Exercício - Integrar e utilizar o reconhecimento e transcrição de fala

Neste módulo, você criará um aplicativo de Realidade Mista que explora o uso dos Serviços de Fala do Azure com o HoloLens 2. Ao concluir esta série, você poderá usar o microfone do seu dispositivo para transcrever fala para texto em tempo real, traduzir sua fala para outros idiomas e usar o recurso de reconhecimento de intenção para entender comandos de voz usando inteligência artificial.

Criar e preparar o projeto Unity

Nesta seção, você criará um novo projeto Unity e o preparará para o desenvolvimento do MRTK.

Como pré-requisito, certifique-se de ter concluído as etapas abaixo para inicializar seu projeto e aplicativo:

- Criar o projeto Unity e dar-lhe um nome adequado, por exemplo, MRTK Tutorials

- Mudar a plataforma de compilação

- Importando os recursos essenciais do TextMeshPro

- Importando o Kit de Ferramentas de Realidade Mista

- Configurando o projeto Unity

- Criar e configurar a cena e dar-lhe um nome adequado; por exemplo, AzureSpeechServices

Observação

Você pode aprender como configurar seu projeto de realidade mista no módulo Introdução ao Kit de Ferramentas de Realidade Mista.

Configurar os recursos

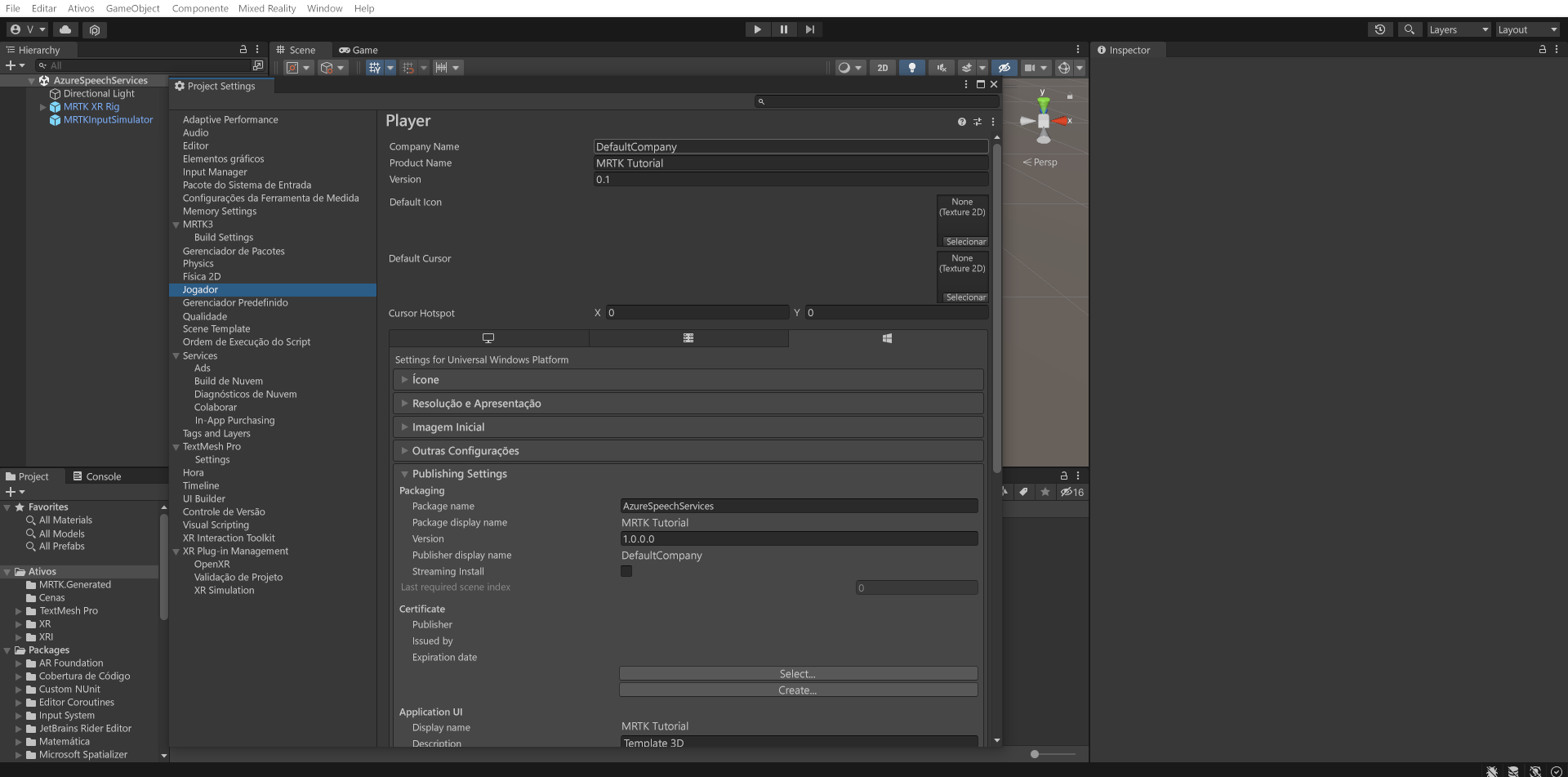

No menu Unity, selecione Editar>Configurações do Projeto... para abrir a janela Configurações do Player, e localize a seção Player>Configurações de Publicação:

No Configurações de Publicação, role para baixo até a seção Capabilities e verifique se os recursos InternetClient, Microphonee SpatialPerception (que você habilitou quando criou o projeto no início do tutorial) ainda estão habilitados. Em seguida, habilite os recursos de InternetClientServer e os recursos de PrivateNetworkClientServer.

Importar os ativos do tutorial

Baixe e importe os seguintes pacotes personalizados Unity na ordem em que estão listados:

Depois de importar os ativos do tutorial, a janela Project deve ter esta aparência:

Preparar a cena

Nesta seção, você preparará a cena adicionando o tutorial pré-fabricado e configurará o componente Lunarcom Controller (Script) para controlar sua cena.

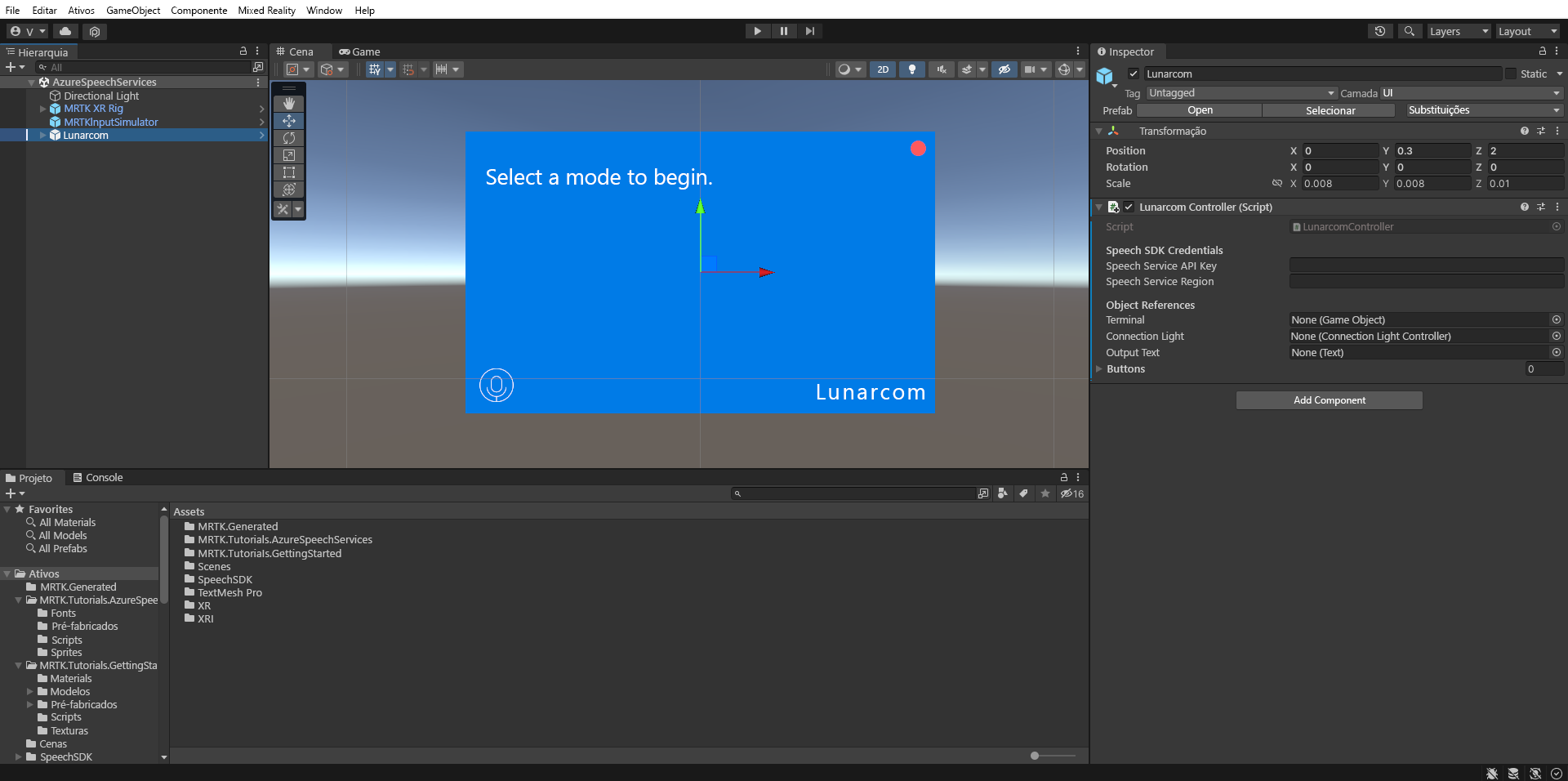

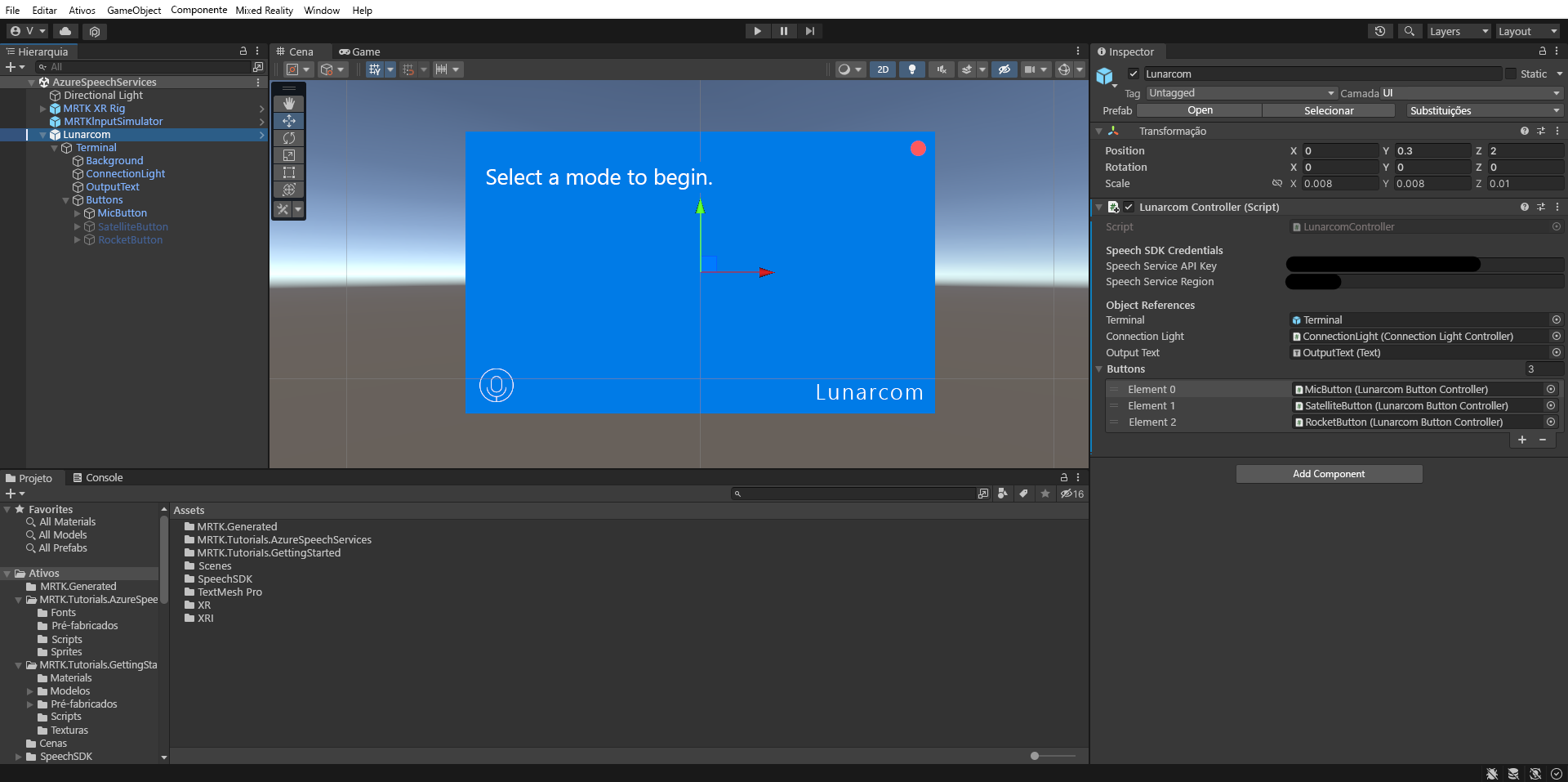

Na janela Projeto, navegue até ao Assets>MRTK.Tutorials.AzureSpeechServices> Prefabs pasta e arraste o Lunarcom prefab para a janela Hierarquia para o adicionar à sua cena.

Com o objeto Lunarcom ainda selecionado na janela Hierarquia, na janela Inspetor, use o botão Adicionar componente para adicionar o componente Controlador Lunarcom (Script) ao objeto Lunarcom.

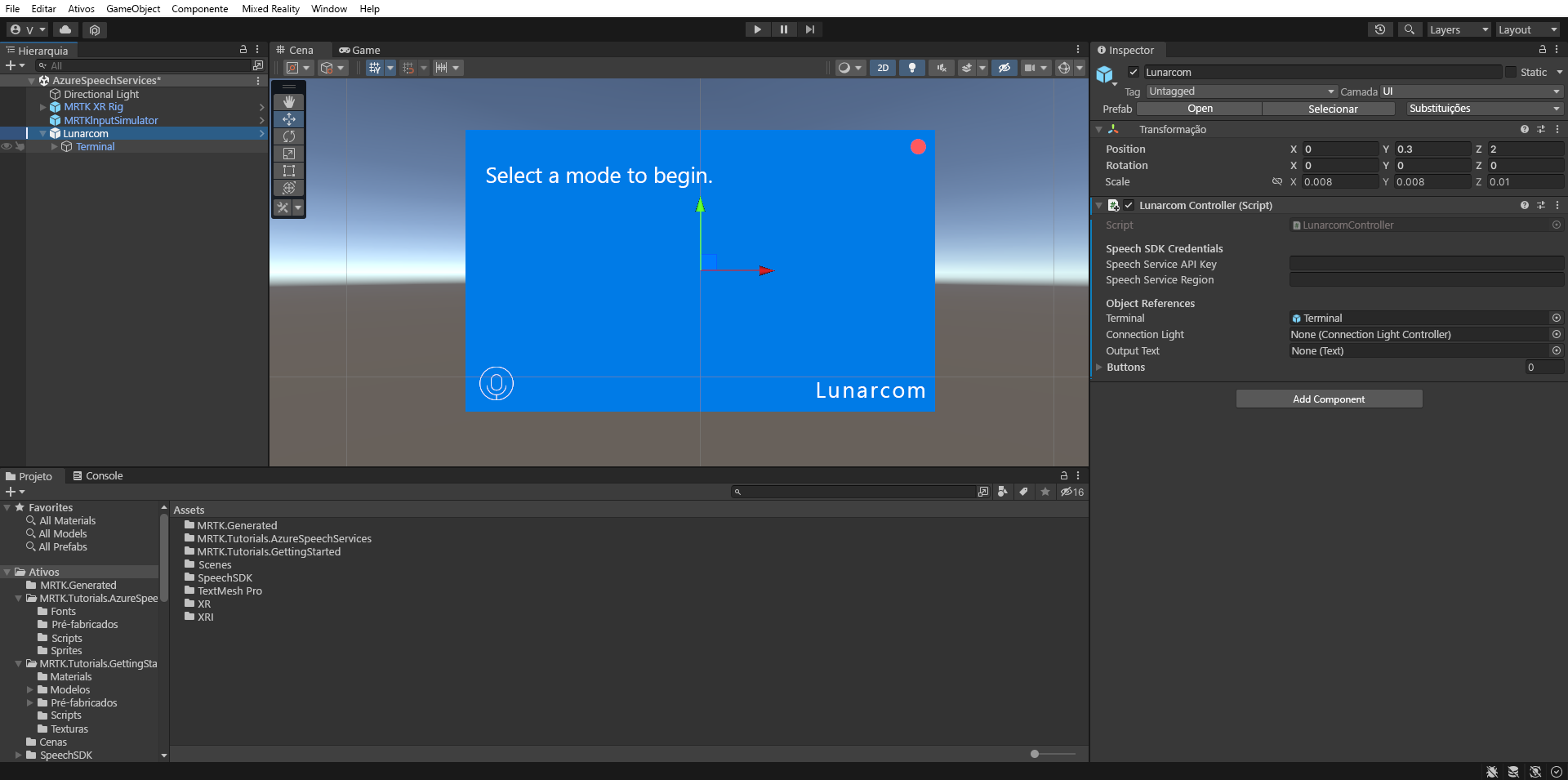

Com o objeto Lunarcom ainda selecionado, expanda-o para revelar os seus objetos-filho e arraste o objeto Terminal para o campo Terminal do componente Lunarcom Controller (Script).

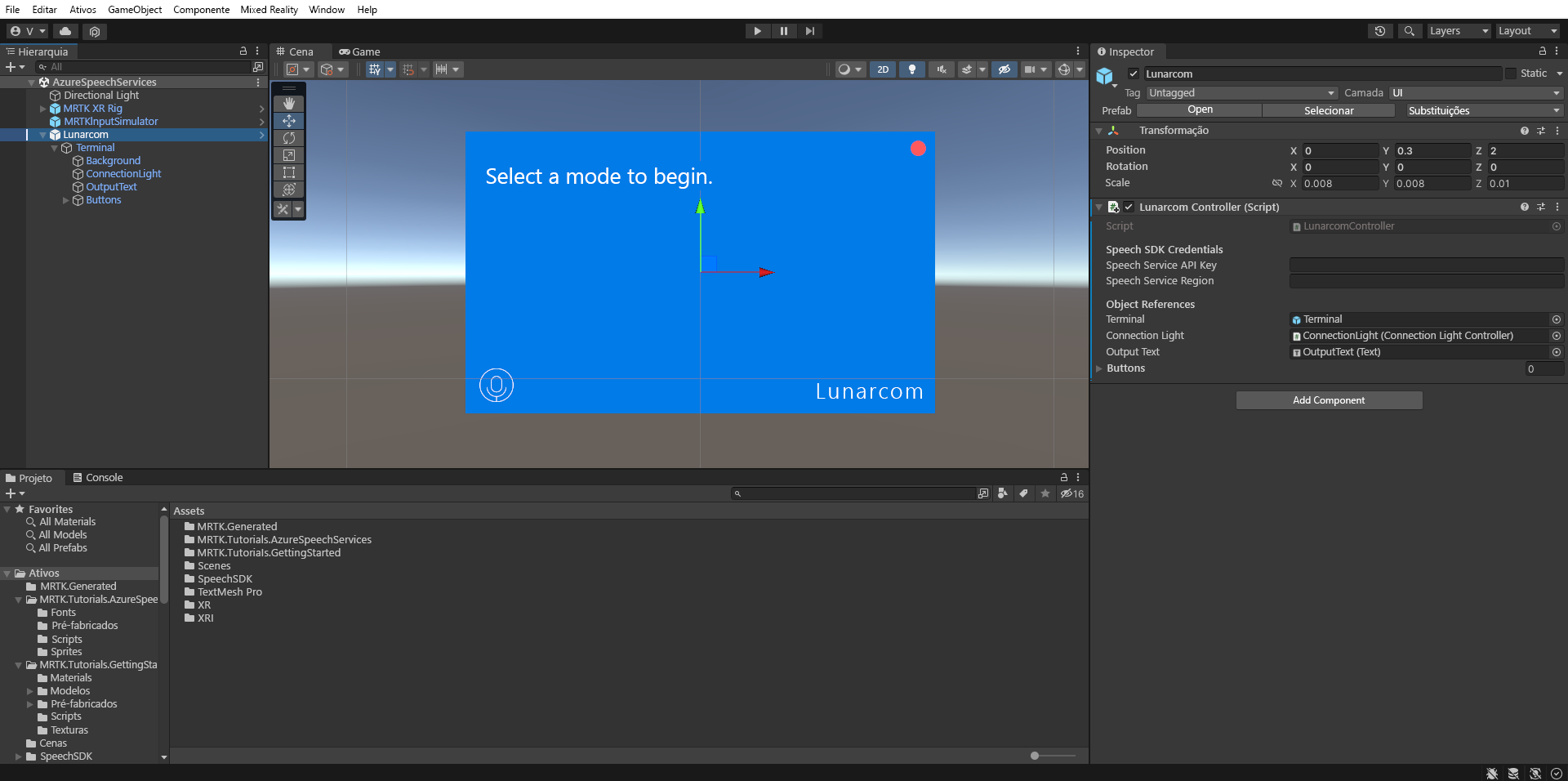

Com o objeto Lunarcom ainda selecionado, expanda o objeto Terminal para revelar os seus objetos filho e, em seguida, arraste o objeto ConnectionLight para o campo Connection Light do componente Lunarcom Controller (Script) e o objeto OutputText para o campo Output Text.

Com o objeto Lunarcom ainda selecionado, expanda o objeto Buttons para revelar os seus objetos filho e, na janela do Inspetor, expanda a lista Buttons, defina o campo Buttons como 3e arraste os objetos MicButton, SatelliteButtone RocketButton para os campos Element 0, 1 e 2, respetivamente.

Conectar o projeto Unity ao recurso do Azure

Para usar os Serviços de Fala do Azure, você precisa criar um recurso do Azure e obter uma chave de API para o Serviço de Fala. Siga as instruções de início rápido e anote a sua região de serviço (também conhecida como Localização ) e a chave de API (também conhecida como Key1 ou Key2 ).

Na janela Hierarquia, selecione o objeto Lunarcom, depois, na janela Inspetor, localize o componente Controlador Lunarcom (Script) na seção Credenciais do SDK de Fala e configure-a da seguinte forma:

- No campo da Chave da API do Serviço de Fala , insira a sua chave de API (Key1 ou Key2).

- No campo Região do Serviço de Fala, insira a sua região de serviço (Local) com letras minúsculas e sem espaços.

Usar o reconhecimento de fala para transcrever a fala

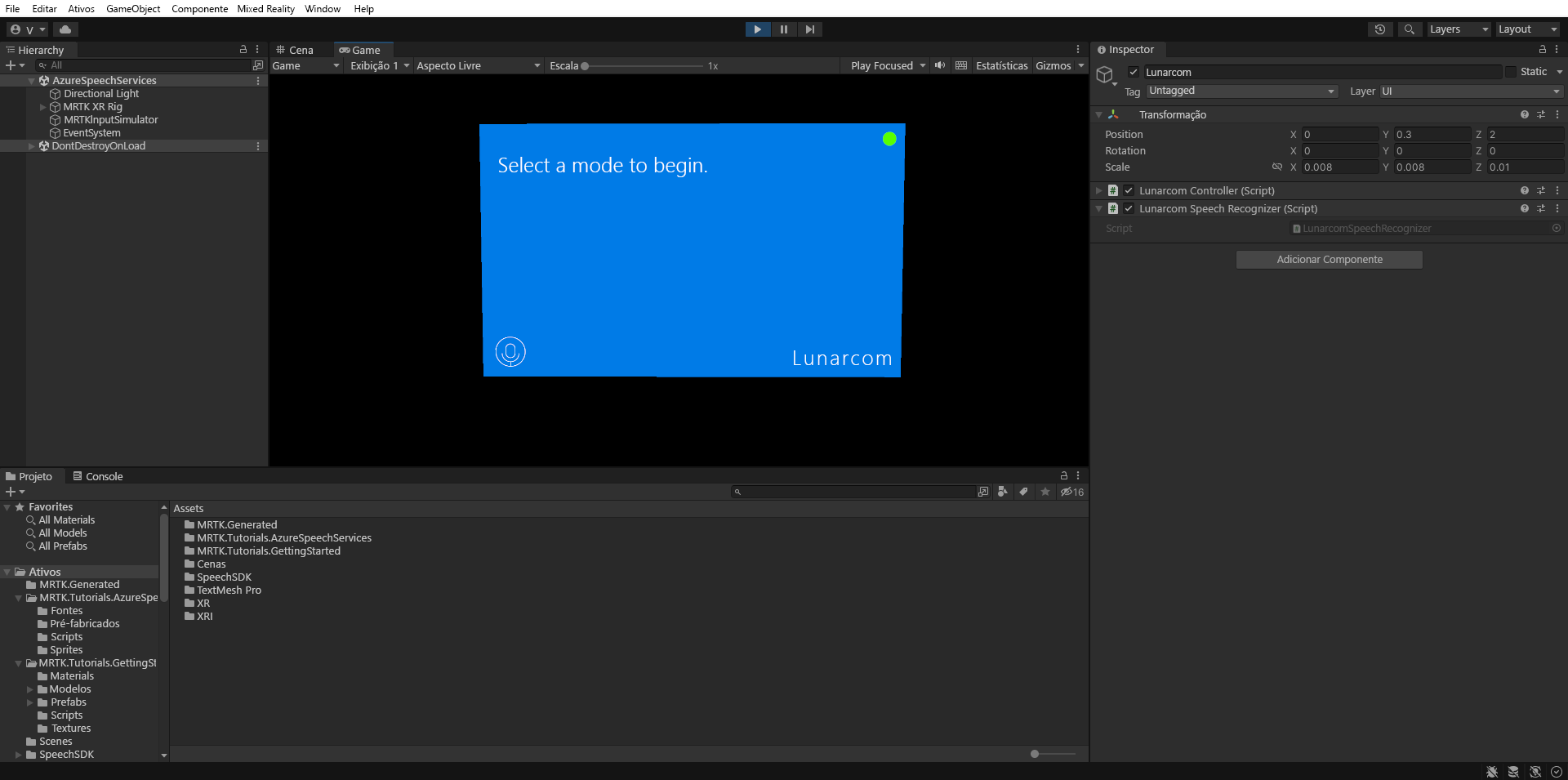

Na janela Hierarquia, selecione o objeto Lunarcom e, em seguida, na janela Inspetor, use o botão Adicionar componente para adicionar o componente Lunarcom Speech Recognizer (Script) ao objeto Lunarcom.

Se agora entrar no modo de jogo e selecionar o botão Play, pode testar o reconhecimento de voz premindo primeiro o botão do microfone:

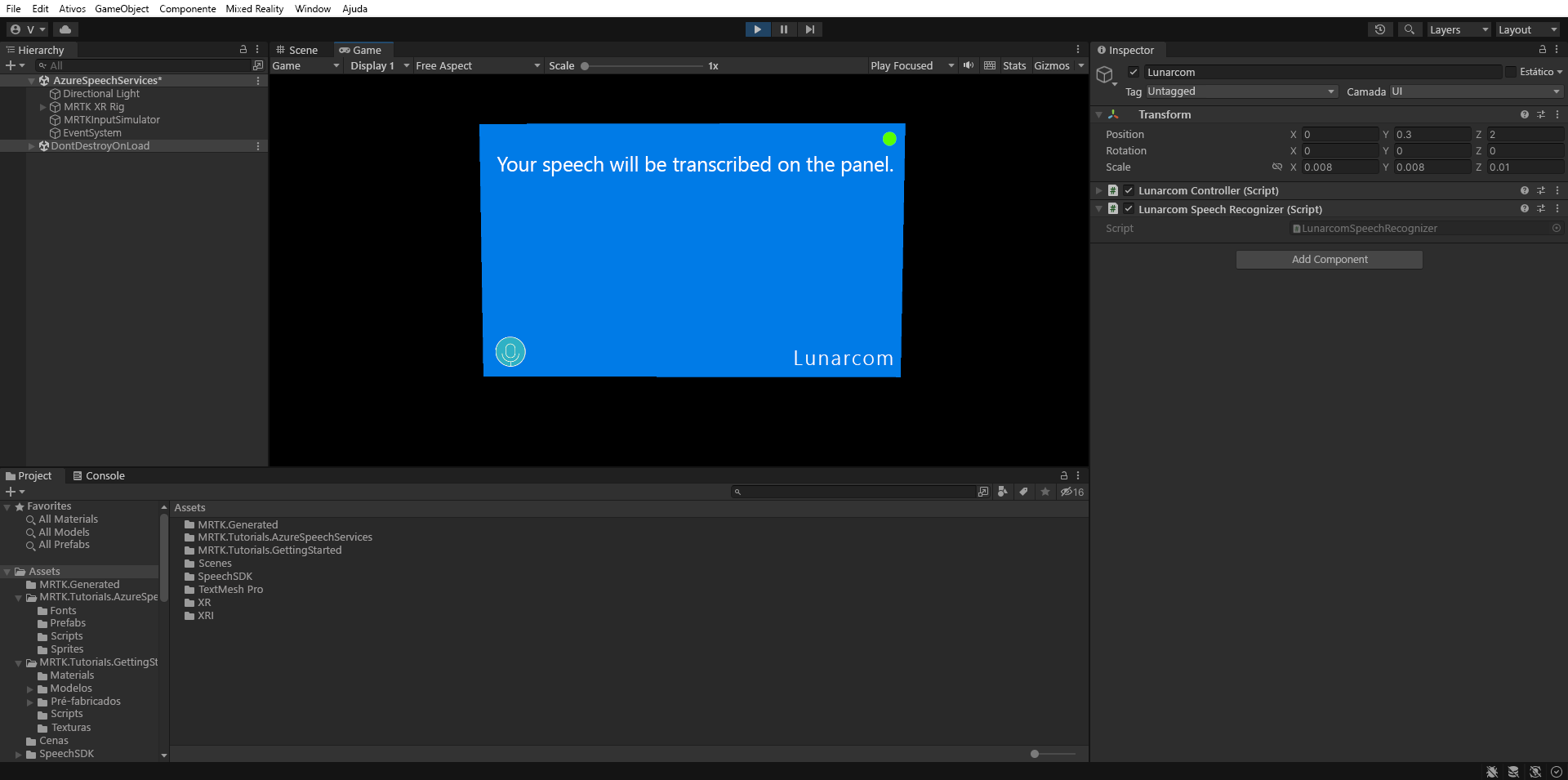

Então, supondo que seu computador tenha um microfone, quando você disser algo, sua fala será transcrita no painel do terminal:

Atenção

O aplicativo precisa se conectar ao Azure, portanto, verifique se seu computador/dispositivo está conectado à Internet.