Suporte nativo de qualidade de dados para o formato Iceberg (pré-visualização)

O suporte nativo do Microsoft Purview para o formato de tabela aberta do Apache Iceberg está em pré-visualização pública. Os clientes do Microsoft Purview que utilizam o Microsoft Azure Data Lake Storage (ADLS) Gen2, o Microsoft Fabric Lakehouse, o Amazon Web Services (AWS) S3 e o Google Cloud Platform (GCP) Google Cloud Storage (GCS) podem agora utilizar o Microsoft Purview para organizar, governar e efetuar o controlo do estado de funcionamento dos dados e a avaliação da qualidade dos dados nos recursos de dados do Iceberg.

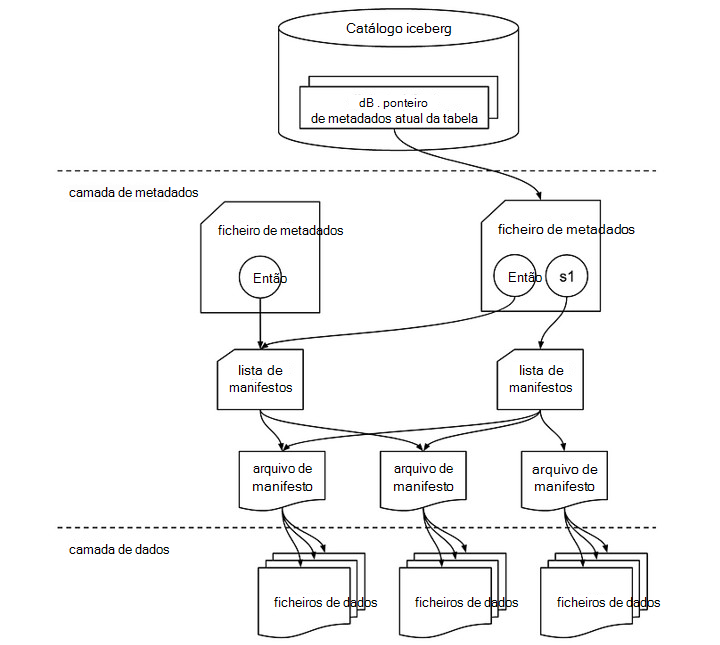

Estrutura de ficheiros iceberg

Uma tabela Iceberg é mais do que apenas uma coleção de ficheiros de dados. Inclui vários ficheiros de metadados que controlam o estado da tabela e facilitam operações como leituras, escritas e evolução do esquema. Segue-se uma exploração dos componentes críticos envolvidos numa tabela iceberg. Normalmente, os ficheiros de dados numa tabela Iceberg são armazenados em formatos columnares como Apache Parquet, Apache Avro ou Apache Optimized Row Columnar (ORC). Estes ficheiros contêm os dados reais com os quais os utilizadores interagem durante as consultas.

Catálogo iceberg

Na parte superior encontra-se o catálogo Iceberg, que armazena o ponteiro de metadados atual para cada tabela. Este catálogo permite controlar o estado mais recente de uma tabela ao referenciar o ficheiro de metadados atual.

Camada de metadados

A camada de metadados é central na funcionalidade do Iceberg e é composta por vários elementos-chave:

- Ficheiro de metadados: Este ficheiro contém informações sobre o esquema, a criação de partições e os instantâneos da tabela. No diagrama, s0 refere-se a um snapshot, que é essencialmente um registo do estado da tabela num determinado momento. Se existirem múltiplos instantâneos, como s0 e s1, o ficheiro de metadados controla ambos.

- Lista de manifestos: Esta lista aponta para um ou mais ficheiros de manifesto. Uma lista de manifestos funciona como um contentor de referências a estes manifestos e ajuda o Iceberg a gerir de forma eficiente os ficheiros de dados que devem ser lidos ou escritos durante operações diferentes. Cada snapshot pode ter a sua própria lista de manifestos.

Camada de dados

Na camada de dados, os ficheiros de manifesto atuam como um intermediário entre os metadados e os ficheiros de dados reais. Cada ficheiro de manifesto aponta para uma coleção de ficheiros de dados, fornecendo um mapa dos ficheiros físicos armazenados no data lake.

- Ficheiros de manifesto: estes ficheiros armazenam os metadados de um grupo de ficheiros de dados, incluindo contagens de linhas, informações de partição e caminhos de ficheiro. Permitem ao Iceberg podar e aceder rapidamente a ficheiros específicos, permitindo uma consulta eficiente.

- Ficheiros de dados: os dados reais residem nestes ficheiros, que podem estar em formatos como Parquet, ORC ou Avro. O Iceberg organiza ficheiros de dados com base em partições, permitindo otimizações de desempenho durante a execução de consultas ao minimizar análises de dados desnecessárias.

Como funciona em conjunto

Quando uma operação como uma consulta ou atualização é executada, o Iceberg procura primeiro o ficheiro de metadados da tabela através do catálogo. O ficheiro de metadados referencia o snapshot atual (ou vários instantâneos), que, em seguida, aponta para a lista de manifestos. A lista de manifestos contém referências aos ficheiros de manifesto que, por sua vez, listam os ficheiros de dados individuais. Esta estrutura hierárquica permite que o Iceberg faça a gestão eficiente de grandes conjuntos de dados ao mesmo tempo que garante a consistência transacional, permitindo funcionalidades como viagens no tempo e evolução do esquema.

Este design de várias camadas melhora o desempenho e a escalabilidade das operações de transmissão em lote e transmissão em fluxo, uma vez que apenas os ficheiros de dados necessários são acedidos e as atualizações são geridas através de instantâneos sem afetar todo o conjunto de dados.

Dados de icebergues no OneLake

Pode consumir de forma totalmente integrada os dados formatados com Iceberg no Microsoft Fabric sem movimento ou duplicação de dados. Pode utilizar atalhos do OneLake para apontar diretamente para uma camada de dados.

Os dados de icebergues são armazenados no OneLake, escritos com Snowflake ou outro escritor iceberg. O OneLake virtualiza a tabela como uma tabela do Delta Lake, garantindo uma ampla compatibilidade entre os motores dos Recursos de Infraestrutura. Por exemplo, pode criar um volume no Snowflake e apontá-lo diretamente para o Fabric Lakehouse. Assim que a tabela for criada no OneLake dos Recursos de Infraestrutura, a autossincronização garante que as atualizações de dados são refletidas em tempo real. Este processo simplificado facilita o trabalho com dados do Iceberg no Microsoft Fabric. Obtenha mais detalhes da documentação do Snowflake.

Importante

Os dados iceberg no AWS S3 e GCS também precisam de ser sincronizados automaticamente como delta para organizar, governar e medir e monitorizar a qualidade dos dados.

Qualidade dos dados do Iceberg

Para todos os utilizadores que hidratam dados nativos no Iceberg on (Parquet, ORC, Avro) no ADLS Gen2 ou Fabric Lakehouse, basta configurar uma análise que aponte para a localização do diretório que aloja os dados e os metadados dos diretórios iceberg. Siga os passos listados abaixo:

Configure e execute uma análise no Mapa de Dados do Microsoft Purview.

Configure o dir (alojando dados e metadados) como recurso de dados e associe-o ao produto de dados. Isto forma o conjunto de dados iceberg. Associe recursos de dados iceberg a um produto de dados no Catálogo unificado do Microsoft Purview. Saiba como associar recursos de dados a um produto de dados.

No Catálogo unificado, em Gestão de estado de funcionamento, selecione Vista de qualidade dos dados para localizar os seus ficheiros Iceberg (recurso de dados) e para configurar a ligação à origem de dados.

3.1 Para configurar a ligação do AdlsG2, siga os passos descritos no documento de ligação do DQ

3.2 Para configurar a ligação OneLake de Recursos de Infraestrutura, siga os passos descritos no documento DQ do património de dados dos recursos de infraestrutura.

Aplique regras de qualidade de dados e execute análises de qualidade de dados para classificação da qualidade dos dados ao nível da coluna e da tabela.

Na página Esquema do ficheiro Iceberg selecionado (recurso de dados), selecione Importar esquema para importar o esquema da origem de dados do ficheiro Iceberg.

Antes de executar a tarefa de criação de perfis ou a tarefa de análise da qualidade dos dados, aceda à página Descrição Geral do ficheiro Iceberg e, no menu pendente Recurso de dados , selecione Iceberg.

Análise da criação de perfis e da qualidade dos dados

Depois de concluir a configuração da ligação e a seleção do formato de ficheiro de recurso de dados, pode criar, criar e aplicar regras e executar uma análise de qualidade de dados dos seus dados em ficheiros de formato aberto iceberg. Siga a orientação passo a passo descrita nos documentos abaixo:

- Como configurar e executar a criação de perfis de dados dos seus dados

- Como configurar e executar a análise da qualidade dos dados

Importante

- O suporte para o formato de abertura iceberg nas funcionalidades de deteção, curadoria, criação de perfis de dados e análise de qualidade de dados está agora em pré-visualização.

- Para a criação de perfis de dados e a avaliação da qualidade dos dados, tem de obter e definir o esquema a partir da página Esquema de Qualidade de Dados.

- Experiência de Deteção do Consumidor: os consumidores não verão o esquema na vista de recursos de dados porque o Mapa de Dados ainda não suporta o formato de tabela de abertura iceberg. O responsável pela Qualidade dos Dados poderá importar o esquema a partir da página de esquema de Qualidade dos Dados.

Limitações

A versão atual suporta dados criados no formato Iceberg apenas com o catálogo Apache Hadoop .

Caminho do Lakehouse e Caminho do ADLS Gen2

- Os Metadados iceberg armazenam o caminho completo para os dados e metadados. Certifique-se de que utiliza o caminho completo para o ADLS Gen2 e o Microsoft Fabric Lakehouse. Além disso, para o caminho do Microsoft Fabric Lakehouse durante a escrita, certifique-se de que opera (WRITES, UPSERTS) com os caminhos de ID.

abfss://c4dd39bb-77e2-43d3-af10-712845dc2179@onelake.dfs.fabric.microsoft.com/5e8ea953-56fc-49c1-bc8c-0b3498cf1a9c/Files/CustomerData. - Sistema de Ficheiros como ID e Lakehouse como ID. Os caminhos absolutos e não relativos são necessários para que o Microsoft Purview efetue o DQ no Iceberg. Para validar, certifique-se de que marcar o caminho dos instantâneos para apontar como caminhos completos de Nome Completamente Qualificado (FQN).

Deteção de esquema

- O Mapa de Dados tem uma limitação na incapacidade de detetar o esquema iceberg. Ao organizar os diretórios iceberg no Fabric Lakehouse ou no ADLS Gen2, não poderá rever o esquema. No entanto, o esquema de obtenção de DQ é capaz de obter o esquema do elemento organizado.

Recomendações

- Se estiver a utilizar o Catálogo SNOWFLAKE para o Formato Iceberg, com armazenamento em VOLUME como ADLS Gen2, AWS S3 ou GCP GCS, utilize o atalho de Tabela OneLake do Microsoft Fabric e execute o DQ como tabela DELTA. Nota: suporta apenas Iceberg com formato de ficheiro Parquet.

- Se estiver a utilizar o ADLS for Iceberg Format com o catálogo do Hadoop, analise o diretório diretamente e utilize o motor DQ como predefinição para o formato Iceberg para DQ. Nota: suporta Iceberg com formato de ficheiro Parquet, ORC e Avro.

- Se estiver a utilizar o formato Snowflake para Iceberg, pode apontar o armazenamento de VOLUME diretamente para o caminho do Microsoft Fabric Lakehouse e utilizar o OneLake Table para, em seguida, criar uma versão compatível com Delta para DQ. Nota: suporta apenas Iceberg com formato de ficheiro Parquet.

- Se estiver a utilizar o Microsoft Fabric Lakehouse for Iceberg Format com o catálogo Hadoop, analise diretamente o diretório lakehouse, utilize o motor DQ como predefinição para o formato Iceberg para DQ. Nota: suporta Iceberg com formato de ficheiro Parquet, ORC e Avro.