Importação da Consulta de Colmeia

Importante

O suporte para o Estúdio de ML (clássico) terminará a 31 de agosto de 2024. Recomendamos a transição para o Azure Machine Learning até essa data.

A partir de 1 de dezembro de 2021, não poderá criar novos recursos do Estúdio de ML (clássico). Até 31 de agosto de 2024, pode continuar a utilizar os recursos existentes do Estúdio de ML (clássico).

- Consulte informações sobre projetos de machine learning em movimento de ML Studio (clássico) para Azure Machine Learning.

- Saiba mais sobre Azure Machine Learning.

A documentação do Estúdio de ML (clássico) está a ser descontinuada e poderá não ser atualizada no futuro.

Este artigo descreve como usar o módulo de Dados de Importação em Machine Learning Studio (clássico), para obter dados de clusters Hadoop e armazenamento distribuído HDInsight.

Nota

Aplica-se a: Machine Learning Studio (clássico) apenas

Módulos semelhantes de arrasto e queda estão disponíveis em Azure Machine Learning designer.

Importar dados da Hive é particularmente útil para carregar grandes conjuntos de dados, ou se você quiser pré-processar os dados usando um trabalho MapReduce antes de carregar os dados em uma experiência de machine learning.

Importante

A 31 de julho de 2018, Microsoft Azure versão 3.3 do HDInsight foi a última versão do HDInsight no Windows. Se tiver algum cluster HDInsight no Windows 3.3 ou mais cedo, deve migrar para HDInsight no Linux (versão HDInsight 3.5 ou mais tarde). Consulte a secção de versões Aposentadas para obter mais informações sobre versões aposentadas do HDInsight. Machine Learning Studio (clássico) apoiará HDInsight no Linux em certos cenários.

Suporte para HDInsight no Linux

Machine Learning Studio (clássico) tem suporte para HDInsight em Linux nos seguintes cenários:

- Hadoop 2.7.3 (HDI 3.6) Blob como padrão, ADLS secundário

- Faísca 2.1.0 (HDI 3.6) Blob como padrão, ADLS secundário

- Faísca 2.2.0 (HDI 3.6) Blob como padrão, ADLS secundário

- Faísca 2.3.0 (HDI 3.6) Blob como padrão, ADLS secundário

Problemas Conhecidos

Existem vários problemas conhecidos com a utilização do módulo de dados de importação para consultas de colmeia com HDInsight no Linux:

- Pacote de Segurança Empresarial não é suportado

- /tmp/colmeia não é ainda explicável

Como importar dados de consultas de Colmeia

Use o feiticeiro

O módulo apresenta um novo assistente para o ajudar a escolher uma opção de armazenamento, selecionar entre as subscrições e contas existentes e configurar rapidamente todas as opções.

Adicione o módulo de Dados de Importação à sua experiência. Pode encontrar o módulo em Estúdio (clássico), na categoria Entrada e Saída de Dados .

Clique em Lançar Assistente de Dados de Importação e siga as instruções.

Quando a configuração estiver concluída, para copiar os dados na sua experiência, clique com o botão direito no módulo e selecione Executar Selecionado.

Se precisar de editar uma ligação de dados existente, o assistente carrega todos os detalhes de configuração anteriores para que não tenha de recomeçar do zero

Definir manualmente propriedades de importação

Os seguintes passos descrevem como configurar manualmente a fonte de importação.

Adicione o módulo de Dados de Importação à sua experiência. Pode encontrar o módulo em Estúdio (clássico), na categoria Entrada e Saída de Dados .

Para obter informações sobre dados, selecione Hive Consulta.

Na caixa de texto de consulta de base de dados da Hive , especifique os dados que pretende ler utilizando o HiveQL.

HiveQL é uma linguagem de consulta SQL que também pode ser usada para agregar dados e realizar a filtragem de dados antes de adicionar os dados ao Machine Learning Studio (clássico). No entanto, a consulta hive deve devolver os dados em formato tabular.

Por exemplo, esta afirmação é uma consulta válida da Hive:

SELECT <column list> FROM table WHERE <expression>;Clique na caixa de texto URI do servidor HCatalog e, em seguida, digite o nome totalmente qualificado do seu cluster.

Por exemplo, se criou um cluster com o nome mycluster001, utilize este formato:

https://mycluster001.azurehdinsight.netClique na caixa de texto do nome da conta do utilizador Hadoop e cole na conta de utilizador Hadoop que utilizou quando ante provisionou o cluster.

Clique na caixa de texto de palavra-passe da conta de utilizador Hadoop e digite as credenciais que utilizou quando forte o cluster.

Para obter mais informações sobre o nome do cluster e a autenticação para Hadoop, consulte os clusters Provision Hadoop em HDInsight.

Para a localização dos dados de saída, selecione a opção que indica onde os dados são armazenados. Se os dados estiverem no sistema de ficheiros distribuídos hadoop (HDFS), este deve estar acessível através da mesma conta e senha que acabou de introduzir. Se os dados estiverem em Azure, forneça a localização e as credenciais da conta de armazenamento.

HDFS: Digite ou cole o servidor HDFS URI. Certifique-se de que utiliza o nome do cluster HDInsight sem o

HTTPS://prefixo.Azure: Para o nome da conta de armazenamento Azure, digite o nome da conta Azure. Por exemplo, se o URL completo da conta de armazenamento for

https://myshared.blob.core.windows.net, escreveriamyshared.Chave de armazenamento Azure: Copiar e colar a chave que está prevista para aceder à conta de armazenamento.

Para o nome do recipiente Azure, especifique o recipiente predefinido para o cluster. Consulte a secção Sugestões para obter ajuda para descobrir que recipiente utilizar.

Selecione as opções de resultados em cache Use se não espera que os dados mudem muito, ou se quiser evitar recarregar os dados cada vez que executar a experiência.

Quando este é selecionado, se não houver outras alterações nos parâmetros do módulo, a experiência carrega os dados na primeira vez que o módulo é executado, e depois utiliza uma versão em cache do conjunto de dados.

Se pretender repor o conjunto de dados em cada iteração do conjunto de dados da experiência, desmarca a opção de resultados em cache Utilização . Os resultados também são reessarregáveis quando há alterações nos parâmetros dos Dados de Importação.

Execute a experimentação.

Resultados

Quando estiver concluído, clique no conjunto de dados de saída e selecione Visualize para ver se os dados foram importados com sucesso.

Se tiver erros, verifique se os seus dados estão em falta, colunas vazias adicionais ou tipos de dados incompatíveis.

Exemplos

Por exemplo, como configurar um cluster HDInsight e utilizar consultas de Hive em experiências de aprendizagem automática, consulte estes recursos:

Este artigo fornece uma análise detalhada de como criar um cluster, carregar dados e chamar os dados do Studio (clássico) usando Hive: Advanced Analytics Process and Technology in Action: Using HDInsight Hadoop clusters.

Este blog da MVP Vesa Tikkanen descreve alguns problemas e soluções ao ler ficheiros muito grandes (consultas distribuídas) de um cluster HD em Linux: Reading Linux HDInsight Hive de Azure ML

Embora a Hive ofereça funcionalidades superiores para muitos tipos de limpeza e pré-processamento de dados, após a importação, poderá encontrar estas ferramentas úteis para preparar os dados para modelação:

Utilize os metadados de edição e outros módulos para alterar nomes de colunas, especifique quais as colunas que contêm etiquetas e funcionalidades e especifique o tipo de dados da coluna. Por exemplo, consulte o Processamento do Conjunto de Dados.

Os dados de texto pós-processo que usam Python, para remover pontuação, partes da bandeira da fala, e muito mais. Por exemplo, consulte a Classificação de Texto.

Combine várias tabelas de diferentes fontes numa única tabela de dados de treino. Por exemplo, consulte a manutenção preditiva.

Notas técnicas

Esta secção contém detalhes de implementação, dicas e respostas a perguntas frequentes.

Como determinar o recipiente padrão

Se criou o seu cluster aceitando todos os padrãos, um recipiente com o mesmo nome do cluster foi criado ao mesmo tempo que o cluster foi criado. Este contentor é o recipiente padrão para o aglomerado. No entanto, se escolheu a opção CUSTOM CREATE ao criar um cluster, é-lhe dada duas opções para selecionar o recipiente predefinido. A primeira opção é selecionar um recipiente existente. Quando o fizer, esse recipiente torna-se o recipiente de armazenamento predefinido para o cluster. A segunda opção é criar o recipiente predefinido. Quando utilizar esta opção, o recipiente predefinido tem o mesmo nome que o cluster.

Como chamar Python scripts de uma consulta de Colmeia

Pode utilizar o módulo de Dados de Importação para executar consultas de Hive que chamam Python UDFs para processar registos.

Para obter mais informações, consulte Use Python com Hive e Pig em HDInsight.

Evitar problemas de memória ao utilizar a Colmeia para pré-processar dados

Ao utilizar consultas de Hive para extrair registos de grandes fontes de dados, por vezes a configuração padrão do cluster Hadoop é demasiado limitada para suportar a execução do trabalho mapReduce. Por exemplo, nestas Notas de Lançamento para HDInsight, as definições padrão são definidas como um cluster de quatro nós.

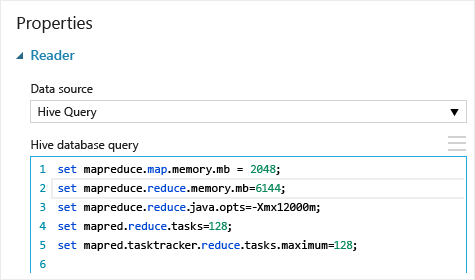

Se os requisitos do trabalho MapReduce excederem a capacidade disponível, as consultas da Hive poderão devolver uma mensagem de erro out of Memory , o que faz com que a operação de Dados de Importação falhe. Se isso acontecer, pode alterar a atribuição de memória padrão para consultas de Hive no módulo de Dados de Importação , como mostrado aqui:

Neste exemplo, os comandos e set mapreduce.reduce.memory.mb são usados set mapreduce.map.memory.mb para aumentar a quantidade de memória, para usar o máximo permitido no cluster.

Perguntas comuns

Como posso evitar reessarcando os mesmos dados desnecessariamente

Se os dados de origem alterarem, pode atualizar o conjunto de dados e adicionar novos dados re-executando dados de importação. No entanto, se não quiser relê-lo a partir da fonte cada vez que executar a experiência, selecione a opção de resultados em cache para A VERDADEIRA. Quando esta opção for definida para TRUE, o módulo verificará se a experiência foi executada anteriormente utilizando a mesma fonte e as mesmas opções de entrada, e se for encontrada uma execução anterior, os dados na cache são utilizados, em vez de reensalar os dados da fonte.

Posso filtrar os dados como está a ser lido a partir da fonte

O módulo de Dados de Importação em si não suporta a filtragem à medida que os dados estão a ser lidos.

Para filtrar os dados antes de os ler em Machine Learning Studio (clássico), utilize uma consulta de Hive ou um trabalho MapReduce para agregar e transformar os dados.

Existem também múltiplas opções para filtrar dados depois de ter sido carregado no Machine Learning Studio (clássico):

- Use um script R personalizado para obter apenas os dados que deseja.

- Utilize o módulo Dados Divididos com uma expressão relativa ou uma expressão regular para isolar os dados que pretende e, em seguida, guarde-os como conjunto de dados.

Nota

Se descobrir que carregou mais dados do que o necessário, pode substituir o conjunto de dados em cache lendo um novo conjunto de dados e guardá-lo com o mesmo nome que os dados mais antigos e maiores.

Parâmetros do módulo

| Nome | Intervalo | Tipo | Predefinição | Description |

|---|---|---|---|---|

| Origem de dados | Lista | Fonte de dados ou pia | Armazenamento de Blobs do Azure | A fonte de dados pode ser HTTP, FTP, HTTPS anónimo ou FTPS, um ficheiro no armazenamento Azure BLOB, uma tabela Azure, uma Base de Dados SQL do Azure, uma base de dados SQL Server no local, uma tabela Hive ou um ponto final OData. |

| Consulta de base de dados de colmeia | qualquer | StreamReader | Consulta HQL | |

| HCatalog servidor URI | qualquer | String | Ponto final de Templeton | |

| Nome da conta do utilizador Hadoop | qualquer | String | Nome de utilizador Hadoop HDFS/HDInsight | |

| Senha de conta de utilizador Hadoop | qualquer | SecureString | Senha Hadoop HDFS/HDInsight | |

| Localização dos dados de saída | qualquer | DataLocation | HDFS | Especificar HDFS ou Azure para saídaDir |

| URI do servidor HDFS | qualquer | String | Ponto final de descanso HDFS | |

| Nome da conta de armazenamento do Azure | qualquer | String | Nome da conta de armazenamento do Azure | |

| Chave de armazenamento azul | qualquer | SecureString | Chave de armazenamento azul | |

| Nome do recipiente Azure | qualquer | String | Nome do recipiente Azure | |

| Tipo de conteúdo de dados | Lista (subconjunto) | Conteúdo de url | OData | Tipo de formato de dados |

| URL de origem | qualquer | String | URL para Power Query fonte de dados | |

| Use resultados em cache | VERDADEIRO/FALSO | Booleano | FALSE | descrição |

Saídas

| Nome | Tipo | Description |

|---|---|---|

| Conjunto de dados de resultados | Tabela de Dados | Dataset com dados descarregados |

Exceções

| Exceção | Description |

|---|---|

| Erro 0027 | Uma exceção ocorre quando dois objetos têm que ter o mesmo tamanho, mas não são. |

| Erro 0003 | Uma exceção ocorre se uma ou mais entradas forem nulas ou vazias. |

| Erro 0029 | Uma exceção ocorre quando um URI inválido é passado. |

| Erro 0030 | Uma exceção ocorre quando não é possível descarregar um ficheiro. |

| Erro 0002 | Ocorre uma exceção se um ou mais parâmetros não puderem ser analisados ou convertidos do tipo especificado para o tipo exigido pelo método-alvo. |

| Erro 0009 | Ocorre uma exceção se o nome da conta de armazenamento Azure ou o nome do recipiente forem especificados incorretamente. |

| Erro 0048 | Uma exceção ocorre quando não é possível abrir um ficheiro. |

| Erro 0015 | Uma exceção ocorre se a ligação da base de dados tiver falhado. |

| Erro 0046 | Uma exceção ocorre quando não é possível criar um diretório em caminho especificado. |

| Erro 0049 | Uma exceção ocorre quando não é possível analisar um ficheiro. |

Para obter uma lista de erros específicos dos módulos Studio (clássicos), consulte Machine Learning Códigos de Erro.

Para obter uma lista de exceções da API, consulte Machine Learning CÓDIGOs de Erro da API REST.

Ver também

Importar Dados

Dados de Exportação

Importar a partir do URL da Web através de HTTP

Importar a partir da Base de Dados SQL do Azure

Importação da Tabela Azure

Importação de Armazenamento de Blobs do Azure

Importação de Fornecedores de Feed de Dados

Importação de Bases de Dados SQL Server de Instalações