Stream dados do Blob de Armazenamento do Azure para o Azure Data Lake Storage Gen1 com o Azure Stream Analytics

Neste artigo, vai aprender a utilizar o Azure Data Lake Storage Gen1 como uma saída para uma tarefa do Azure Stream Analytics. Este artigo demonstra um cenário simples que lê dados de um blob de Armazenamento do Azure (entrada) e escreve os dados para Data Lake Storage Gen1 (saída).

Pré-requisitos

Antes de começar este tutorial, tem de ter o seguinte:

Uma subscrição do Azure. Consulte Obter versão de avaliação gratuita do Azure.

Conta de Armazenamento do Azure. Irá utilizar um contentor de blobs desta conta para introduzir dados para uma tarefa do Stream Analytics. Para este tutorial, suponha que tem uma conta de armazenamento chamada storageforasa e um contentor na conta denominada storageforasacontainer. Depois de criar o contentor, carregue um ficheiro de dados de exemplo para o mesmo.

Uma conta Data Lake Storage Gen1. Siga as instruções em Introdução ao Azure Data Lake Storage Gen1 com o portal do Azure. Vamos supor que tem uma conta Data Lake Storage Gen1 chamada myadlsg1.

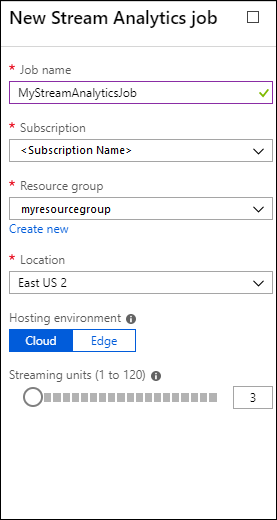

Criar uma Tarefa do Stream Analytics

Comece por criar uma tarefa do Stream Analytics que inclui uma origem de entrada e um destino de saída. Neste tutorial, a origem é um contentor de blobs do Azure e o destino é Data Lake Storage Gen1.

Inicie sessão no portal do Azure.

No painel esquerdo, clique em Stream Tarefas de análise e, em seguida, clique em Adicionar.

Nota

Certifique-se de que cria uma tarefa na mesma região que a conta de armazenamento ou terá custos adicionais de movimentação de dados entre regiões.

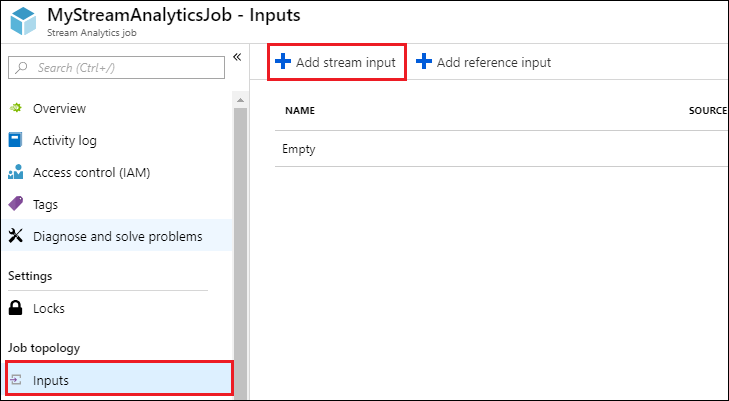

Criar uma entrada de Blob para a tarefa

Abra a página da tarefa Stream Analytics, no painel esquerdo, clique no separador Entradas e, em seguida, clique em Adicionar.

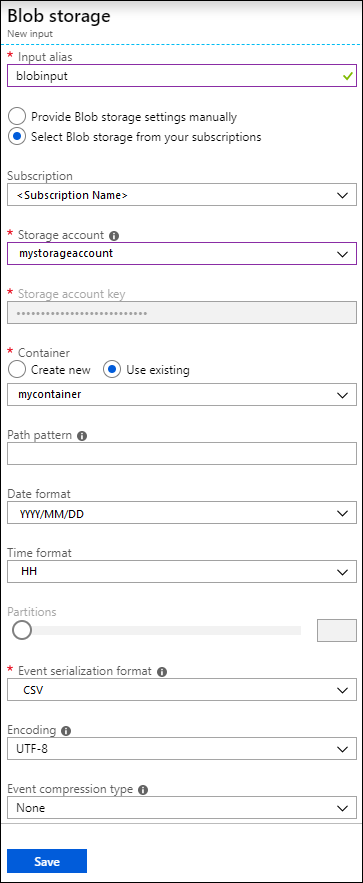

No painel Nova entrada , forneça os seguintes valores.

Em Alias de entrada, introduza um nome exclusivo para a entrada da tarefa.

Em Tipo de origem, selecione Fluxo de dados.

Em Origem, selecione Armazenamento de blobs.

Em Subscrição, selecione Utilizar armazenamento de blobs na subscrição atual.

Em Conta de armazenamento, selecione a conta de armazenamento que criou como parte dos pré-requisitos.

Em Contentor, selecione o contentor que criou na conta de armazenamento selecionada.

Para Formato de serialização de eventos, selecione CSV.

Para Delimitador, selecione o separador.

Para Codificação, selecione UTF-8.

Clique em Criar. Agora, o portal adiciona a entrada e testa a ligação.

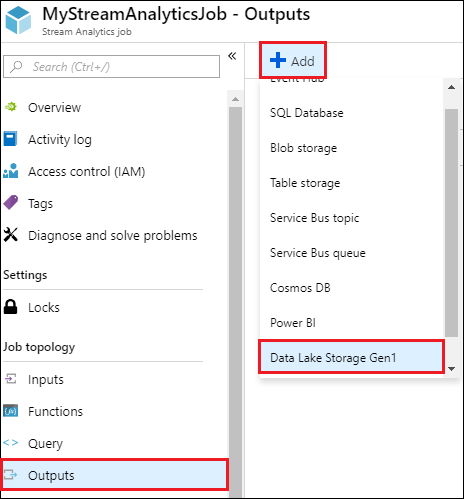

Criar uma saída de Data Lake Storage Gen1 para a tarefa

Abra a página da tarefa Stream Analytics, clique no separador Saídas, clique em Adicionar e selecione Data Lake Storage Gen1.

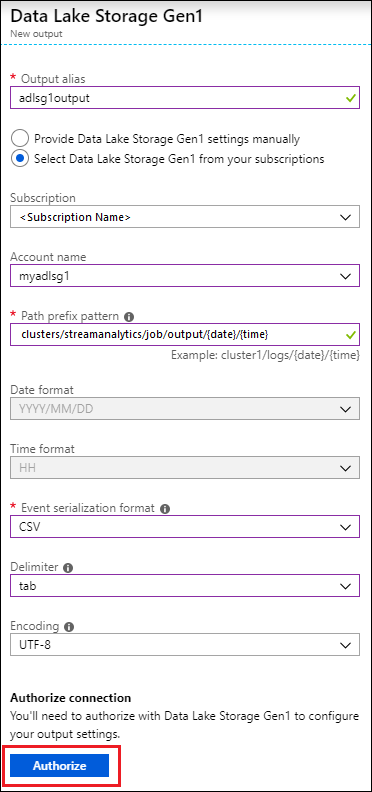

No painel Nova saída , forneça os seguintes valores.

- Em Alias de saída, introduza um nome exclusivo para o resultado da tarefa. Este é um nome amigável utilizado nas consultas para direcionar a saída da consulta para esta conta Data Lake Storage Gen1.

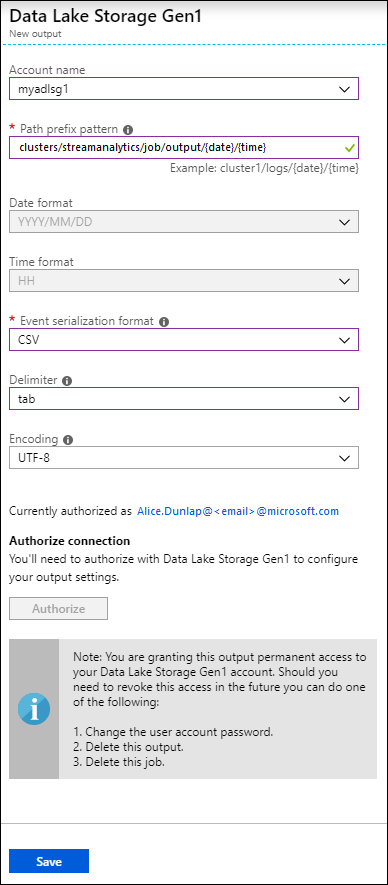

- Ser-lhe-á pedido para autorizar o acesso à conta Data Lake Storage Gen1. Clique em Autorizar.

No painel Nova saída , continue a fornecer os seguintes valores.

Em Nome da conta, selecione a conta Data Lake Storage Gen1 que já criou para onde pretende que o resultado da tarefa seja enviado.

Para o padrão de prefixo Caminho, introduza um caminho de ficheiro utilizado para escrever os seus ficheiros na conta de Data Lake Storage Gen1 especificada.

Em Formato de data, se utilizou um token de data no caminho do prefixo, pode selecionar o formato de data no qual os seus ficheiros estão organizados.

Em Formato de tempo, se utilizou um token de hora no caminho do prefixo, especifique o formato de hora no qual os seus ficheiros estão organizados.

Para Formato de serialização de eventos, selecione CSV.

Para Delimitador, selecione o separador.

Para Codificação, selecione UTF-8.

Clique em Criar. O portal adiciona agora o resultado e testa a ligação ao mesmo.

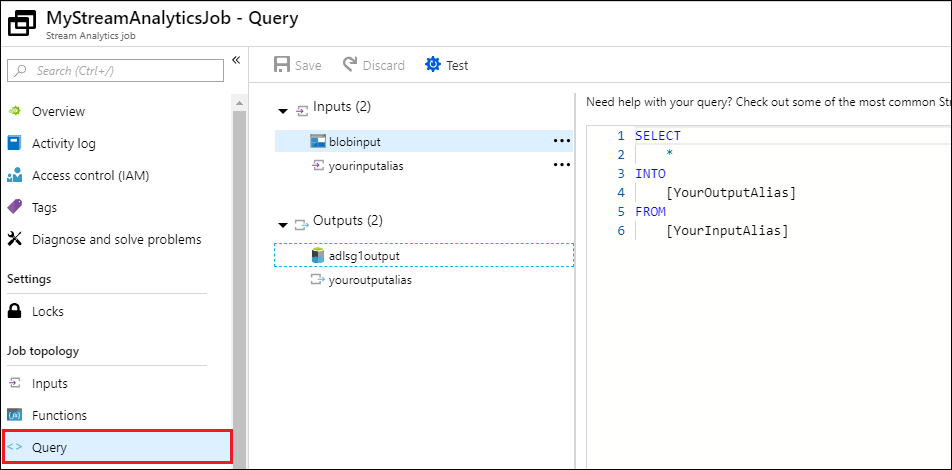

Executar a tarefa do Stream Analytics

Para executar uma tarefa do Stream Analytics, tem de executar uma consulta a partir do separador Consulta. Neste tutorial, pode executar a consulta de exemplo ao substituir os marcadores de posição pelos aliases de entrada e saída da tarefa, conforme mostrado na captura de ecrã abaixo.

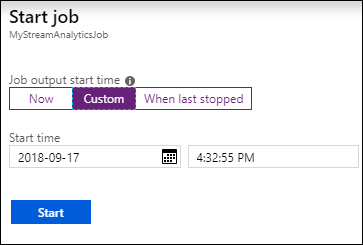

Clique em Guardar na parte superior do ecrã e, em seguida, no separador Descrição geral , clique em Iniciar. Na caixa de diálogo, selecione Hora Personalizada e, em seguida, defina a data e hora atuais.

Clique em Iniciar para iniciar a tarefa. Pode demorar até alguns minutos para iniciar o trabalho.

Para acionar a tarefa para escolher os dados do blob, copie um ficheiro de dados de exemplo para o contentor de blobs. Pode obter um ficheiro de dados de exemplo do Repositório Git do Azure Data Lake. Neste tutorial, vamos copiar o ficheiro vehicle1_09142014.csv. Pode utilizar vários clientes, como Explorador de Armazenamento do Azure, para carregar dados para um contentor de blobs.

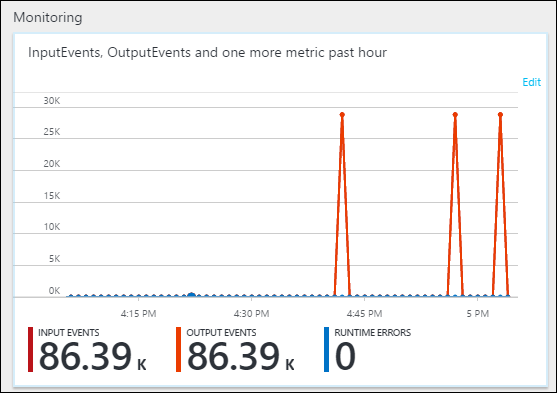

No separador Descrição Geral , em Monitorização, veja como os dados foram processados.

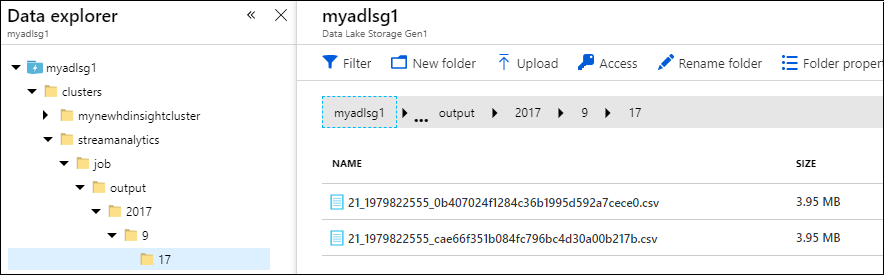

Por fim, pode verificar se os dados de saída da tarefa estão disponíveis na conta Data Lake Storage Gen1.

No painel Data Explorer, repare que o resultado é escrito num caminho de pasta, conforme especificado nas definições de saída do Data Lake Storage Gen1 (

streamanalytics/job/output/{date}/{time}).