Crie uma casa no lago para o Direct Lake

Este artigo descreve como criar uma lakehouse, criar uma tabela Delta na lakehouse e, em seguida, criar um modelo semântico básico para a lakehouse em um espaço de trabalho do Microsoft Fabric.

Antes de começar a criar uma casa no lago para o Direct Lake, leia a visão geral do Direct Lake.

Criar uma casa no lago

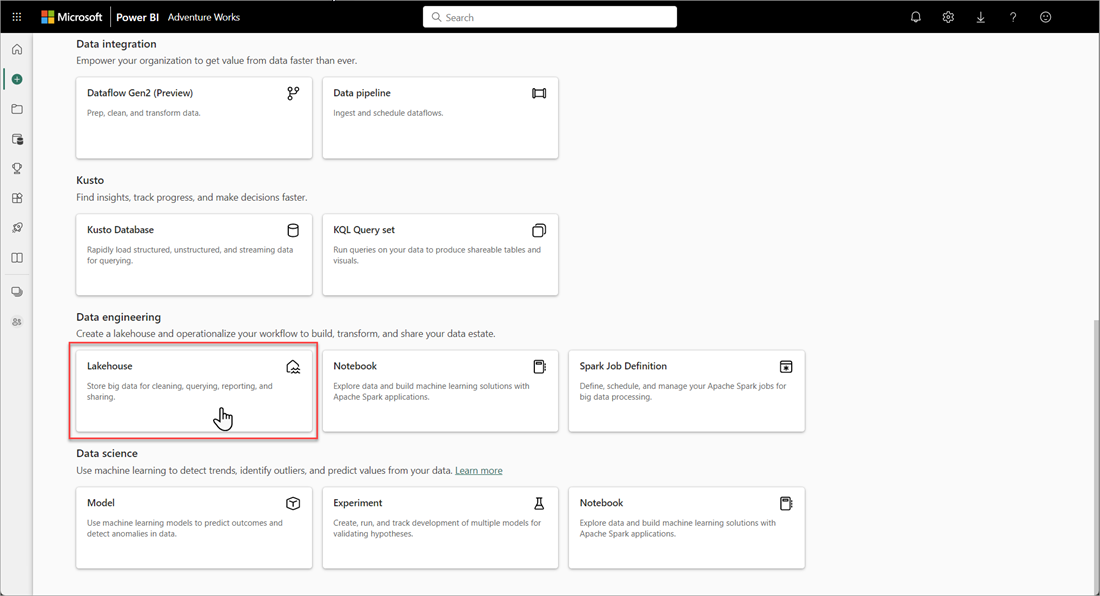

No espaço de trabalho do Microsoft Fabric, selecione Novas>Mais opções e, em Engenharia de Dados, selecione o bloco Lakehouse .

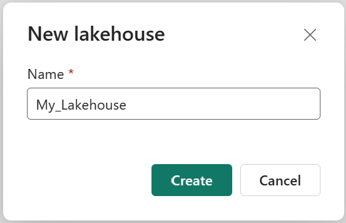

Na caixa de diálogo New lakehouse, insira um nome e selecione Criar. O nome só pode conter caracteres alfanuméricos e sublinhados.

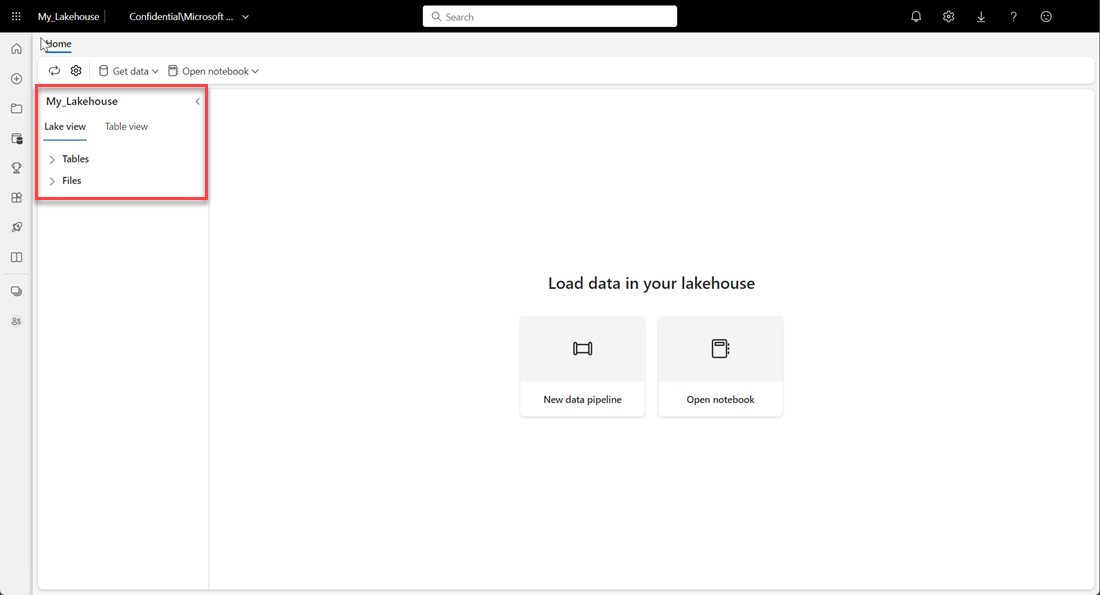

Verifique se a nova casa do lago foi criada e aberta com êxito.

Crie uma tabela Delta na casa do lago

Depois de criar uma nova lakehouse, você deve criar pelo menos uma tabela Delta para que o Direct Lake possa acessar alguns dados. O Direct Lake pode ler arquivos formatados em parquet, mas para obter o melhor desempenho, é melhor compactar os dados usando o método de compactação VORDER. O VORDER compacta os dados usando o algoritmo de compactação nativo do mecanismo do Power BI. Desta forma, o motor pode carregar os dados na memória o mais rápido possível.

Há várias opções para carregar dados em um lakehouse, incluindo pipelines de dados e scripts. As etapas a seguir usam o PySpark para adicionar uma tabela Delta a uma casa de lago com base em um conjunto de dados abertos do Azure:

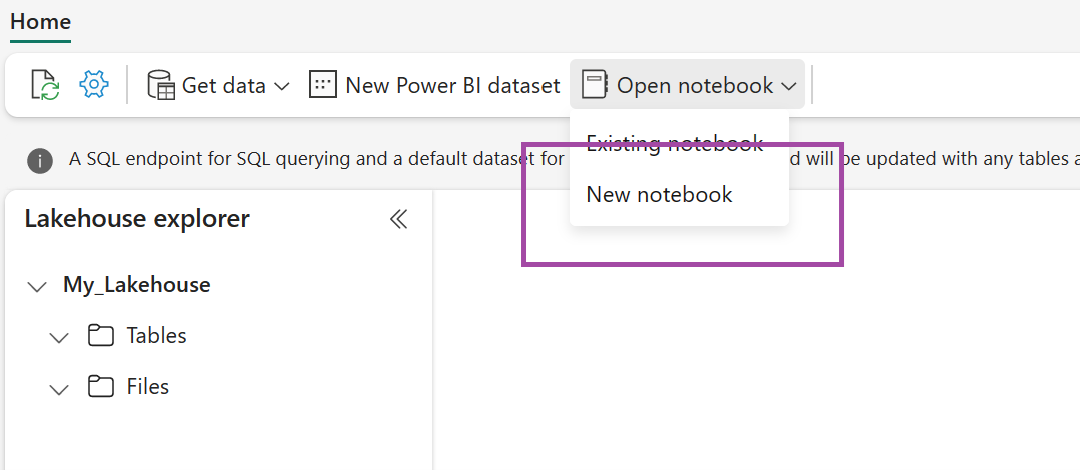

Na casa do lago recém-criada, selecione Abrir bloco de anotações e, em seguida, selecione Novo bloco de anotações.

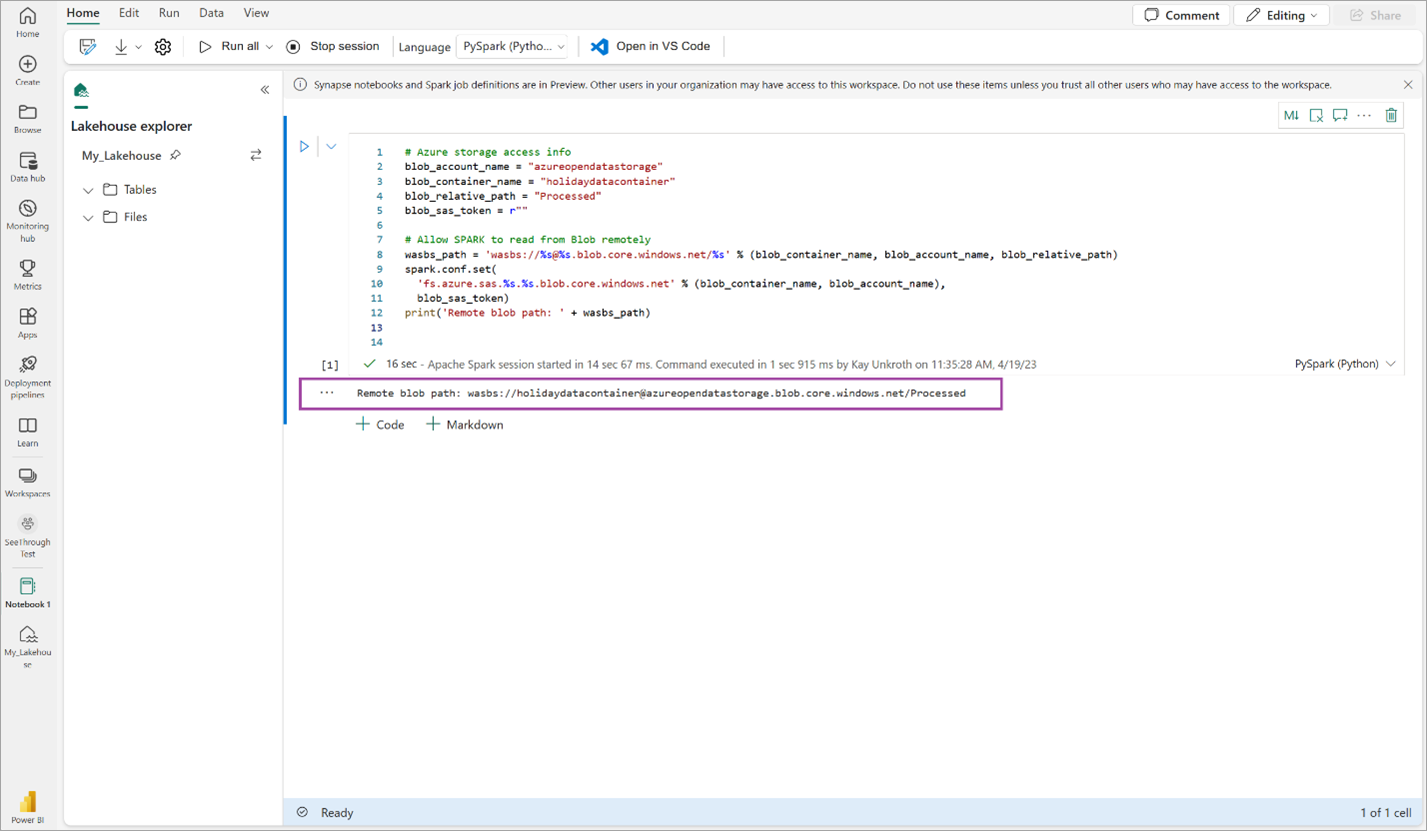

Copie e cole o seguinte trecho de código na primeira célula de código para permitir que o SPARK acesse o modelo aberto e pressione Shift + Enter para executar o código.

# Azure storage access info blob_account_name = "azureopendatastorage" blob_container_name = "holidaydatacontainer" blob_relative_path = "Processed" blob_sas_token = r"" # Allow SPARK to read from Blob remotely wasbs_path = 'wasbs://%s@%s.blob.core.windows.net/%s' % (blob_container_name, blob_account_name, blob_relative_path) spark.conf.set( 'fs.azure.sas.%s.%s.blob.core.windows.net' % (blob_container_name, blob_account_name), blob_sas_token) print('Remote blob path: ' + wasbs_path)Verifique se o código produz com êxito um caminho de blob remoto.

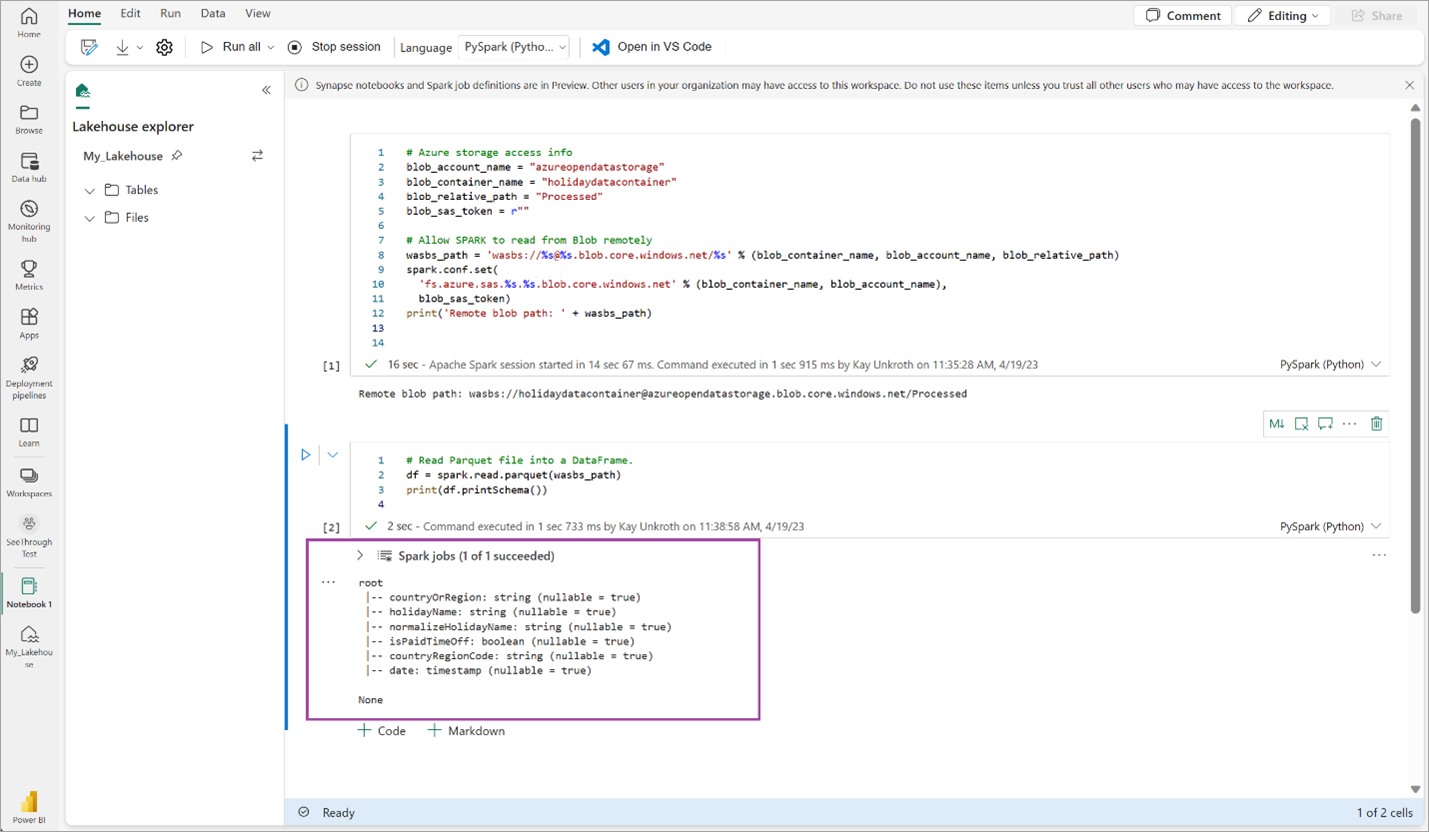

Copie e cole o código a seguir na próxima célula e pressione Shift + Enter.

# Read Parquet file into a DataFrame. df = spark.read.parquet(wasbs_path) print(df.printSchema())Verifique se o código produz com êxito o esquema DataFrame.

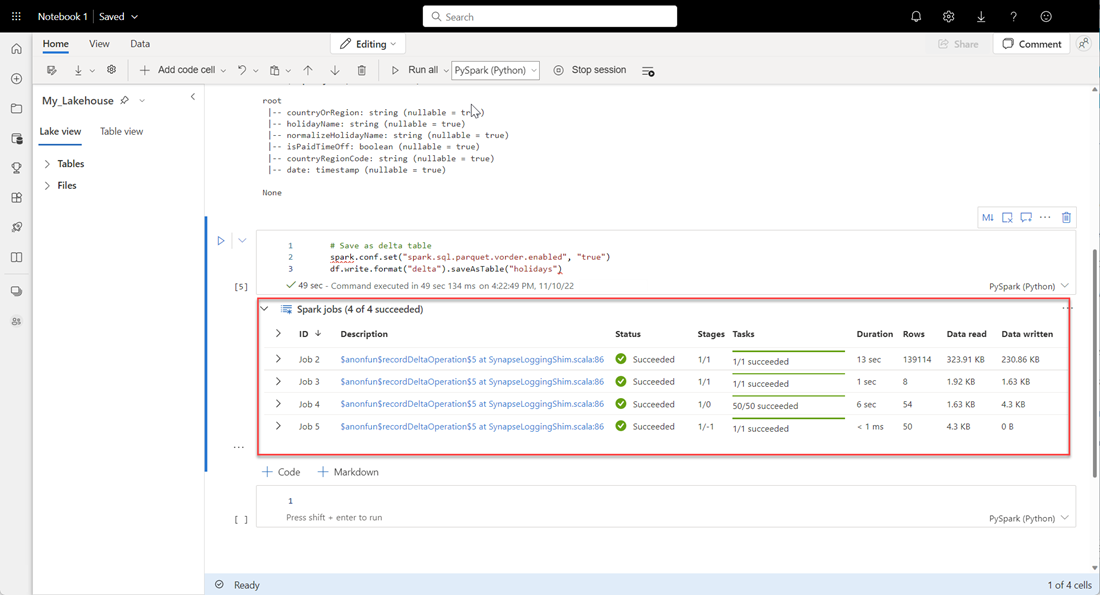

Copie e cole as seguintes linhas na célula seguinte e, em seguida, prima Shift + Enter. A primeira instrução habilita o método de compactação VORDER e a próxima instrução salva o DataFrame como uma tabela Delta na casa do lago.

# Save as delta table spark.conf.set("spark.sql.parquet.vorder.enabled", "true") df.write.format("delta").saveAsTable("holidays")Verifique se todos os trabalhos do SPARK foram concluídos com êxito. Expanda a lista de trabalhos do SPARK para ver mais detalhes.

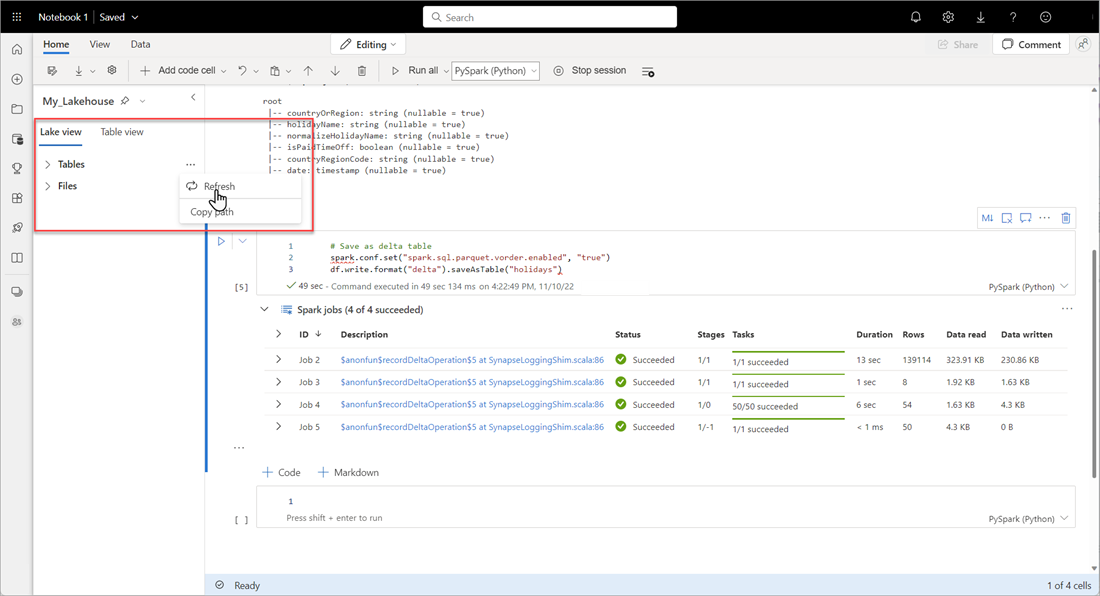

Para verificar se uma tabela foi criada com êxito, na área superior esquerda, ao lado de Tabelas, selecione as reticências (...) e, em seguida, selecione Atualizar e expanda o nó Tabelas .

Usando o mesmo método acima ou outros métodos suportados, adicione mais tabelas Delta para os dados que você deseja analisar.

Crie um modelo básico de Direct Lake para a sua casa no lago

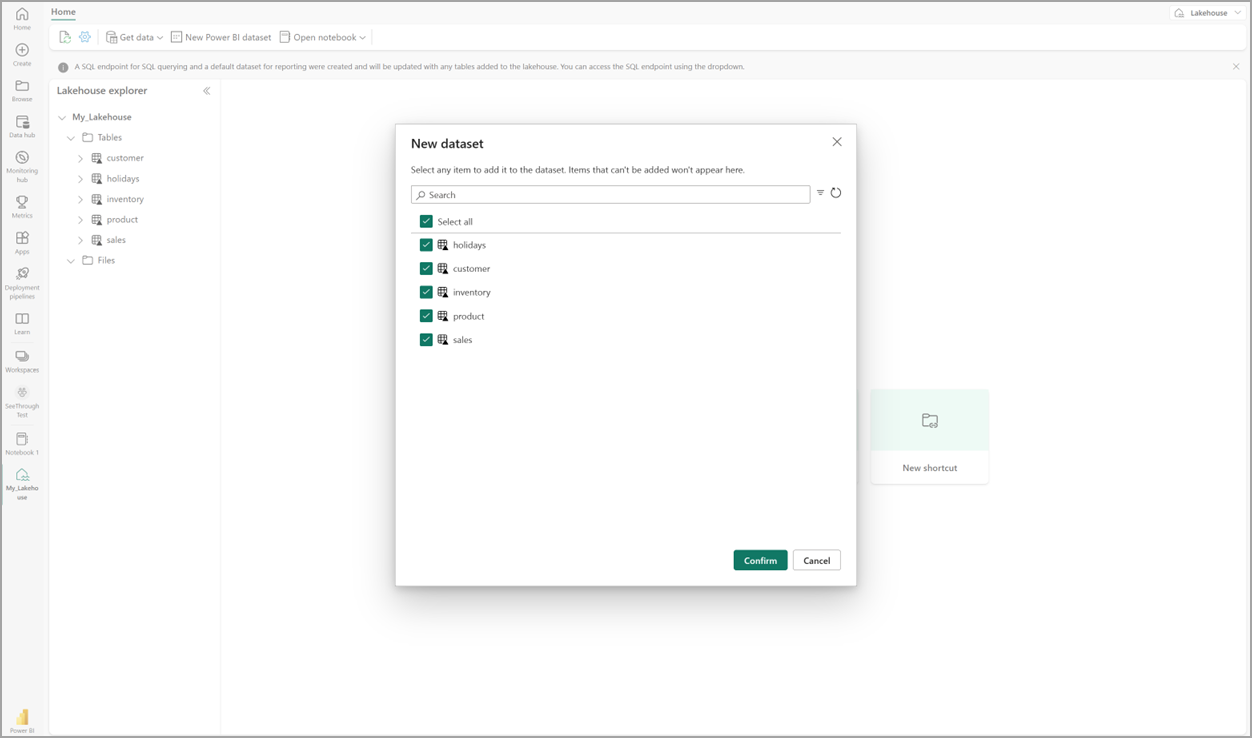

Na sua casa do lago, selecione Novo modelo semântico e, em seguida, na caixa de diálogo, selecione as tabelas a serem incluídas.

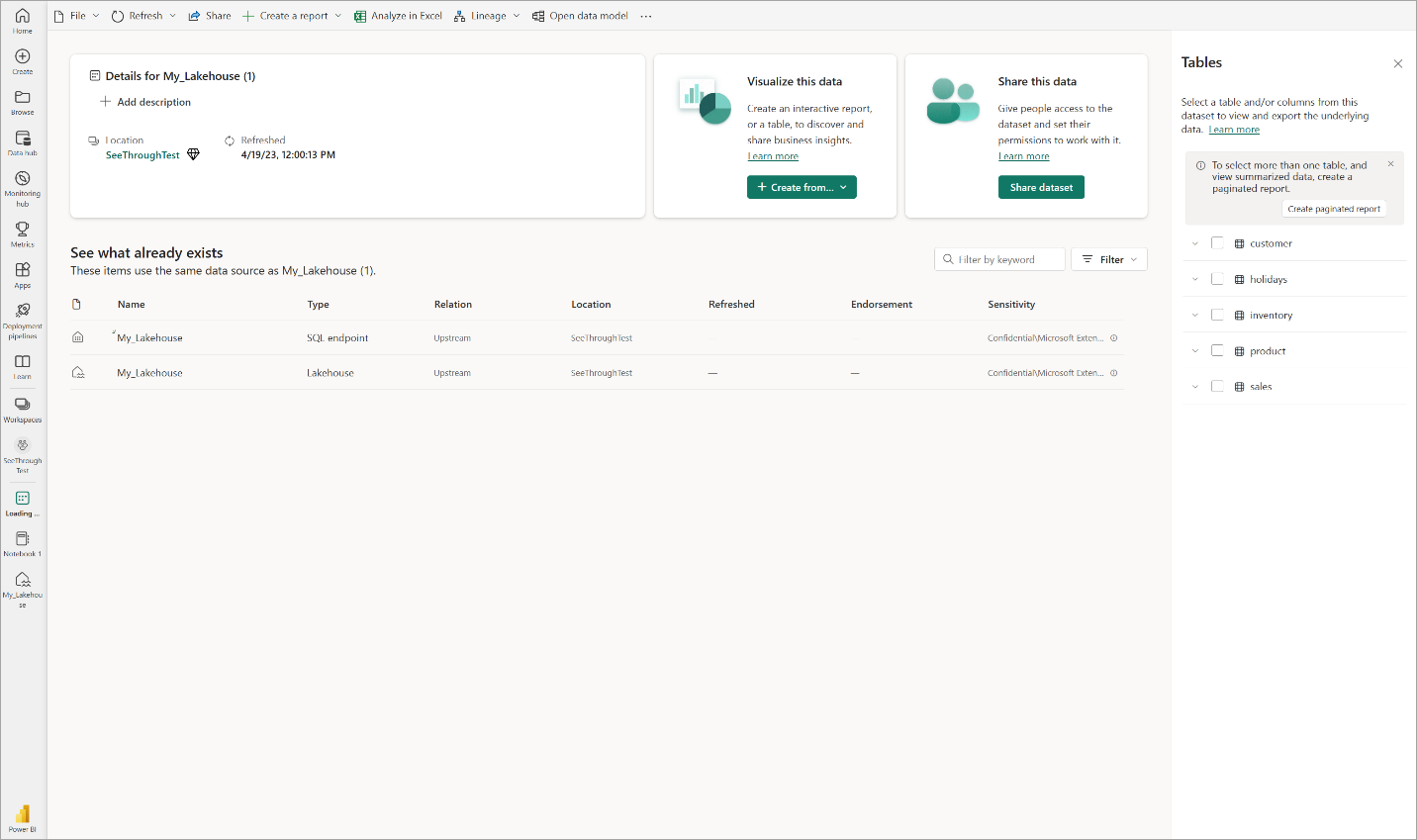

Selecione Confirmar para gerar o modelo Direct Lake. O modelo é salvo automaticamente no espaço de trabalho com base no nome da sua casa do lago e, em seguida, abre o modelo.

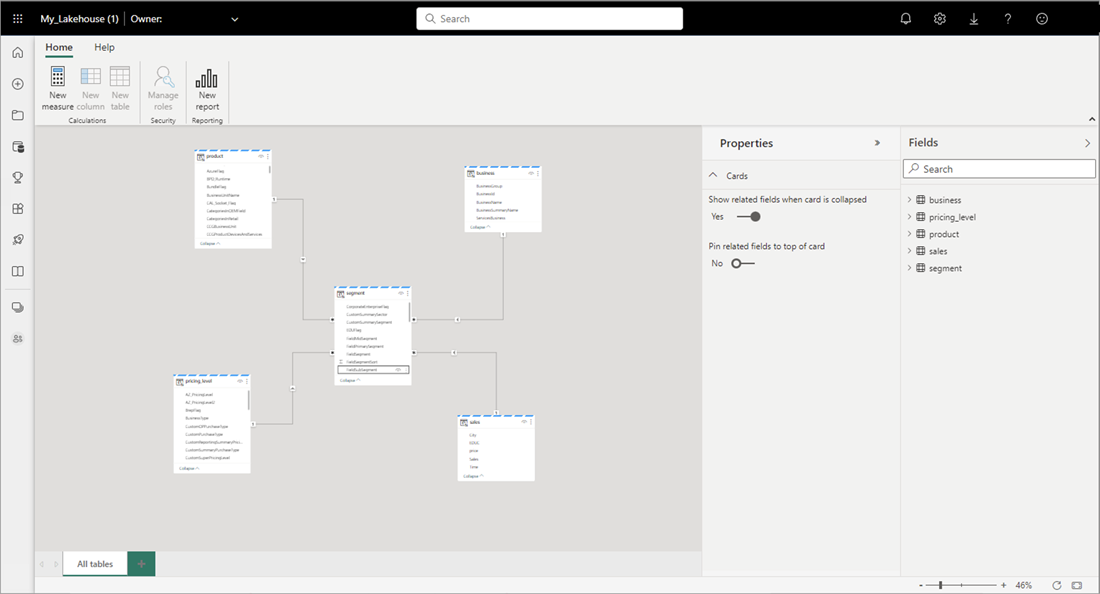

Selecione Abrir modelo de dados para abrir a experiência de modelagem da Web, onde você pode adicionar relações de tabela e medidas DAX.

Quando terminar de adicionar relacionamentos e medidas DAX, você poderá criar relatórios, criar um modelo composto e consultar o modelo por meio de pontos de extremidade XMLA da mesma forma que qualquer outro modelo.