Explore dados em seu banco de dados espelhado com blocos de anotações

Você pode explorar os dados replicados de seu banco de dados espelhado com consultas do Spark em blocos de anotações.

Os notebooks são um poderoso item de código para você desenvolver trabalhos do Apache Spark e experimentos de aprendizado de máquina em seus dados. Você pode usar cadernos no Fabric Lakehouse para explorar suas mesas espelhadas.

Pré-requisitos

- Conclua o tutorial para criar um banco de dados espelhado a partir do banco de dados de origem.

- Tutorial: Configurar o banco de dados espelhado do Microsoft Fabric para o Azure Cosmos DB (Visualização)

- Tutorial: Configurar bancos de dados espelhados do Microsoft Fabric a partir do Azure Databricks (Visualização)

- Tutorial: Configurar bancos de dados espelhados do Microsoft Fabric do Banco de Dados SQL do Azure

- Tutorial: Configurar bancos de dados espelhados do Microsoft Fabric a partir da Instância Gerenciada SQL do Azure (Visualização)

- Tutorial: Configurar bancos de dados espelhados do Microsoft Fabric a partir do Snowflake

Criar um atalho

Primeiro, você precisa criar um atalho de suas mesas espelhadas para o Lakehouse e, em seguida, criar blocos de anotações com consultas do Spark em seu Lakehouse.

No portal Fabric, abra a Engenharia de Dados.

Se você ainda não tem uma Lakehouse criada, selecione Lakehouse e crie uma nova Lakehouse dando-lhe um nome.

Selecione Obter dados -> Novo atalho.

Selecione Microsoft OneLake.

Você pode ver todos os seus bancos de dados espelhados no espaço de trabalho Malha.

Selecione o banco de dados espelhado que você deseja adicionar ao seu Lakehouse, como um atalho.

Selecione as tabelas desejadas no banco de dados espelhado.

Selecione Avançar e, em seguida , Criar.

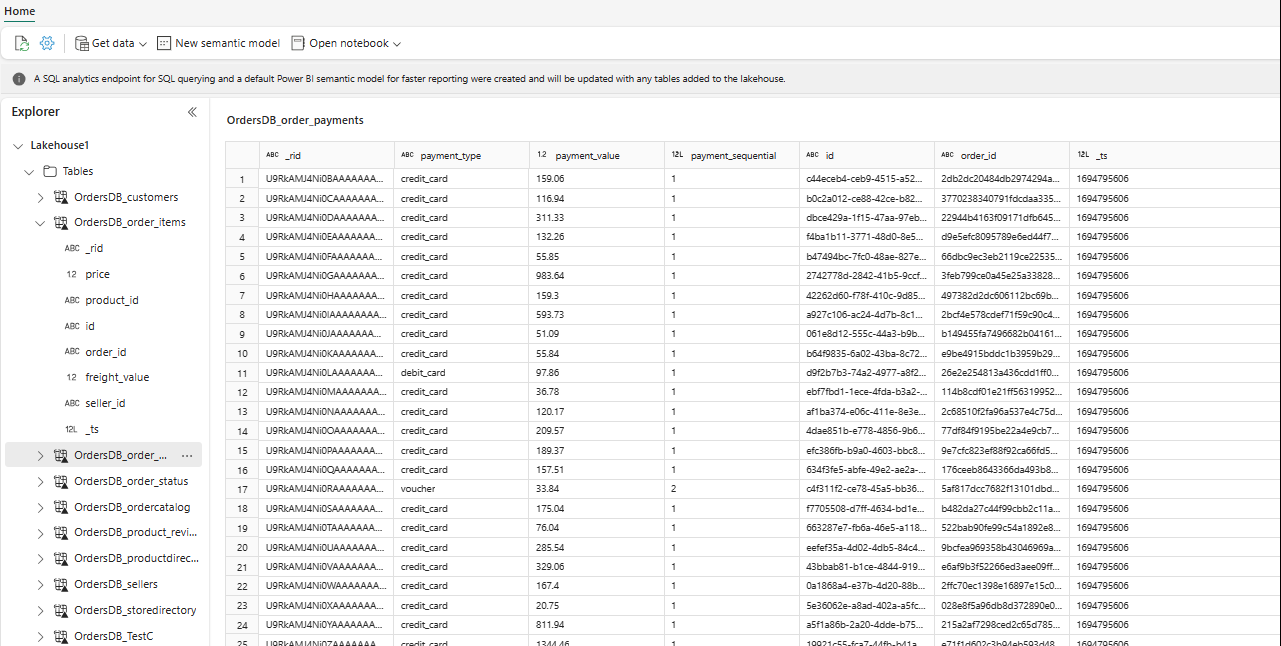

No Explorer, agora você pode ver os dados da tabela selecionada em sua Lakehouse.

Gorjeta

Você pode adicionar outros dados no Lakehouse diretamente ou trazer atalhos como S3, ADLS Gen2. Você pode navegar até o ponto de extremidade de análise SQL do Lakehouse e unir os dados em todas essas fontes com dados espelhados perfeitamente.

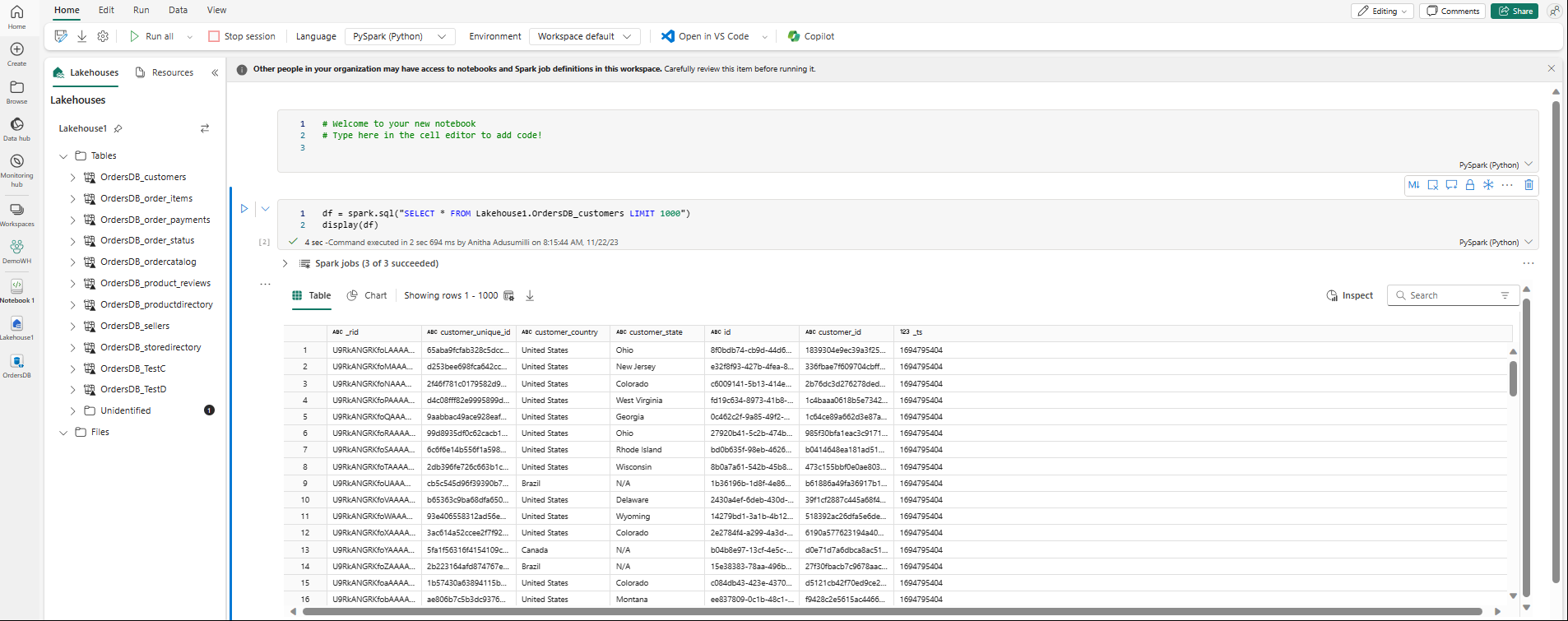

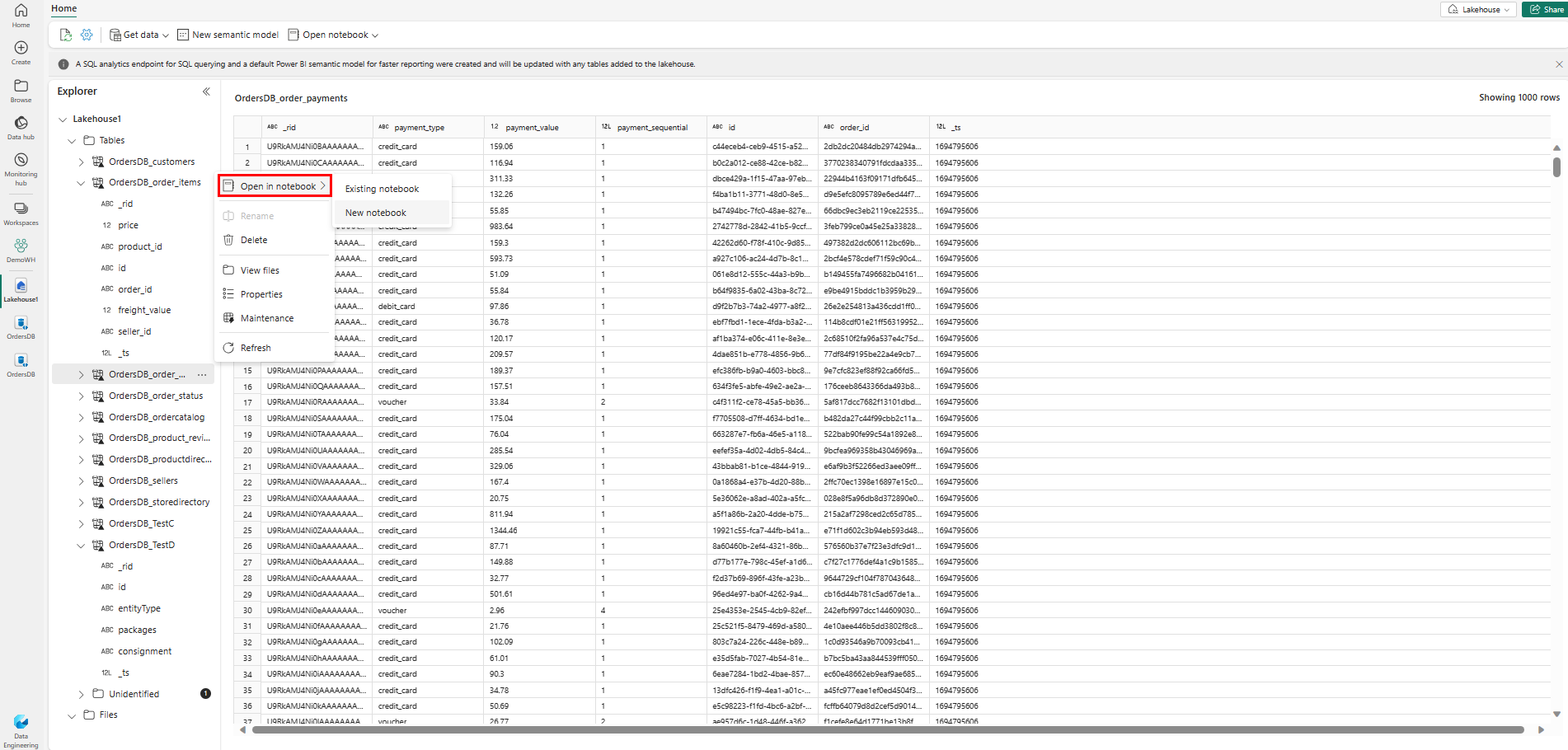

Para explorar esses dados no Spark, selecione os

...pontos ao lado de qualquer tabela. Selecione Novo bloco de anotações ou Bloco de anotações existente para iniciar a análise.

O bloco de anotações será aberto automaticamente e carregará o dataframe com uma

SELECT ... LIMIT 1000consulta SQL do Spark.