Módulo 1: Criar um pipeline com o Data Factory

Este módulo leva 10 minutos, ingerindo dados brutos do armazenamento de origem na tabela Bronze de um Lakehouse de dados usando a atividade Copy em um pipeline.

As etapas de alto nível no módulo 1 são as seguintes:

- Crie um pipeline de dados.

- Utilize uma Atividade de Cópia no pipeline para carregar dados de amostra em um repositório de dados.

Criar um pipeline de dados

É necessária uma conta de locatário do Microsoft Fabric com uma assinatura ativa. Crie uma conta gratuita.

Verifique se você tem um espaço de trabalho habilitado para Microsoft Fabric: Criar um espaço de trabalho.

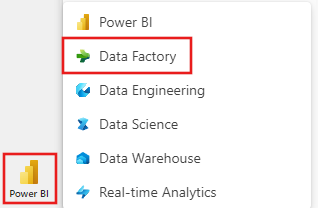

Entre em Power BI.

Selecione o ícone padrão do Power BI no canto inferior esquerdo do ecrã e selecione Fabric.

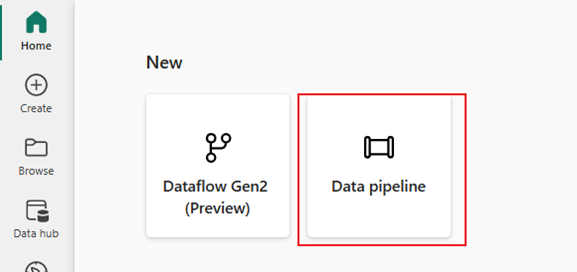

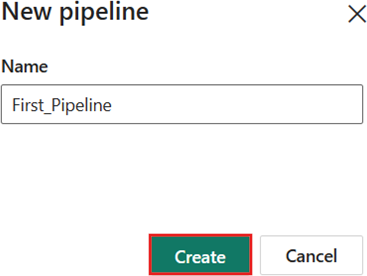

Selecione um espaço de trabalho na aba Espaços de Trabalho, depois selecione + Novo iteme escolha Pipeline de dados. Forneça um nome de pipeline. Em seguida, selecione Criar.

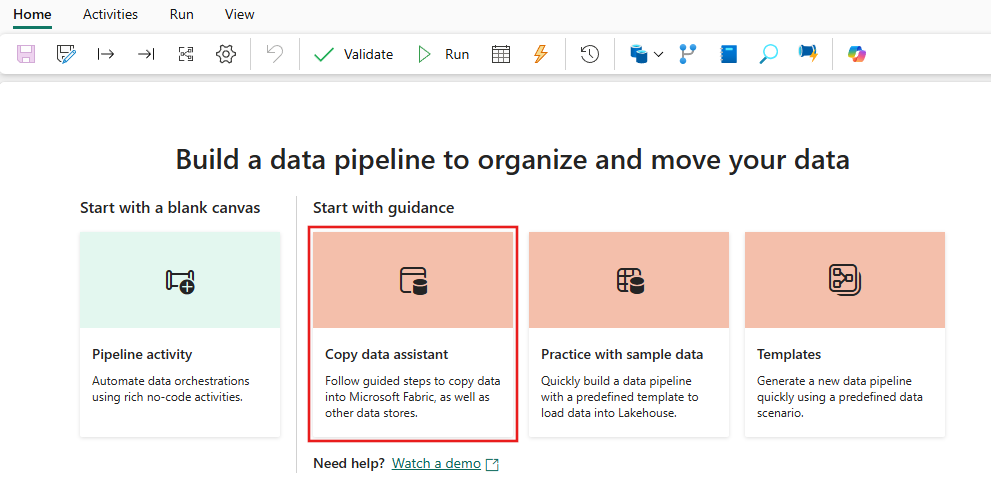

Usar uma atividade de cópia no pipeline para carregar dados de exemplo num data Lakehouse.

Etapa 1: Use o assistente de cópia para configurar uma atividade de cópia.

Selecione Assistente de cópia de dados para abrir a ferramenta de cópia.

Passo 2: Configure as suas definições no assistente de cópia.

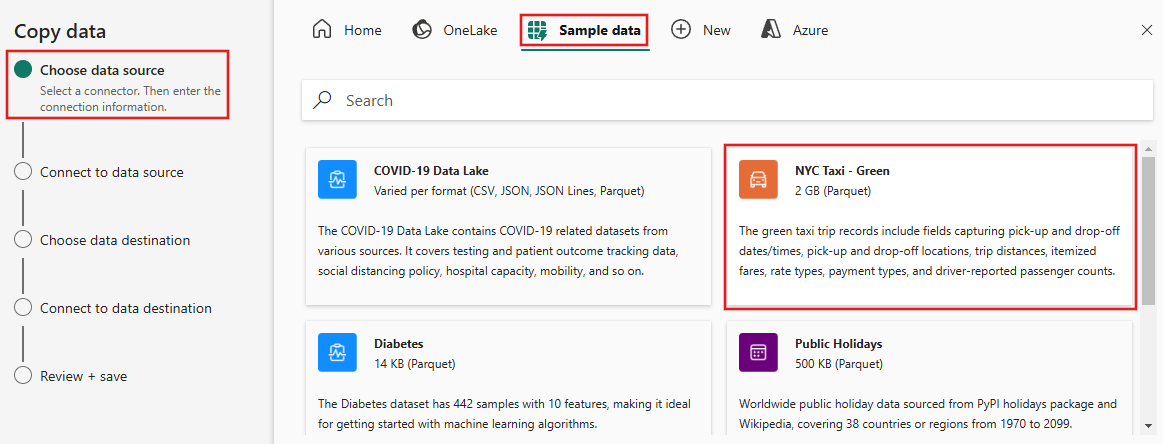

A caixa de diálogo Copiar dados é exibida com a primeira etapa, Escolher fonte de dados, realçada. Selecione dados de exemplo nas opções na parte superior da caixa de diálogo e, em seguida, selecione NYC Taxi - Green.

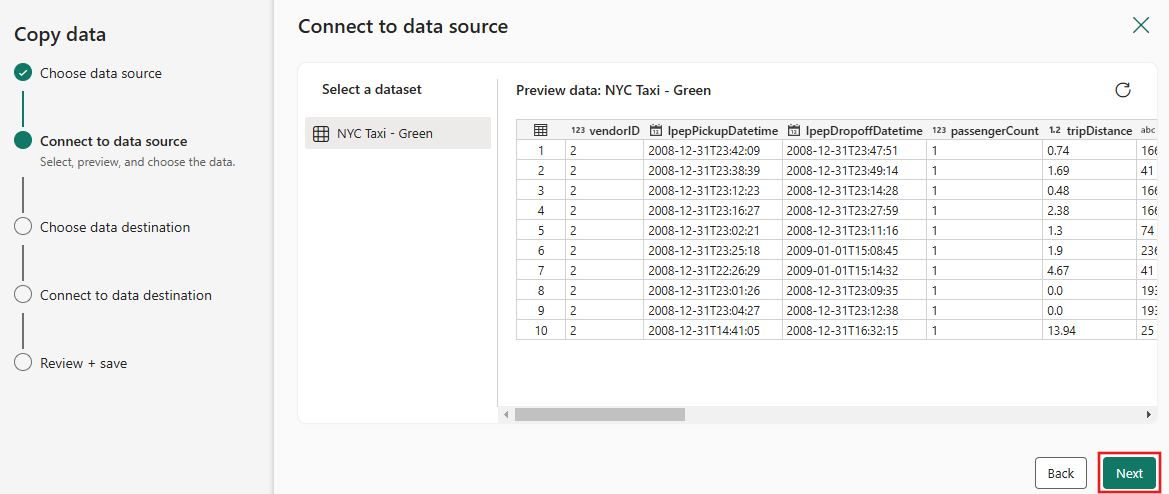

A visualização da fonte de dados aparece em seguida na página Conectar à fonte de dados. Reveja e, em seguida, selecione Seguinte.

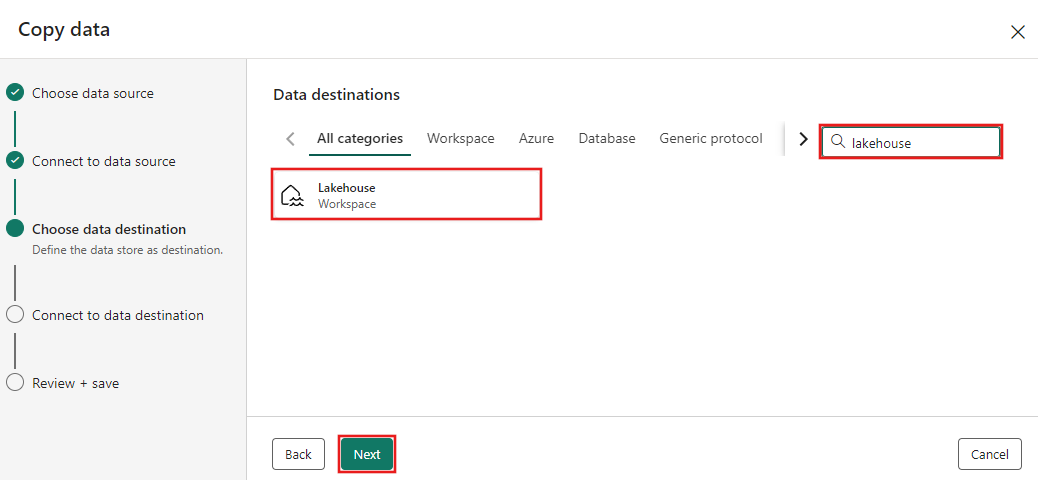

Para na etapa Escolher destino dos dados do assistente de cópia, selecione Lakehouse e depois Avançar.

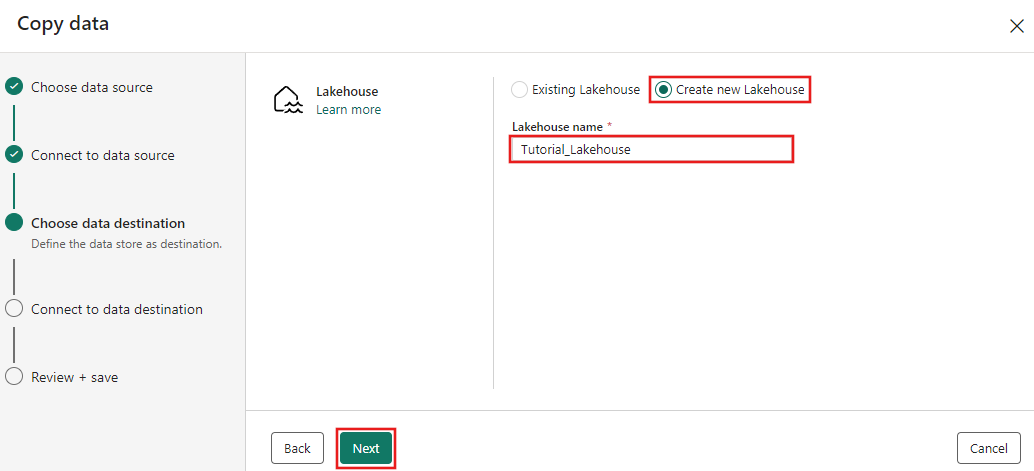

Selecione Criar novo Lakehouse na página de configuração de destino de dados exibida e insira um nome para o novo Lakehouse. Em seguida, selecione Avançar novamente.

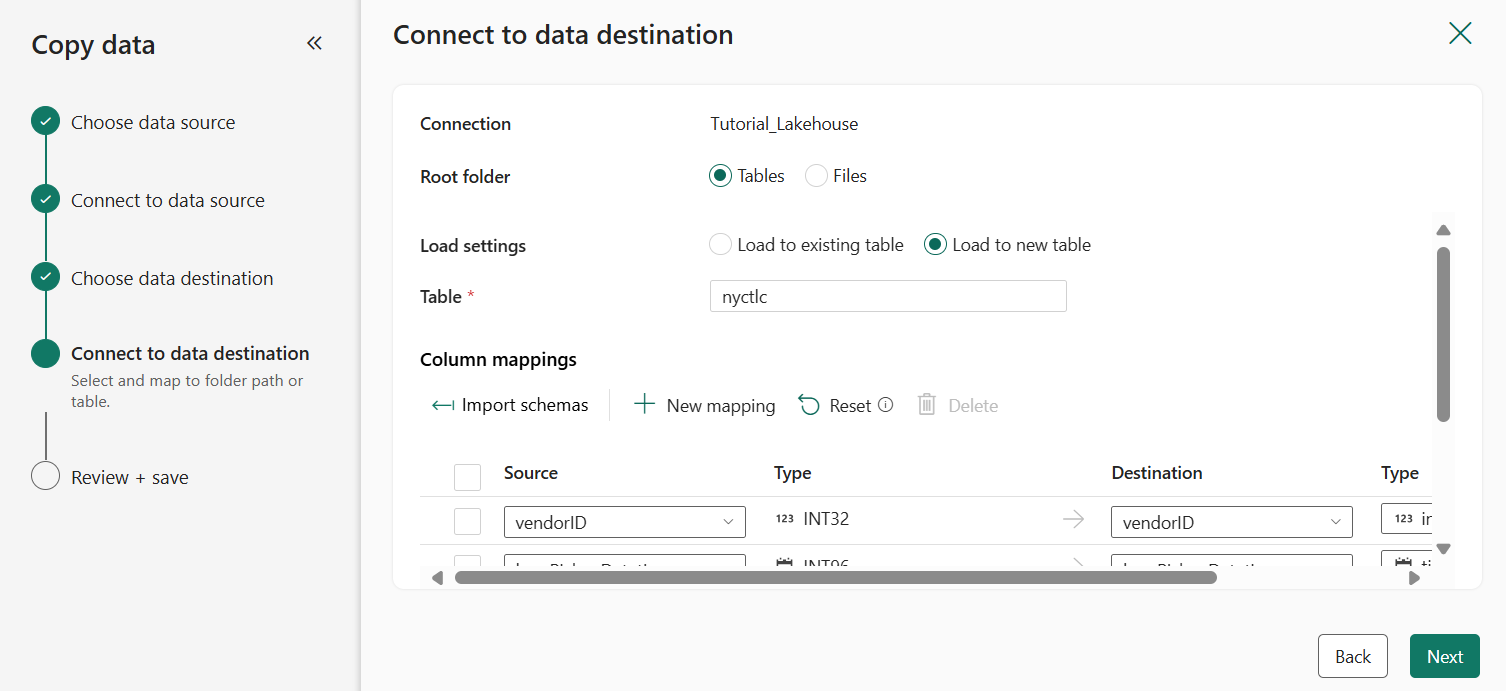

Agora configure os detalhes do seu destino Lakehouse na página Selecionar e mapear para o caminho da pasta ou tabela. Selecione Tabelas para a pasta Raiz, forneça um nome de tabela e escolha a ação Sobrescrever. Não marque a caixa de seleção Habilitar partição que aparece depois de selecionar a ação de tabela Substituir .

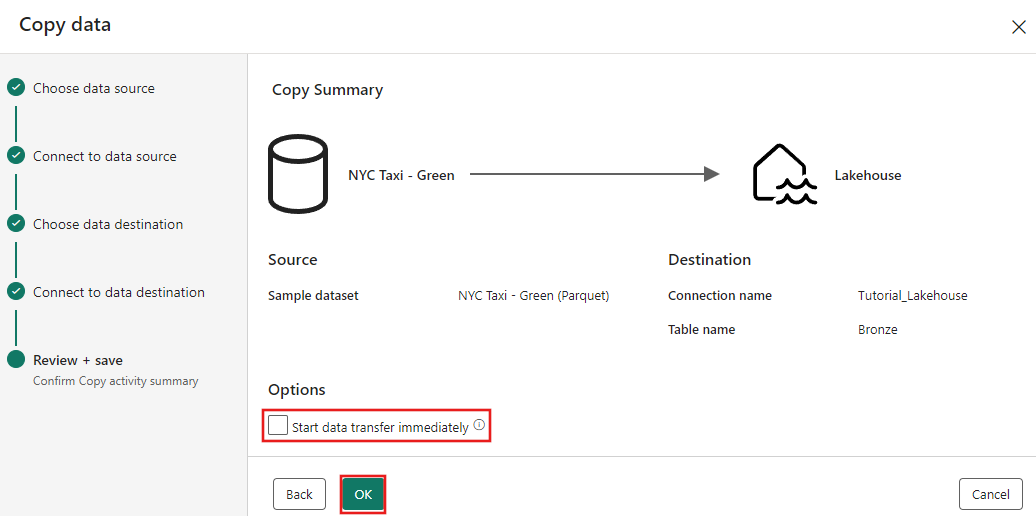

Finalmente, na página Review + Save do assistente de cópia de dados, revise a configuração. Para este tutorial, desmarque a caixa de seleção Iniciar transferência de dados imediatamente, já que executamos a atividade manualmente na próxima etapa. Em seguida, selecione OK.

Passo 3: Execute e visualize os resultados da sua atividade de Cópia.

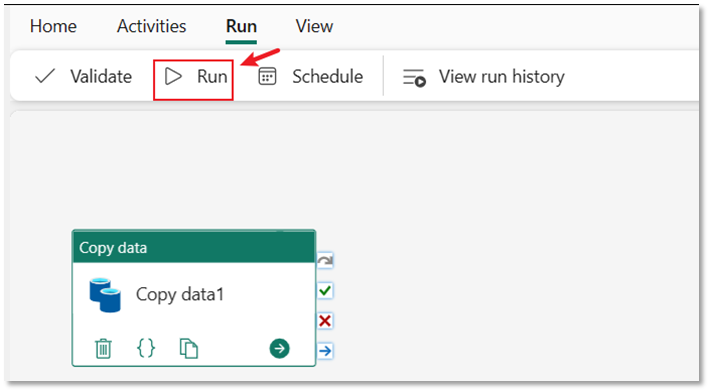

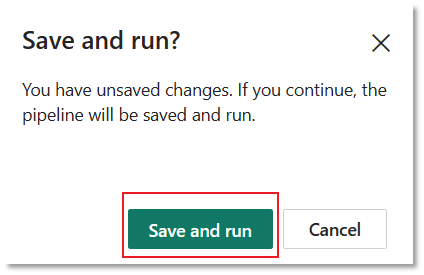

Selecione a guia Executar no editor de pipeline. Em seguida, selecione o botão Executar e, em seguida, Salvar e executar no prompt, para executar a atividade Copiar.

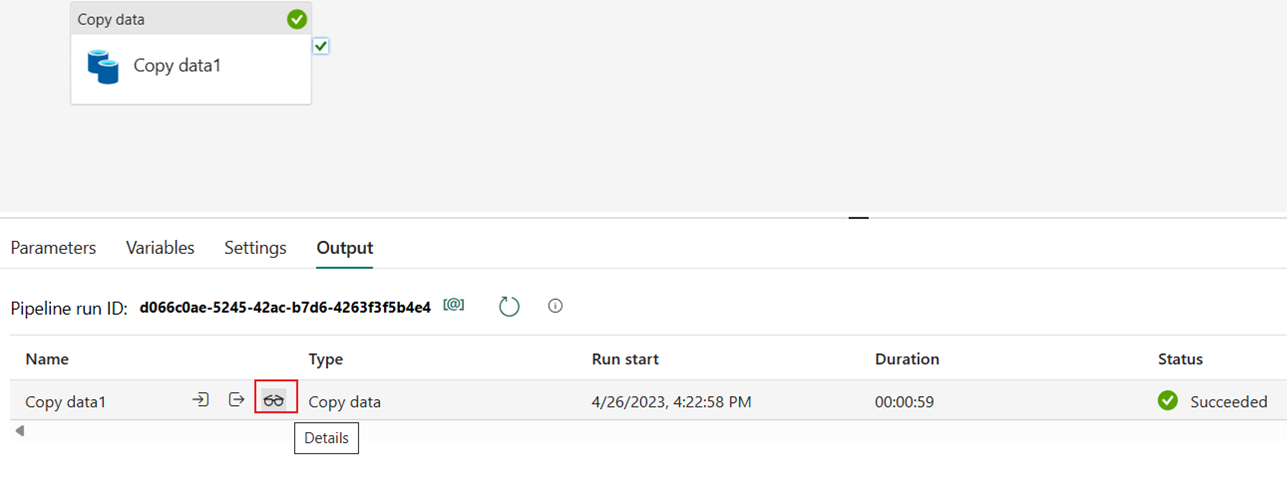

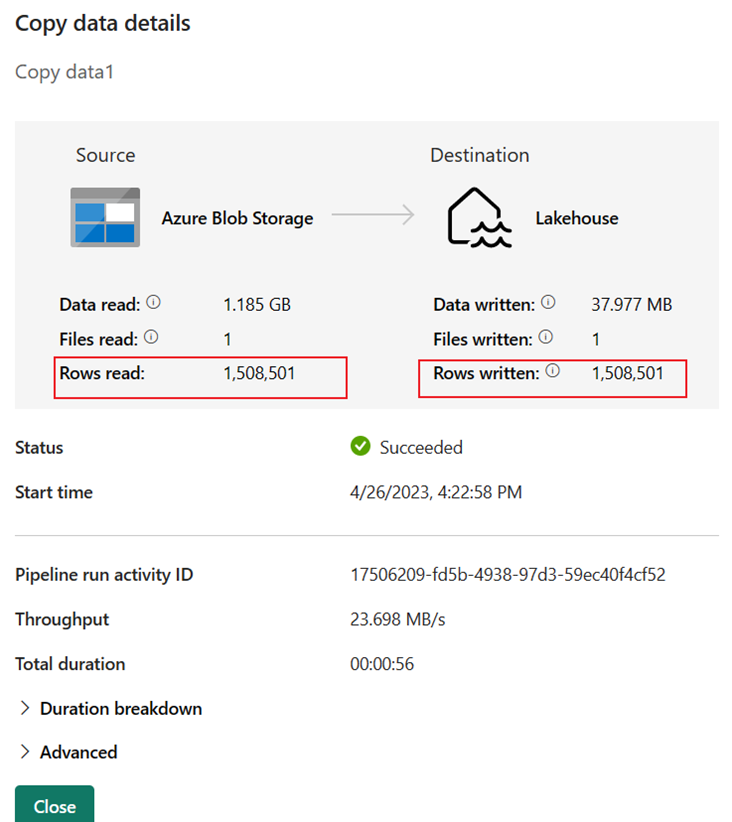

Você pode monitorar a execução e verificar os resultados na guia Output abaixo da tela do pipeline. Selecione o botão de detalhes da execução (o ícone "óculos" que aparece quando você passa o mouse sobre a execução do pipeline em execução) para visualizar os detalhes da execução.

Os detalhes da execução mostram 1.508.501 linhas lidas e escritas.

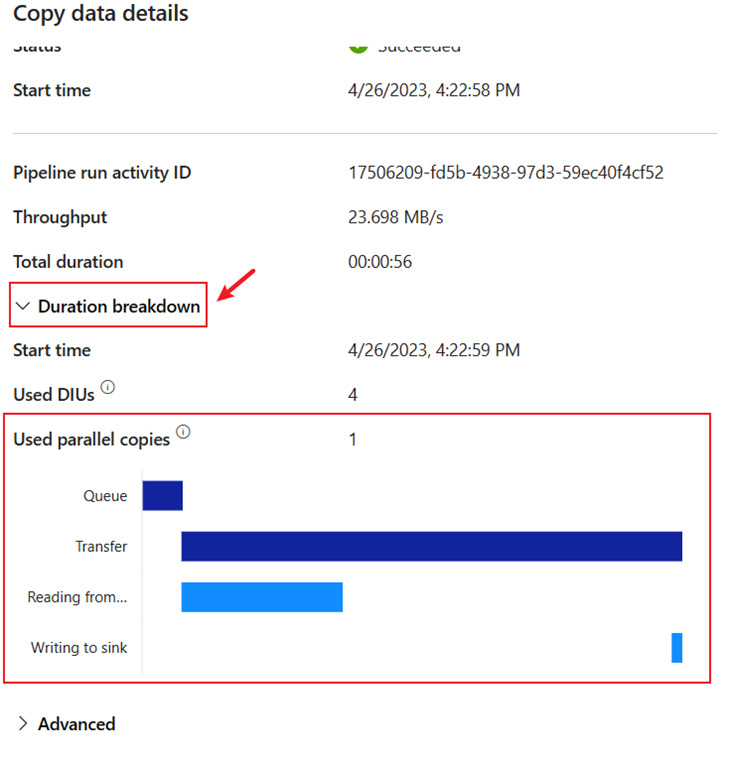

Expanda a seção detalhamento da Duração para ver a duração de cada estágio da atividade de cópia. Depois de rever os detalhes da cópia, selecione Fechar.

Conteúdo relacionado

Neste primeiro módulo do nosso tutorial completo para sua primeira integração de dados usando o Data Factory no Microsoft Fabric, você aprendeu como:

- Crie um pipeline de dados.

- Adicione uma atividade de cópia ao seu pipeline.

- Utilize dados de exemplo e crie um repositório de dados Lakehouse para armazenar os dados numa nova tabela.

- Execute o pipeline e visualize seus detalhes e detalhamento de duração.

Continue para a próxima seção agora para criar seu fluxo de dados.