Cenário de preços usando o Dataflow Gen2 para carregar 2 GB de dados CSV locais em uma tabela Lakehouse

Nesse cenário, o Dataflow Gen2 foi usado para carregar 2 GB de dados CSV locais em uma tabela Lakehouse no Microsoft Fabric.

Os preços usados no exemplo a seguir são hipotéticos e não pretendem implicar preços reais exatos. Estes são apenas para demonstrar como você pode estimar, planejar e gerenciar o custo para projetos do Data Factory no Microsoft Fabric. Além disso, como as capacidades de malha têm preços exclusivos entre regiões, usamos o preço pré-pago para uma capacidade de malha no Oeste dos EUA 2 (uma região típica do Azure), a US$ 0,18 por por hora. Consulte aqui Microsoft Fabric - Pricing para explorar outras opções de preços de capacidade de malha.

Configuração

Para realizar esse cenário, você precisa criar um fluxo de dados com as seguintes etapas:

- Inicializar fluxo de dados: comece carregando arquivos CSV de 2 GB do seu ambiente local para o fluxo de dados.

- Configurar o Power Query:

- Navegue até Power Query.

- Desative a opção para preparar a consulta.

- Prossiga para combinar os arquivos CSV.

- Transformação de dados:

- Promova cabeçalhos para maior clareza.

- Remova colunas desnecessárias.

- Ajuste os tipos de dados de coluna conforme necessário.

- Definir Destino dos Dados de Saída:

- Configure o Lakehouse como o destino de saída de dados.

- Neste exemplo, uma Lakehouse dentro do Fabric foi criada e utilizada.

Estimativa de custos usando o aplicativo Fabric Metrics

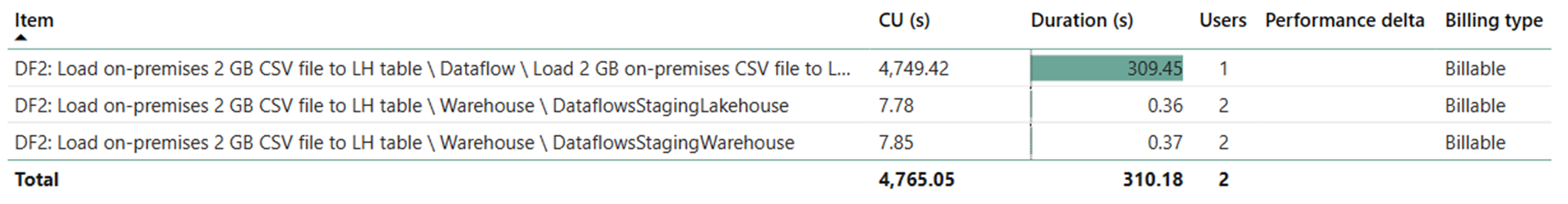

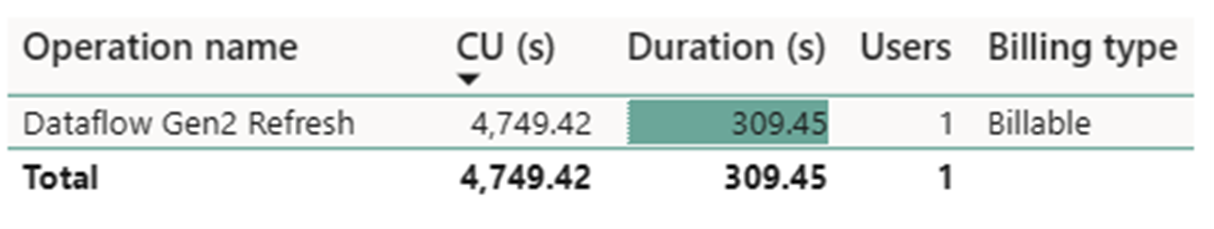

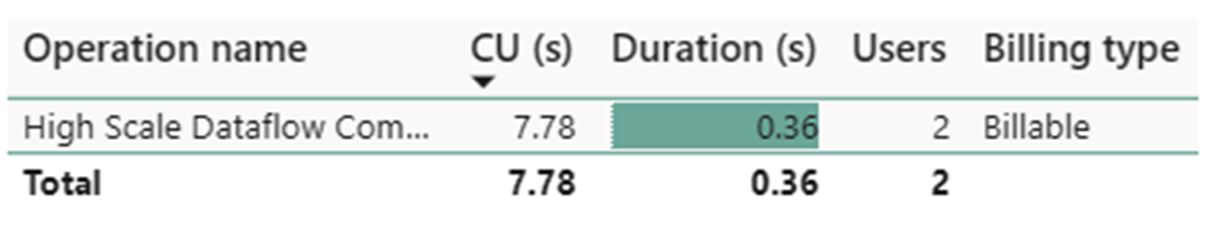

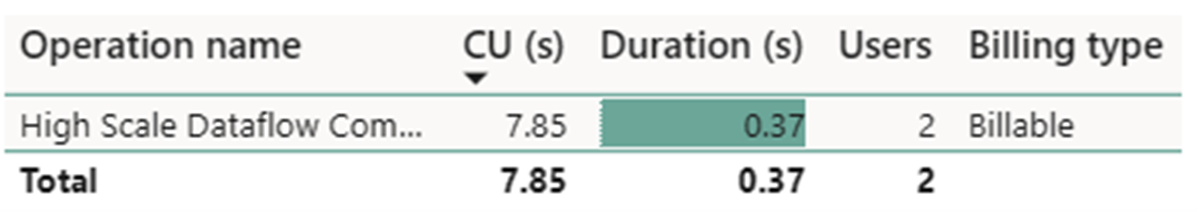

A operação Dataflow Gen2 Refresh consumiu 4749,42 segundos e duas operações High Scale Dataflows Compute consumiram 7,78 segundos + 7,85 segundos cada.

Nota

Embora relatada como uma métrica, a duração real da execução não é relevante ao calcular as horas efetivas com o Fabric Metrics App, uma vez que a métrica segundos que ela também relata já contabiliza sua duração.

| Métrica | Calcular o consumo |

|---|---|

| Segundos de atualização do Dataflow Gen2 | 4749,42 segundos |

| Fluxos de dados de alta escala Compute segundos | (7,78 + 7,85) 15,63 segundos |

| Horas efetivas faturadas | (4749,42 + 15,63) / (60*60) = 1,32 horas |

Custo total de execução em $0.18/hora = (1.32-horas) * ($0.18/hora) ~= $0.24