Monitore o consumo de capacidade do Apache Spark

O objetivo deste artigo é oferecer orientação para administradores que desejam monitorar atividades nas capacidades que gerenciam. Ao utilizar os relatórios de consumo de capacidade do Apache Spark disponíveis no aplicativo Microsoft Fabric Capacity Metrics, os administradores podem obter informações sobre o consumo faturável de capacidade do Spark para itens, incluindo definições de trabalho Lakehouse, Notebook e Apache Spark. Algumas atividades de consumo de capacidade do Spark não são relatadas no aplicativo.

Consumo de capacidade de faísca comunicado

As seguintes operações de lakehouses, notebooks e definições de trabalho do Spark são tratadas como atividades faturáveis.

| Nome da operação | Item | Comentários |

|---|---|---|

| Operações Lakehouse | Casa do Lago | Tabela de visualização de usuários no Lakehouse explorer. |

| Carga da mesa Lakehouse | Casa do Lago | Os usuários carregam a tabela delta no explorador Lakehouse. |

| Execução do bloco de notas | Bloco de Notas | O bloco de notas é executado manualmente pelos utilizadores. |

| Notebook HC executado | Bloco de Notas | O notebook é executado sob a sessão Apache Spark de alta simultaneidade. |

| Execução agendada do bloco de notas | Bloco de Notas | O bloco de anotações é executado acionado por eventos agendados do bloco de anotações. |

| Execução do pipeline do notebook | Bloco de Notas | O notebook é executado acionado por pipeline. |

| Notebook VS Code executado | Bloco de Notas | O notebook é executado no VS Code. |

| Execução do trabalho do Spark | Definição de trabalho do Spark | O trabalho em lote do Spark é executado iniciado pelo envio do usuário. |

| Execução agendada do trabalho do Spark | Definição de trabalho do Spark | O trabalho em lote é executado acionado por eventos agendados do bloco de anotações. |

| Execução do pipeline de trabalho do Spark | Definição de trabalho do Spark | O trabalho em lote é executado acionado pelo pipeline. |

| Trabalho do Spark VS Code executado | Definição de trabalho do Spark | Definição de trabalho do Spark enviada do VS Code. |

Consumo de capacidade de faísca que não é relatado

Há algumas atividades de consumo de capacidade do Spark que não são relatadas no aplicativo de métricas. Essas atividades incluem trabalhos do Spark do sistema para gerenciamento de bibliotecas e certos trabalhos do Spark do sistema para a piscina do Spark Live ou sessões ao vivo.

Gerenciamento de bibliotecas - O consumo de capacidade associado ao gerenciamento de bibliotecas no nível do espaço de trabalho não é relatado no aplicativo de métricas.

Trabalhos do System Spark - O consumo de capacidade do Spark que não está associado a um bloco de anotações, a uma definição de trabalho do Spark ou a uma casa de lago não está incluído no relatório de capacidade.

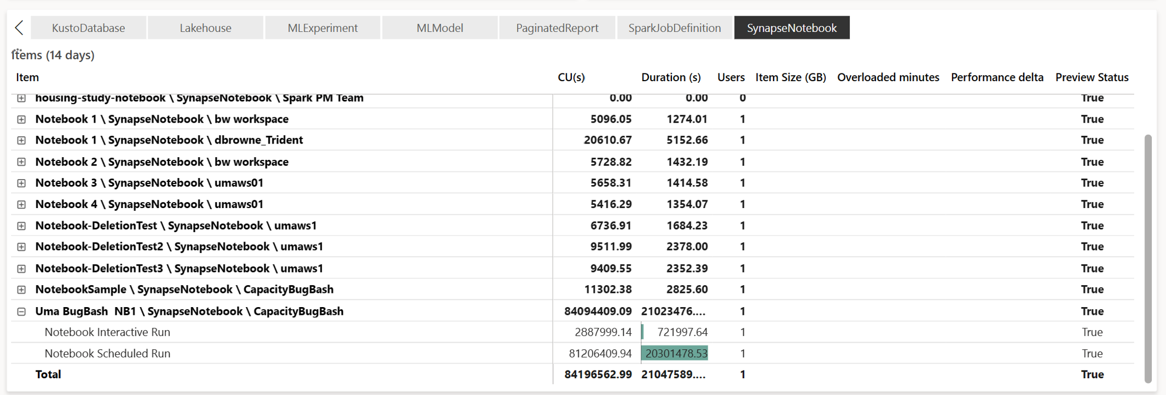

Relatórios de consumo de capacidade

Todas as operações relacionadas ao Spark são classificadas como operações em segundo plano. O consumo de capacidade do Spark é exibido em um bloco de anotações, uma definição de trabalho do Spark ou uma casa de lago, e é agregado por nome da operação e item.

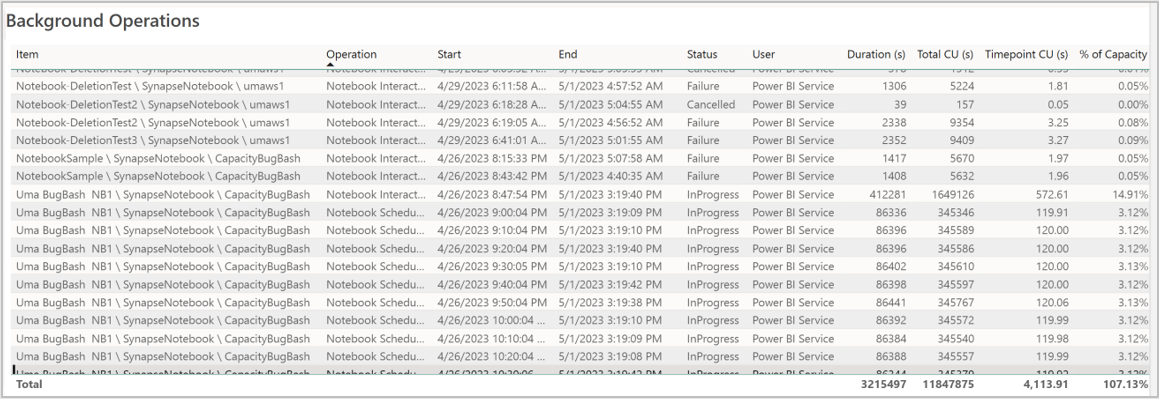

Relatório de operações em segundo plano

As operações em segundo plano são exibidas para um ponto de tempo específico. Na tabela do relatório, cada linha refere-se a uma operação do usuário. Revise a coluna Usuário para identificar quem executou uma operação específica. Se precisar de mais informações sobre uma operação específica, você pode usar sua ID de operação para procurá-la no hub de monitoramento do Microsoft Fabric.