Migrar pools do Spark do Azure Synapse Analytics para o Fabric

Enquanto o Azure Synapse fornece pools do Spark, o Fabric oferece pools iniciais e pools personalizados. O Pool inicial pode ser uma boa opção se você tiver um único pool sem configurações ou bibliotecas personalizadas no Azure Synapse e se o tamanho do nó Médio atender às suas necessidades. No entanto, se você busca mais flexibilidade com suas configurações de pool Spark, recomendamos o uso de pools personalizados. Há duas opções aqui:

- Opção 1: Mova o pool do Spark para o pool padrão de um espaço de trabalho.

- Opção 2: Mova seu pool do Spark para um ambiente personalizado no Fabric.

Se você tiver mais de um pool do Spark e planeja movê-los para o mesmo espaço de trabalho do Fabric, recomendamos o uso da Opção 2, criando vários ambientes e pools personalizados.

Para obter considerações sobre o pool do Spark, consulte as diferenças entre o Azure Synapse Spark e o Fabric.

Pré-requisitos

Se você ainda não tiver um, crie um espaço de trabalho de malha em seu locatário.

Opção 1: Do pool do Spark para o pool padrão do espaço de trabalho

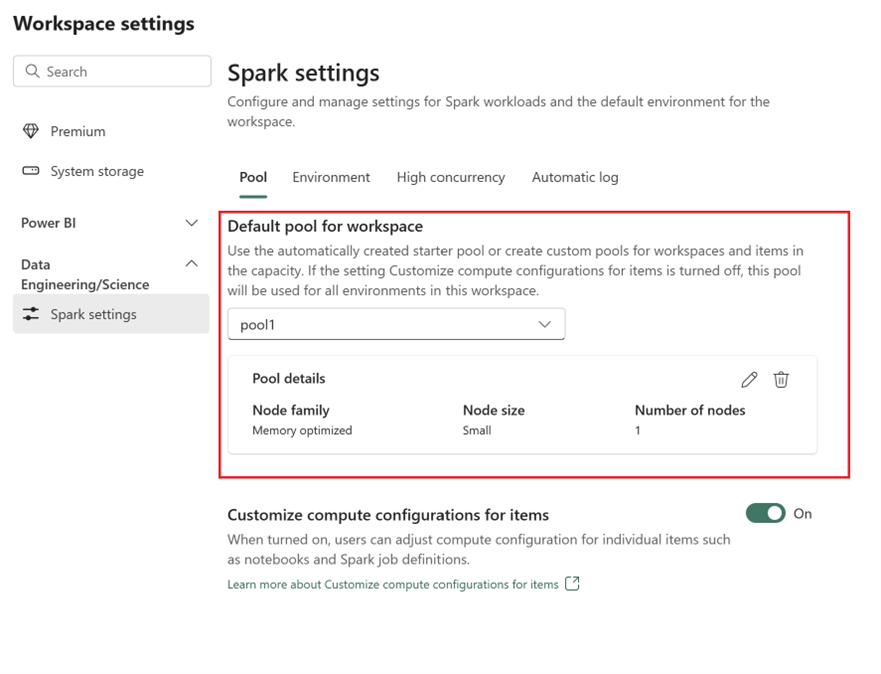

Você pode criar um pool do Spark personalizado a partir do espaço de trabalho do Fabric e usá-lo como o pool padrão no espaço de trabalho. O pool padrão é usado por todos os blocos de anotações e definições de trabalho do Spark no mesmo espaço de trabalho.

Para mover de um pool do Spark existente do Azure Synapse para um pool padrão de espaço de trabalho:

- Acessar o espaço de trabalho do Azure Synapse: entre no Azure. Navegue até o espaço de trabalho do Azure Synapse, vá para Pools do Google Analytics e selecione Pools do Apache Spark.

- Localize o pool do Spark: Nos pools do Apache Spark, localize o pool do Spark que você deseja mover para o Fabric e verifique as Propriedades do pool.

- Obter propriedades: obtenha as propriedades do pool do Spark, como a versão do Apache Spark, a família de tamanho do nó, o tamanho do nó ou o dimensionamento automático. Consulte as considerações do Spark pool para ver as diferenças.

-

Crie um pool de faíscas personalizado no Fabric:

- Vá para o espaço de trabalho do Fabric e selecione Configurações do espaço de trabalho.

- Vá para Engenharia de Dados/Ciência e selecione Configurações do Spark.

- Na guia Pool e na seção Pool padrão para espaço de trabalho, expanda o menu suspenso e selecione criar novo pool.

- Crie seu pool personalizado com os valores de destino correspondentes. Preencha as opções de nome, família de nós, tamanho do nó, dimensionamento automático e alocação dinâmica do executor.

-

Selecione uma versão de tempo de execução:

- Vá para a guia Ambiente e selecione a Versão de Tempo de Execução necessária. Veja os tempos de execução disponíveis aqui.

- Desative a opção Definir ambiente padrão.

Nota

Nesta opção, não há suporte para bibliotecas ou configurações no nível do pool. No entanto, você pode ajustar a configuração de computação para itens individuais, como blocos de anotações e definições de trabalho do Spark, e adicionar bibliotecas embutidas. Se você precisar adicionar bibliotecas e configurações personalizadas a um ambiente, considere um ambiente personalizado.

Opção 2: Da piscina de faíscas para o ambiente personalizado

Com ambientes personalizados, você pode configurar propriedades e bibliotecas personalizadas do Spark. Para criar um ambiente personalizado:

- Acessar o espaço de trabalho do Azure Synapse: entre no Azure. Navegue até o espaço de trabalho do Azure Synapse, vá para Pools do Google Analytics e selecione Pools do Apache Spark.

- Localize o pool do Spark: Nos pools do Apache Spark, localize o pool do Spark que você deseja mover para o Fabric e verifique as Propriedades do pool.

- Obter propriedades: obtenha as propriedades do pool do Spark, como a versão do Apache Spark, a família de tamanho do nó, o tamanho do nó ou o dimensionamento automático. Consulte as considerações do Spark pool para ver as diferenças.

-

Crie um pool de faíscas personalizado:

- Vá para o espaço de trabalho do Fabric e selecione Configurações do espaço de trabalho.

- Vá para Engenharia de Dados/Ciência e selecione Configurações do Spark.

- Na guia Pool e na seção Pool padrão para espaço de trabalho, expanda o menu suspenso e selecione criar novo pool.

- Crie seu pool personalizado com os valores de destino correspondentes. Preencha as opções de nome, família de nós, tamanho do nó, dimensionamento automático e alocação dinâmica do executor.

- Crie um item Ambiente se não tiver um.

-

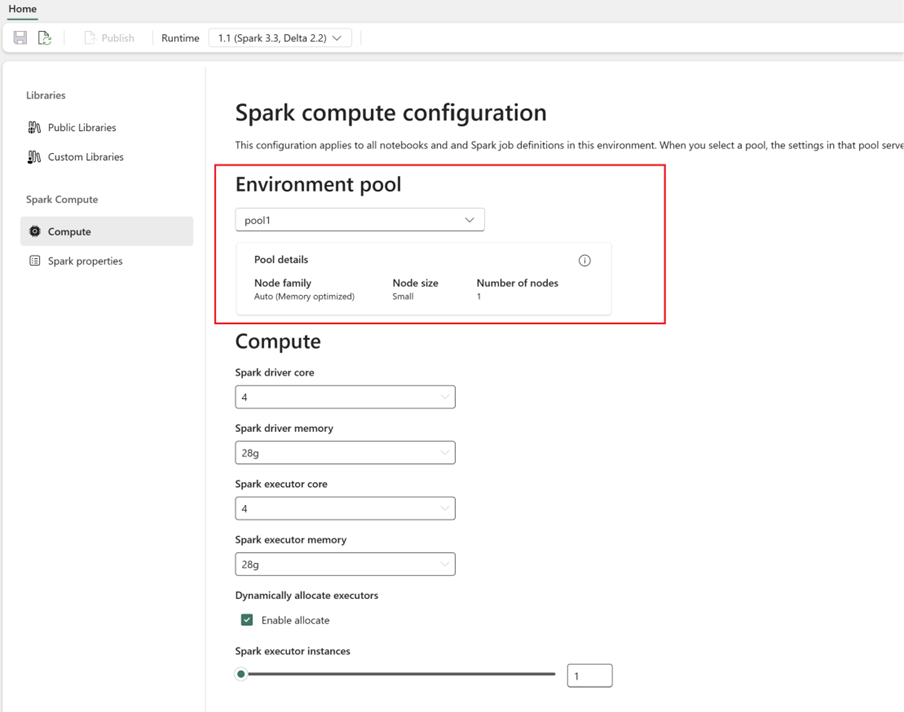

Configurar a computação do Spark:

- No Ambiente, vá para Spark Compute>Compute.

- Selecione o pool recém-criado para o novo ambiente.

- Você pode configurar núcleos e memória de driver e executores.

- Selecione uma versão de tempo de execução para o ambiente. Veja os tempos de execução disponíveis aqui.

- Clique em Salvar e publicar alterações.

Saiba mais sobre como criar e usar um ambiente.