Navegue pelos aplicativos Apache Spark no Fabric Monitor

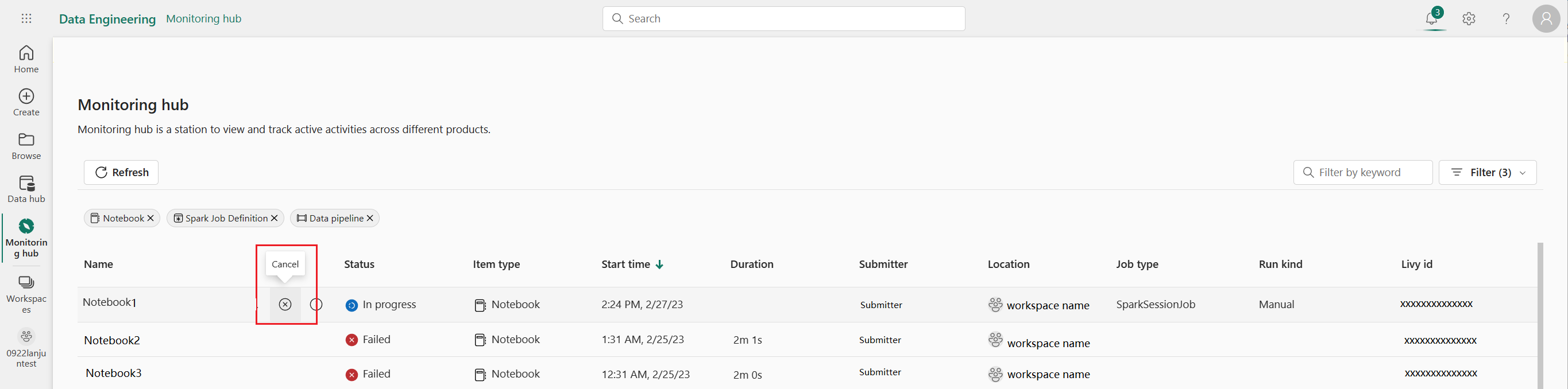

O painel Monitor serve como um portal centralizado para navegar pelas atividades do Apache Spark entre itens. Quando você estiver em Engenharia de Dados ou Ciência de Dados, poderá visualizar aplicativos Apache Spark em andamento acionados a partir de notebooks, definições de trabalho do Apache Spark e pipelines. Você também pode pesquisar e filtrar aplicativos Apache Spark com base em diferentes critérios. Além disso, você pode cancelar seus aplicativos Apache Spark em andamento e fazer drill down para ver mais detalhes de execução de um aplicativo Apache Spark.

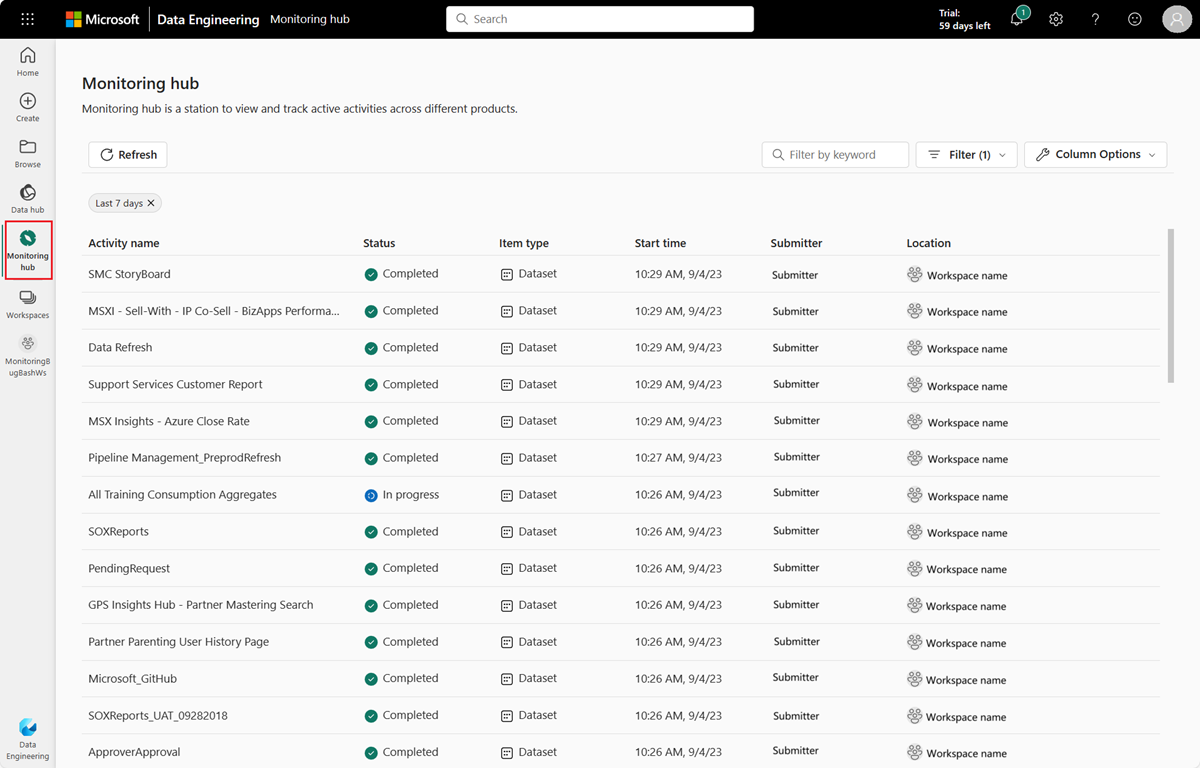

Aceder ao painel Monitor

Você pode acessar o painel Monitor para visualizar várias atividades do Apache Spark selecionando Monitor na barra de navegação.

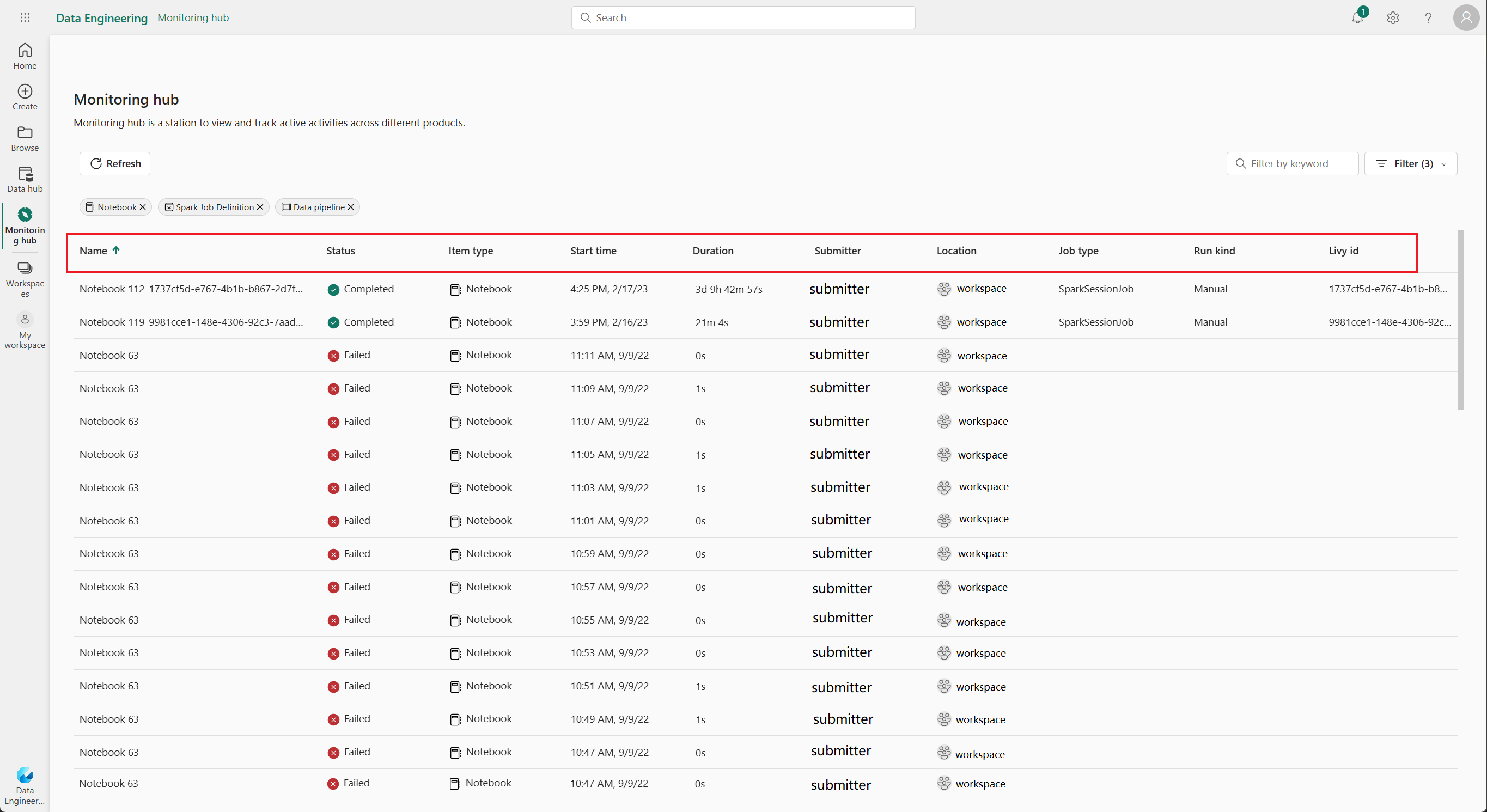

Opções de classificação, pesquisa, filtro e coluna Aplicações Apache Spark

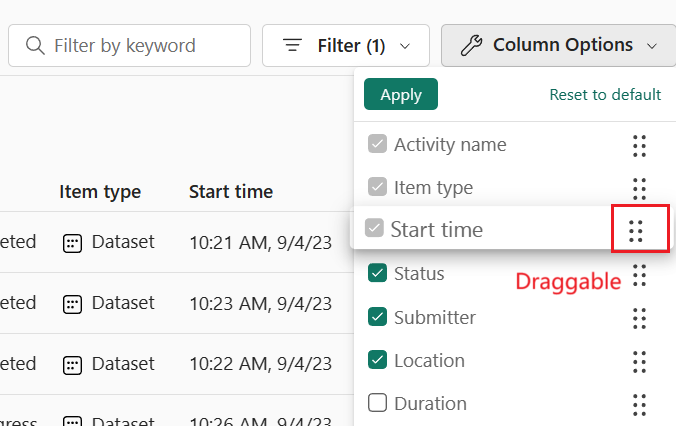

Para melhor usabilidade e descoberta, você pode classificar os aplicativos Apache Spark selecionando colunas diferentes na interface do usuário. Você também pode filtrar os aplicativos com base em diferentes colunas e pesquisar aplicativos específicos. Você também pode ajustar a exibição e a ordem de classificação das colunas independentemente através das opções de coluna.

Classificar aplicativos Apache Spark

Para classificar aplicativos Apache Spark, você pode selecionar em cada cabeçalho de coluna, como Nome, Status, Tipo de Item, Hora de Início, Localizaçãoe assim por diante.

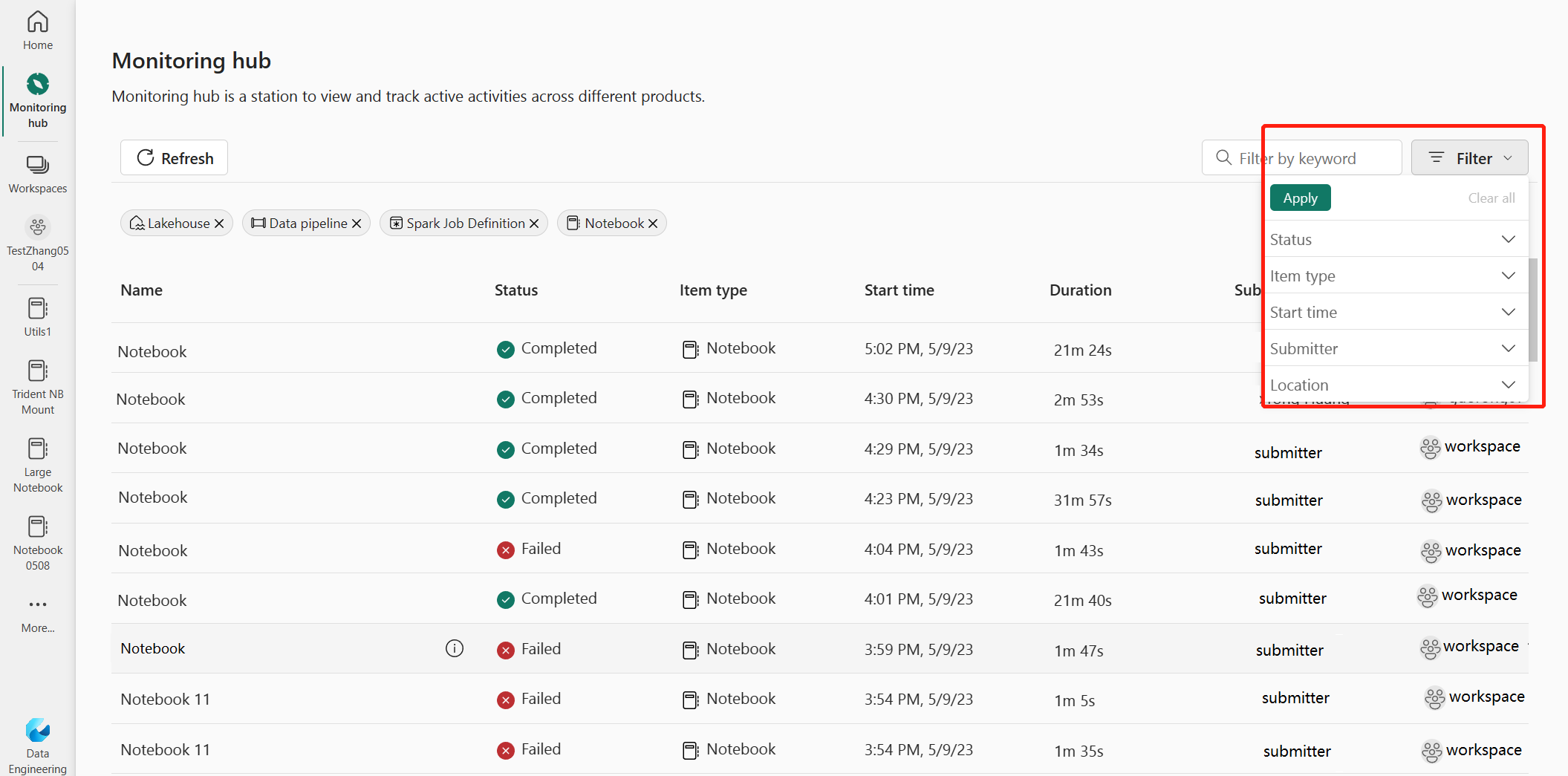

Filtrar aplicações Apache Spark

Pode filtrar as aplicações Apache Spark por Status , Tipo de Item , Hora de Início , Transmitente e Localização através do painel de filtro no canto superior direito.

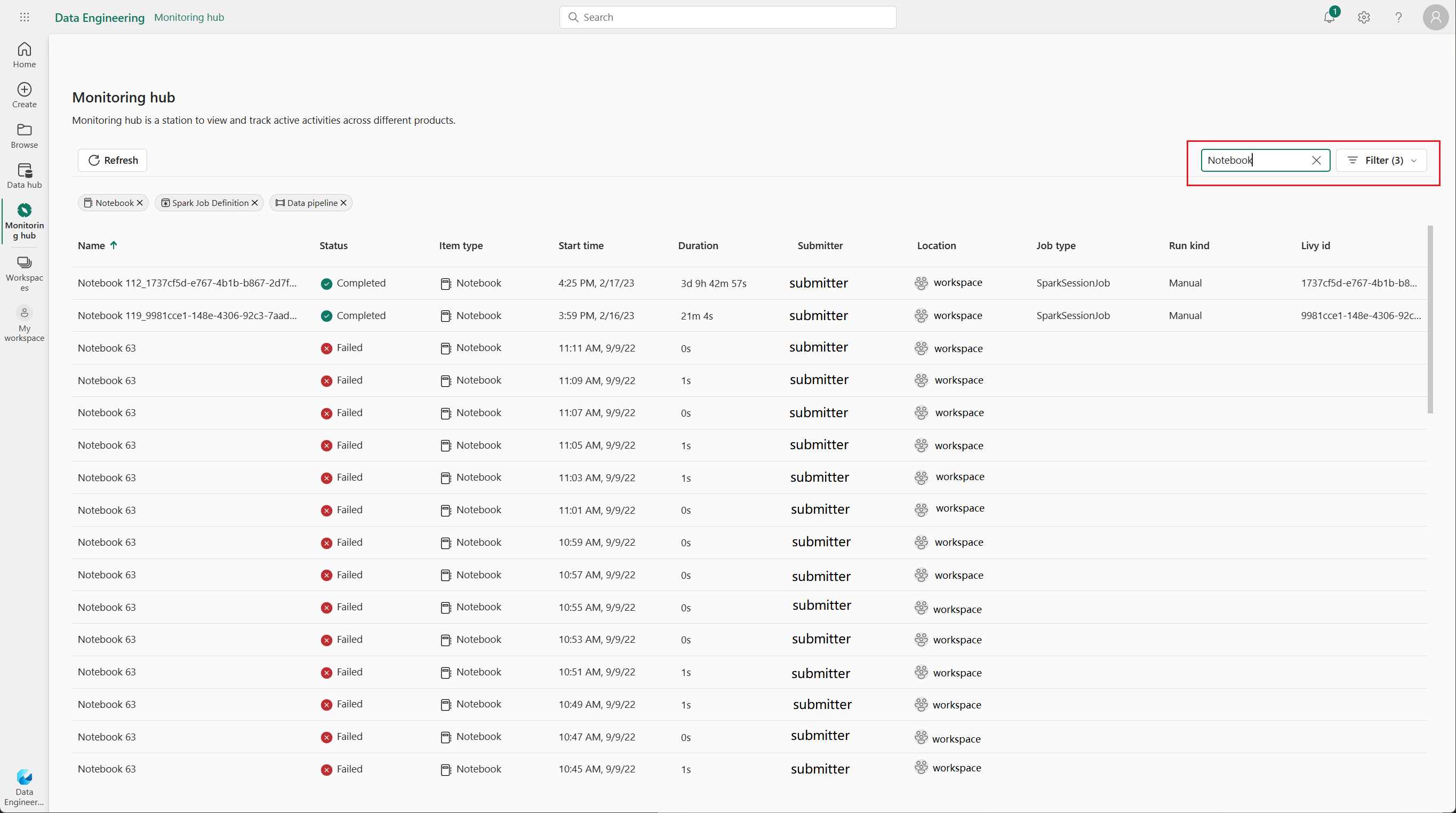

Pesquisar aplicativos Apache Spark

Para pesquisar aplicativos Apache Spark específicos, você pode inserir determinadas palavras-chave na caixa de pesquisa localizada no canto superior direito.

Opções de coluna Aplicações Apache Spark

Você pode alterar a ordem em que as listas são exibidas selecionando a lista que deseja exibir e arrastando as opções da lista.

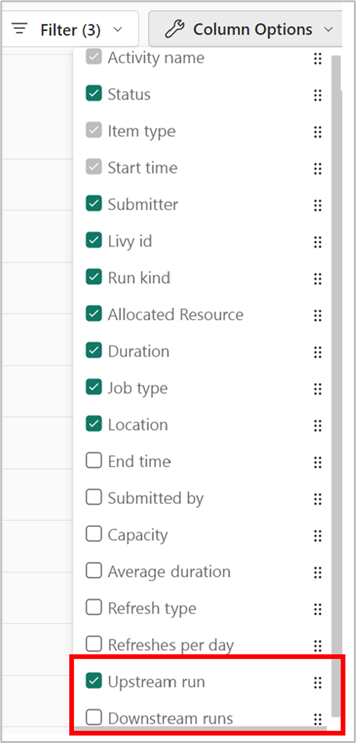

Habilitar a visualização upstream para Pipelines relacionados

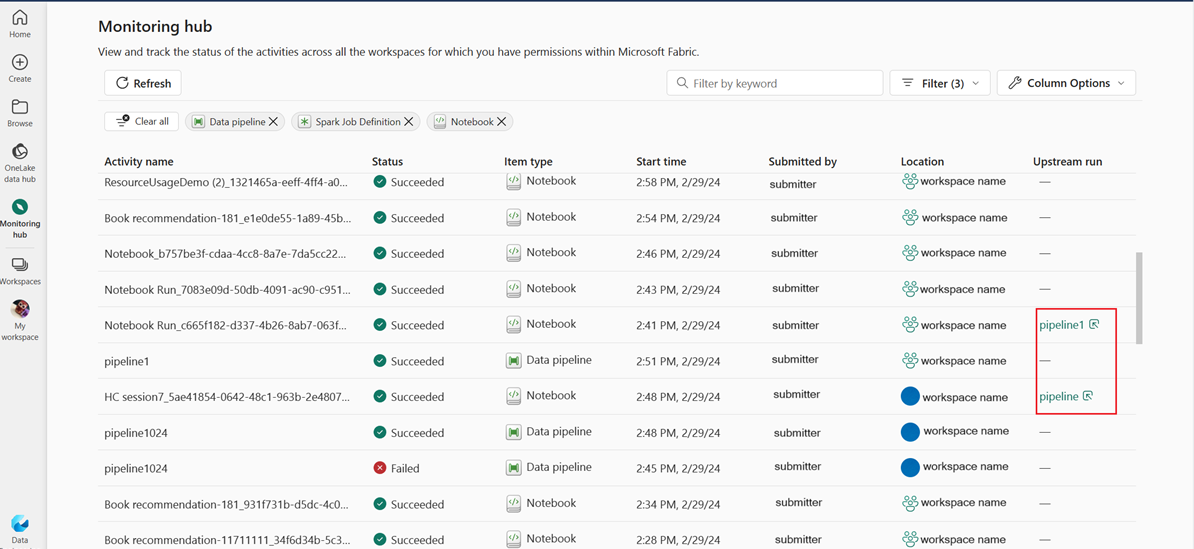

Se tiver agendado definições de tarefas de notebooks e Spark para execução em pipelines, poderá ver as atividades do Spark nesses notebooks e definições de tarefas do Spark no painel Monitor. Além disso, pode também ver o pipeline pai correspondente e todas as suas atividades no painel de Monitorização.

Selecione a opção Upstream run column.

Visualize a execução do pipeline pai relacionada na coluna de execução Upstream do

e clique na execução do pipeline para ver todas as suas atividades.

Gerenciar um aplicativo Apache Spark

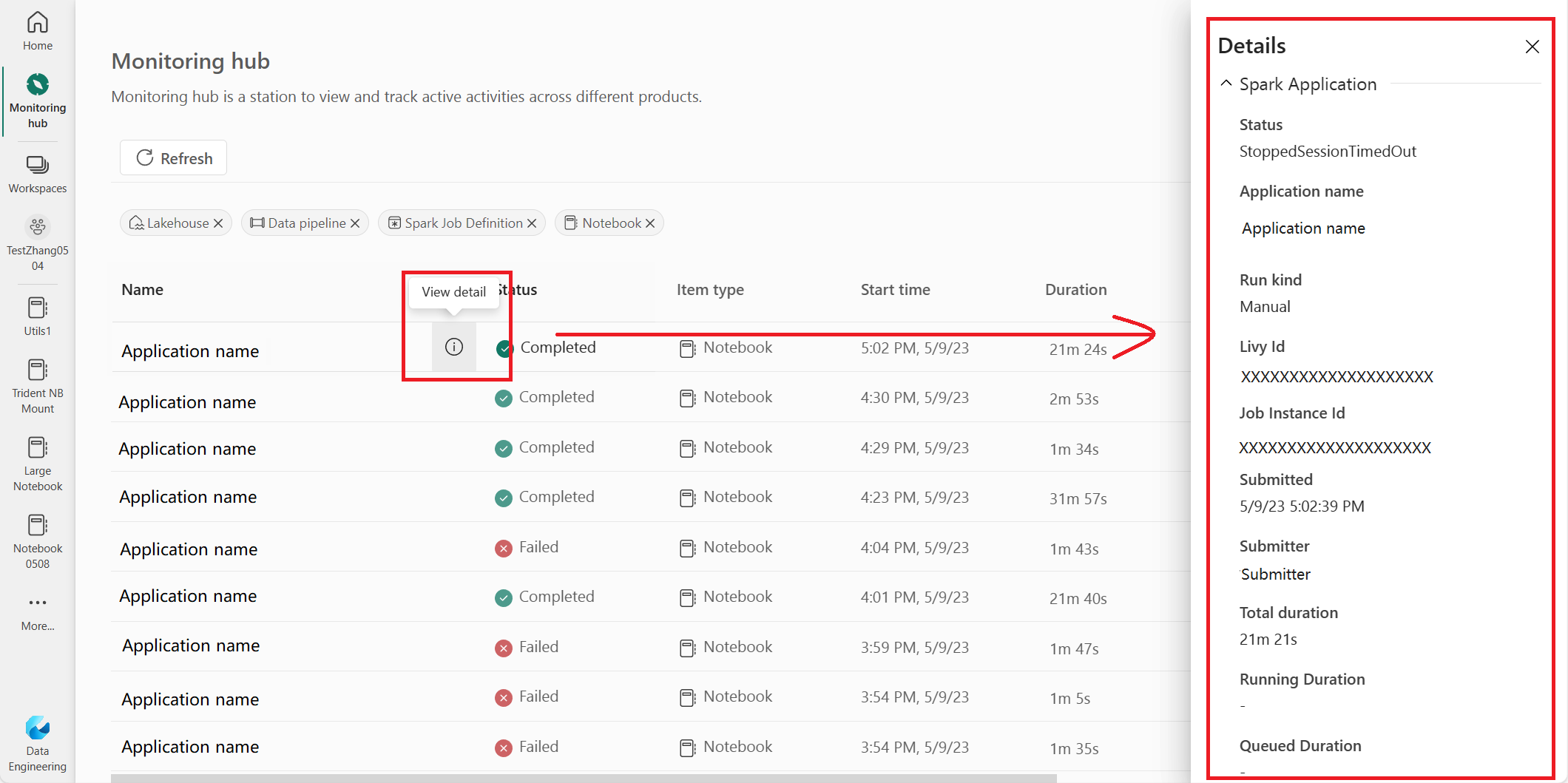

Quando você passa o mouse sobre uma linha de aplicativo Apache Spark, você pode ver várias ações de nível de linha que permitem gerenciar um aplicativo Apache Spark específico.

Veja o painel de detalhes do aplicativo Apache Spark

Você pode passar o mouse sobre uma linha de aplicação Apache Spark e clicar no ícone Exibir detalhes para abrir o painel de Detalhes e encontrar mais informações sobre uma aplicação Apache Spark.

Cancelar um aplicativo Apache Spark

Se precisar cancelar uma aplicação Apache Spark em andamento, passe o rato sobre a linha correspondente e clique no ícone Cancelar.

Navegue até a visualização de detalhes do aplicativo Apache Spark

Se você precisar de mais informações sobre estatísticas de execução do Apache Spark, acessar logs do Apache Spark ou verificar dados de entrada e saída, você pode clicar no nome de um aplicativo Apache Spark para navegar até a página de detalhes do aplicativo Apache Spark correspondente.