Filtrar e ingerir para o Azure Data Lake Storage Gen2 usando o Stream Analytics sem editor de código

Este artigo descreve como você pode usar o editor sem código para criar facilmente um trabalho do Stream Analytics. Ele lê continuamente de seus Hubs de Eventos, filtra os dados de entrada e grava os resultados continuamente no Azure Data Lake Storage Gen2.

Pré-requisitos

- Os recursos dos Hubs de Eventos do Azure devem estar acessíveis publicamente e não protegidos por um firewall ou protegidos em uma Rede Virtual do Azure

- Os dados em seus Hubs de Eventos devem ser serializados no formato JSON, CSV ou Avro.

Desenvolver um trabalho do Stream Analytics para filtrar e ingerir dados em tempo real

No portal do Azure, localize e selecione a instância dos Hubs de Eventos do Azure.

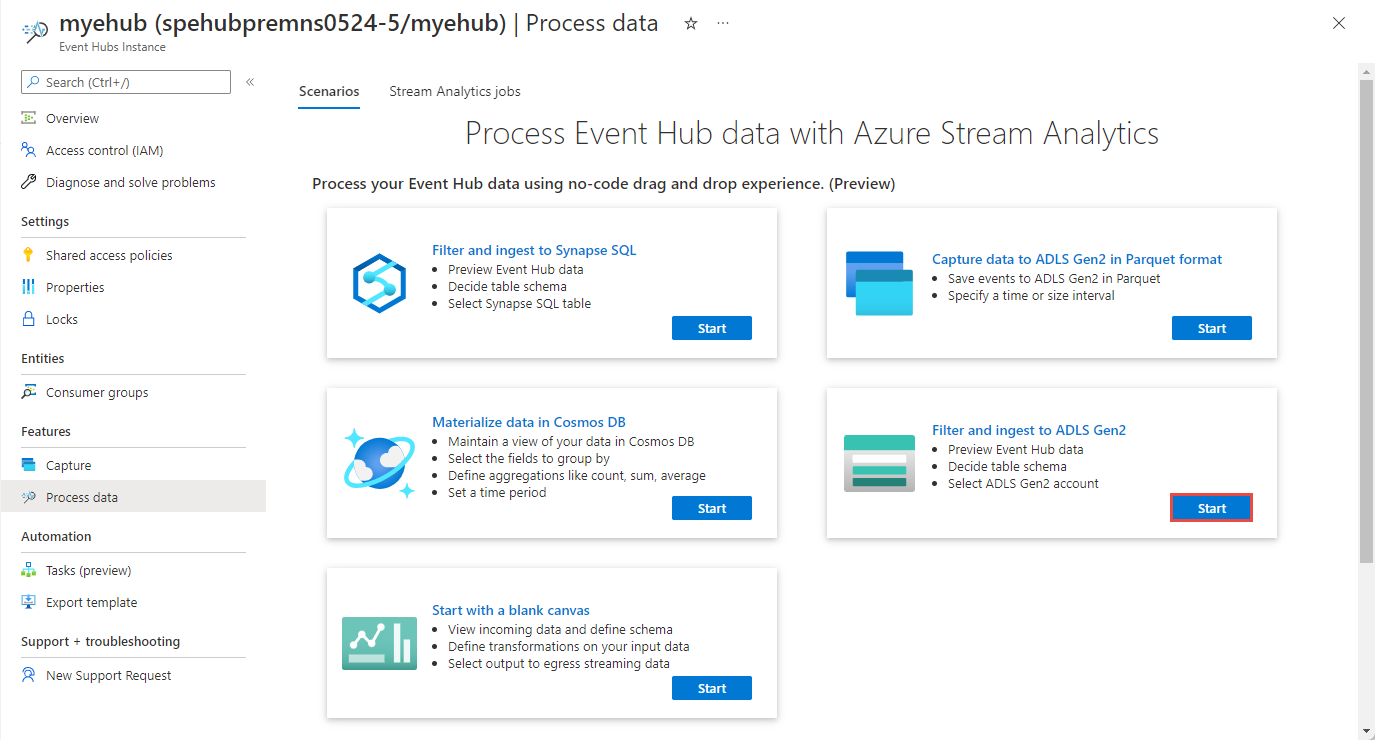

Selecione Recursos>processar dados e, em seguida, selecione Iniciar no filtro e ingerir no cartão ADLS Gen2.

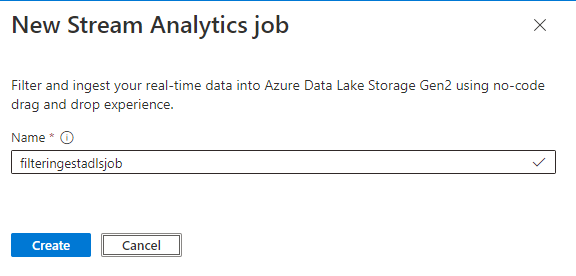

Insira um nome para o trabalho do Stream Analytics e selecione Criar.

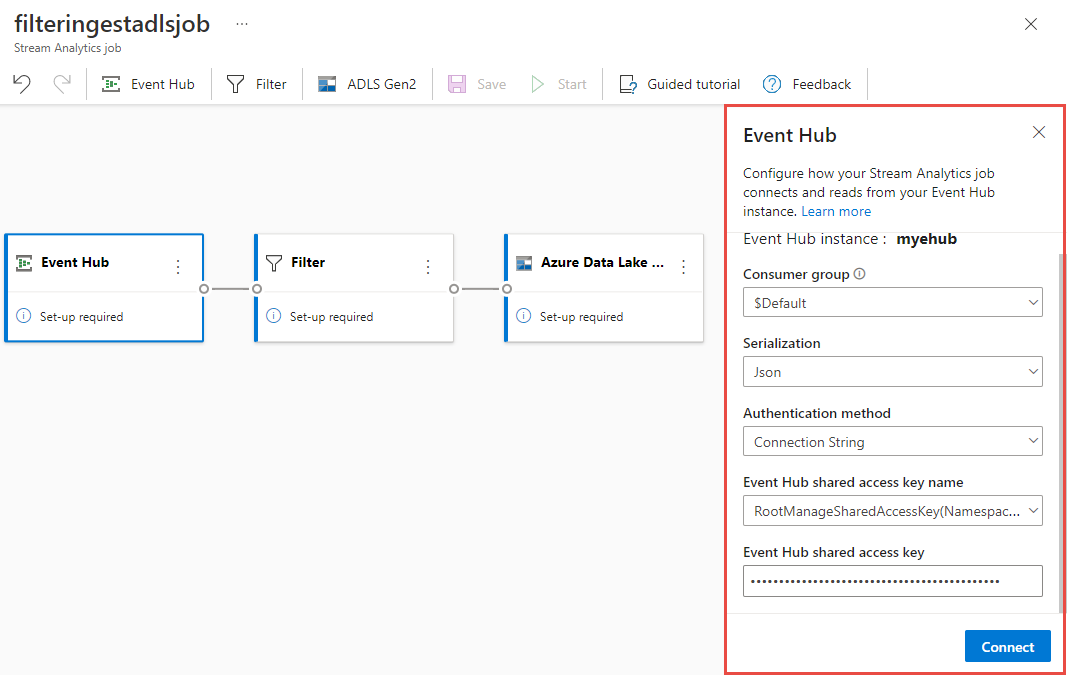

Especifique o tipo de serialização de seus dados na janela Hubs de Eventos e o método de Autenticação que o trabalho usará para se conectar aos Hubs de Eventos. Em seguida, selecione Conectar.

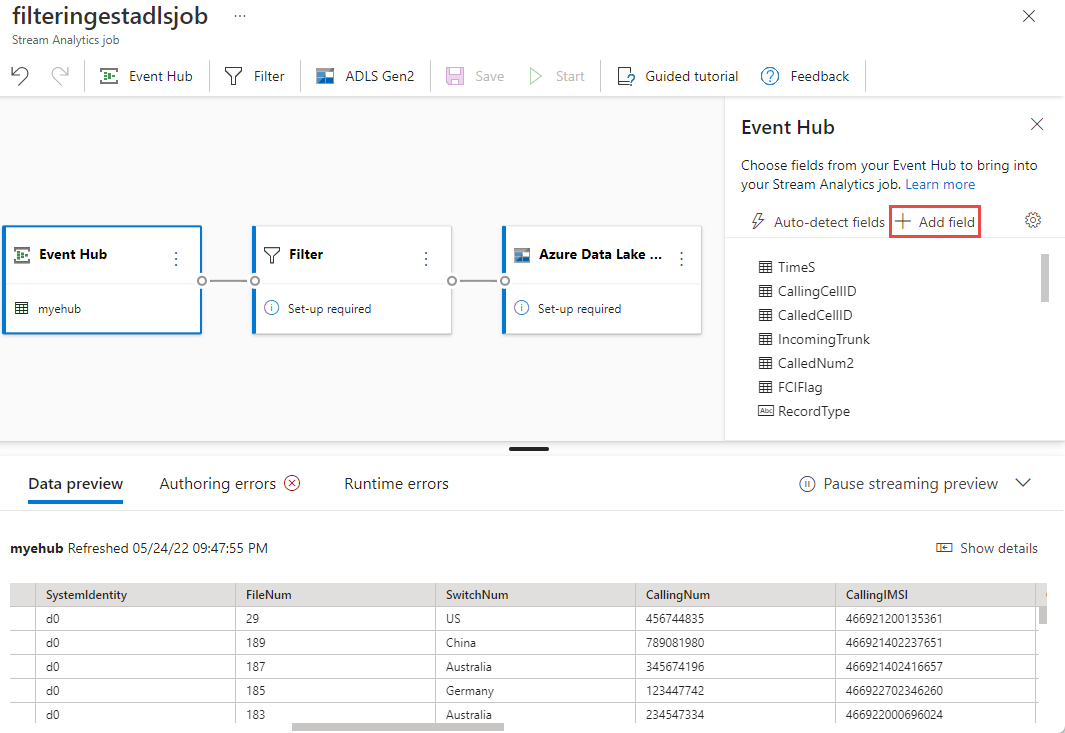

Se a conexão for estabelecida com êxito e você tiver fluxos de dados fluindo para a instância dos Hubs de Eventos, você verá imediatamente duas coisas:

- Campos que estão presentes nos dados de entrada. Você pode escolher Adicionar campo ou selecionar o símbolo de três pontos ao lado de cada campo para remover, renomear ou alterar seu tipo.

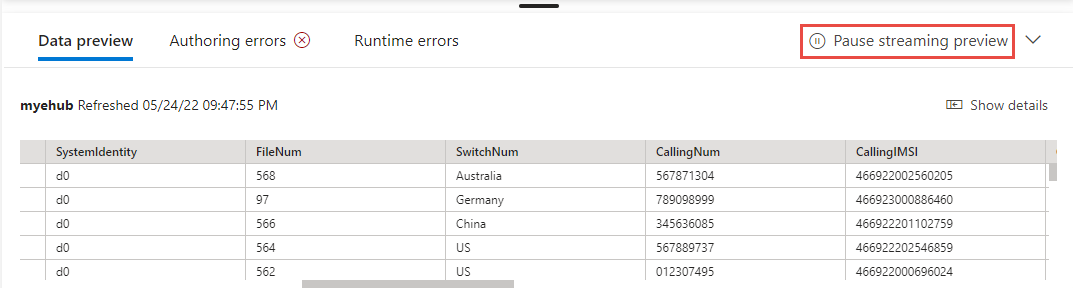

- Uma amostra dinâmica de dados de entrada na tabela de visualização de dados sob o modo de exibição de diagrama. Ele é atualizado automaticamente periodicamente. Você pode selecionar Pausar visualização de streaming para ver uma exibição estática de dados de entrada de exemplo.

- Campos que estão presentes nos dados de entrada. Você pode escolher Adicionar campo ou selecionar o símbolo de três pontos ao lado de cada campo para remover, renomear ou alterar seu tipo.

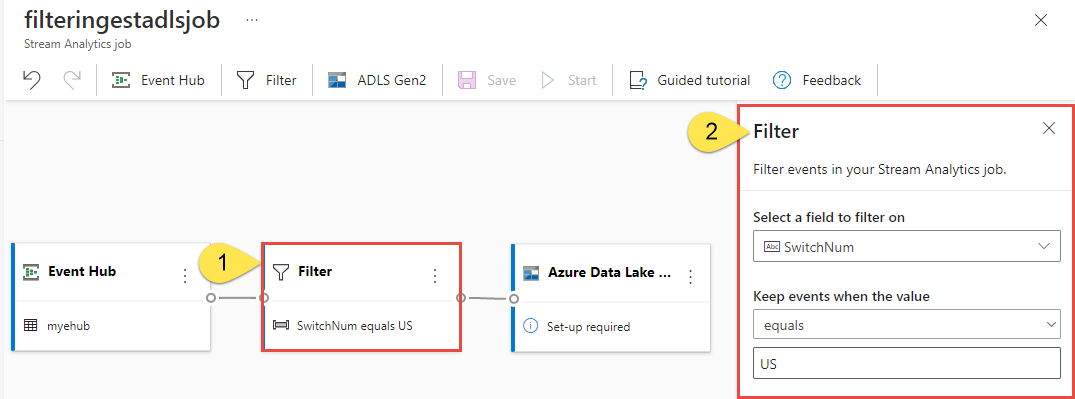

Selecione o bloco Filtro . Na área Filtro, selecione um campo para filtrar os dados recebidos com uma condição.

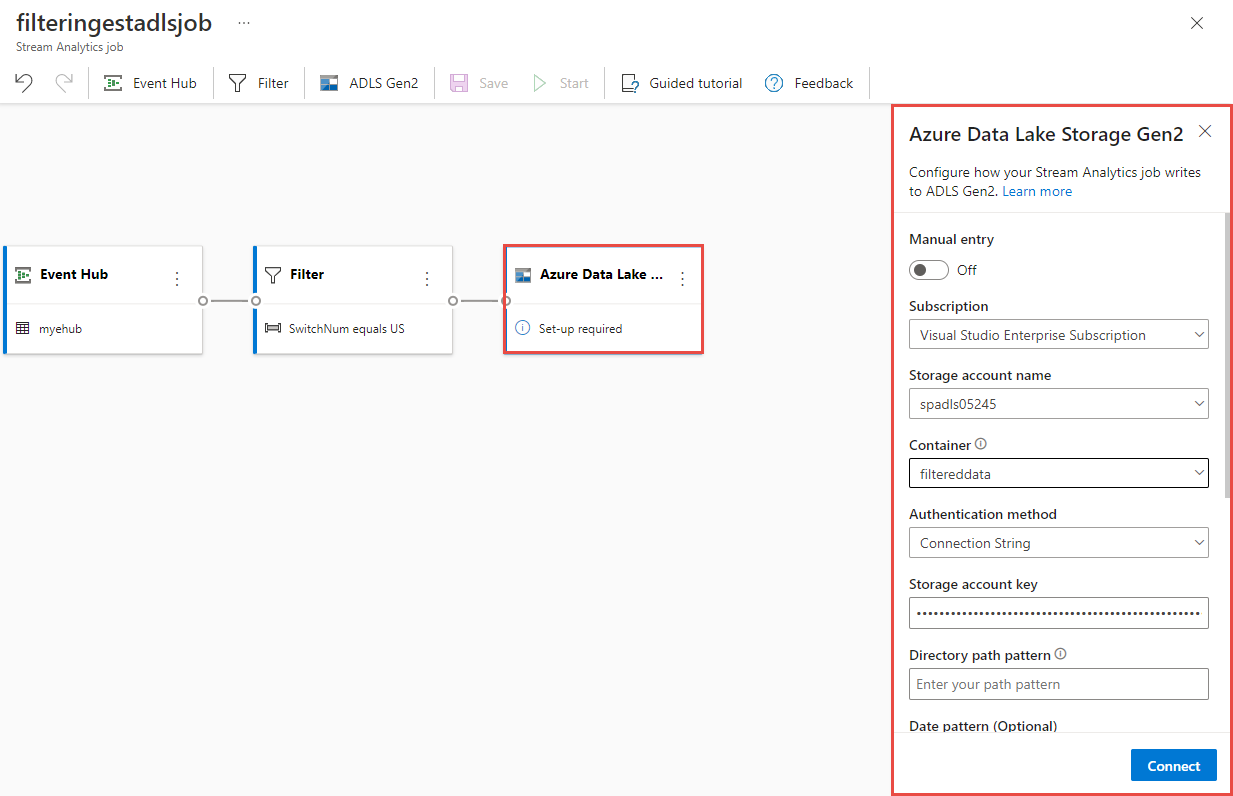

Selecione o bloco Azure Data Lake Storage Gen2 . Selecione a conta do Azure Data Lake Gen2 para enviar seus dados filtrados:

- Selecione a assinatura, o nome da conta de armazenamento e o contêiner no menu suspenso.

- Depois que a assinatura for selecionada, o método de autenticação e a chave da conta de armazenamento deverão ser preenchidos automaticamente. Selecione Ligar.

Para obter mais informações sobre os campos e ver exemplos de padrão de caminho, consulte Armazenamento de Blob e saída do Azure Data Lake Gen2 do Azure Stream Analytics.

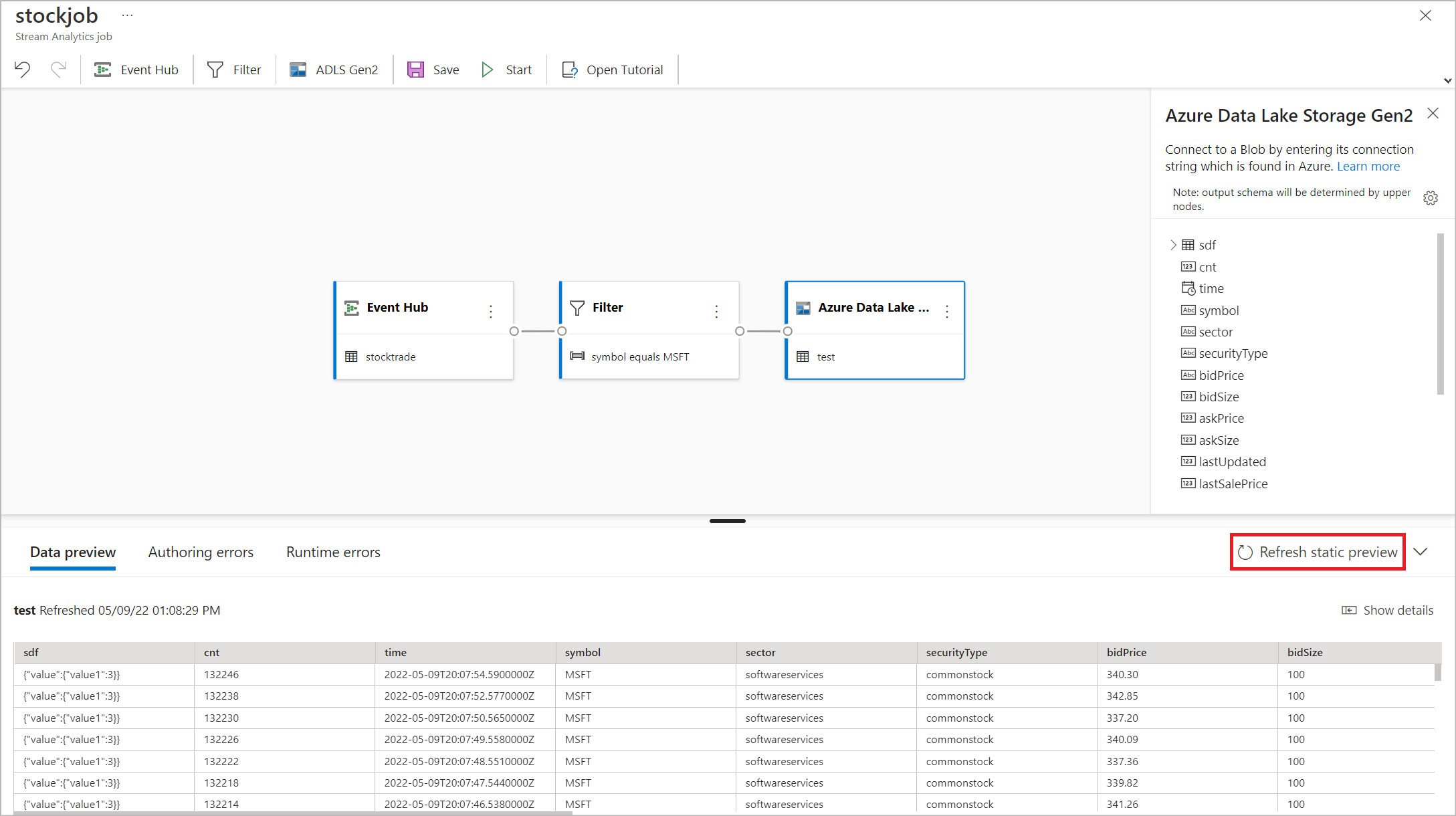

Opcionalmente, selecione Obter visualização estática/Atualizar visualização estática para ver a visualização de dados que será ingerida do Azure Data Lake Storage Gen2.

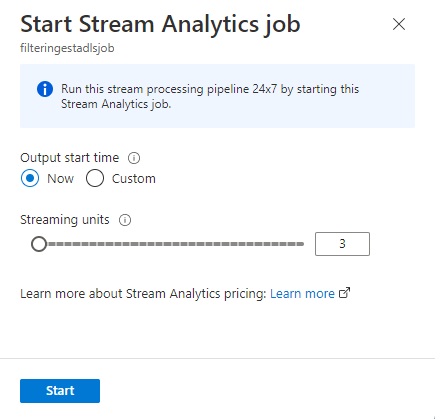

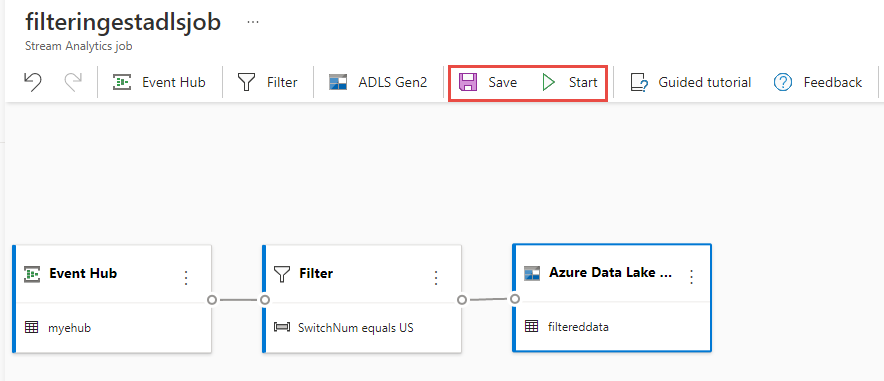

Selecione Salvar e, em seguida, selecione Iniciar o trabalho do Stream Analytics.

Para iniciar o trabalho, especifique o número de Unidades de Streaming (SUs) com as quais o trabalho é executado. SUs representa a quantidade de computação e memória alocada para o trabalho. Recomendamos que comece com três e depois ajuste conforme necessário.

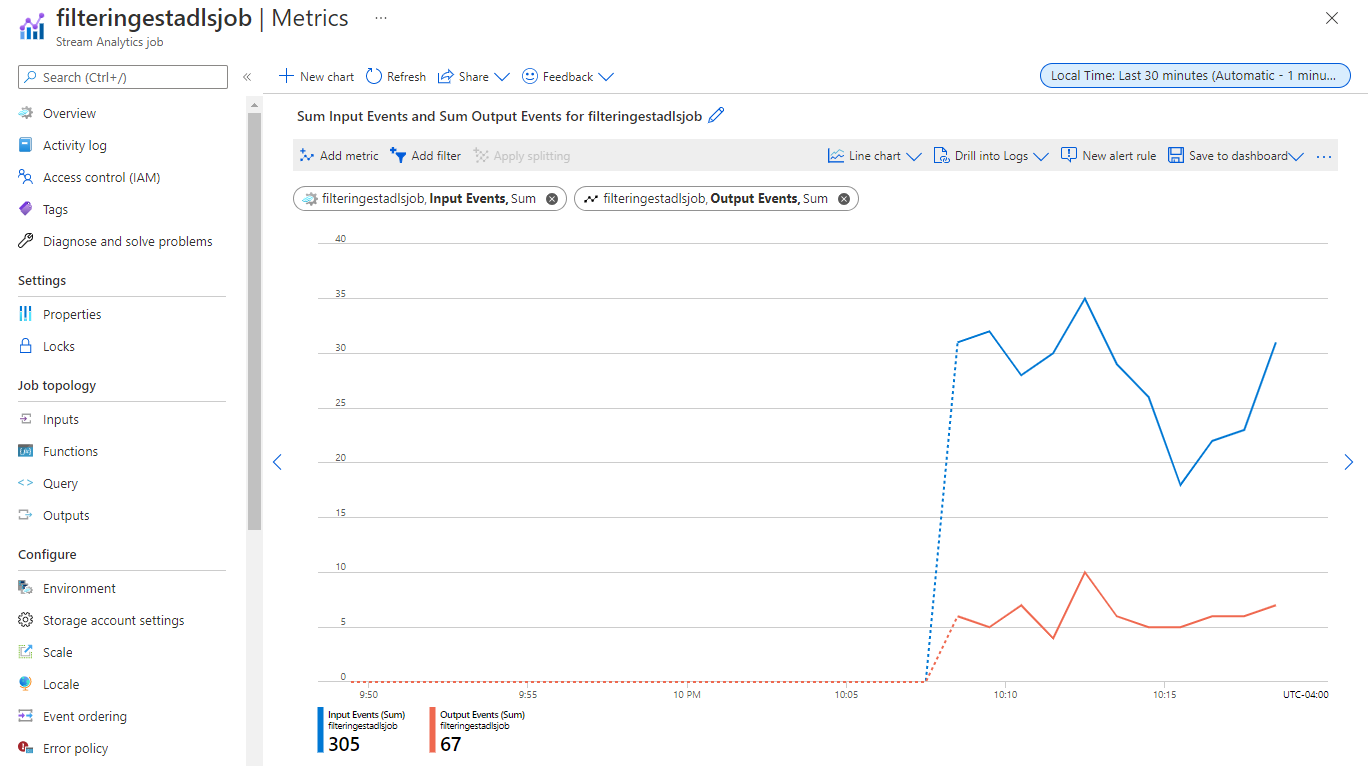

Depois de selecionar Iniciar, o trabalho começa a ser executado em dois minutos e as métricas serão abertas na seção da guia abaixo.

Você pode ver o trabalho na seção Processar dados na guia Trabalhos do Stream Analytics. Selecione Atualizar até ver o status do trabalho como Em execução. Selecione Abrir métricas para monitorá-lo ou parar e reiniciá-lo, conforme necessário.

Aqui está uma página de exemplo de métricas :

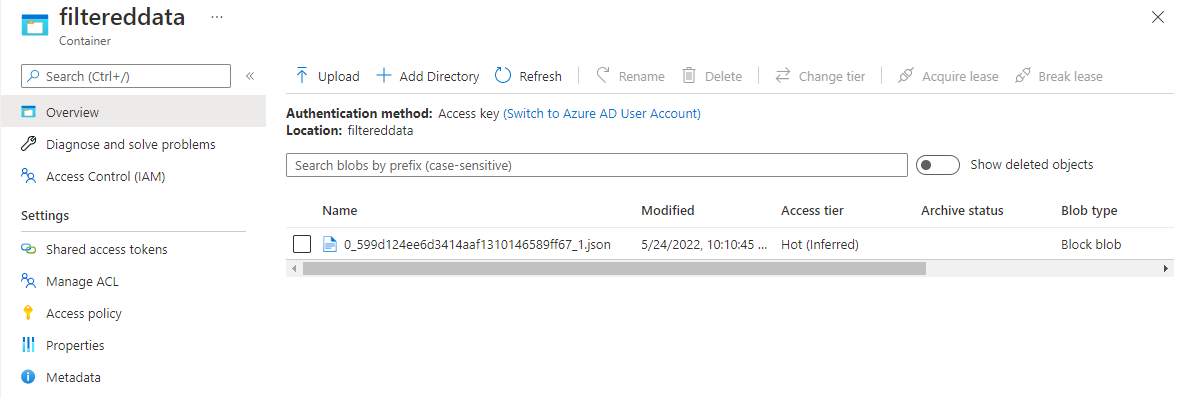

Verificar dados no Armazenamento Data Lake

Você deve ver os arquivos criados no contêiner especificado.

Transfira e abra o ficheiro para confirmar que vê apenas os dados filtrados. No exemplo a seguir, você verá dados com SwitchNum definido como US.

{"RecordType":"MO","SystemIdentity":"d0","FileNum":"548","SwitchNum":"US","CallingNum":"345697969","CallingIMSI":"466921402416657","CalledNum":"012332886","CalledIMSI":"466923101048691","DateS":"20220524","TimeType":0,"CallPeriod":0,"ServiceType":"S","Transfer":0,"OutgoingTrunk":"419","MSRN":"1416960750071","callrecTime":"2022-05-25T02:07:10Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:09.5140000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"552","SwitchNum":"US","CallingNum":"012351287","CallingIMSI":"262021390056324","CalledNum":"012301973","CalledIMSI":"466922202613463","DateS":"20220524","TimeType":3,"CallPeriod":0,"ServiceType":"V","Transfer":0,"OutgoingTrunk":"442","MSRN":"886932428242","callrecTime":"2022-05-25T02:07:13Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:12.7350000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null} {"RecordType":"MO","SystemIdentity":"d0","FileNum":"559","SwitchNum":"US","CallingNum":"456757102","CallingIMSI":"466920401237309","CalledNum":"345617823","CalledIMSI":"466923000886460","DateS":"20220524","TimeType":1,"CallPeriod":696,"ServiceType":"V","Transfer":1,"OutgoingTrunk":"419","MSRN":"886932429155","callrecTime":"2022-05-25T02:07:22Z","EventProcessedUtcTime":"2022-05-25T02:07:50.5478116Z","PartitionId":0,"EventEnqueuedUtcTime":"2022-05-25T02:07:21.9190000Z", "TimeS":null,"CallingCellID":null,"CalledCellID":null,"IncomingTrunk":null,"CalledNum2":null,"FCIFlag":null}

Considerações ao usar o recurso de replicação geográfica de Hubs de Eventos

Os Hubs de Eventos do Azure lançaram recentemente o recurso de Replicação Geográfica na visualização pública. Esse recurso é diferente do recurso de Recuperação de Desastres Geográficos dos Hubs de Eventos do Azure.

Quando o tipo de failover é Forçado e a consistência da replicação é assíncrona, o trabalho do Stream Analytics não garante exatamente uma saída para uma saída dos Hubs de Eventos do Azure.

O Azure Stream Analytics, como produtor com um hub de eventos uma saída, pode observar atraso de marca d'água no trabalho durante a duração do failover e durante a limitação pelos Hubs de Eventos caso o atraso de replicação entre primário e secundário atinja o atraso máximo configurado.

O Azure Stream Analytics, como consumidor com Hubs de Eventos como Entrada, pode observar atraso de marca d'água no trabalho durante a duração do failover e pode ignorar dados ou localizar dados duplicados após a conclusão do failover.

Devido a essas ressalvas, recomendamos que você reinicie o trabalho do Stream Analytics com a hora de início apropriada logo após a conclusão do failover dos Hubs de Eventos. Além disso, como o recurso de replicação geográfica dos Hubs de Eventos está em visualização pública, não recomendamos o uso desse padrão para trabalhos do Stream Analytics de produção neste momento. O comportamento atual do Stream Analytics melhorará antes que o recurso de replicação geográfica dos Hubs de Eventos esteja disponível em geral e possa ser usado em trabalhos de produção do Stream Analytics.

Próximos passos

Saiba mais sobre o Azure Stream Analytics e como monitorar o trabalho que você criou.