Dados, privacidade e segurança para utilização de modelos através do Catálogo de Modelos

Este artigo fornece detalhes sobre como os dados fornecidos por você são processados, usados e armazenados quando você implanta modelos do Catálogo de Modelos. Consulte também o Adendo de Proteção de Dados dos Produtos e Serviços da Microsoft, que rege o processamento de dados pelos serviços do Azure.

Quais dados são processados para modelos implantados no Azure Machine Learning?

Quando você implanta modelos no Aprendizado de Máquina do Azure, os seguintes tipos de dados são processados para fornecer o serviço:

Prompts e conteúdo gerado. Os prompts são enviados pelo usuário e o conteúdo (saída) é gerado pelo modelo por meio das operações suportadas pelo modelo. Os prompts podem incluir conteúdo que foi adicionado por meio de geração aumentada de recuperação (RAG), metaprompts ou outras funcionalidades incluídas em um aplicativo.

Dados carregados. Para modelos que dão suporte ao ajuste fino, os clientes podem carregar seus dados no Repositório de Dados do Azure Machine Learning para uso para ajuste fino.

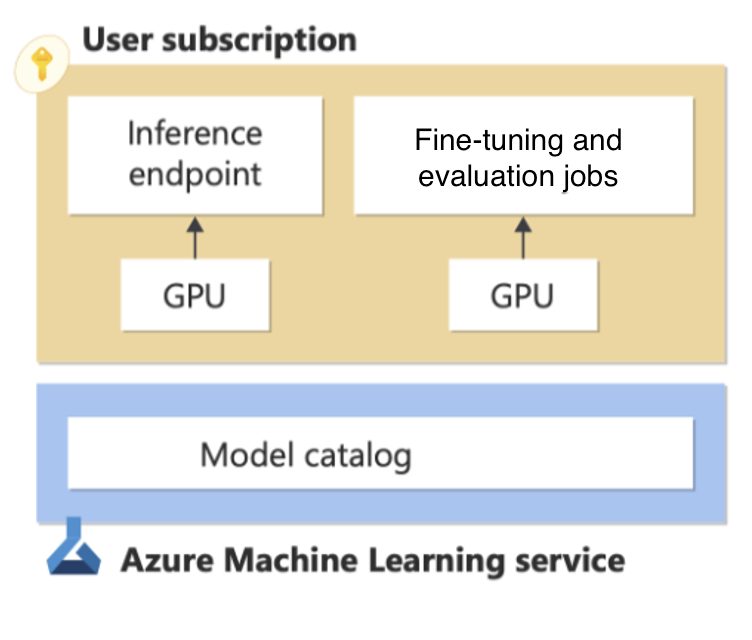

Gere saídas de inferência com computação gerenciada

A implantação de modelos para computação gerenciada implanta pesos de modelo em máquinas virtuais dedicadas e expõe uma API REST para inferência em tempo real. Saiba mais sobre como implantar modelos do Catálogo de modelos para computação gerenciada. Você gerencia a infraestrutura para esses cálculos gerenciados, e os compromissos de dados, privacidade e segurança do Azure se aplicam. Saiba mais sobre as ofertas de conformidade do Azure aplicáveis ao Azure Machine Learning.

Embora os contêineres para modelos "Selecionados pela IA do Azure" sejam verificados em busca de vulnerabilidades que possam exfiltrar dados, nem todos os modelos disponíveis no catálogo de modelos foram verificados. Para reduzir o risco de exfiltração de dados, você pode proteger sua implantação usando redes virtuais. Siga este link para saber mais. Você também pode usar a Política do Azure para regular os modelos que podem ser implantados por seus usuários.

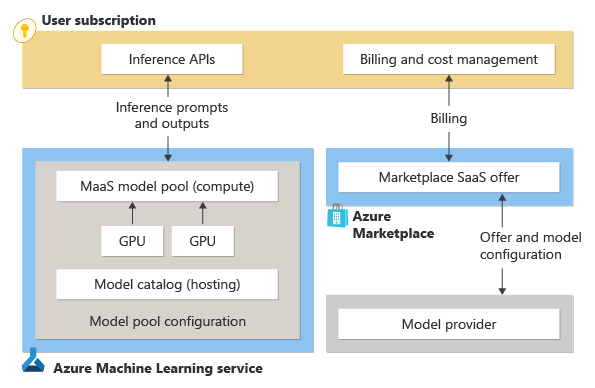

Gerar saídas de inferência com APIs sem servidor (Models-as-a-Service)

Quando você implanta um modelo do catálogo de modelos (base ou ajustado) como uma API sem servidor para inferência, uma API é provisionada dando acesso ao modelo hospedado e gerenciado pelo Serviço de Aprendizado de Máquina do Azure. Saiba mais sobre Models-as-a-Service. O modelo processa seus prompts de entrada e gera saídas com base na funcionalidade do modelo, conforme descrito nos detalhes do modelo fornecidos para o modelo. Embora o modelo seja fornecido pelo provedor do modelo e seu uso do modelo (e a responsabilidade do provedor do modelo pelo modelo e suas saídas) esteja sujeito aos termos de licença fornecidos com o modelo, a Microsoft fornece e gerencia a infraestrutura de hospedagem e o ponto de extremidade da API. Os modelos hospedados em Modelos como Serviço estão sujeitos aos compromissos de dados, privacidade e segurança do Azure. Saiba mais sobre as ofertas de conformidade do Azure aplicáveis ao Azure Machine Learning aqui.

Importante

Esta funcionalidade está atualmente em pré-visualização pública. Esta versão de pré-visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas.

Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

A Microsoft atua como o processador de dados para prompts e saídas enviadas e geradas por um modelo implantado para inferência de pagamento conforme o uso (MaaS). A Microsoft não compartilha esses prompts e saídas com o provedor de modelo, e a Microsoft não usa esses prompts e saídas para treinar ou melhorar os modelos da Microsoft, do provedor de modelo ou de terceiros. Os modelos são sem monitoração de estado e nenhum prompt ou saída é armazenado no modelo. Se a filtragem de conteúdo (visualização) estiver habilitada, os prompts e saídas serão rastreados para determinadas categorias de conteúdo prejudicial pelo serviço de Segurança de Conteúdo do Azure AI em tempo real; saiba mais sobre como o Azure AI Content Safety processa dados aqui. Os prompts e saídas são processados dentro da geografia especificada durante a implantação, mas podem ser processados entre regiões dentro da geografia para fins operacionais (incluindo gerenciamento de desempenho e capacidade).

Conforme explicado durante o processo de implementação de Modelos como Serviço, a Microsoft pode partilhar informações de contacto dos clientes e detalhes das transações (incluindo o volume de uso associado à oferta) com o editor do modelo para que ele possa entrar em contacto com os clientes sobre o modelo. Saiba mais sobre as informações disponíveis para editores de modelos, siga esta ligação.

Ajuste um modelo com APIs sem servidor (Models-as-a-Service)

Se um modelo disponível para implantação de API sem servidor oferecer suporte a ajuste fino, você poderá carregar dados em (ou designar dados já em) um Repositório de Dados do Azure Machine Learning para ajustar o modelo. Em seguida, você pode criar uma API sem servidor para o modelo ajustado. O modelo ajustado não pode ser baixado, mas o modelo ajustado:

Está disponível exclusivamente para seu uso;

Pode ser duplamente criptografado em repouso (por padrão com a criptografia AES-256 da Microsoft e, opcionalmente, com uma chave gerenciada pelo cliente).

Pode ser excluído por você a qualquer momento.

Os dados de treinamento carregados para ajuste fino não são usados para treinar, treinar novamente ou melhorar qualquer modelo da Microsoft ou de terceiros, exceto conforme indicado por você dentro do serviço.

Processamento de dados para modelos descarregados

Se você baixar um modelo do catálogo de modelos, escolherá onde implantá-lo e será responsável por como os dados serão processados quando você usar o modelo.