Gerenciando políticas de rede para controle de saída sem servidor

Importante

Esta funcionalidade está em Pré-visualização Pública.

Este documento explica como configurar e gerenciar políticas de rede para controlar conexões de rede de saída de suas cargas de trabalho sem servidor no Azure Databricks.

As permissões para gerenciar políticas de rede são restritas ao administrador da conta. Consulte Introdução à administração do Azure Databricks.

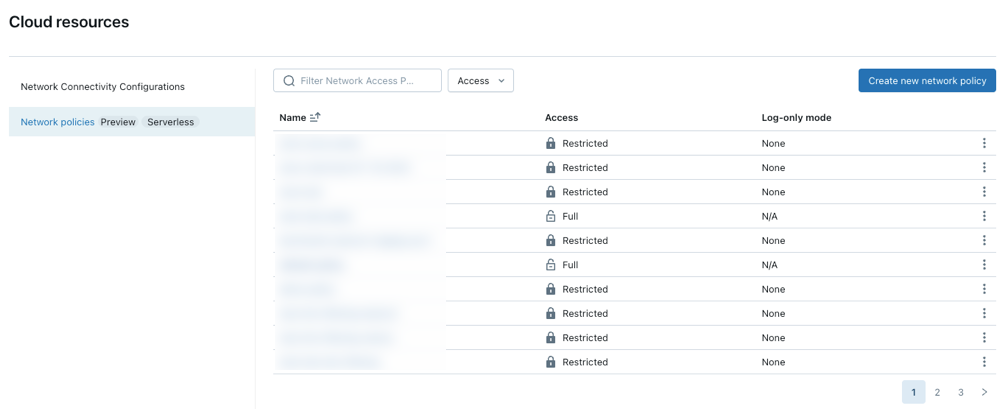

Aceder a políticas de rede

Para criar, visualizar e atualizar políticas de rede na sua conta:

- No console da conta, clique em Recursos de nuvem.

- Clique na guia Rede .

Criar uma nova política de rede

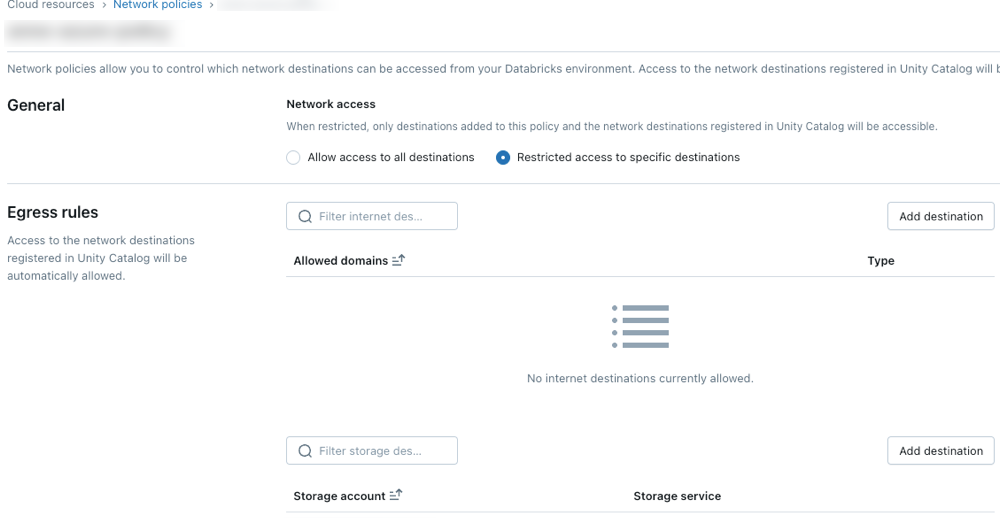

Clique Criar nova política de rede.

Escolha um modo de acesso à rede:

- Acesso total: Acesso irrestrito à Internet para saída. Se você escolher Acesso total, o acesso de saída à Internet permanecerá irrestrito.

- Acesso restrito: O acesso de saída é limitado a destinos especificados. Para obter mais informações, consulte Visão geral da diretiva de rede.

Configurar políticas de rede

As etapas a seguir descrevem as configurações opcionais para o modo de acesso restrito.

Regras de saída

Destinos configurados por meio de locais ou conexões do Catálogo Unity são automaticamente permitidos pela política.

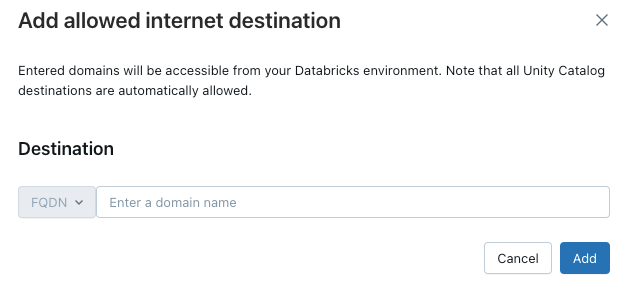

Para conceder acesso de computação sem servidor a domínios adicionais, clique em Adicionar destino acima da lista Domínios permitidos.

O filtro FQDN permite o acesso a todos os domínios que compartilham o mesmo endereço IP. O serviço de modelo provisionado em todos os pontos de extremidade impede o acesso à Internet quando o acesso à rede é definido como restrito. No entanto, o controle granular com filtragem FQDN não é suportado.

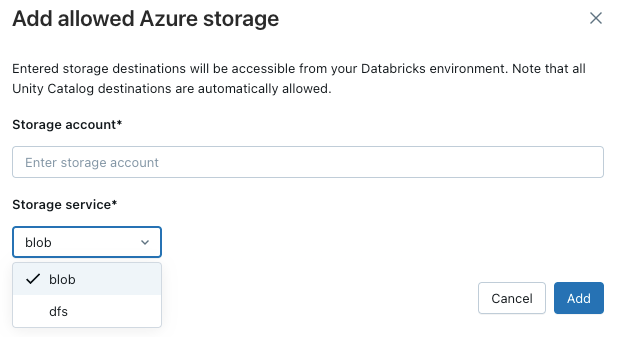

Para permitir que o seu espaço de trabalho aceda a contas de armazenamento adicionais do Azure, clique no botão Adicionar destino acima da lista Contas de armazenamento permitidas.

Nota

O número máximo de destinos suportados é 2000. Isso inclui todos os locais e conexões do Catálogo Unity acessíveis a partir do espaço de trabalho, bem como destinos explicitamente adicionados na política.

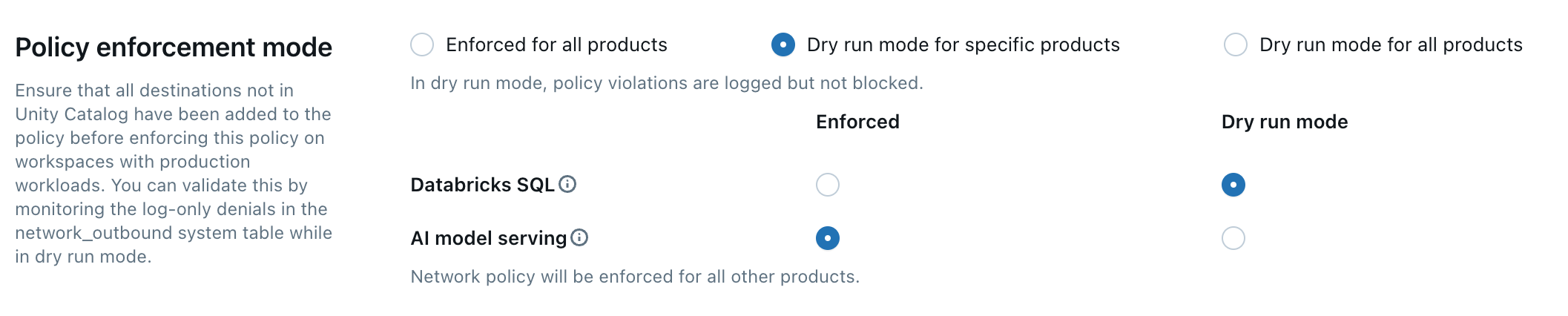

Aplicação de políticas

O modo de execução seca permite testar a configuração da política e monitorar as conexões de saída sem interromper o acesso aos recursos. Quando o modo de execução seca está ativado, as solicitações que violam a política são registradas, mas não bloqueadas. Você pode selecionar entre as seguintes opções:

Databricks SQL: Os armazéns SQL Databricks operam no modo de execução seca.

modelo de IA que serve: O modelo que serve pontos finais opera no modo de funcionamento seco.

Todos os produtos: Todos os serviços do Azure Databricks operam no modo de execução seca, substituindo todas as outras seleções.

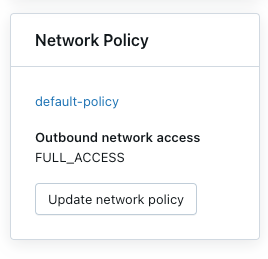

Atualizar a política padrão

Cada conta do Azure Databricks inclui uma política padrão . A política padrão está associada a todos os espaços de trabalho sem atribuição explícita de política de rede, incluindo os espaços de trabalho recém-criados. Você pode modificar essa política, mas ela não pode ser excluída. As políticas padrão só são aplicadas a espaços de trabalho com, pelo menos, a camada Premium.

Associar uma política de rede a espaços de trabalho

Se você tiver atualizado sua política padrão com configurações adicionais, elas serão aplicadas automaticamente a espaços de trabalho que não têm uma diretiva de rede existente. Seu espaço de trabalho precisará estar no nível Premium.

Para associar seu espaço de trabalho a uma política diferente, faça o seguinte:

- Selecione um espaço de trabalho.

- Em Diretiva de Rede, clique em Atualizar a diretiva de rede.

- Selecione a política de rede desejada na lista.

Aplicar alterações na política de rede

A maioria das atualizações de configuração de rede propaga-se automaticamente para a computação sem servidor em dez minutos. Isto inclui:

- Adicionar um novo local externo ou conexão do Catálogo Unity.

- Anexando seu espaço de trabalho a um metastore diferente.

- Alterar o armazenamento permitido ou os destinos da Internet.

Nota

Você deve reiniciar a computação se modificar a configuração de acesso à Internet ou modo de execução seca.

Reiniciar ou reimplantar cargas de trabalho sem servidor

Você só precisa atualizar ao mudar o modo de acesso à Internet ou ao atualizar o modo de execução a seco.

Para determinar o procedimento de reinicialização apropriado, consulte a seguinte lista por produto:

- Databricks ML Serving: Reimplantar o endpoint de servição de ML. Ver Criar terminais de serviço de modelos personalizados

- DLT: Pare e reinicie o pipeline DLT em execução. Consulte Realizar uma atualização num pipeline de DLT.

- Serverless SQL warehouse: Pare e reinicie o SQL warehouse. Consulte Gerir um armazém de dados SQL.

- Fluxos de trabalho: as alterações de política de rede são aplicadas automaticamente quando uma nova execução de trabalho é acionada ou uma execução de tarefa existente é reiniciada.

-

Cadernos:

- Se o seu bloco de notas não interagir com o Spark, pode terminar e anexar um novo cluster sem servidor para atualizar a configuração de rede aplicada ao seu bloco de notas.

- Se o seu bloco de notas interagir com o Spark, o recurso sem servidor é atualizado e deteta automaticamente a alteração. A comutação do modo de acesso e do modo de funcionamento a seco pode levar até 24 horas para ser aplicada, e outras alterações podem levar até 10 minutos para serem aplicadas.

Verificar a aplicação da política de rede

Você pode validar se sua diretiva de rede é aplicada corretamente tentando acessar recursos restritos de diferentes cargas de trabalho sem servidor. O processo de validação varia dependendo do produto sem servidor.

Validar com DLT

- Crie um bloco de anotações Python. Você pode usar o bloco de anotações de exemplo fornecido no tutorial DLT wikipedia python.

- Crie uma linha de dados de DLT.

- Clique em Pipelines, em Engenharia de Dados, na barra lateral do espaço de trabalho.

- Clique em Criar Pipeline.

- Configure o pipeline com as seguintes configurações:

- Modo de pipeline: sem servidor

- Código Fonte: Selecione o bloco de notas que criou.

- Opções de armazenamento: Unity Catalog. Selecione o catálogo e o esquema desejados.

- Clique em Criar.

- Executar o pipeline DLT.

- Na página do pipeline, clique em Iniciar.

- Aguarde a conclusão do pipeline.

- Verificar os resultados

- Destino confiável: o pipeline deve ser executado com sucesso e gravar dados no destino.

- Destino não confiável: o pipeline deve falhar com erros indicando que o acesso à rede está bloqueado.

Validar com Databricks SQL

- Crie um SQL Warehouse. Para obter instruções, consulte Criar um armazém SQL.

- Execute uma consulta de teste no editor SQL que tenta acessar um recurso controlado pela sua diretiva de rede.

- Verifique os resultados:

- Destino confiável: a consulta deve ser bem-sucedida.

- Destino não confiável: a consulta deve falhar com um erro de acesso à rede.

Valide com a disponibilização do modelo

Criar um modelo de teste

- Em um bloco de anotações Python, crie um modelo que tente acessar um recurso público da Internet, como baixar um arquivo ou fazer uma solicitação de API.

- Execute este bloco de anotações para gerar um modelo no espaço de trabalho de teste. Por exemplo:

import mlflow import mlflow.pyfunc import mlflow.sklearn import requests class DummyModel(mlflow.pyfunc.PythonModel): def load_context(self, context): pass def predict(self, _, model_input): first_row = model_input.iloc[0] try: response = requests.get(first_row['host']) except requests.exceptions.RequestException as e: # Return the error details as text return f"Error: An error occurred - {e}" return [response.status_code] with mlflow.start_run(run_name='internet-access-model'): wrappedModel = DummyModel() mlflow.pyfunc.log_model(artifact_path="internet_access_ml_model", python_model=wrappedModel, registered_model_name="internet-http-access")Criar um endpoint de serviço

- Na navegação do espaço de trabalho, selecione Aprendizado de Máquina.

- Clique na aba Servir.

- Clique em Criar EndPoint de Serviço.

- Configure o ponto de extremidade com as seguintes configurações:

- Nome do Ponto de Serviço: forneça um nome descritivo.

- Detalhes da entidade: Selecione modelo do registo de modelos.

- Modelo: escolha o modelo que você criou na etapa anterior.

- Clique em Confirmar.

- Aguarde até que o endpoint de serviço atinja o estado Pronto.

Solicite o ponto de extremidade.

- Utilize a opção Query Endpoint na página de endpoint de serviço para enviar uma solicitação de teste.

{"dataframe_records": [{"host": "https://www.google.com"}]}Verifique o resultado:

- Acesso à Internet habilitado: a consulta deve ser bem-sucedida.

- Acesso restrito à Internet: A consulta deve falhar com um erro de acesso à rede.

Atualizar uma política de rede

Você pode atualizar uma diretiva de rede a qualquer momento após sua criação. Para atualizar uma política de rede:

- Na página de detalhes da política de rede no console de contas, modifique a política:

- Altere o modo de acesso à rede.

- Habilite ou desabilite o modo de execução seca para serviços específicos.

- Adicione ou remova FQDN ou destinos de armazenamento.

- Clique Atualizar.

- Consulte . Aplique alterações de diretiva de rede para verificar se as atualizações são aplicadas a cargas de trabalho existentes.

Verifique os registros de negação

Os logs de negação são armazenados na tabela system.access.outbound_network no Unity Catalog. Esses logs rastreiam quando as solicitações de rede de saída são negadas. Para aceder aos registos de negação, assegure-se de que o esquema de acesso está ativado no metastore do Unity Catalog. Consulte Habilitar esquemas de tabela do sistema.

Use uma consulta SQL como a abaixo para exibir eventos de negação. Se os logs de execução seca estiverem habilitados, a consulta retornará os logs de negação e os logs de execução seca, que você pode distinguir usando a coluna access_type. Os logs de negação têm um valor DROP, enquanto os logs de dry-run mostram DRY_RUN_DENIAL.

O exemplo a seguir recupera logs das últimas 2 horas:

select * from system.access.outbound_network

where event_time >= current_timestamp() - interval 2 hour

sort by event_time desc

As recusas não são registradas na tabela do sistema de saída de rede ao se conectar a modelos de IA generativa externos usando o Mosaic AI Gateway. Veja a introdução ao Mosaic AI Gateway .

Nota

Pode haver alguma latência entre o momento do acesso e quando os logs de negação aparecem.

Limitações

- Configuration: Esta funcionalidade só é configurável através do console da conta. O suporte à API ainda não está disponível.

-

Tamanho do upload de artefato: Ao usar o sistema de arquivos Databricks interno do MLflow com o formato

dbfs:/databricks/mlflow-tracking/<experiment_id>/<run_id>/artifacts/<artifactPath>, os carregamentos de artefatos são limitados a 5 GB para APIslog_artifact,log_artifactselog_model. - Conexões de catálogo Unity suportadas: Os seguintes tipos de conexão são suportados: MySQL, PostgreSQL, Snowflake, Redshift, Azure Synapse, SQL Server, Salesforce, BigQuery, Netsuite, Workday RaaS, Hive MetaStore e Salesforce Data Cloud.

- Serviço de Modelos: O controlo de saída não se aplica ao criar imagens para o serviço de modelos.

- Acesso ao armazenamento Azure: Apenas o driver do Azure Blob Filesystem para o Azure Data Lake Storage é suportado. O acesso usando o driver de Armazenamento de Blob do Azure ou o driver WASB não é suportado.