Classificação com AutoML

Use o AutoML para encontrar automaticamente o melhor algoritmo de classificação e a configuração de hiperparâmetros para prever o rótulo ou a categoria de uma determinada entrada.

Configurar a experiência de classificação com a interface do usuário

Você pode configurar um problema de classificação usando a interface do usuário AutoML com as seguintes etapas:

Na barra lateral, selecione Experimentos.

No cartão Classificação, selecione Iniciar treinamento.

A página Configurar experimento AutoML é exibida. Nesta página, você configura o processo AutoML, especificando o conjunto de dados, o tipo de problema, a coluna de destino ou rótulo a ser prevista, a métrica a ser usada para avaliar e pontuar as execuções do experimento e as condições de parada.

No campo Computação, selecione um cluster executando o Databricks Runtime ML.

Em Conjunto de dados, selecione Procurar.

Navegue até a tabela que deseja usar e clique em Selecionar. O esquema da tabela é exibido.

- No Databricks Runtime 10.3 ML e superior, você pode especificar quais colunas o AutoML deve usar para treinamento. Não é possível remover a coluna selecionada como o destino de previsão ou a coluna de tempo para dividir os dados.

- No Databricks Runtime 10.4 LTS ML e superior, você pode especificar como os valores nulos são imputados selecionando a partir da lista suspensa Imputar com . Por padrão, o AutoML seleciona um método de imputação com base no tipo de coluna e no conteúdo.

Nota

Se você especificar um método de imputação não padrão, o AutoML não executará a deteção de tipo semântico.

Clique no campo Destino de previsão. Uma lista suspensa é exibida listando as colunas mostradas no esquema. Selecione a coluna que deseja que o modelo preveja.

O campo Nome do experimento mostra o nome padrão. Para alterá-lo, digite o novo nome no campo.

Também pode:

- Especifique opções de configuração adicionais.

- Use tabelas de recursos existentes no Feature Store para aumentar o conjunto de dados de entrada original.

Configurações avançadas

Abra a seção Configuração Avançada (opcional) para acessar esses parâmetros.

- A métrica de avaliação é a principal métrica usada para pontuar as corridas.

- No Databricks Runtime 10.4 LTS ML e superior, você pode excluir estruturas de treinamento da consideração. Por padrão, o AutoML treina modelos usando estruturas listadas em algoritmos AutoML.

- Você pode editar as condições de parada. As condições de parada padrão são:

- Para experiências de previsão, pare após 120 minutos.

- No Databricks Runtime 10.4 LTS ML e inferior, para experimentos de classificação e regressão, pare após 60 minutos ou depois de completar 200 ensaios, o que acontecer primeiro. Para o Databricks Runtime 11.0 ML e superior, o número de ensaios não é usado como uma condição de parada.

- No Databricks Runtime 10.4 LTS ML e superior, para experimentos de classificação e regressão, o AutoML incorpora a parada antecipada; ele interrompe o treinamento e o ajuste de modelos se a métrica de validação não estiver mais melhorando.

- No Databricks Runtime 10.4 LTS ML e superior, você pode selecionar um

time columnpara dividir os dados para treinamento, validação e teste em ordem cronológica (aplica-se apenas à classificação e regressão). - O Databricks recomenda não preencher o campo Diretório de dados. Isso aciona o comportamento padrão de armazenar com segurança o conjunto de dados como um artefato MLflow. Um caminho DBFS pode ser especificado, mas, nesse caso, o conjunto de dados não herda as permissões de acesso do experimento AutoML.

Execute o experimento e monitore os resultados

Para iniciar o experimento AutoML, clique em Iniciar AutoML. O experimento começa a ser executado e a página de treinamento AutoML é exibida. Para atualizar a tabela de execuções, clique em  .

.

Ver o progresso da experiência

Nesta página, pode:

- Pare a experiência a qualquer momento.

- Abra o bloco de anotações de exploração de dados.

- O monitor é executado.

- Navegue até a página de execução para qualquer execução.

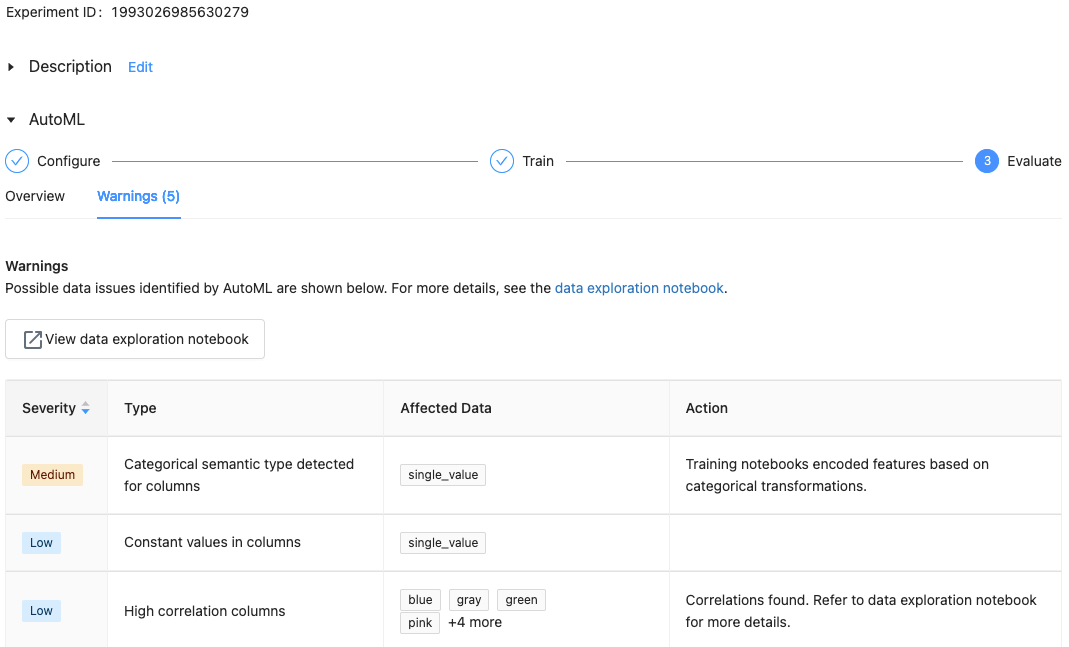

Com o Databricks Runtime 10.1 ML e superior, o AutoML exibe avisos para possíveis problemas com o conjunto de dados, como tipos de coluna sem suporte ou colunas de alta cardinalidade.

Nota

O Databricks faz o seu melhor para indicar possíveis erros ou problemas. No entanto, isso pode não ser abrangente e pode não capturar os problemas ou erros que você pode estar procurando.

Para ver quaisquer avisos para o conjunto de dados, clique na guia Avisos na página de treinamento ou na página do experimento após a conclusão do experimento.

Ver resultados

Quando o experimento for concluído, você poderá:

- Registre e implante um dos modelos com MLflow.

- Selecione Ver bloco de notas para o melhor modelo para rever e editar o bloco de notas que criou o melhor modelo.

- Selecione Exibir bloco de anotações de exploração de dados para abrir o bloco de anotações de exploração de dados.

- Pesquise, filtre e classifique as execuções na tabela de execuções.

- Veja os detalhes de qualquer corrida:

- O bloco de anotações gerado contendo o código-fonte para uma execução de avaliação pode ser encontrado clicando na execução MLflow. O bloco de anotações é salvo na seção Artefatos da página de execução. Você pode baixar este bloco de anotações e importá-lo para o espaço de trabalho, se o download de artefatos estiver habilitado pelos administradores do espaço de trabalho.

- Para visualizar os resultados da execução, clique na coluna Modelos ou na coluna Hora de início. A página de execução é exibida, mostrando informações sobre a execução da avaliação (como parâmetros, métricas e tags) e artefatos criados pela execução, incluindo o modelo. Esta página também inclui trechos de código que você pode usar para fazer previsões com o modelo.

Para voltar a este experimento AutoML mais tarde, encontre-o na tabela na página Experimentos. Os resultados de cada experimento AutoML, incluindo os blocos de anotações de exploração de dados e treinamento, são armazenados em uma databricks_automl pasta na pasta inicial do usuário que executou o experimento.

Registrar e implantar um modelo

Você pode registrar e implantar seu modelo com a interface do usuário do AutoML:

- Selecione o link na coluna Modelos para o modelo a ser registrado. Quando uma execução é concluída, a linha superior é o melhor modelo (com base na métrica primária).

- Selecione

para registrar o modelo no Registro modelo.

para registrar o modelo no Registro modelo. - Selecione

Modelos na barra lateral para navegar até o Registro de modelo.

Modelos na barra lateral para navegar até o Registro de modelo. - Selecione o nome do seu modelo na tabela de modelos.

- Na página do modelo registrado, você pode servir o modelo com o Model Serving.

Nenhum módulo chamado 'pandas.core.indexes.numeric

Ao servir um modelo construído usando AutoML com Model Serving, você pode obter o erro: No module named 'pandas.core.indexes.numeric.

Isso ocorre devido a uma versão incompatível pandas entre o AutoML e o modelo que serve o ambiente de ponto final. Você pode resolver esse erro executando o script add-pandas-dependency.py. O script edita o requirements.txt e conda.yaml para o modelo registrado para incluir a versão de dependência apropriada pandas : pandas==1.5.3

- Modifique o script para incluir o

run_idda execução do MLflow onde o modelo foi registrado. - Registro novo do modelo no registro do modelo MLflow.

- Tente servir a nova versão do modelo MLflow.