Explore os dados de origem de um pipeline de dados

Uma primeira etapa comum na criação de um pipeline de dados é entender os dados de origem para o pipeline. Nesta etapa, você executará os comandos Databricks Utilities e PySpark em um bloco de anotações para examinar os dados e artefatos de origem.

Para saber mais sobre a análise exploratória de dados, consulte Análise exploratória de dados no Azure Databricks: ferramentas e técnicas.

Vídeo: Introdução aos notebooks Databricks

Para uma introdução aos notebooks Databricks, assista a este vídeo:

Criar um bloco de anotações de exploração de dados

Na barra lateral, clique em

Novo e selecione Bloco de Anotações no menu. O bloco de notas abre com um nome predefinido que pode substituir.

Novo e selecione Bloco de Anotações no menu. O bloco de notas abre com um nome predefinido que pode substituir.Introduza um nome para o bloco de notas, por exemplo,

Explore songs data. Por predefinição:- Python é a linguagem selecionada.

- O bloco de anotações é anexado ao último cluster usado. Nesse caso, o cluster criado na Etapa 1: criar um cluster.

Para exibir o conteúdo do diretório que contém o conjunto de dados, digite o seguinte na primeira célula do bloco de anotações, clique em

e selecione Executar célula.

e selecione Executar célula.%fs ls "/databricks-datasets/songs"path nome size Tempo de modificação dbfs:/databricks-datasets/músicas/README.md README.md 1719 1454620183000 dbfs:/databricks-datasets/músicas/data-001/ dados-001/ 0 1672791237846 dbfs:/databricks-datasets/músicas/data-002/ dados-002/ 0 1672791237846

Explorar os dados

O arquivo LEIA-ME tem informações sobre o conjunto de dados, incluindo uma descrição do esquema de dados. As informações do esquema são usadas na próxima etapa ao ingerir os dados. Para visualizar o conteúdo do LEIA-ME, clique

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte na nova célula, clique em

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte na nova célula, clique em e selecione Executar célula.

e selecione Executar célula.%fs head --maxBytes=10000 "/databricks-datasets/songs/README.md"Sample of Million Song Dataset =============================== ## Source This data is a small subset of the [Million Song Dataset](http://labrosa.ee.columbia.edu/millionsong/). The original data was contributed by The Echo Nest. Prepared by T. Bertin-Mahieux <tb2332 '@' columbia.edu> ## Attribute Information - artist_id:string - artist_latitude:double - artist_longitude:double - artist_location:string - artist_name:string - duration:double - end_of_fade_in:double - key:int - key_confidence:double - loudness:double - release:string - song_hotnes:double - song_id:string - start_of_fade_out:double - tempo:double - time_signature:double - time_signature_confidence:double - title:string - year:double - partial_sequence:int ...Os registros usados neste exemplo estão no

/databricks-datasets/songs/data-001/diretório. Para visualizar o conteúdo deste diretório, clique no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte na nova célula, clique em

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte na nova célula, clique em e selecione Executar célula.

e selecione Executar célula.%fs ls "/databricks-datasets/songs/data-001"path nome size Tempo de modificação dbfs:/databricks-datasets/músicas/data-001/header.txt header.txt 377 1454633901000 dbfs:/databricks-datasets/músicas/data-001/part-00000 parte-00000 52837 1454547464000 dbfs:/databricks-datasets/músicas/data-001/part-00001 Parte-00001 52469 1454547465000 Como o LEIA-ME e os nomes de arquivo não indicam o formato de arquivo, você pode exibir uma amostra dos registros para entender melhor o conteúdo e o formato de cada registro. Para ler e exibir os primeiros dez registros de um dos arquivos de dados, clique

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte na nova célula, clique em

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte na nova célula, clique em e selecione Executar célula.

e selecione Executar célula.%fs head --maxBytes=10000 "/databricks-datasets/songs/data-001/part-00000"AR81V6H1187FB48872 nan nan Earl Sixteen 213.7073 0.0 11 0.419 -12.106 Soldier of Jah Army nan SOVNZSZ12AB018A9B8 208.289 125.882 1 0.0 Rastaman 2003 -- ARVVZQP11E2835DBCB nan nan Wavves 133.25016 0.0 0 0.282 0.596 Wavvves 0.471578247701 SOJTQHQ12A8C143C5F 128.116 89.519 1 0.0 I Want To See You (And Go To The Movies) 2009 -- ARFG9M11187FB3BBCB nan nan Nashua USA C-Side 247.32689 0.0 9 0.612 -4.896 Santa Festival Compilation 2008 vol.1 nan SOAJSQL12AB0180501 242.196 171.278 5 1.0 Loose on the Dancefloor 0 225261 ...Você pode observar algumas coisas sobre os dados visualizando uma amostra dos registros. Você usará estas observações mais tarde ao processar os dados:

- Os registos não contêm um cabeçalho. Em vez disso, o cabeçalho é armazenado em um arquivo separado no mesmo diretório.

- Os arquivos parecem estar no formato de valor separado por tabulação (TSV).

- Alguns campos estão ausentes ou são inválidos.

- Os registos não contêm um cabeçalho. Em vez disso, o cabeçalho é armazenado em um arquivo separado no mesmo diretório.

Para explorar e analisar melhor os dados, use essas observações para carregar os dados de música formatados pelo TSV em um DataFrame do PySpark. Para fazer isso, clique

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte código na nova célula e, em seguida, clique em

no menu de ações da célula, selecione Adicionar célula abaixo, digite o seguinte código na nova célula e, em seguida, clique em  >Executar célula.

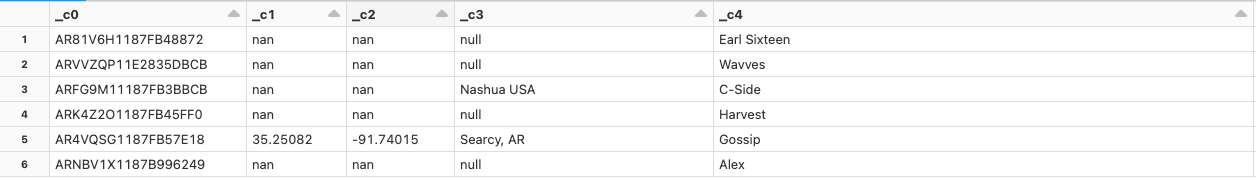

>Executar célula.df = spark.read.format('csv').option("sep", "\t").load('dbfs:/databricks-datasets/songs/data-001/part-00000') df.display()Como o arquivo de dados está faltando um cabeçalho, os nomes das colunas são exibidos como

_c0,_c1e assim por diante. Cada coluna é interpretada como umstringindependentemente do tipo de dados real. A ingestão dos dados brutos na próxima etapa mostra um exemplo de como você pode impor um esquema válido ao carregar os dados.