Habilitar cache semântico para APIs do Azure OpenAI no Gerenciamento de API do Azure

APLICA-SE A: Todas as camadas de gerenciamento de API

Habilite o cache semântico de respostas a solicitações de API OpenAI do Azure para reduzir os requisitos de largura de banda e processamento impostos às APIs de back-end e diminuir a latência percebida pelos consumidores de API. Com o cache semântico, você pode retornar respostas armazenadas em cache para prompts idênticos e também para prompts que são semelhantes em significado, mesmo que o texto não seja o mesmo. Para obter plano de fundo, consulte Tutorial: Usar o Cache do Azure para Redis como um cache semântico.

Nota

As etapas de configuração neste artigo habilitam o cache semântico para APIs do Azure OpenAI. Essas etapas podem ser generalizadas para habilitar o cache semântico para APIs LLM (modelo de linguagem grande) correspondentes disponíveis por meio da API de Inferência de Modelo de IA do Azure.

Pré-requisitos

- Uma ou mais APIs do Serviço OpenAI do Azure devem ser adicionadas à sua instância de Gerenciamento de API. Para obter mais informações, consulte Adicionar uma API de Serviço OpenAI do Azure ao Gerenciamento de API do Azure.

- O serviço Azure OpenAI deve ter implantações para o seguinte:

- API de conclusão de bate-papo (ou API de conclusão) - Implantação usada para chamadas de consumidor de API

- API de incorporação - Implantação usada para cache semântico

- A instância de Gerenciamento de API deve ser configurada para usar a autenticação de identidade gerenciada para as APIs do Azure OpenAI. Para obter mais informações, consulte Autenticar e autorizar o acesso às APIs do Azure OpenAI usando o Gerenciamento de API do Azure .

- Um Cache do Azure para Redis Enterprise ou uma instância do Azure Managed Redis . O módulo RediSearch deve ser habilitado no cache Redis.

Nota

Você só pode habilitar o módulo RediSearch ao criar um novo cache do Azure Redis Enterprise ou do Azure Managed Redis. Não é possível adicionar um módulo a um cache existente. Mais informações

- Cache externo configurado na instância de Gerenciamento de API do Azure. Para conhecer as etapas, consulte Usar um cache externo compatível com Redis no Gerenciamento de API do Azure.

Implementação da API de Chat de Teste

Primeiro, teste a implantação do Azure OpenAI para garantir que a API de Conclusão de Chat ou a API de Chat esteja funcionando conforme o esperado. Para conhecer as etapas, consulte Importar uma API do Azure OpenAI para o Gerenciamento de API do Azure.

Por exemplo, teste a API de Chat OpenAI do Azure enviando uma solicitação POST para o ponto de extremidade da API com um prompt no corpo da solicitação. A resposta deve incluir a conclusão do prompt. Exemplo de pedido:

POST https://my-api-management.azure-api.net/my-api/openai/deployments/chat-deployment/chat/completions?api-version=2024-02-01

com o corpo do pedido:

{"messages":[{"role":"user","content":"Hello"}]}

Quando a solicitação é bem-sucedida, a resposta inclui uma conclusão para a mensagem de chat.

Criar um back-end para incorporar API

Configure um recurso de back-end para a implantação da API de incorporação com as seguintes configurações:

- Nome - Um nome de sua escolha, como

embeddings-backend. Use esse nome para fazer referência ao back-end em políticas. - Tipo - Selecione URL personalizado.

- URL de tempo de execução - A URL da implantação da API de incorporação no Serviço OpenAI do Azure, semelhante a:

https://my-aoai.openai.azure.com/openai/deployments/embeddings-deployment/embeddings - Credenciais de autorização - Vá para a guia Identidade gerenciada .

- Identidade do cliente - Selecione Identidade atribuída ao sistema ou digite um ID de cliente de identidade gerenciada atribuído ao usuário.

- ID do recurso - Insira

https://cognitiveservices.azure.com/para o Serviço OpenAI do Azure.

Back-end de teste

Para testar o back-end, crie uma operação de API para sua API de Serviço OpenAI do Azure:

- Na guia Design da API, selecione + Adicionar operação.

- Insira um Nome para exibição e, opcionalmente, um Nome para a operação.

- Na seção Frontend, em URL, selecione POST e insira o caminho

/. - Na guia Cabeçalhos, adicione um cabeçalho obrigatório com o nome

Content-Typee o valorapplication/json. - Selecione Guardar

Configure as políticas a seguir na seção Processamento de entrada da operação da API. Na política set-backend-service, substitua o nome do back-end criado.

<policies>

<inbound>

<set-backend-service backend-id="embeddings-backend" />

<authentication-managed-identity resource="https://cognitiveservices.azure.com/" />

[...]

</inbound>

[...]

</policies>

Na guia Teste, teste a operação adicionando um api-version parâmetro de consulta com valor como 2024-02-01. Forneça um corpo de solicitação válido. Por exemplo:

{"input":"Hello"}

Se a solicitação for bem-sucedida, a resposta incluirá uma representação vetorial do texto de entrada:

{

"object": "list",

"data": [{

"object": "embedding",

"index": 0,

"embedding": [

-0.021829502,

-0.007157768,

-0.028619017,

[...]

]

}]

}

Configurar políticas de cache semântico

Configure as seguintes políticas para habilitar o cache semântico para APIs do Azure OpenAI no Gerenciamento de API do Azure:

Na seção Processamento de entrada para a API, adicione a política azure-openai-semantic-cache-lookup. No atributo, especifique o

embeddings-backend-idback-end da API de incorporação que você criou.Nota

Ao habilitar o cache semântico para outras APIs de modelo de linguagem grande, use a política llm-semantic-cache-lookup .

Exemplo:

<azure-openai-semantic-cache-lookup score-threshold="0.8" embeddings-backend-id="embeddings-deployment" ignore-system-messages="true" max-message-count="10"> <vary-by>@(context.Subscription.Id)</vary-by> </azure-openai-semantic-cache-lookup>Na seção Processamento de saída para a API, adicione a política azure-openai-semantic-cache-store.

Nota

Ao habilitar o cache semântico para outras APIs de modelo de linguagem grande, use a política llm-semantic-cache-store .

Exemplo:

<azure-openai-semantic-cache-store duration="60" />

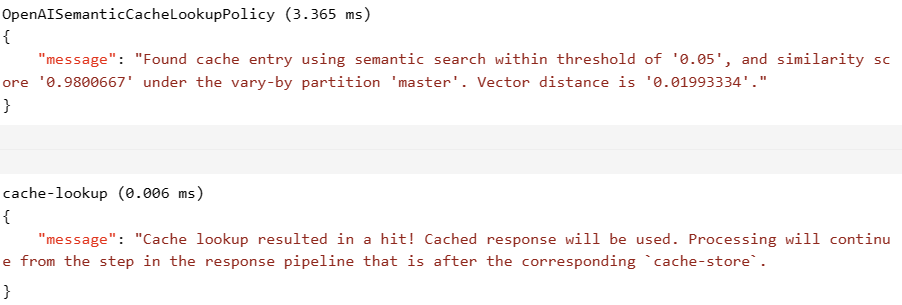

Confirmar cache

Para confirmar se o cache semântico está funcionando conforme o esperado, rastreie uma operação de Conclusão de teste ou Conclusão de Chat usando o console de teste no portal. Confirme se o cache foi usado em tentativas subsequentes inspecionando o rastreamento. Saiba mais sobre como rastrear chamadas de API no Gerenciamento de API do Azure.

Por exemplo, se o cache foi usado, a seção Saída inclui entradas semelhantes às da captura de tela a seguir:

Conteúdos relacionados

- Caching policies (Políticas de colocação em cache)

- Cache do Azure para Redis

- Recursos de gateway GenAI no Gerenciamento de API do Azure