Modelos suportados pelo Azure AI Agent Service

Os agentes são alimentados por um conjunto diversificado de modelos com diferentes capacidades e preços. A disponibilidade do modelo varia de acordo com a região e a nuvem. Certas ferramentas e capacidades requerem os modelos mais recentes. Os modelos a seguir estão disponíveis nos SDKs disponíveis. A tabela a seguir é para pagamento conforme o uso. Para obter informações sobre a disponibilidade da PTU (Unidade de Taxa de Transferência Provisionada), consulte a taxa de transferência provisionada na documentação do Azure OpenAI. Você pode usar modelos padrão globais se eles forem suportados nas regiões listadas aqui.

Modelos do Azure OpenAI

O Azure AI Agent Service dá suporte aos mesmos modelos que a API de conclusão de chat no Azure OpenAI, nas seguintes regiões.

| Região | GPT-4O, 2024-05-13 | GPT-4O, 2024-08-06 | GPT-4O-Mini, 2024-07-18 | GPT-4, 0613 | gpt-4, 1106-Pré-visualização | gpt-4, 0125-Pré-visualização | GPT-4, turbo-2024-04-09 | GPT-4-32K, 0613 | GPT-35-TURBO, 0613 | GPT-35-Turbo, 1106 | GPT-35-Turbo, 0125 | GPT-35-TURBO-16K, 0613 |

|---|---|---|---|---|---|---|---|---|---|---|---|---|

| australiaeast | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ | ✅ |

| eastus | ✅ | ✅ | ✅ | - | - | ✅ | ✅ | - | ✅ | - | ✅ | ✅ |

| eastus2 | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | ✅ | - | ✅ | ✅ |

| francecentral | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | - | ✅ |

| japaneast | - | - | - | - | - | - | - | - | ✅ | - | ✅ | ✅ |

| norwayeast | - | - | - | - | ✅ | - | - | - | - | - | - | - |

| southindia | - | - | - | - | ✅ | - | - | - | - | ✅ | ✅ | - |

| suécia central | ✅ | ✅ | ✅ | ✅ | ✅ | - | ✅ | ✅ | ✅ | ✅ | - | ✅ |

| uksouth | - | - | - | - | ✅ | ✅ | - | - | ✅ | ✅ | ✅ | ✅ |

| westus | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | ✅ | ✅ | - |

| westus3 | ✅ | ✅ | ✅ | - | ✅ | - | ✅ | - | - | - | ✅ | - |

Mais modelos

O Serviço Azure AI Agent também dá suporte aos seguintes modelos do catálogo de modelos do Azure AI Foundry.

- Meta-Llama-405B-Instruir

- Mistral-grande-2407

- Cohere-command-r-plus

- Cohere-command-r

Para usar esses modelos, você pode usar o portal do Azure AI Foundry para fazer uma implantação e, em seguida, fazer referência a ela em seu agente.

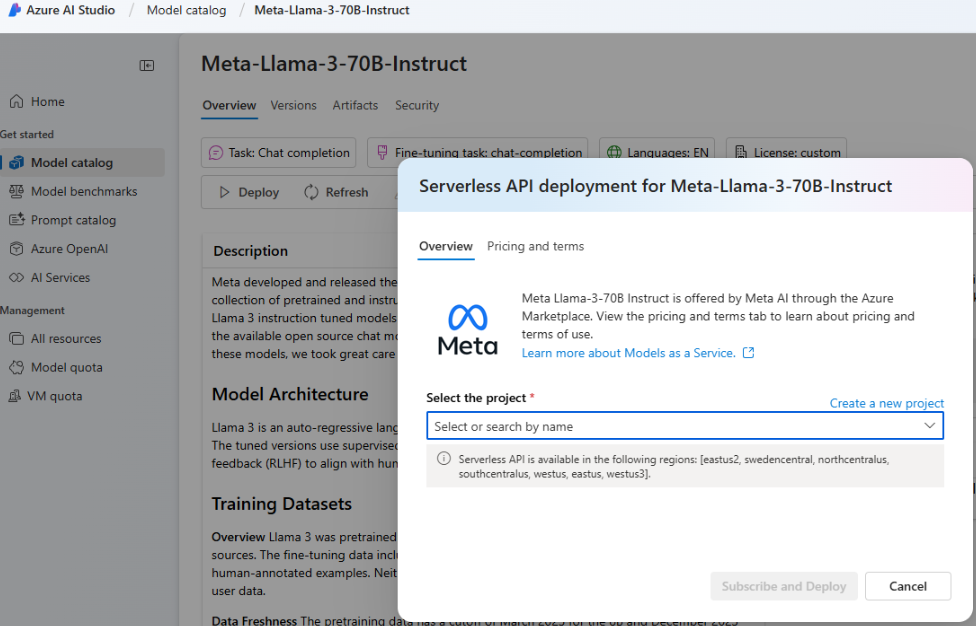

Vá para o portal do Azure AI Foundry e selecione Catálogo de modelos no menu de navegação esquerdo e role para baixo até Meta-Llama-3-70B-Instruct. Você também pode encontrar e usar um dos modelos listados anteriormente.

Selecione Implementar.

Na tela Opções de implantação exibida, selecione Serverless API with Azure AI Content Safety.

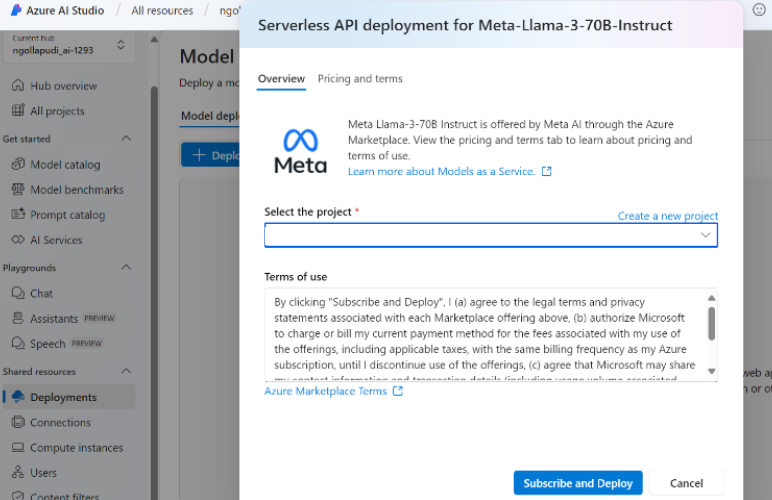

Selecione seu projeto e, em seguida, selecione Inscrever e implantar.

Adicione a conexão sem servidor ao seu hub/projeto. O nome de implantação escolhido é aquele ao qual você faz referência em seu código.

Ao chamar a API de criação do agente, defina o parâmetro como seu nome de

modelsimplantação. Por exemplo: