Capture dados de Hubs de Eventos no formato Parquet

Este artigo explica como usar o editor sem código para capturar automaticamente dados de streaming em Hubs de Eventos em uma conta do Azure Data Lake Storage Gen2 no formato Parquet.

Pré-requisitos

Um namespace de Hubs de Eventos do Azure com um hub de eventos e uma conta do Azure Data Lake Storage Gen2 com um contêiner para armazenar os dados capturados. Esses recursos devem estar acessíveis publicamente e não podem estar protegidos em um firewall ou protegidos em uma rede virtual do Azure.

Se você não tiver um hub de eventos, crie um seguindo as instruções de Guia de início rápido: criar um hub de eventos.

Se você não tiver uma conta do Data Lake Storage Gen2, crie uma seguindo as instruções de Criar uma conta de armazenamento

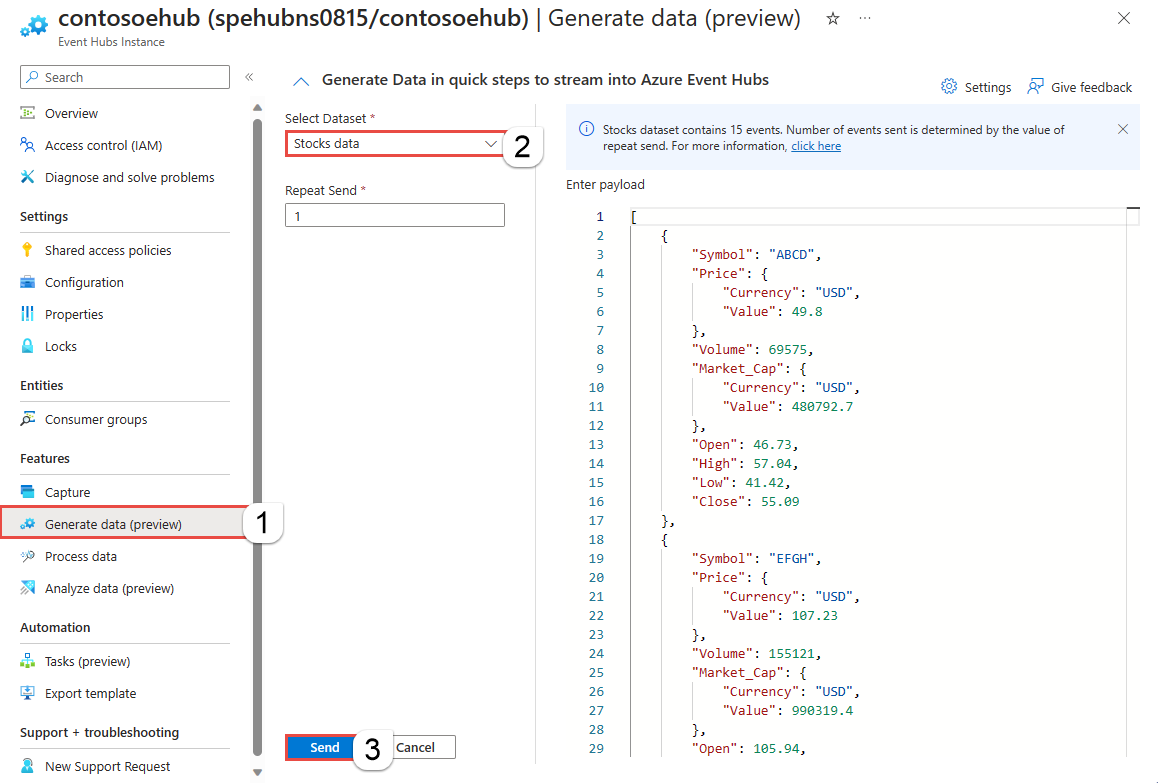

Os dados em sua instância de Hubs de Eventos (hub de eventos) devem ser serializados no formato JSON, CSV ou Avro. Na página Instância de Hubs de Eventos do seu hub de eventos, siga estas etapas:

Configurar um trabalho para capturar dados

Use as etapas a seguir para configurar um trabalho do Stream Analytics para capturar dados no Azure Data Lake Storage Gen2.

No portal do Azure, navegue até o hub de eventos.

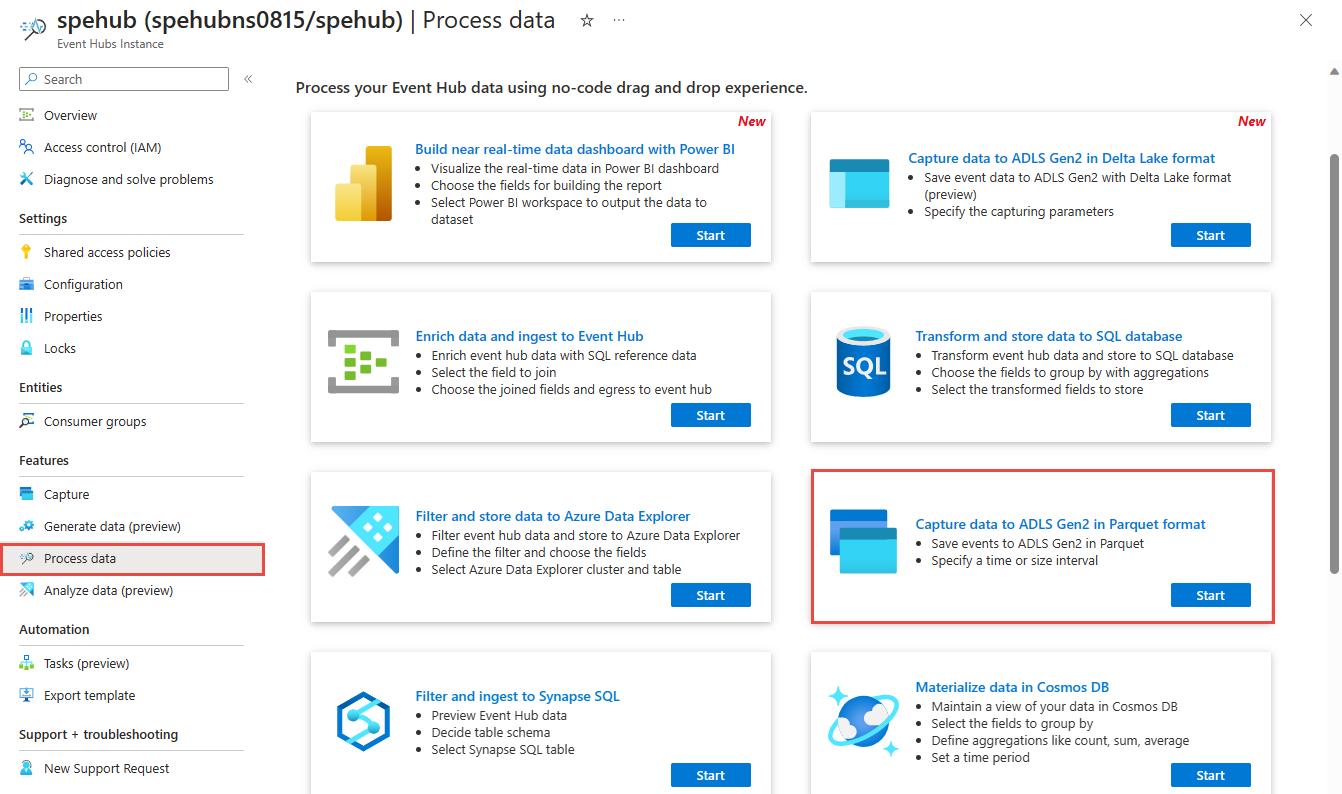

No menu à esquerda, selecione Processar dados em Recursos. Em seguida, selecione Iniciar na placa Capturar dados para ADLS Gen2 no formato Parquet.

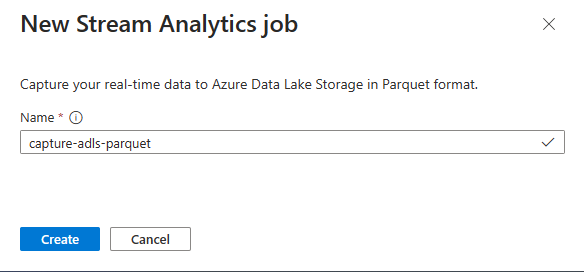

Introduza um nome para a sua tarefa do Stream Analytics e, em seguida, selecione Criar.

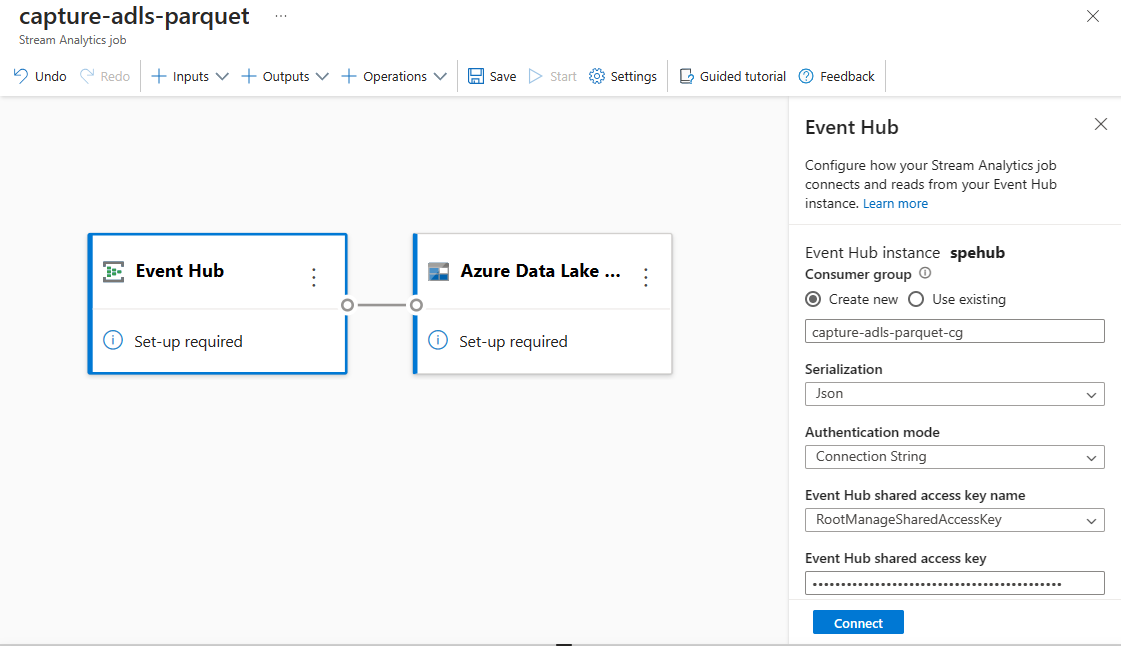

Especifique o tipo de serialização de seus dados nos Hubs de Eventos e o método de Autenticação que o trabalho usa para se conectar aos Hubs de Eventos. Para este tutorial, mantenha as configurações padrão. Em seguida, selecione Conectar.

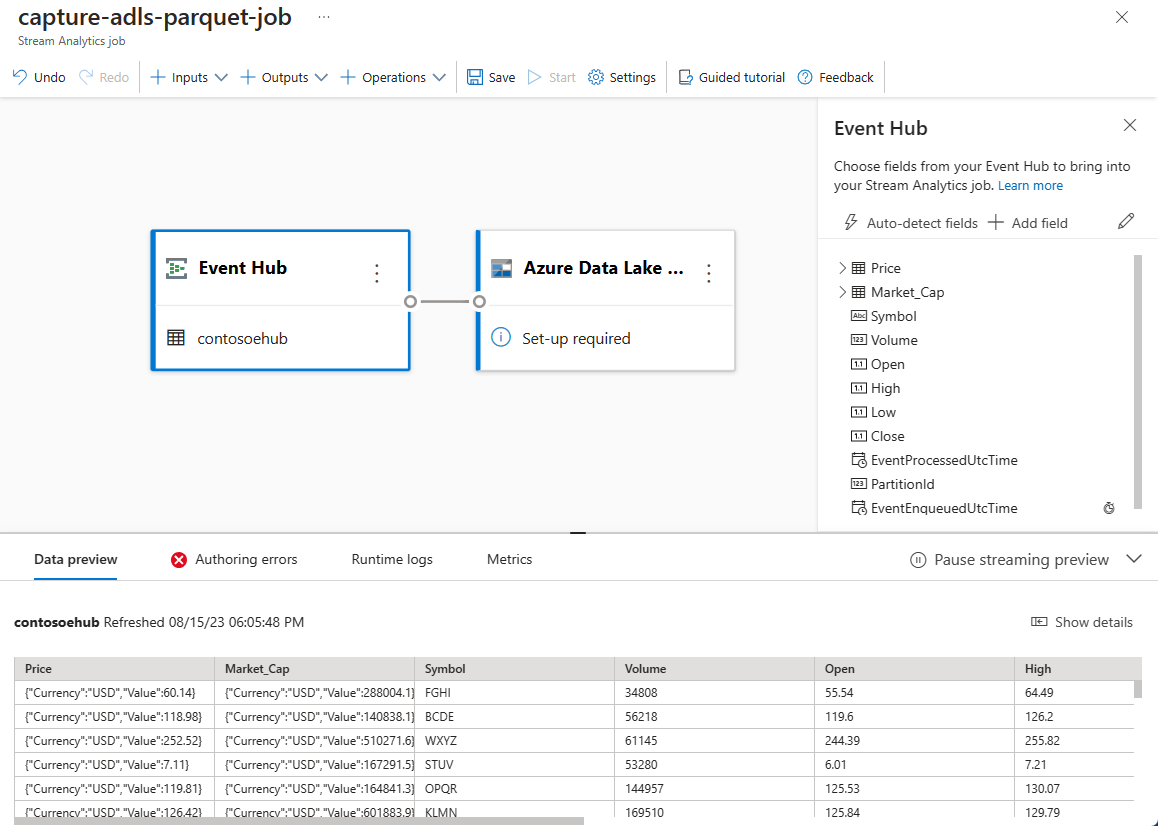

Quando a conexão é estabelecida com êxito, você vê:

Campos que estão presentes nos dados de entrada. Você pode escolher Adicionar campo ou selecionar o símbolo de três pontos ao lado de um campo para, opcionalmente, remover, renomear ou alterar seu nome.

Uma amostra dinâmica de dados de entrada na tabela de visualização de dados sob o modo de exibição de diagrama. Refresca-se periodicamente. Você pode selecionar Pausar visualização de streaming para exibir uma exibição estática da entrada de exemplo.

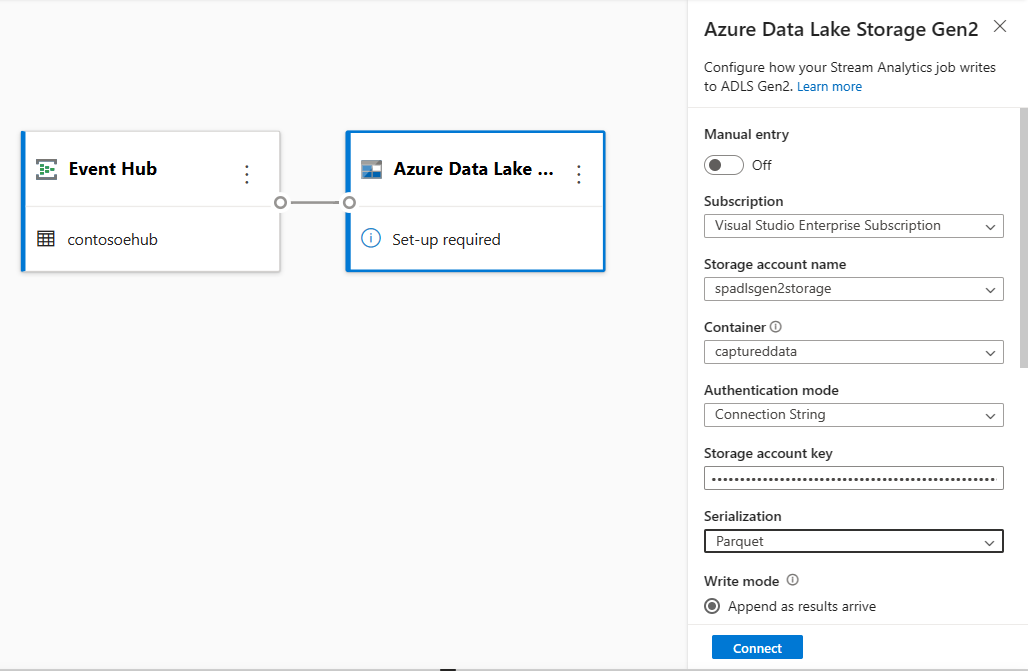

Selecione o bloco Azure Data Lake Storage Gen2 para editar a configuração.

Na página de configuração do Azure Data Lake Storage Gen2 , siga estas etapas:

Selecione a assinatura, o nome da conta de armazenamento e o contêiner no menu suspenso.

Depois que a assinatura for selecionada, o método de autenticação e a chave da conta de armazenamento deverão ser preenchidos automaticamente.

Selecione Parquet para o formato de serialização .

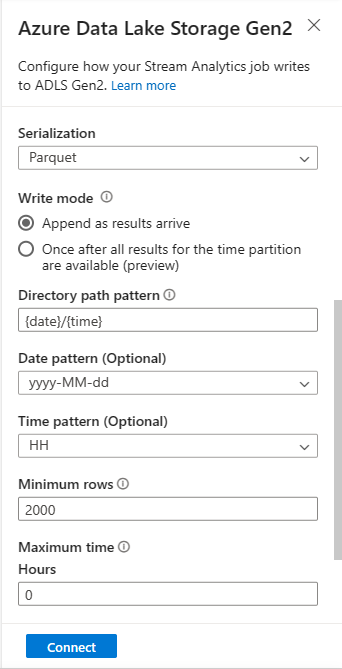

Para blobs de streaming, espera-se que o padrão de caminho de diretório seja um valor dinâmico. É necessário que a data faça parte do caminho do arquivo para o blob – referenciado como

{date}. Para saber mais sobre padrões de caminho personalizados, consulte Particionamento de saída de blob personalizado do Azure Stream Analytics.Selecione Ligar

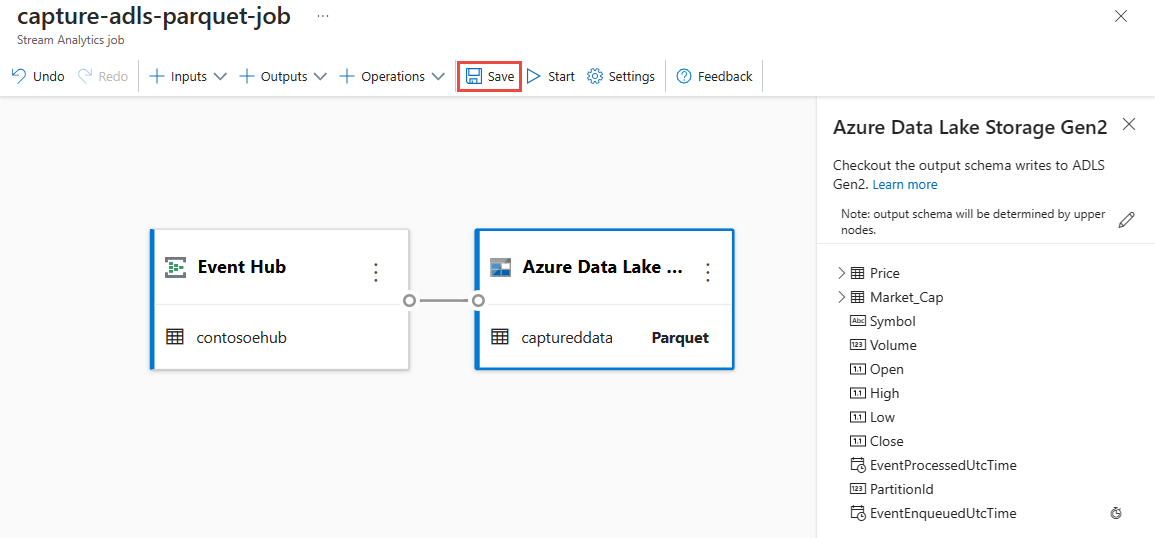

Quando a conexão é estabelecida, você vê campos que estão presentes nos dados de saída.

Selecione Salvar na barra de comandos para salvar sua configuração.

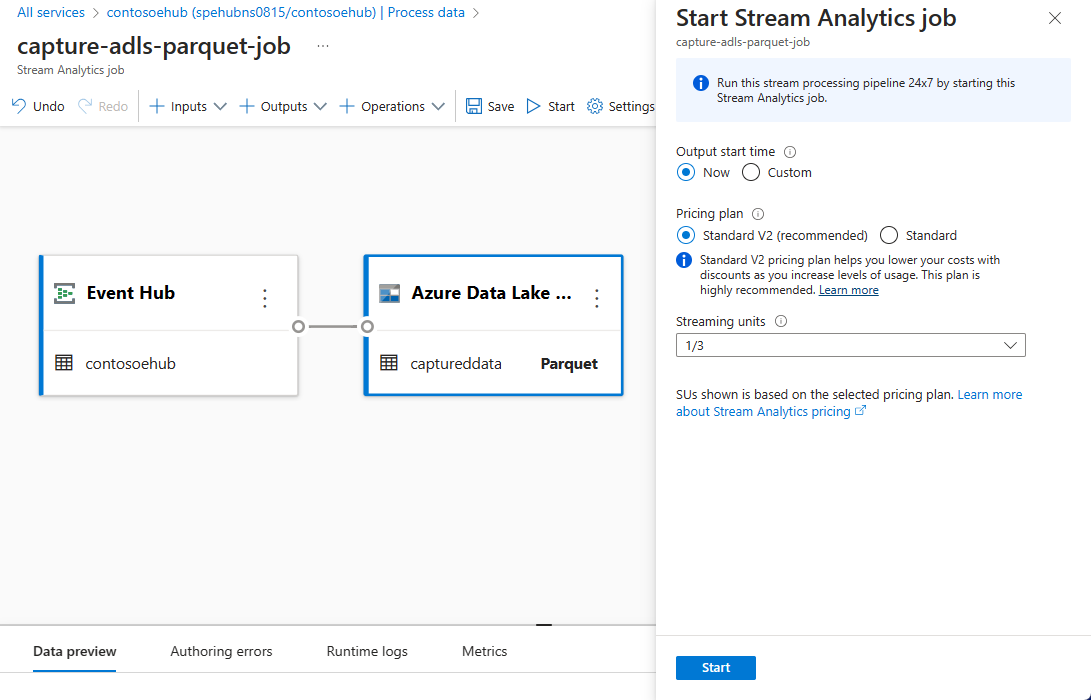

Selecione Iniciar na barra de comandos para iniciar o fluxo de streaming para capturar dados. Em seguida, na janela de trabalho Start Stream Analytics:

Escolha a hora de início da saída.

Selecione o plano de preços.

Selecione o número de unidades de streaming (SU) com as quais o trabalho é executado. SU representa os recursos de computação alocados para executar um trabalho do Stream Analytics. Para obter mais informações, consulte Unidades de streaming no Azure Stream Analytics.

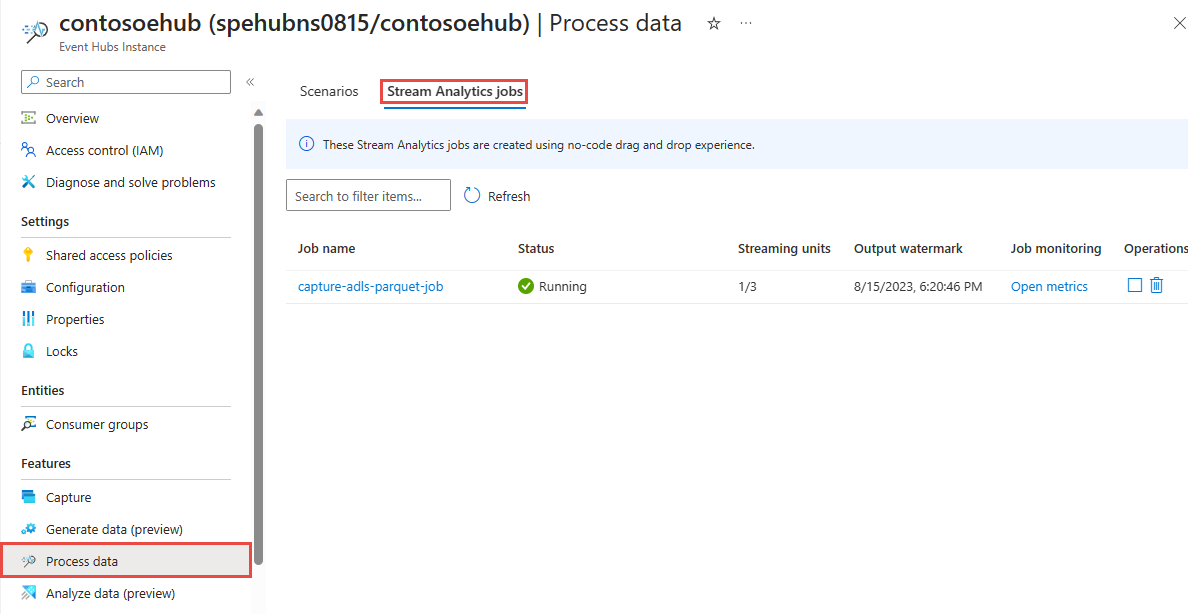

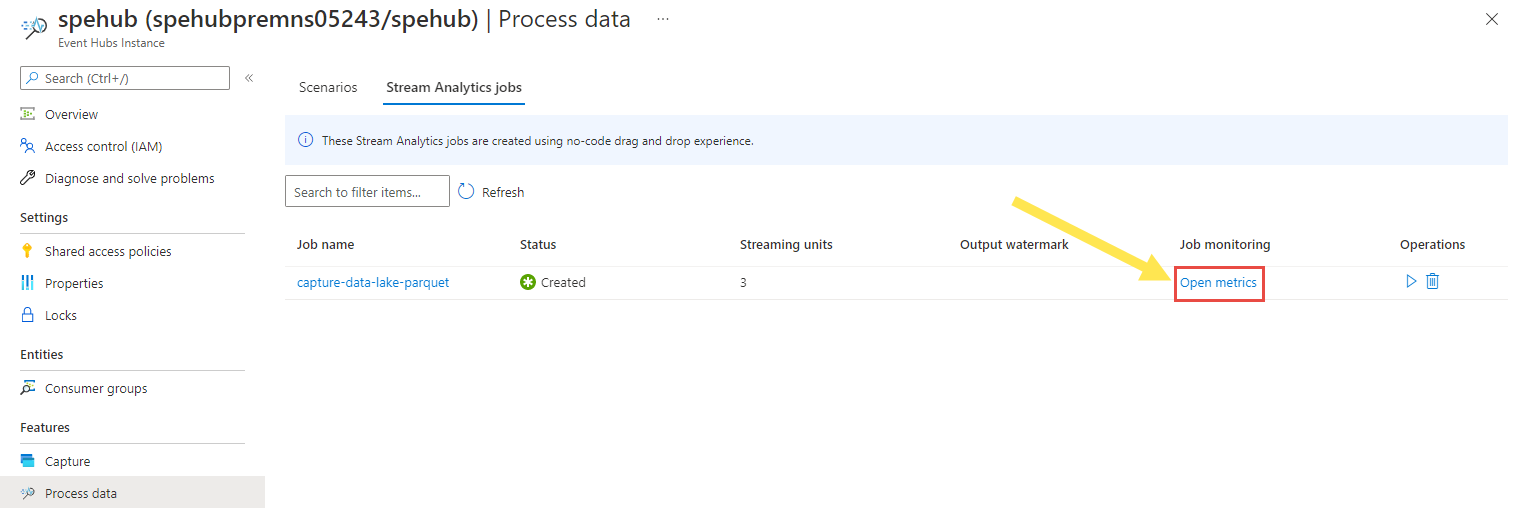

Você deve ver o trabalho do Stream Analytic na guia do trabalho do Stream Analytics da página Processar dados do seu hub de eventos.

Verificar a saída

Na página de instância dos Hubs de Eventos do seu hub de eventos, siga estas etapas:

- No menu à esquerda, selecione Data Explorer.

- No painel central, selecione Enviar eventos.

- No painel Enviar eventos, para Selecionar conjunto de dados, selecione Dados de ações.

- Selecione Enviar.

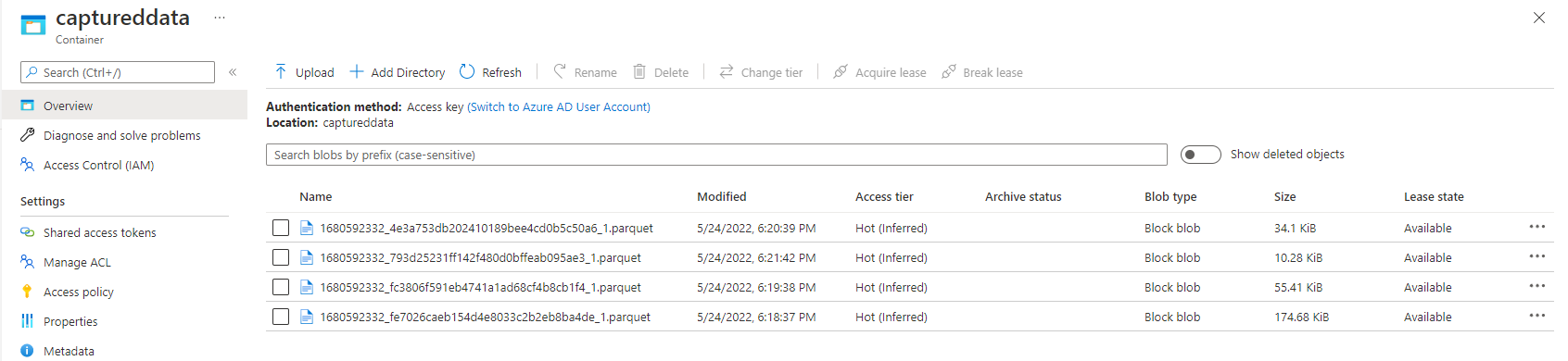

Verifique se os arquivos do Parquet são gerados no contêiner do Armazenamento do Azure Data Lake.

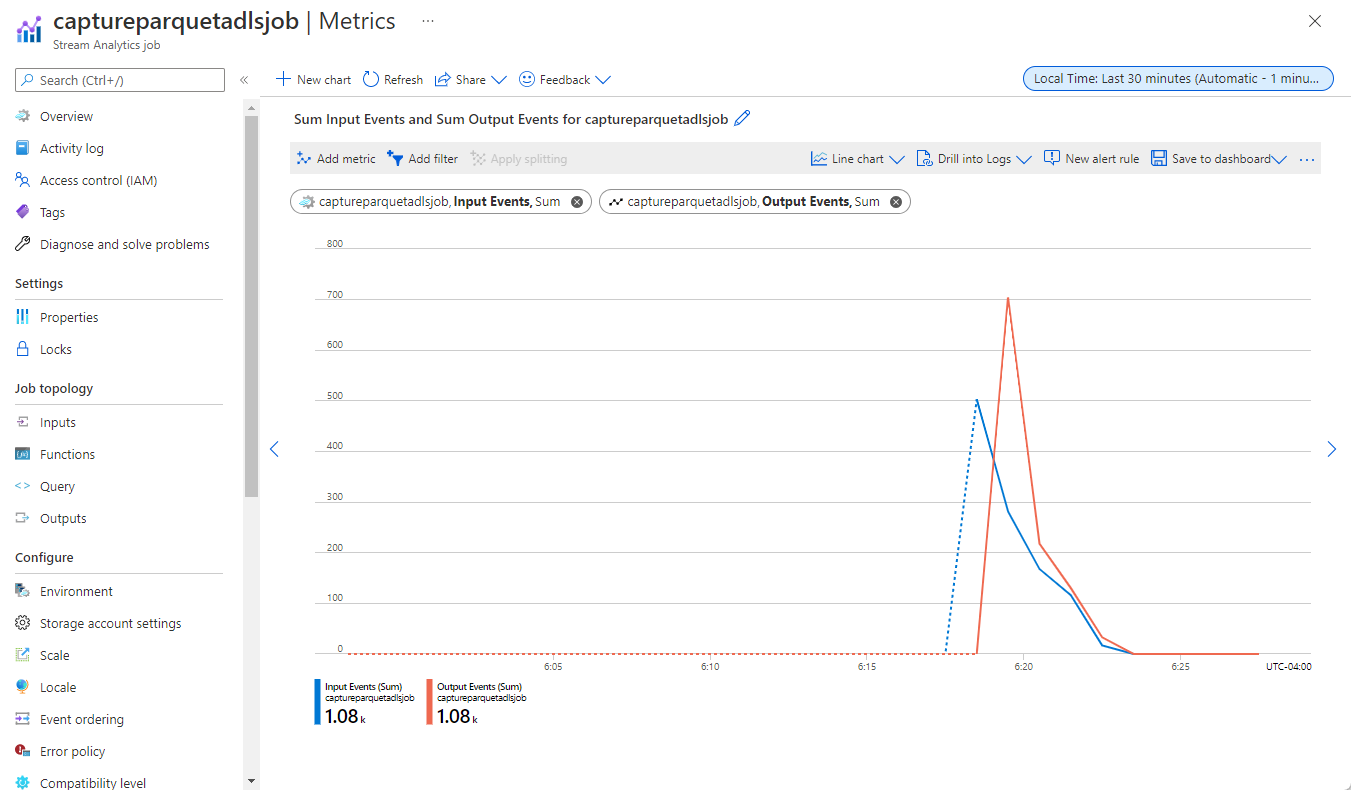

De volta à página de instância dos Hubs de Eventos, selecione Processar dados no menu à esquerda. Alterne para a guia Trabalhos do Stream Analytics. Selecione Abrir métricas para monitorá-lo. Adicione métricas de entrada ao gráfico usando a métrica Adicionar na barra de ferramentas. Se você não vir as métricas no gráfico, aguarde alguns minutos e atualize a página.

Aqui está um exemplo de captura de tela de métricas mostrando eventos de entrada e saída.

Considerações ao usar o recurso de replicação geográfica de Hubs de Eventos

Os Hubs de Eventos do Azure lançaram recentemente o recurso de Replicação Geográfica na visualização pública. Esse recurso é diferente do recurso de Recuperação de Desastres Geográficos dos Hubs de Eventos do Azure.

Quando o tipo de failover é Forçado e a consistência da replicação é assíncrona, o trabalho do Stream Analytics não garante exatamente uma saída para uma saída dos Hubs de Eventos do Azure.

O Azure Stream Analytics, como produtor com um hub de eventos uma saída, pode observar atraso de marca d'água no trabalho durante a duração do failover e durante a limitação pelos Hubs de Eventos caso o atraso de replicação entre primário e secundário atinja o atraso máximo configurado.

O Azure Stream Analytics, como consumidor com Hubs de Eventos como Entrada, pode observar atraso de marca d'água no trabalho durante a duração do failover e pode ignorar dados ou localizar dados duplicados após a conclusão do failover.

Devido a essas ressalvas, recomendamos que você reinicie o trabalho do Stream Analytics com a hora de início apropriada logo após a conclusão do failover dos Hubs de Eventos. Além disso, como o recurso de replicação geográfica dos Hubs de Eventos está em visualização pública, não recomendamos o uso desse padrão para trabalhos do Stream Analytics de produção neste momento. O comportamento atual do Stream Analytics melhorará antes que o recurso de replicação geográfica dos Hubs de Eventos esteja disponível em geral e possa ser usado em trabalhos de produção do Stream Analytics.

Conteúdos relacionados

Agora você já sabe como usar o editor sem código do Stream Analytics para criar um trabalho que captura dados de Hubs de Eventos para o Azure Data Lake Storage Gen2 no formato Parquet. Em seguida, você pode saber mais sobre o Azure Stream Analytics e como monitorar o trabalho que você criou.