Ferramentas de exploração de dados no Azure Databricks

Depois de ingerir dados de suas fontes, você pode usar a plataforma do Azure Databricks para explorar e analisar seus dados de forma colaborativa.

Vamos explorar as ferramentas que você usa ao trabalhar com dados no Azure Databricks.

Colaborar e executar código com notebooks

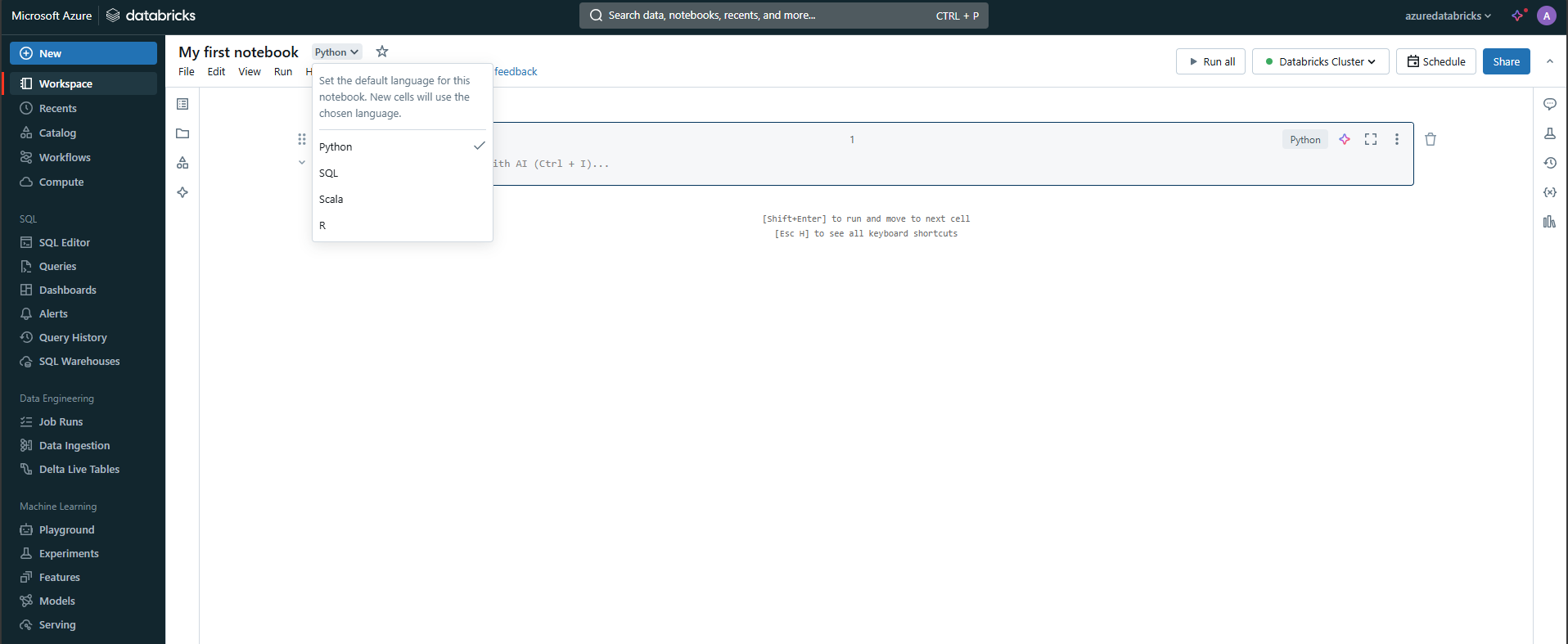

Você pode usar notebooks no Azure Databricks para escrever código Python, SQL, Scala ou R para explorar e visualizar dados. Os notebooks dão suporte à exploração interativa de dados e podem ser compartilhados entre os membros da equipe. Ele também dá suporte a recursos de criação de perfil de dados para que os cientistas de dados entendam a forma e o conteúdo dos dados.

Você pode usar as visualizações internas para entender rapidamente distribuições de dados, tendências e padrões. Ao lado dos recursos internos, o Azure Databricks permite que você se integre a bibliotecas de software livre comumente usadas, como Matplotlib, Seaborn ou D3.js para visualizações mais complexas.

Trabalhar com DataFrames do Spark

Quando você trabalha com dados em notebooks, você usa DataFrames do Spark que são criados no Apache Spark. DataFrames permitem manipular grandes conjuntos de dados com eficiência.

Para criar um DataFrame simples, você pode executar o seguinte código:

data = [("Alice", 34), ("Bob", 45), ("Cathy", 29)]

columns = ["Name", "Age"]

df = spark.createDataFrame(data, columns)

O DataFrames dá suporte a operações como filtragem, agregação e junção, que são cruciais para a exploração de dados.

Por exemplo, você pode filtrar um DataFrame:

filtered_df = df.filter(df["Age"] > 30)

O Azure Databricks também dá suporte ao SQL, permitindo alternar entre operações de DataFrame e consultas SQL para interagir com os dados de uma maneira mais natural.

Para filtrar o DataFrame usando uma consulta SQL, primeiro crie uma exibição temporária:

df.createOrReplaceTempView("people")

sql_df = spark.sql("SELECT Name, Age FROM people WHERE Age > 30")

Dica

Para obter mais informações, saiba como carregar e transformar dados usando DataFrames do Apache Spark.

Explorar dados usando bibliotecas e APIs

Dependendo do que você deseja fazer com seus dados, você precisa usar bibliotecas e APIs específicas para fornecer a funcionalidade para executar as etapas de processamento de dados desejadas.

Instalar bibliotecas de código aberto

Como analista de dados, engenheiro de dados ou cientista de dados, você pode usar suas bibliotecas de software livre preferenciais para explorar e processar dados. O Azure Databricks permite que você instale bibliotecas do Python, como Pandas, NumPy ou Scikit-learn para recursos adicionais de análise de dados.

Usar o MLlib para cargas de trabalho de machine learning

Você pode treinar modelos de machine learning para ajudar você a explorar e processar seus dados. Com o MLlib do Spark, você faz o uso ideal dos clusters de computação distribuídos anexados aos blocos de anotações. Com a biblioteca MLlib, você pode aplicar técnicas de aprendizado de máquina, como clustering, regressão e classificação, ajudando você a descobrir padrões ocultos e complexos em seus dados.

Visualizar dados com ferramentas de visualização externas

Além das opções internas do gráfico, o Azure Databricks integra-se a ferramentas de visualização externas, como o Tableau ou o Power BI, por meio de APIs de visualização de dados para recursos de dashboard avançados.

Dica

Saiba mais sobre como trabalhar com bibliotecas.

Gerenciar seus clusters de computação

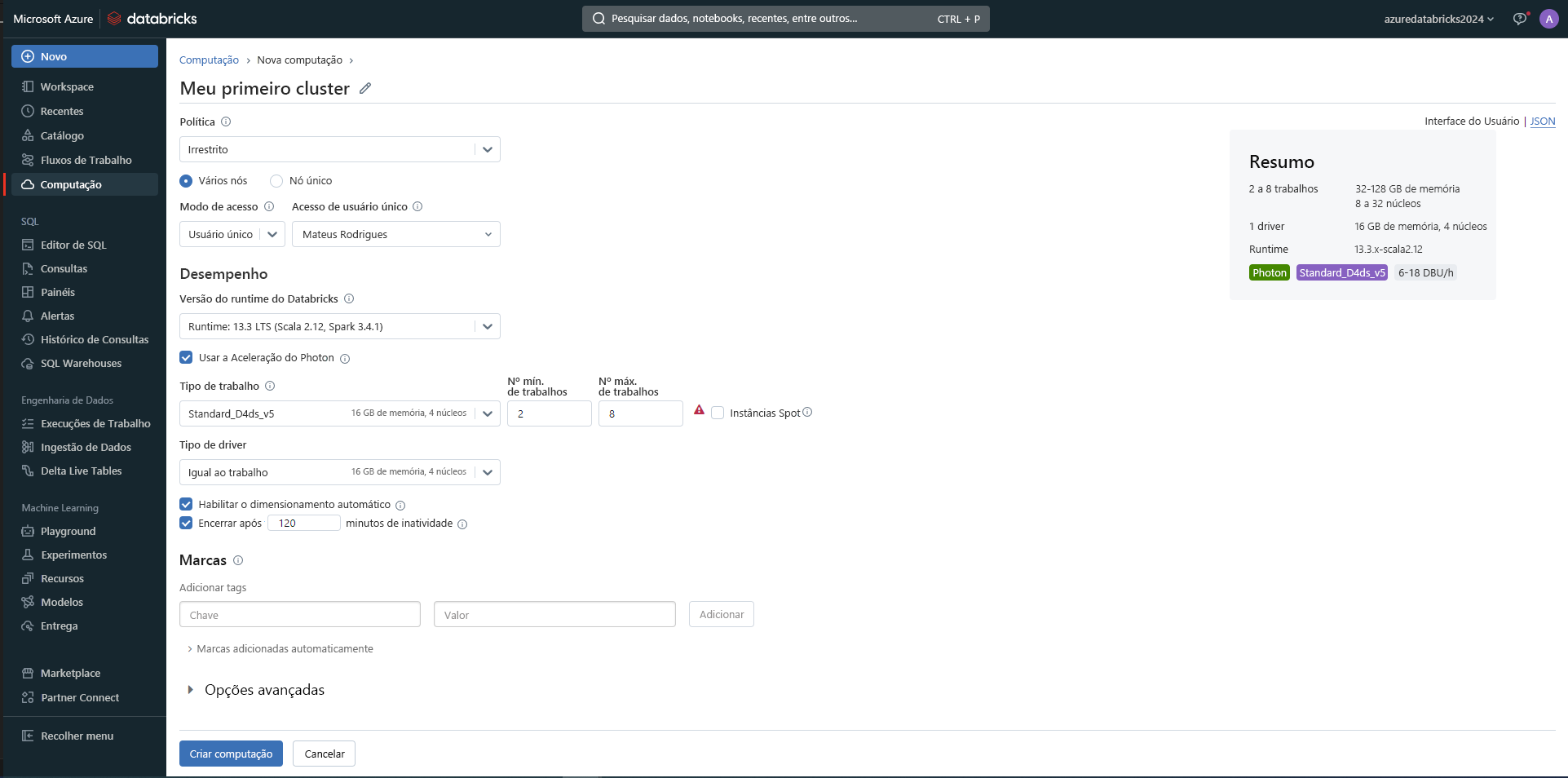

Quando você deseja executar o código em notebooks, é necessário anexar um notebook a um cluster de computação para acessar o poder de processamento necessário.

Há dois benefícios em gerenciar seus clusters de computação no Azure Databricks:

- Dimensionamento automático de clusters: Você pode dimensionar automaticamente seus recursos computacionais dependendo da carga de trabalho, o que ajuda a otimizar os custos e o desempenho durante a fase de exploração.

- Clusters gerenciados: Você pode simplificar o gerenciamento de cluster à medida que o Azure Databricks gerencia a configuração, a configuração e a manutenção.

Dica

Saiba mais sobre como gerenciar a computação

Essas ferramentas tornam o Azure Databricks uma plataforma flexível para exploração de dados, tratando tudo, desde limpeza básica de dados até projetos avançados de machine learning.