Ingerir dados com o Azure Databricks

Antes de trabalhar com dados no Azure Databricks, você precisa ingerir dados na plataforma. Uma vez na plataforma, a computação baseada em nuvem permite que você processe grandes volumes de dados com eficiência.

Há várias maneiras de ingerir dados no Azure Databricks, tornando-o uma ferramenta versátil e poderosa para análise de dados:

Orquestrar pipelines de dados com o Azure Data Factory

O Azure Data Factory é um serviço de integração de dados robusto que permite criar pipelines de dados. Esses pipelines podem ingerir dados de várias fontes no Azure Databricks, garantindo que todos os seus dados estejam centralizados e prontos para análise.

Ingerir dados em tempo real com os Hubs de Eventos e os Hubs de IoT

Para ingestão de dados em tempo real, os Hubs de Eventos do Azure e os Hubs IoT são as opções mais adequadas. Eles permitem que você transmita dados diretamente para o Azure Databricks, permitindo que você processe e analise os dados à medida que eles chegam. A ingestão e a análise de dados em tempo real são úteis para cenários como monitoramento de eventos ao vivo ou acompanhamento de dados do dispositivo Internet das Coisas (IoT).

Ingerir dados diretamente do Armazenamento de Blobs do Azure e do Azure Data Lake

O Armazenamento de Blobs do Azure e o Azure Data Lake Storage Gen2 são perfeitos para armazenar grandes quantidades de dados não estruturados. Você pode ingerir facilmente esses dados no Databricks por meio de:

- Sistema de Arquivos do Databricks (DBFS): Um sistema de arquivos distribuído integrado ao Azure Databricks, permitindo que você monte contêineres do Armazenamento de Blobs do Azure e acesse-os como se fizessem parte do sistema de arquivos local.

- APIs do Spark: As APIs do Spark fornecem uma maneira flexível de ler e gravar dados do Armazenamento de Blobs do Azure diretamente no Spark DataFrames, usando os recursos de processamento paralelo do Spark para processamento eficiente de dados em larga escala.

O DBFS oferece uma maneira mais simples e integrada de trabalhar com dados no Armazenamento de Blobs do Azure, enquanto as APIs do Spark fornecem maior flexibilidade e desempenho para tarefas de processamento de dados em larga escala. A escolha entre os dois depende de seu caso de uso e requisitos específicos.

Observação

O Azure Data Lake Storage Gen2 é criado com base no Armazenamento de Blobs do Azure, combinando os recursos de ambos os serviços. O Armazenamento de Blobs do Azure foi projetado para armazenar grandes quantidades de dados não estruturados, enquanto o Azure Data Lake Storage Gen2 adiciona recursos especificamente para análise de Big Data, como namespace hierárquico e controle de acesso refinado.

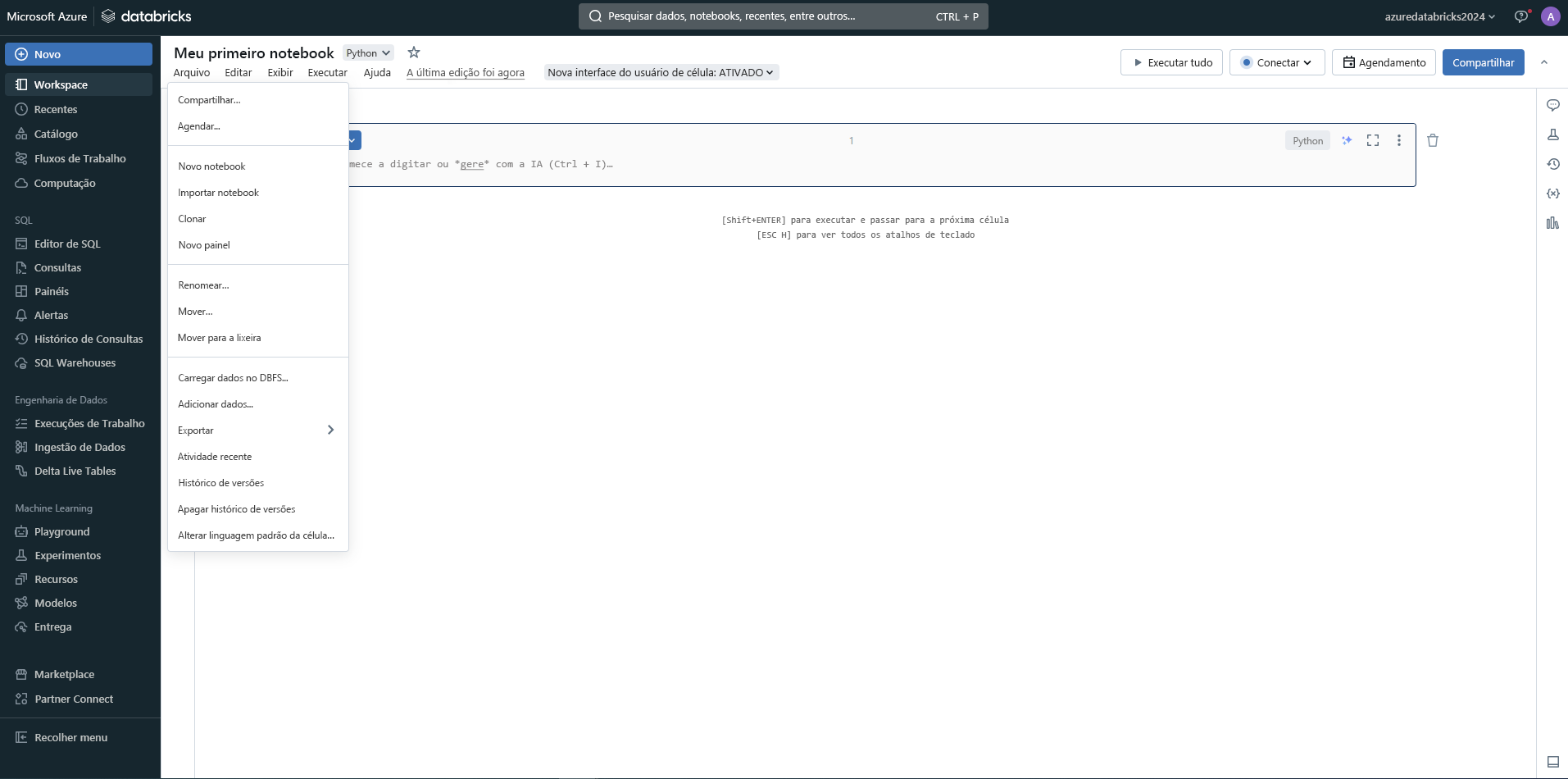

Explorar seus dados ingeridos em notebooks

Depois que os dados forem ingeridos, você poderá explorar seus dados para descobrir insights acionáveis. Os notebooks do Azure Databricks fornecem um ambiente colaborativo em que você pode executar a análise usando PySpark, Scala, R ou SQL. Esses notebooks não são apenas poderosos, mas também fáceis de usar, facilitando a manipulação e visualização de seus dados.

Na próxima seção, você aprenderá as várias abordagens para exploração de dados com o Azure Databricks.