Monitorar pipelines do Azure Data Factory

Depois de criar e publicar um pipeline no Azure Data Factory, você pode associá-lo a um gatilho ou iniciar manualmente uma execução sob demanda. Você pode monitorar todas as execuções de pipeline nativamente na experiência de usuário do Azure Data Factory. Para abrir a experiência de monitoramento, selecione o bloco Monitorar e Gerenciar na folha de data factory do portal do Azure. Se você já estiver na UX do Azure Data Factory, clique no ícone Monitorar na barra lateral esquerda.

Monitorar execuções de pipeline

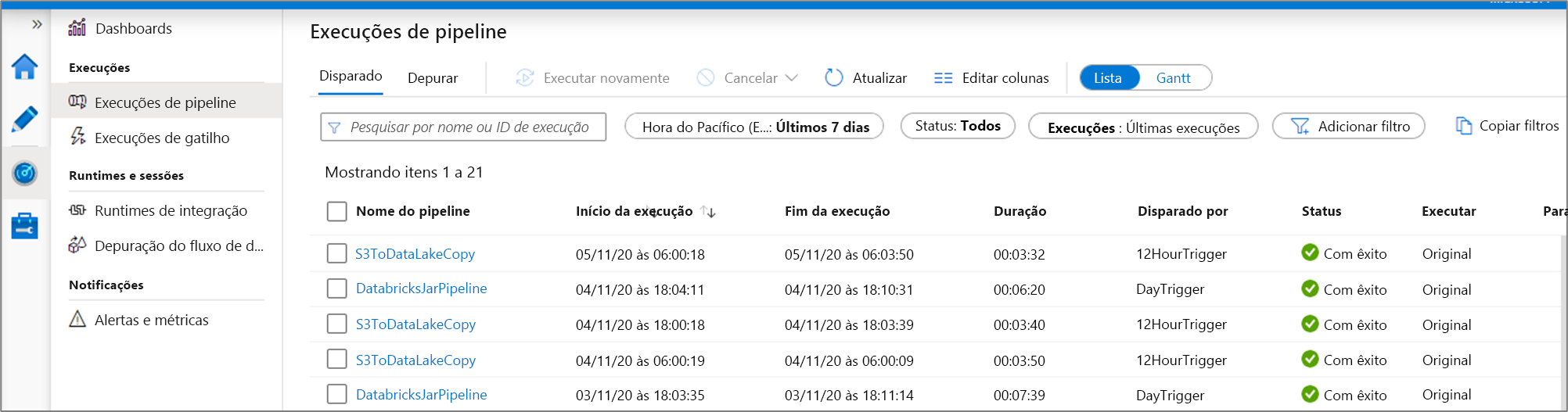

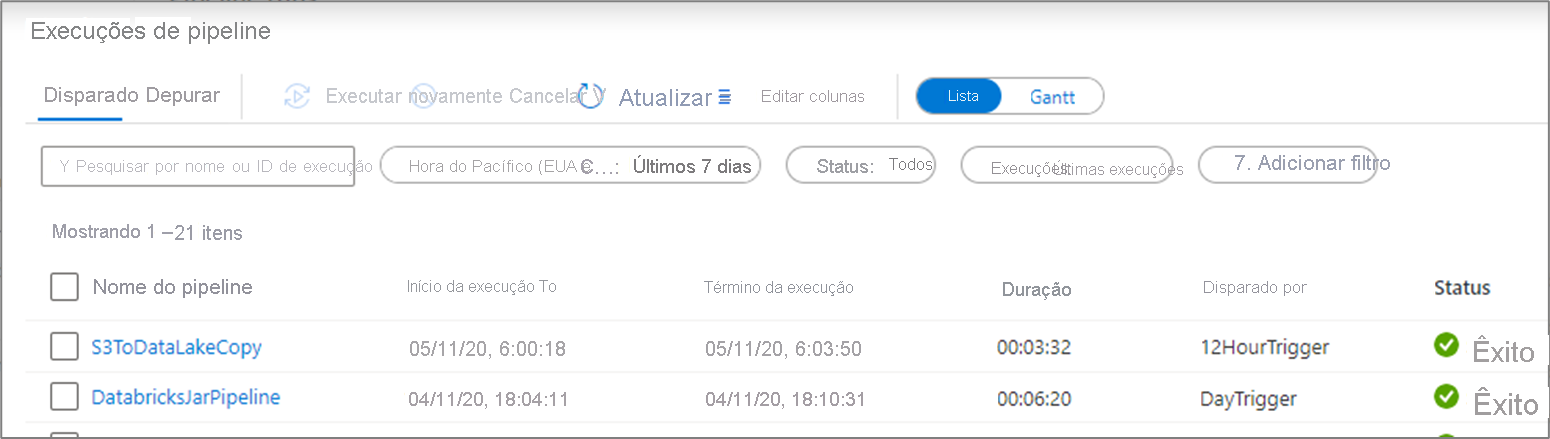

O modo de exibição de monitoramento padrão é a lista de execuções de pipeline no período selecionado. Você pode alterar o intervalo de tempo e filtrar por status, nome do pipeline ou anotação. Passe o mouse sobre a execução de pipeline específica para obter ações específicas de execução, como executar novamente e o relatório de consumo.

A grade de execução de pipeline contém as seguintes colunas:

| Nome da coluna | Descrição |

|---|---|

| Nome do Pipeline | Nome do pipeline |

| Início da Execução | Data e hora de início da execução do pipeline (MM/DD/AAAA HH:MM:SS AM/PM) |

| Fim da execução | Data e hora de término da execução de pipeline (MM/DD/AAAA HH:MM:SS AM/PM) |

| Duration | Duração da execução (HH:MM:SS) |

| Disparado por | O nome do gatilho que iniciou o pipeline |

| Status | Falha, Bem-sucedida, Em andamento, Canceladoou Na fila |

| Anotações | Marcas filtráveis associadas a um pipeline |

| Parâmetros | Parâmetros de execução de pipeline (pares de nome/valor) |

| Erro | Se o pipeline falhou, o erro de execução |

| ID da execução | ID da execução de pipeline |

Você precisará selecionar manualmente o botão Atualizar para atualizar a lista de execuções do pipeline e atividades. No momento, não há suporte para atualização automática.

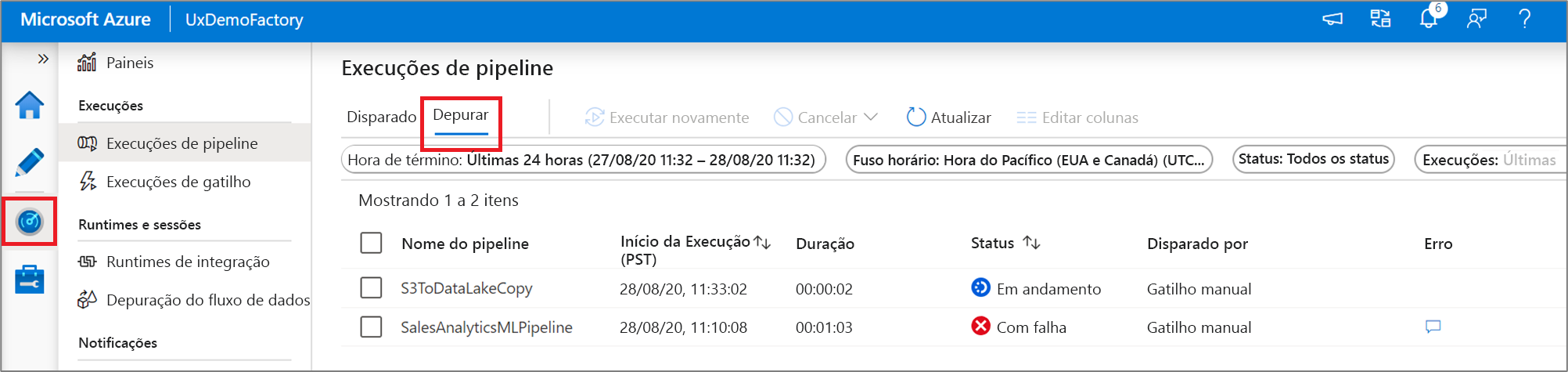

Para ver os resultados de uma execução de depuração, selecione a guia Depurar.

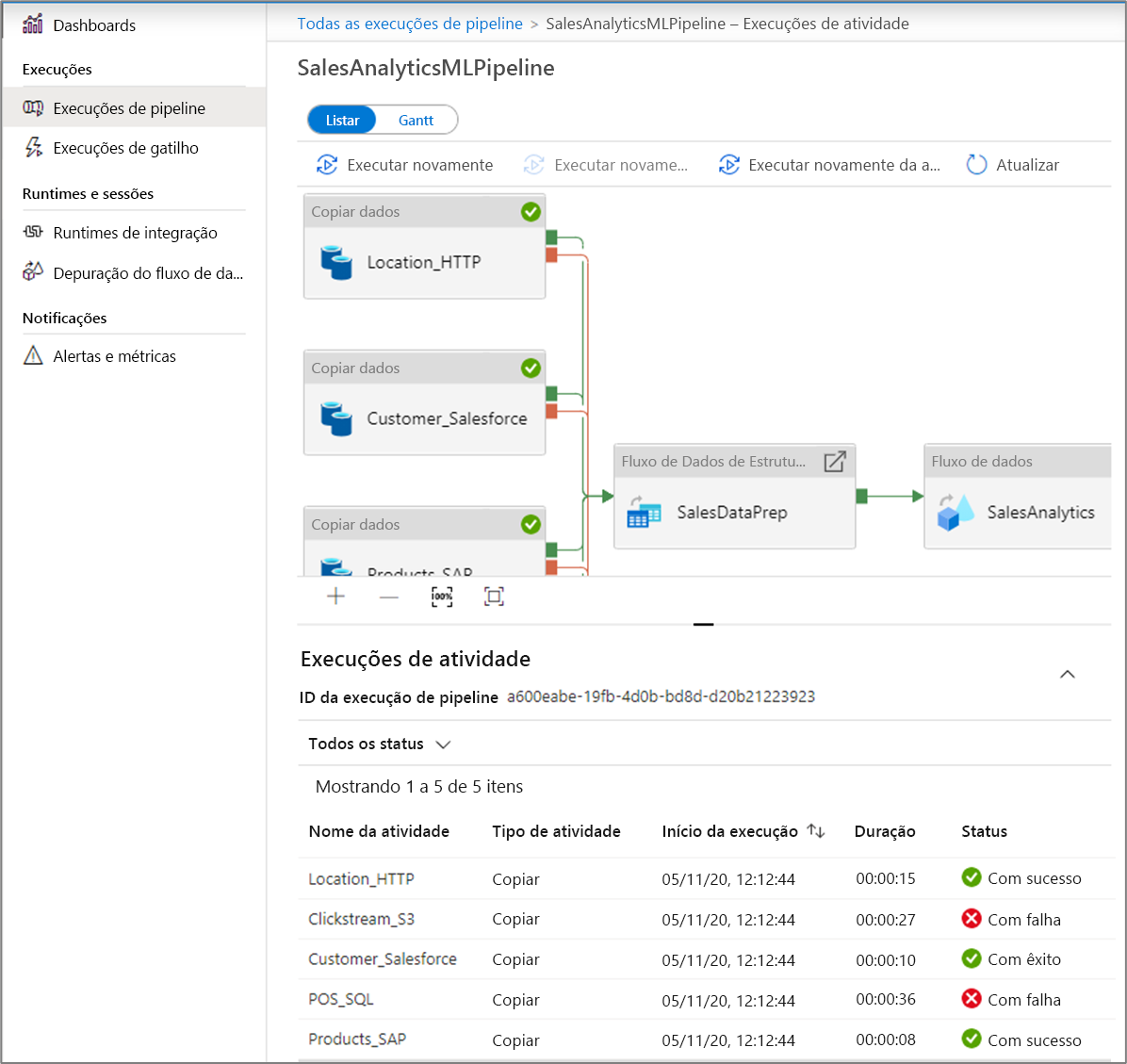

Monitorar execuções de atividade

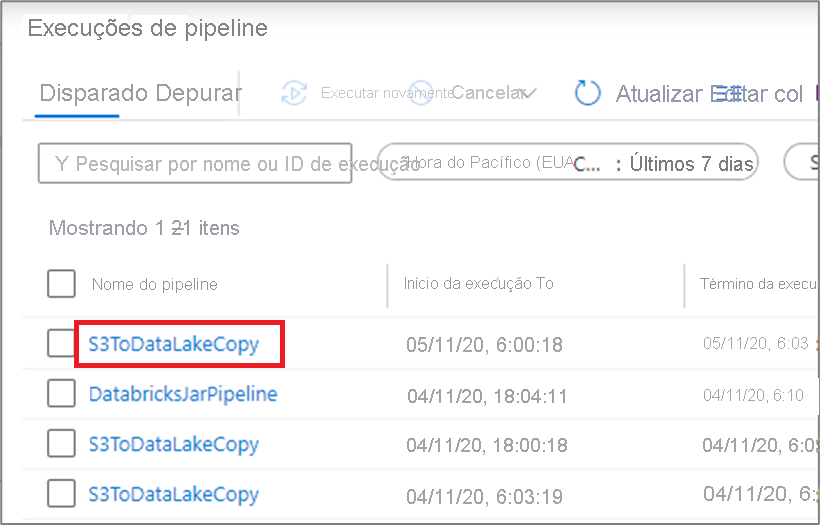

Para obter uma exibição detalhada das execuções de atividade individuais de uma execução de pipeline específica, clique no nome do pipeline.

A exibição de lista mostra as execuções de atividade que correspondem a cada execução de pipeline. Focalize a execução da atividade específica para obter informações específicas da execução, como a entrada JSON, a saída JSON e experiências detalhadas de monitoramento específicas da atividade. Atividades como fluxo de dados, cópia e Azure Databricks têm uma exibição dedicada que pode ser vista clicando no ícone de óculos.

| Nome da coluna | Descrição |

|---|---|

| Nome da atividade | Nome da atividade no pipeline |

| Tipo de atividade | Tipo de atividade, como Copiar, ExecuteDataFlow ou AzureMLExecutePipeline |

| Ações | Ícones que permitem que você veja informações de entrada JSON, informações de saída JSON ou experiências detalhadas de monitoramento específicas da atividade |

| Início da Execução | Data e hora de início da execução da atividade (MM/DD/AAAA HH:MM:SS AM/PM) |

| Duration | Duração da execução (HH:MM:SS) |

| Status | Falha, Sucesso, Em andamento ou Cancelado |

| Integration Runtime | Em qual Integration Runtime a atividade foi executada |

| Propriedades do Usuário | Propriedades definidas pelo usuário da atividade |

| Erro | Se a atividade falhou, o erro de execução |

| ID da execução | ID da execução de atividade |

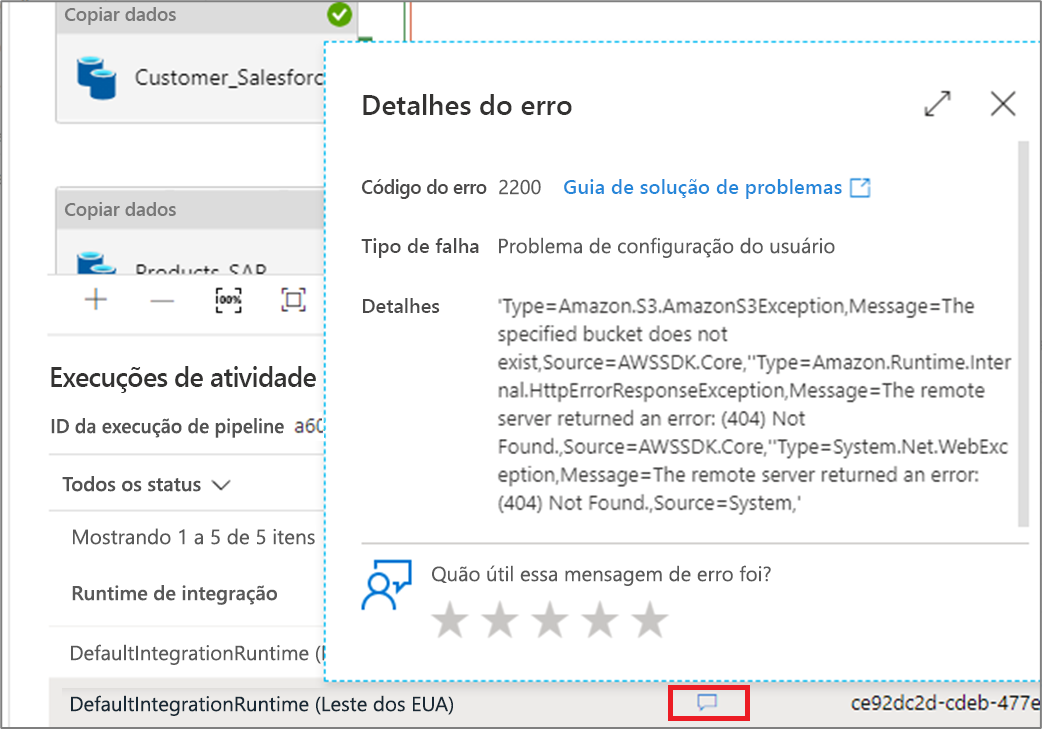

Se uma atividade falhar, você poderá ver a mensagem de erro detalhada clicando no ícone na coluna erro.

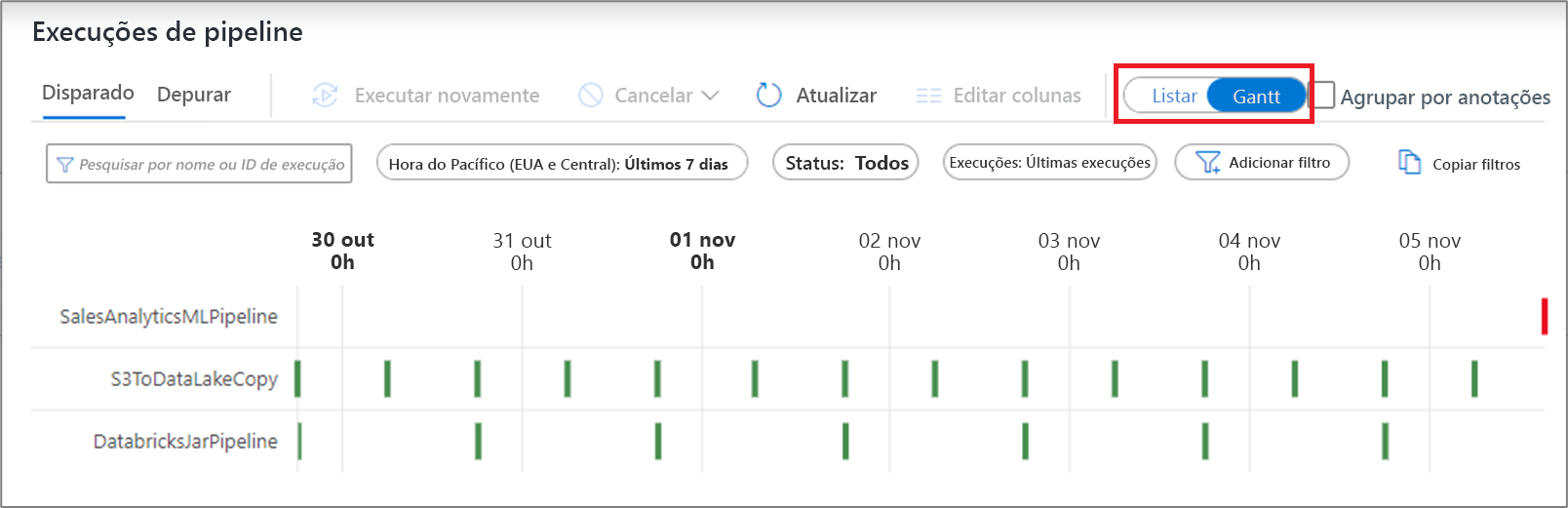

Exibição de Gantt

Um gráfico de Gantt é uma exibição que permite que você veja o histórico de execução ao longo de um intervalo de tempo. Ao alternar para um modo de exibição de Gantt, você verá todas as execuções de pipeline agrupadas por nome exibidas como barras em relação ao tempo que a execução levou. Você também pode agrupar por anotações/marcas que você criou em seu pipeline. O modo de exibição Gantt também está disponível no nível de execução da atividade.

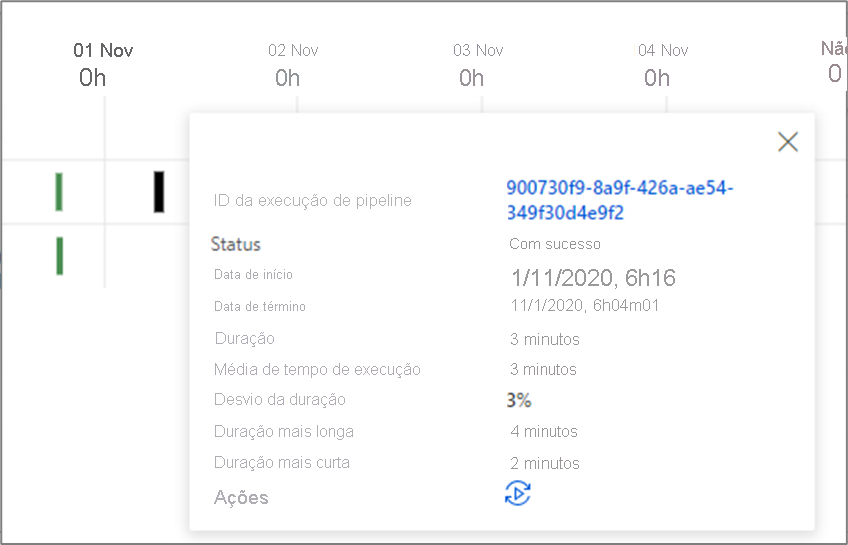

O comprimento da barra informa a duração do pipeline. Você também pode selecionar a barra para ver mais detalhes.

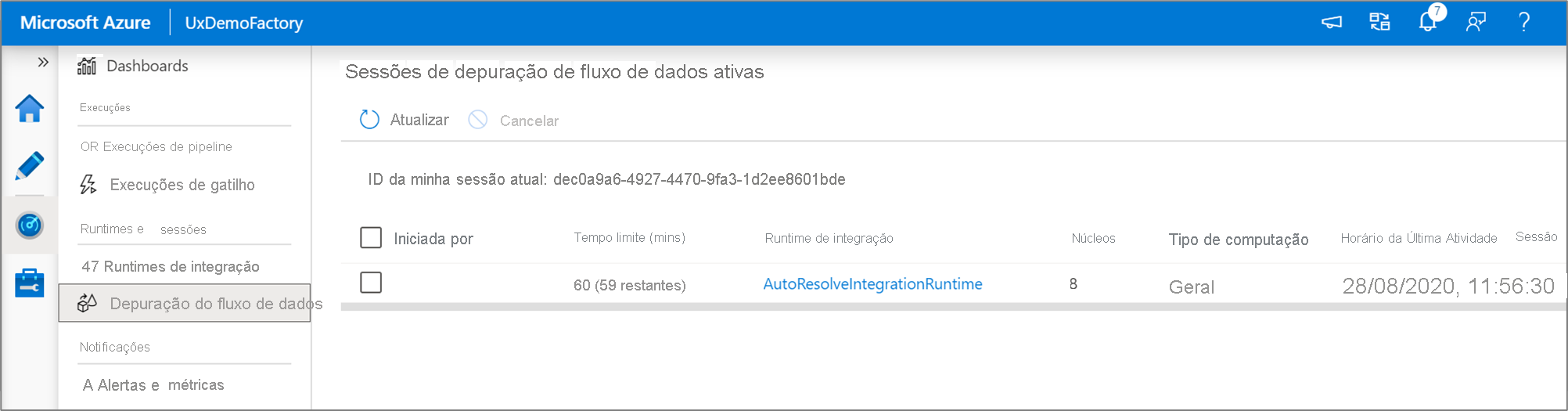

Monitorar sessões de depuração do fluxo de dados

O fluxo de dados de mapeamento permite que você crie uma lógica de transformação de dados sem código que é executada em escala. Ao criar sua lógica, você pode ativar uma sessão de depuração para trabalhar interativamente com seus dados usando um cluster do Spark ao vivo.

Você pode monitorar sessões de depuração de fluxo de dados ativos em um alocador na experiência de Monitor.

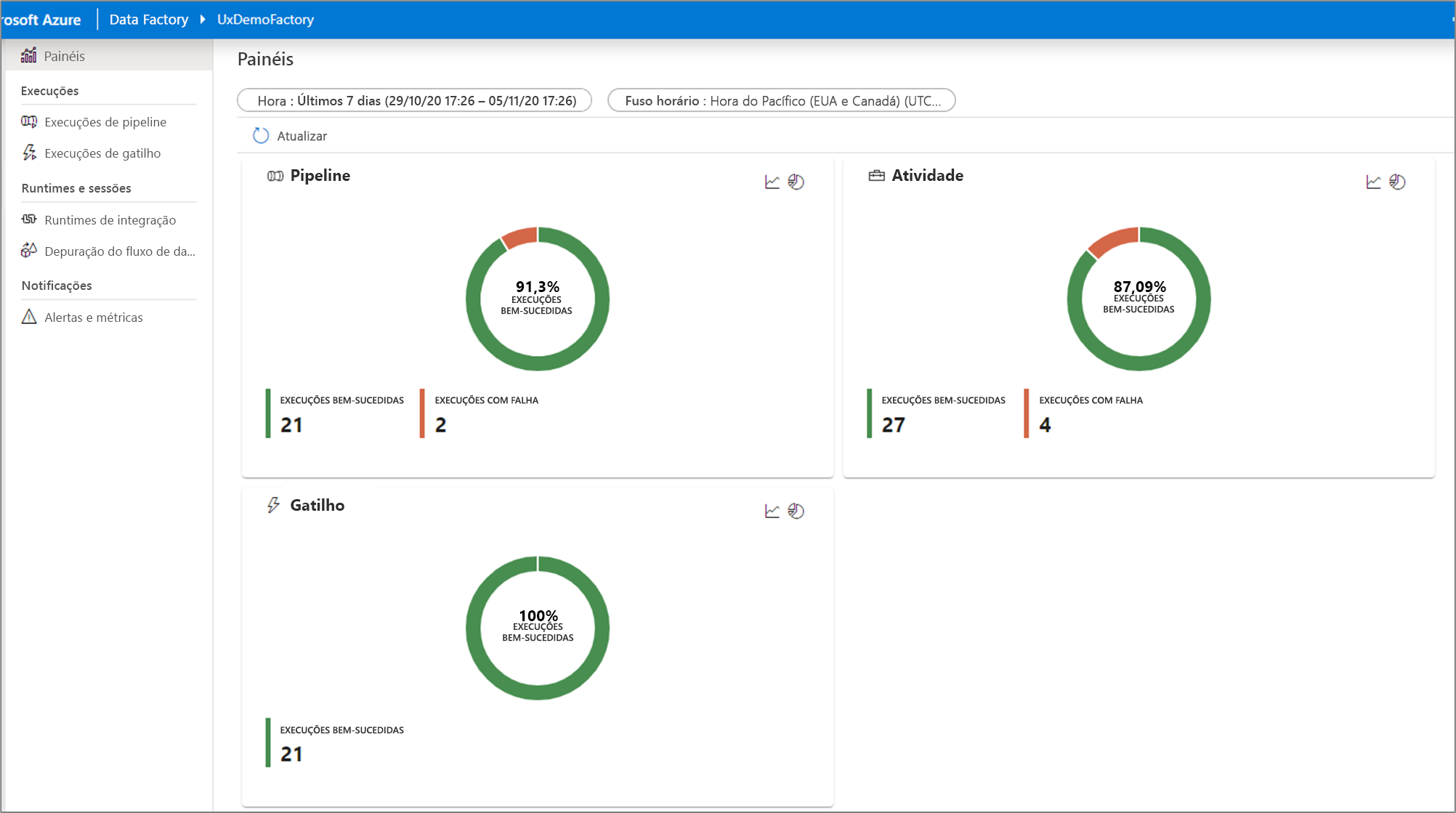

Como monitorar painéis

Para ver uma exibição visual de alto nível de seu pipeline, atividade e execuções de gatilho, vá para o painel Painéis. Aqui, você pode ver o número de sucessos e falhas em um período especificado.

Monitorar usando o Azure Monitor

O Azure Monitor fornece logs e métricas de infraestrutura de nível básico para a maioria dos serviços do Azure. Os logs de diagnóstico do Azure são emitidos por um recurso e fornecem dados avançados e frequentes sobre a operação do recurso. O ADF (Azure Data Factory) pode gravar logs de diagnóstico no Azure Monitor.

O Data Factory armazena dados de execução de pipeline por apenas 45 dias. Use o Azure Monitor se desejar manter esses dados por mais tempo. Com o monitor, você pode rotear os logs de diagnóstico para análise em vários destinos diferentes.

- Conta de armazenamento: salve os logs de diagnóstico em uma conta de armazenamento para auditoria ou inspeção manual. Você pode usar as configurações de diagnóstico para especificar o tempo de retenção em dias.

- Hub de eventos: transmita os logs para os Hubs de Eventos do Azure. Os logs tornam-se entrada para uma solução de serviço de parceiro/análise personalizada, como o Power BI.

- Log Analytics: analise os logs com o Log Analytics. A integração do Data Factory ao Azure Monitor é útil nos seguintes cenários:

- Você quer escrever consultas complexas em um conjunto avançado de métricas publicadas pelo Data Factory no Monitor. Você pode criar alertas personalizados nessas consultas por meio do Monitor.

- Você quer monitorar os data factories. Você pode rotear dados de vários alocadores de dados para um só workspace de monitoramento.

Você também pode usar uma conta de armazenamento ou um namespace de hub de eventos que não esteja na assinatura do recurso que emite logs. O usuário que define a configuração deve ter acesso apropriado ao RBAC (controle de acesso baseado em função) do Azure para ambas as assinaturas.

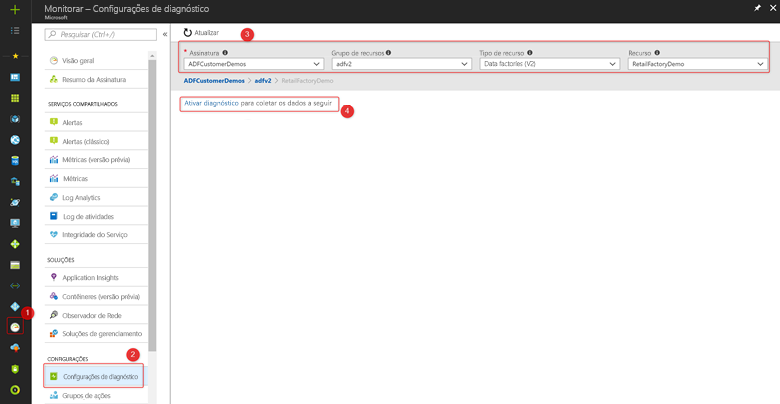

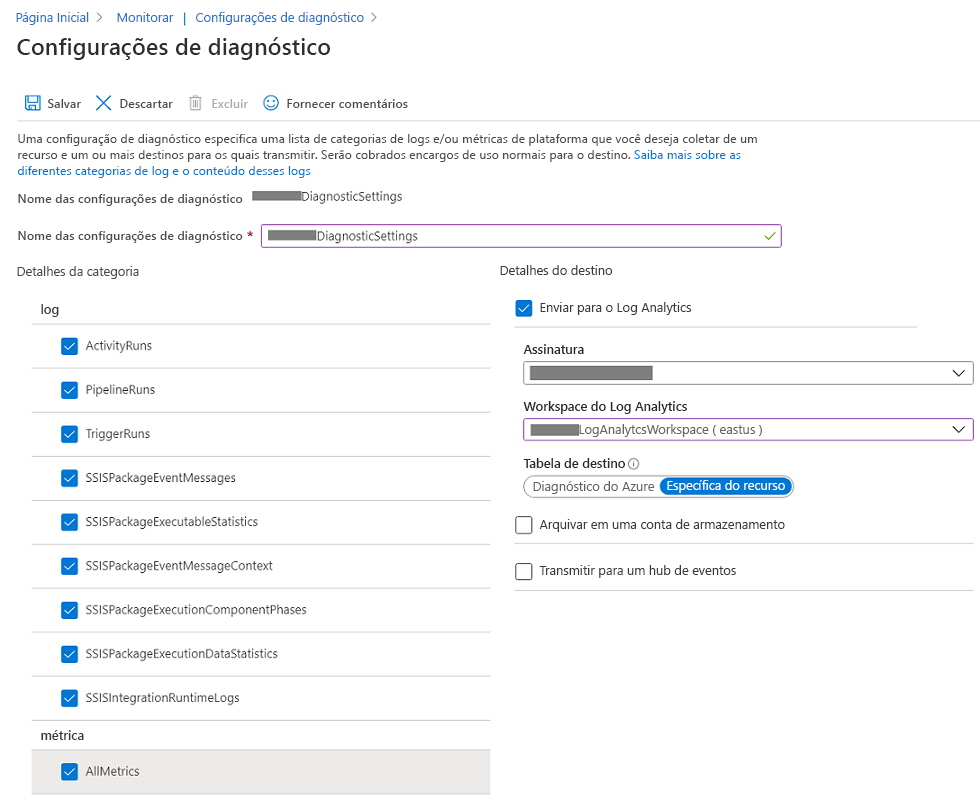

Definir as configurações de diagnóstico e de workspace

Crie ou adicione configurações de diagnóstico para seu data factory.

No portal, acesse Monitor. Selecione Configurações>Configurações de diagnóstico.

Selecione o data factory para o qual você deseja definir uma configuração de diagnóstico.

Se não existir nenhuma configuração no data factory selecionado, você será solicitado a criar uma configuração. Selecione Ativar diagnóstico.

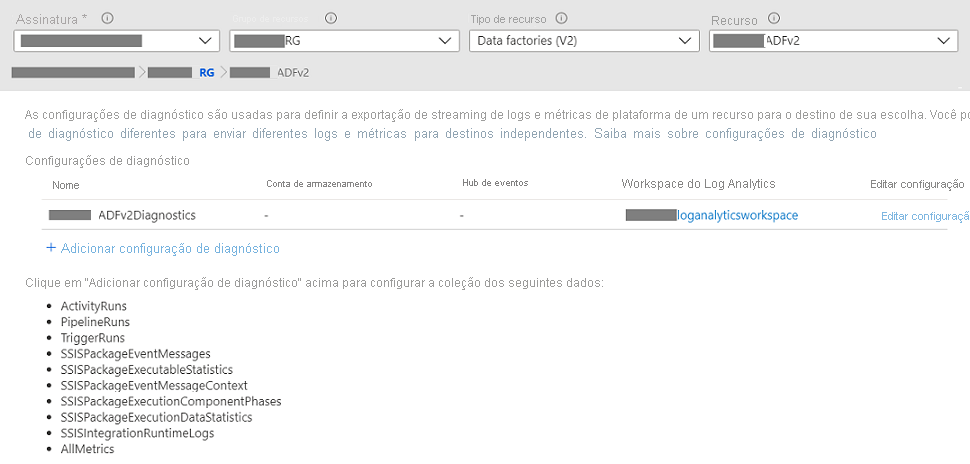

Se houver configurações no data factory, você verá uma lista de configurações já definidas no data factory. Selecione Adicionar configuração de diagnóstico.

Dê um nome à sua configuração, selecione Enviar para o log Analytics e selecione um workspace no Workspace do Log Analytics.

No modo Diagnóstico do Azure, os logs de diagnóstico fluem para a tabela AzureDiagnostics.

No modo Específico do Recurso, os logs de diagnóstico do Azure Data Factory fluem para as seguintes tabelas:

- ADFActivityRun

- ADFPipelineRun

- ADFTriggerRun

- ADFSSISIntegrationRuntimeLogs

- ADFSSISPackageEventMessageContext

- ADFSSISPackageEventMessages

- ADFSSISPackageExecutableStatistics

- ADFSSISPackageExecutionComponentPhases

- ADFSSISPackageExecutionDataStatistics

Você pode selecionar vários logs relevantes para suas cargas de trabalho para enviar para tabelas do Log Analytics. Por exemplo, se você não usar o SSIS (SQL Server Integration Services), não será necessário selecionar nenhum log do SSIS. Se você quiser registrar em log as operações de início/parada/manutenção do SSIS IR (Integration Runtime), poderá selecionar logs do SSIS IR. Se você invocar execuções de pacote SSIS via T-SQL no SSMS (SQL Server Management Studio), no SQL Server Agent ou em outras ferramentas designadas, poderá selecionar logs de pacote SSIS. Se você invocar execuções de pacote SSIS por meio de atividades de Executar Pacote SSIS em pipelines do ADF, poderá selecionar todos os logs.

Se você selecionar AllMetrics, várias métricas do Azure Data Factory serão disponibilizadas para você monitorar ou gerar alertas, incluindo as métricas para a atividade, o pipeline e as execuções de gatilho Azure Data Factory, bem como para operações do IR do SSIS e execuções de pacote do SSIS.

> [!NOTE]

> Because an Azure log table can't have more than 500 columns, Select _Resource-Specific mode_.

- Selecione Salvar.

Após alguns instantes, a nova configuração aparece na lista de configurações para esse data factory. Os logs de diagnóstico são transmitidos para esse workspace assim que os dados de evento são gerados. Podem se passar até 15 minutos entre o momento em que um evento é emitido e o momento em que ele aparece no Log Analytics.