Avaliar o painel de controle da IA responsável

Quando seu painel de IA Responsável for gerado, você poderá explorar seu conteúdo no Estúdio do Azure Machine Learning para avaliar seu modelo.

Quando você abre o painel da IA Responsável, o estúdio tenta conectá-lo automaticamente a uma instância de computação. A instância de computação fornece a computação necessária para a exploração interativa no painel.

A saída de cada componente que você adicionou ao pipeline é refletida no painel. Dependendo dos componentes que você selecionar, é possível encontrar os seguintes insights no painel do IA Responsável:

- Análise de erros

- Explicações

- Contrafactuais

- Análise de causa

Vamos explorar o que podemos analisar em cada um desses insights.

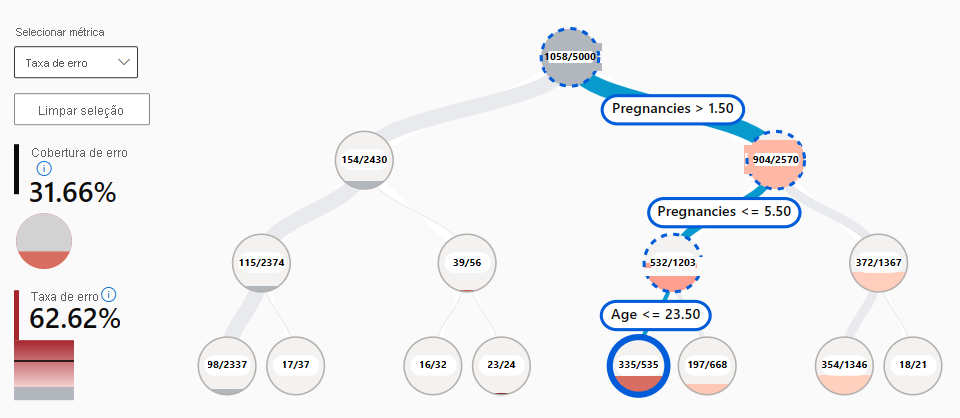

Explorar a análise de erros

Espera-se que um modelo faça previsões falsas, ou erros. Com o recurso de análise de erros no painel da IA Responsável, você pode analisar e entender como os erros estão distribuídos em seu conjunto de dados. Por exemplo, existem subgrupos ou coortes específicos no seu conjunto de dados para os quais o modelo deve fazer mais falsas previsões ?

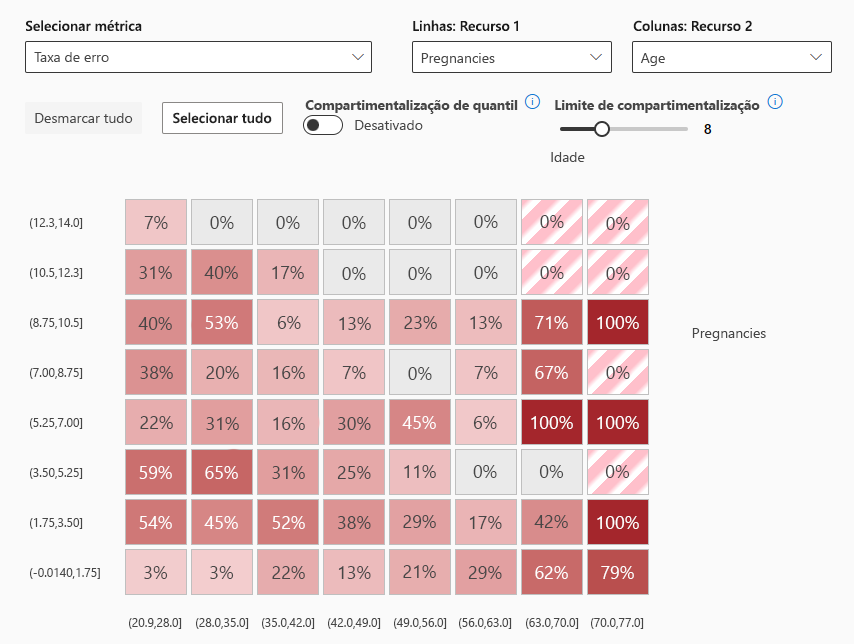

Quando você inclui a análise de erros, existem dois tipos de recursos visuais que podem ser explorados no painel da IA Responsável:

- Mapa da árvore de erros: permite que você explore qual combinação de subgrupos resulta em um modelo que faz mais previsões falsas.

- Mapa de calor de erros: apresenta uma visão geral em grade dos erros de um modelo na escala de um ou dois recursos.

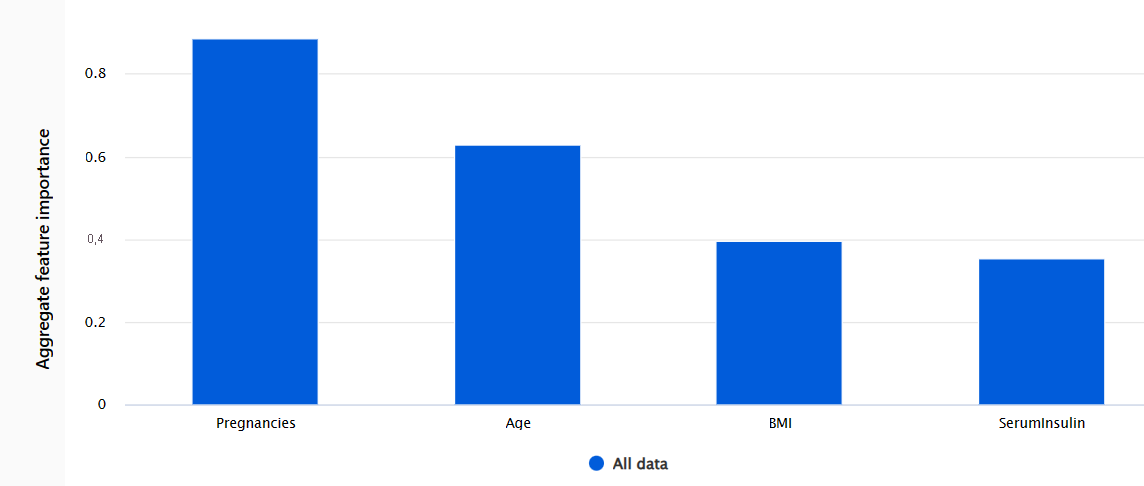

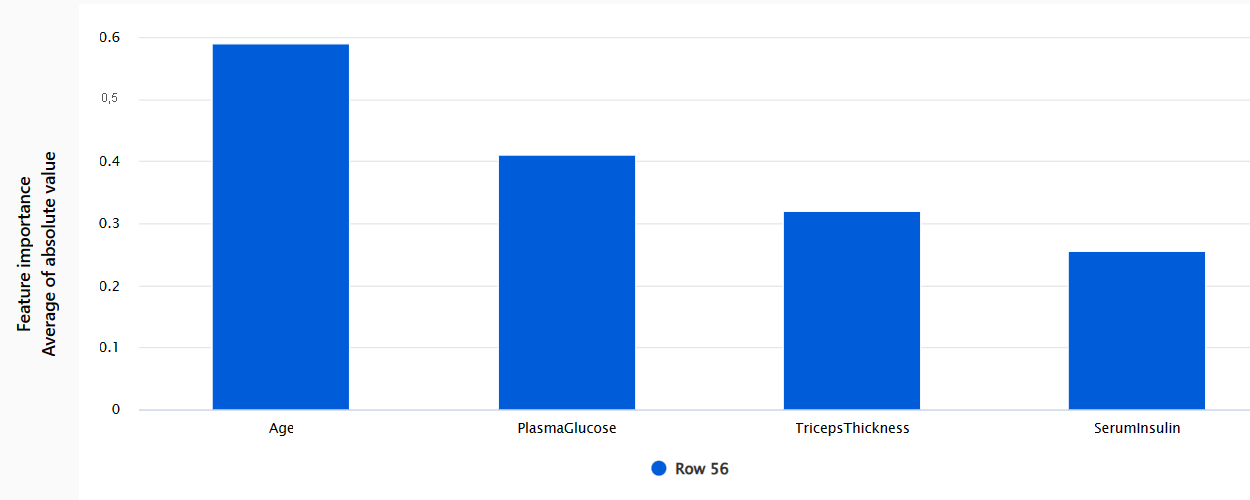

Explorar as explicações

Sempre que você utiliza um modelo para tomar decisões, você deseja entender como um modelo chega a uma determinada previsão. Sempre que você tiver treinado um modelo que seja muito complexo para entender, você pode executar o explicadores de modelos para calcular a importância do recurso. Em outras pessoas, você deseja entender como cada um dos recursos de entrada influencia a previsão do modelo.

Existem várias técnicas estatísticas que você pode usar como explicadores de modelos. Mais comumente, o explicador mimic treina um modelo interpretável simples nos mesmos dados e tarefas. Como resultado, você pode explorar dois tipos de importância de recursos:

- Importância agregada dos recursos: mostra como cada recurso nos dados de teste influencia as previsões do modelo geral.

- Importância do recurso individual: mostra como cada recurso afeta uma previsão individual.

Explorar o contrafactuais

As explicações podem lhe dar insights sobre a importância relativa dos recursos nas previsões do modelo. Às vezes, você pode querer dar um passo adiante e entender se as previsões do modelo seriam alteradas se a entrada fosse diferente. Para explorar como a saída do modelo seria alterada com base na mudança da entrada, você pode utilizar counterfactuals.

Você pode optar por explorar exemplos contrafactuais teste de hipóteses selecionando um ponto de dados e a previsão do modelo desejado para esse ponto. Quando você cria um teste de hipóteses contrafactual, o painel abre um painel para ajudar você a entender qual entrada resultaria na previsão desejada.

Explorar a análise causal

As explicações e as contrafactuais ajudam você a entender as previsões do modelo e os efeitos dos recursos nas previsões. Embora a interpretabilidade do modelo já seja um objetivo por si só, você também pode precisar de mais informações para ajudar a melhorar a tomada de decisões.

A análise causal utiliza técnicas estatísticas para estimar o efeito médio de um recurso em uma previsão desejada. Analisa como determinadas intervenções ou tratamentos podem resultar em um resultado melhor, em uma população ou em uma pessoa específica.

Existem três guias disponíveis no painel da IA Responsável ao incluir a análise causal:

- Agregação de efeitos causais: mostra os efeitos causais médios para recursos de tratamento predefinidos (os recursos que você deseja alterar para otimizar as previsões do modelo).

- Efeitos causais individuais: mostra pontos de dados de pessoas e permite alterar os recursos de tratamento para explorar sua influência na previsão.

- Política de tratamento: mostra quais partes dos seus pontos de dados se beneficiam mais de um tratamento.