Explorar os modelos de base no catálogo de modelos

A arquitetura de transformador nos permitiu treinar modelos para processamento de linguagem natural (NLP) de uma maneira mais eficiente. Em vez de processar cada token em uma frase ou sequência, a atenção permite que um modelo processe tokens em paralelo de várias maneiras.

Para treinar um modelo usando a arquitetura de transformador, você precisa usar uma grande quantidade de dados de texto como entrada. Diferentes modelos foram treinados, que diferem principalmente pelos dados nos quais foram treinados ou pela forma como implementam a atenção em suas arquiteturas. Como os modelos são treinados em grandes conjuntos de dados e os próprios modelos são grandes em tamanho, eles geralmente são chamados de Modelos de Linguagem Grande (LLMs).

Muitas LLMs são de software livre e estão disponíveis publicamente por meio de comunidades como o Hugging Face. O Azure também oferece os LLMs mais usados como modelos de base no catálogo de modelos do Azure Machine Learning. Os modelos de base são pré-treinados em textos grandes e podem ser ajustados para tarefas específicas com um conjunto de dados relativamente pequeno.

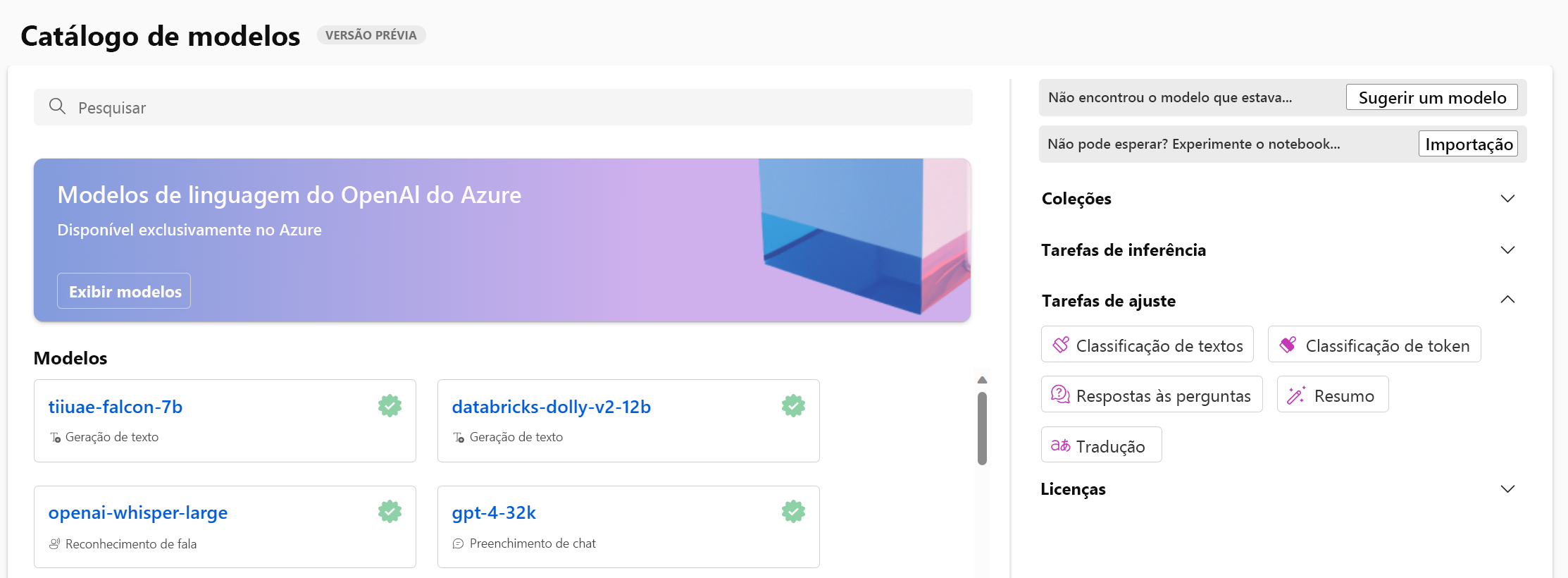

Explorar o catálogo de modelos

No Estúdio do Azure Machine Learning, você pode navegar até o catálogo de modelos para explorar todos os modelos de base disponíveis. Além disso, você pode importar qualquer modelo da biblioteca de software livre do Hugging Face para o catálogo de modelos.

Dica

O Hugging Face é uma comunidade de software livre que disponibiliza modelos para o público. Você pode encontrar todos os modelos em seus catálogos. Além disso, você pode explorar a documentação para saber mais sobre como os modelos individuais funcionam, como o BERT.

O catálogo de modelos do Azure Machine Learning integra-se a modelos do Hugging Face e outras fontes. O catálogo de modelos do Azure Machine Learning facilita a exploração, teste, ajuste e implantação de modelos.

Explorar modelos básicos

Ao selecionar um modelo no catálogo do Azure Machine Learning, você pode experimentá-lo para explorar se ele atende aos seus requisitos. Um modelo de base já é pré-treinado, e você pode implantar um modelo de base em um ponto de extremidade sem nenhum treinamento extra. Se você quiser que o modelo seja especializado em uma tarefa ou tenha um desempenho melhor sobre o conhecimento específico do domínio, também poderá optar por ajustar um modelo de base.

Os modelos de base podem ser usados para várias tarefas, incluindo:

- Classificação de texto

- Classificação de token

- Respostas às perguntas

- Resumo

- Tradução

Para escolher o modelo de base que melhor atenda às suas necessidades, você pode testar facilmente diferentes modelos no catálogo de modelos. Você também pode examinar os dados nos quais os modelos são treinados e possíveis vieses e riscos que um modelo pode ter.

Alguns modelos de base comumente usados são:

| Modelar | Descrição |

|---|---|

| BERT (Representações de codificador bidirecional de transformadores) | Focado na codificação de informações usando o contexto de antes e depois de um token (bidirecional). Normalmente usado quando você deseja ajustar um modelo para executar uma tarefa específica, como classificar texto e responder perguntas. |

| GPT (Transformador generativo pré-treinado) | Treinado para criar texto coerente e contextualmente relevante e é mais comumente usado para tarefas como geração de texto e conclusões de chat. |

| LLaMA (Meta AI de modelo de linguagem grande) | Uma família de modelos criados pelo Meta. Ao treinar modelos LLaMA, o foco tem sido fornecer mais dados de treinamento do que aumentar a complexidade dos modelos. Você pode usar modelos LLaMA para geração de texto e conclusões de chat. |

| T5 (Transformador de transferência de texto para texto) | Um modelo codificador-decodificador que usa uma abordagem de texto para texto. Ao se concentrar na conversão de texto em texto, esses tipos de modelos são ideais para tradução. |