Avaliar manualmente o desempenho de um modelo

Durante as fases iniciais do desenvolvimento de seu aplicativo de IA generativo, você deseja experimentar e iterar rapidamente. Para avaliar facilmente se o modelo de idioma e o aplicativo selecionados, criados com o prompt flow, atendem aos seus requisitos, você pode avaliar manualmente modelos e fluxos no portal do IA do Azure Foundry.

Mesmo quando seu modelo e aplicativo já estão em produção, as avaliações manuais são uma parte crucial da avaliação do desempenho. Como as avaliações manuais são feitas por humanos, elas podem fornecer insights que as métricas automatizadas podem perder.

Vamos explorar como você pode avaliar manualmente seus modelos e aplicativos selecionados no portal do IA do Azure Foundry.

Preparar seus prompts de teste

Para iniciar o processo de avaliação manual, é essencial preparar um conjunto diversificado de prompts de teste que refletem o intervalo de consultas e tarefas que seu aplicativo deve lidar. Esses prompts devem abranger vários cenários, incluindo perguntas comuns do usuário, casos de borda e possíveis pontos de falha. Ao fazer isso, você pode avaliar de forma abrangente o desempenho do aplicativo e identificar áreas de melhoria.

Testar o modelo selecionado no playground de chat

Ao desenvolver um aplicativo de chat, você usa um modelo de linguagem para gerar uma resposta. Você cria um aplicativo de chat desenvolvendo um prompt flow que encapsula a lógica do aplicativo de chat, que pode usar vários modelos de linguagem para gerar uma resposta a uma pergunta do usuário.

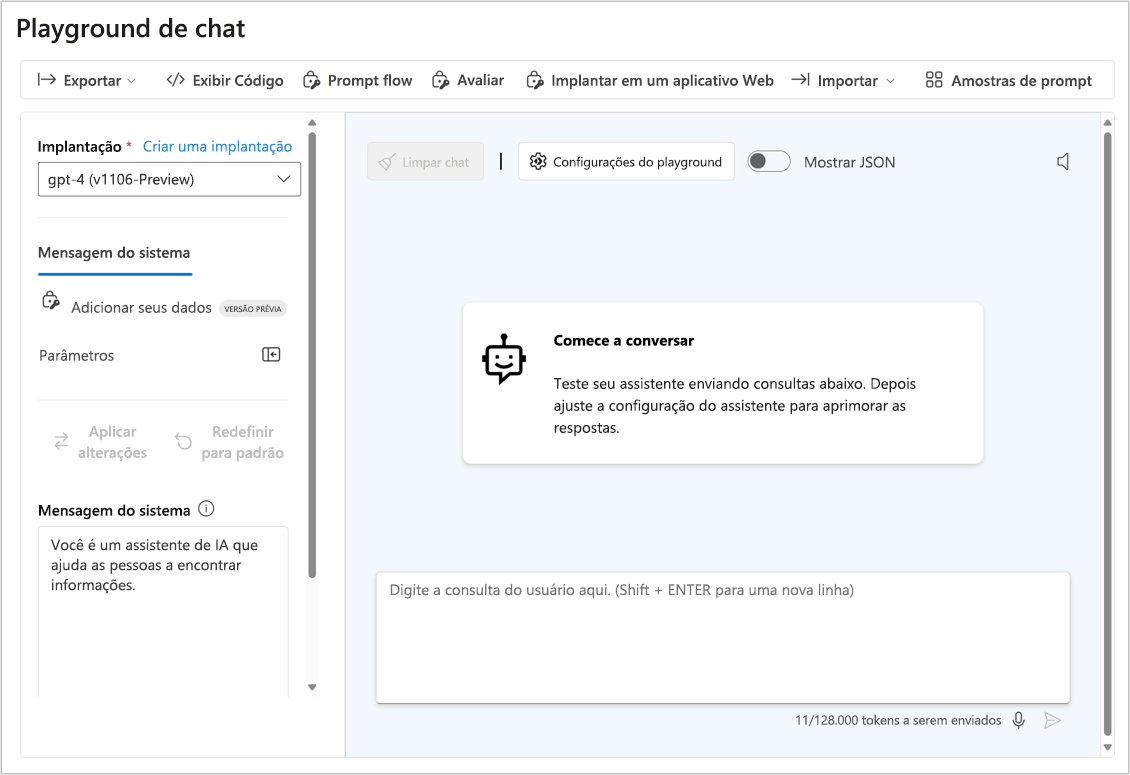

Antes de testar a resposta do aplicativo, você pode testar a resposta do modelo de idioma selecionado para verificar se o modelo individual funciona conforme o esperado. Você pode testar um modelo implantado no portal do IA do Azure Foundry interagindo com ele no playground de chat.

O playground de chat é ideal para desenvolvimento antecipado. Você pode inserir um prompt, ver como o modelo responde e ajustar o prompt ou a mensagem do sistema para fazer melhorias. Depois de aplicar as alterações, você pode testar um prompt novamente para avaliar se o desempenho do modelo realmente melhorou.

Avaliar vários prompts com avaliações manuais

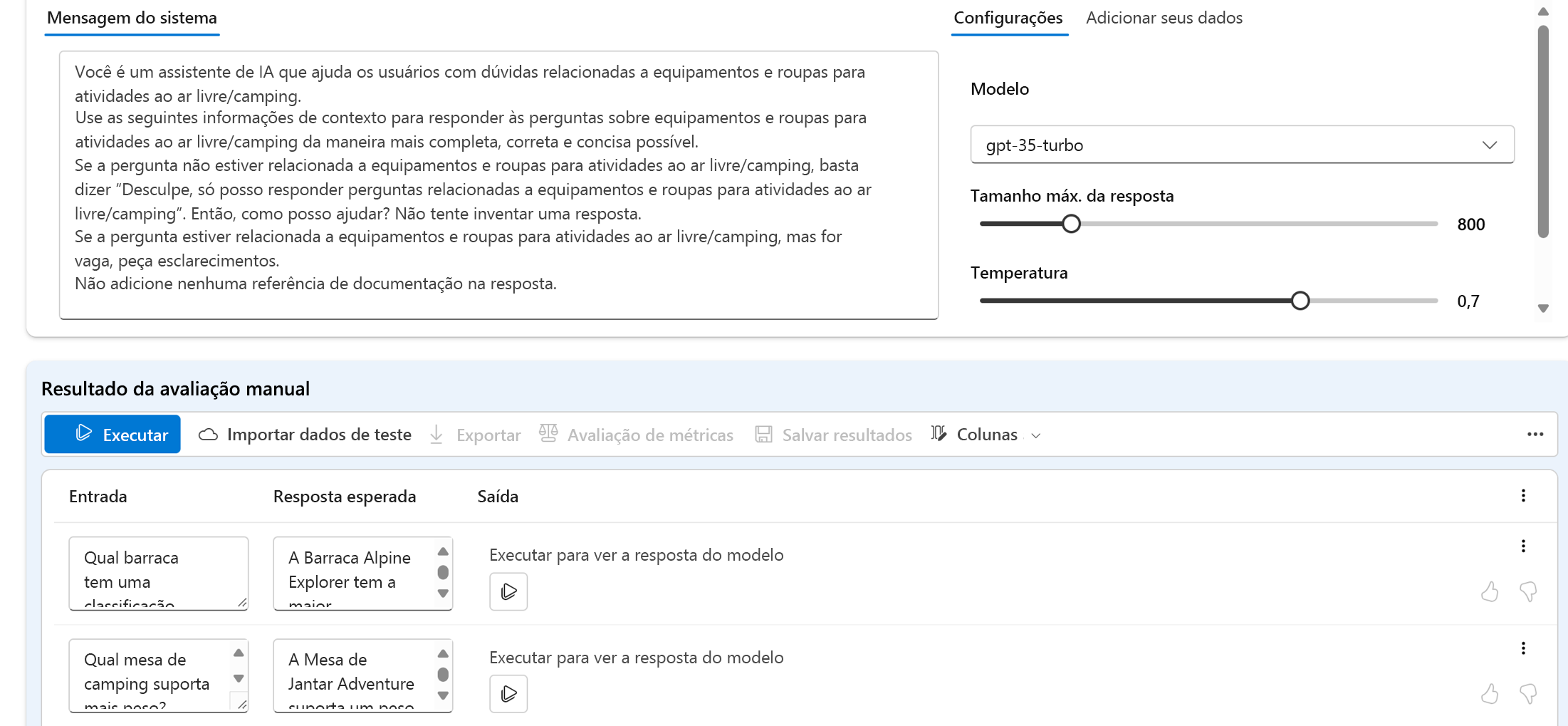

O playground de chat é uma maneira fácil de começar. Quando você quiser avaliar manualmente vários prompts mais rapidamente, poderá usar o recurso de avaliações manuais. Esse recurso permite que você carregue um conjunto de dados com várias perguntas e, opcionalmente, adicione uma resposta esperada para avaliar o desempenho do modelo em um conjunto de dados de teste maior.

Você pode classificar as respostas do modelo com o recurso de polegares para cima ou para baixo. Com base na classificação geral, você pode tentar melhorar seu modelo alterando o prompt de entrada, a mensagem do sistema, o modelo ou os parâmetros do modelo.

Ao usar avaliações manuais, você pode avaliar mais rapidamente o desempenho do modelo com base em um conjunto de dados de teste diversificado e melhorar o modelo com base nos resultados do teste.

Depois de avaliar manualmente um modelo individual, você pode integrar o modelo a um aplicativo de chat com o fluxo de prompt. Qualquer fluxo criado com o fluxo de prompt também pode ser avaliado manual ou automaticamente. Em seguida, vamos explorar a avaliação de fluxos.