Entender os componentes do Azure Data Factory

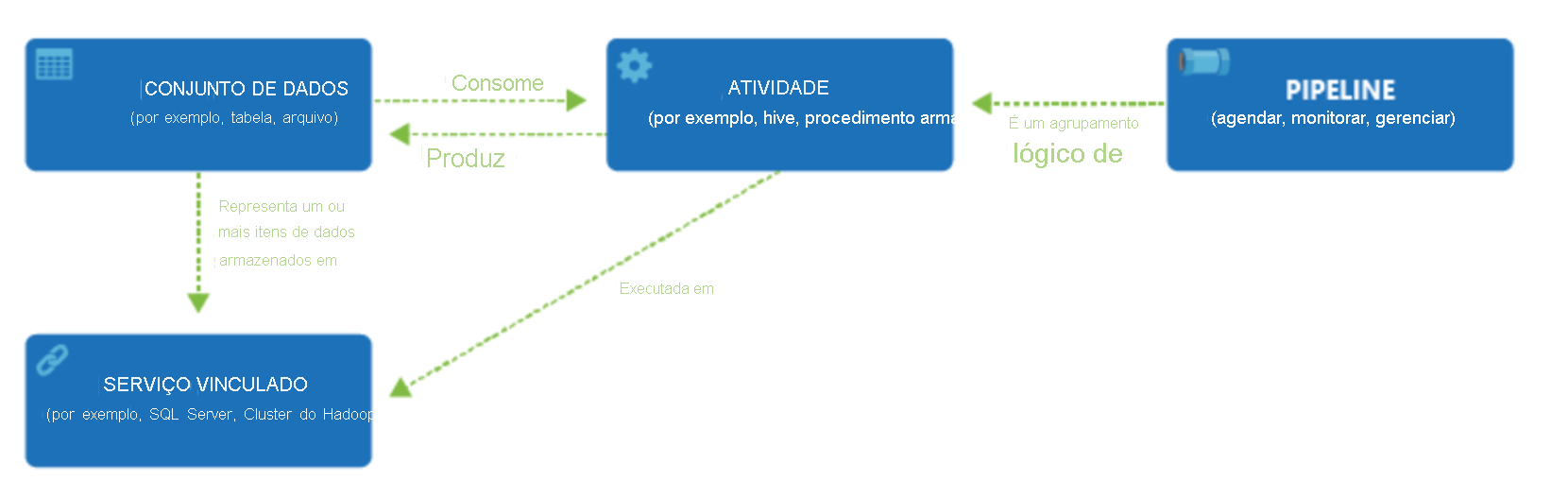

Uma assinatura do Azure poderá ter uma ou mais instâncias do Azure Data Factory. O Azure Data Factory é composto de quatro componentes principais. Esses componentes trabalham juntos para oferecer a plataforma na qual você pode compor fluxos de trabalho orientados a dados com etapas para mover e transformar dados.

O Data Factory dá suporte a uma ampla variedade de fontes de dados com as quais você pode se conectar por meio da criação de um objeto conhecido como Serviço Vinculado, o que lhe permite ingerir dados de uma fonte de dados pronta a fim de preparar os dados para transformação e/ou análise. Além disso, os Serviços Vinculados podem disparar serviços de computação sob demanda. Por exemplo, você pode ter um requisito para iniciar um cluster do HDInsight sob demanda com a finalidade de apenas processar dados por meio de uma consulta do Hive. Portanto, os Serviços Vinculados permitem que você defina as fontes de dados ou os recursos de computação necessários para ingerir e preparar os dados.

Com o Serviço Vinculado definido, o Azure Data Factory é informado sobre os conjuntos de dados que ele deve usar por meio da criação de um objeto de Conjunto de dados. Conjuntos de dados representam estruturas de dados dentro do armazenamento de dados que está sendo referenciado pelo objeto de serviço vinculado. Os conjuntos de dados também podem ser usados por um objeto do ADF conhecido como uma Atividade.

As Atividades normalmente contêm a lógica de transformação ou os comandos de análise do trabalho do Azure Data Factory. As Atividades incluem a Atividade de Cópia que pode ser usada para ingerir dados de uma série de fontes de dados. Também pode incluir o Fluxo de Dados de Mapeamento para executar transformações de dados sem código. Também pode incluir a execução de um procedimento armazenado, consulta de Hive ou script Pig para transformar os dados. Você pode enviar dados por push para um modelo de Machine Learning a fim de executar a análise. Não é incomum que várias atividades ocorram e que possam incluir a transformação de dados usando um procedimento armazenado do SQL e, em seguida, executando uma análise com o Databricks. Nesse caso, várias atividades podem ser logicamente agrupadas com um objeto referido como um pipeline, e elas podem ser agendadas para execução, ou um gatilho pode ser definido, determinando quando uma execução de pipeline precisa ser iniciada. Existem diferentes tipos de gatilhos para diferentes tipos de eventos.

O fluxo de controle é uma orquestração de atividades do pipeline que inclui o encadeamento de atividades em uma sequência, ramificação, definindo parâmetros no nível do pipeline, e passando argumentos durante a invocação do pipeline sob demanda ou por meio de um gatilho. Isso também inclui transmissão de estado personalizada e contêineres de loop e iteradores for-each.

Os Parâmetros são pares chave-valor da configuração somente leitura. Os parâmetros são definidos no pipeline. Os argumentos para os parâmetros definidos são passados durante a execução por um contexto de execução criado por um gatilho ou por um pipeline executado manualmente. As atividades no pipeline consomem os valores de parâmetro.

O Azure Data Factory tem um runtime de integração que permite a ponte entre os objetos de atividade e serviços vinculados. Ele é referenciado pelo serviço vinculado e fornece o ambiente de computação em que a atividade é executada ou da qual é expedida. Dessa forma, a atividade pode ser executada na região mais próxima possível. Há três tipos de Integration Runtime, incluindo Azure, auto-hospedado e Azure-SSIS.

Depois que todo o trabalho for concluído, você poderá usar o Data Factory para publicar o conjunto de dados final em um outro serviço vinculado que pode ser consumido por tecnologias como o Power BI ou o Machine Learning.