Iniciar a CLI do Cliente SQL no modo de gateway

Importante

O Azure HDInsight no AKS se aposentou em 31 de janeiro de 2025. Saiba mais com este comunicado.

Você precisa migrar suas cargas de trabalho para microsoft fabric ou um produto equivalente do Azure para evitar o encerramento abrupto de suas cargas de trabalho.

Importante

Esse recurso está atualmente em versão prévia. Os termos de uso complementares para o Microsoft Azure Previews incluem mais termos legais que se aplicam aos recursos do Azure que estão em versão beta, em versão prévia ou ainda não lançados em disponibilidade geral. Para obter informações sobre essa versão prévia específica, consulte Azure HDInsight em informações de visualização do AKS. Para perguntas ou sugestões de recursos, envie uma solicitação em AskHDInsight com os detalhes e siga-nos para mais atualizações na Comunidade Azure HDInsight .

Este tutorial orienta como iniciar a CLI do Cliente SQL no modo de gateway no Cluster 1.17.0 do Apache Flink no HDInsight no AKS. No modo de gateway, a CLI envia o SQL para o gateway remoto especificado para executar instruções.

./bin/sql-client.sh gateway --endpoint <gateway address>

Nota

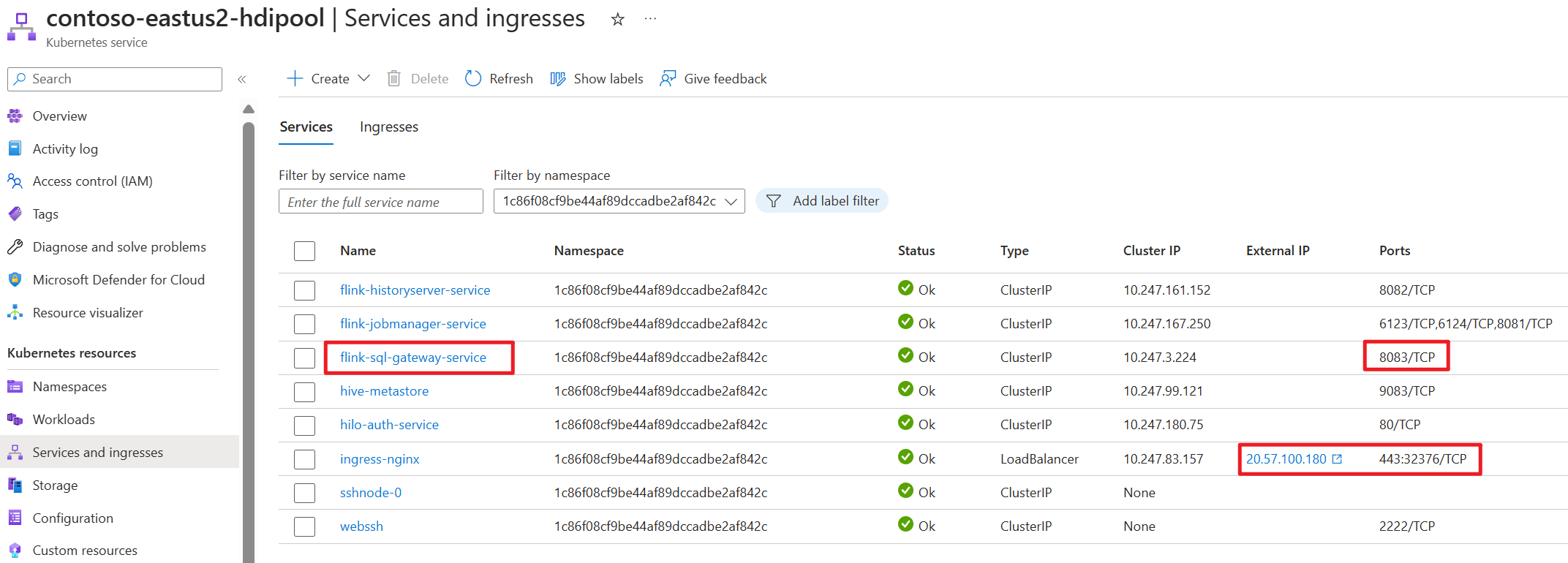

No Cluster do Apache Flink no HDInsight no AKS, qualquer conexão externa passará pela porta 443. Mas, internamente, ele redirecionará a solicitação para o serviço sql-gateway escutando a porta 8083.

Verifique o serviço de gateway SQL no lado do AKS:

O que é o CLIENTE SQL no Flink?

A API & SQL do Flink torna possível trabalhar com consultas escritas na linguagem SQL, mas essas consultas precisam ser inseridas em um programa de tabela escrito em Java ou Scala. Além disso, esses programas precisam ser empacotados com uma ferramenta de build antes de serem enviados para um cluster. Esse recurso limita o uso do Flink para programadores Java/Scala.

O Cliente SQL tem como objetivo fornecer uma maneira fácil de escrever, depurar e enviar programas de tabela para um cluster Flink sem uma única linha de código Java ou Scala. A CLI do Cliente SQL permite recuperar e visualizar resultados em tempo real do aplicativo distribuído em execução na linha de comando.

Para obter mais informações, consulte como acessar o cliente Flink SQL CLI no webssh.

O que é o Gateway de SQL no Flink

O Gateway de SQL é um serviço que permite que vários clientes do remoto executem o SQL em simultaneidade. Ele fornece uma maneira fácil de enviar o Job do Flink, consultar os metadados e analisar os dados online.

Para obter mais informações, consulte Gateway SQL .

Iniciar a CLI do Cliente SQL no modo de gateway no Flink-cli

No Cluster do Apache Flink no HDInsight no AKS, inicie o cliente SQL em modo gateway executando o comando:

./bin/sql-client.sh gateway --endpoint host:port

or

./bin/sql-client.sh gateway --endpoint https://fqdn/sql-gateway

Obtenha o endpoint de cluster (host ou fqdn) no portal do Azure.

Teste

Preparação

Baixar a CLI do Flink

- Baixe a CLI do Flink de https://aka.ms/hdionaksflink117clilinux no computador Windows local.

Instale o Subsistema do Windows para Linux para fazer isso funcionar no computador Windows local.

Abra o prompt de comando do Windows e execute o seguinte comando (substituindo JAVA_HOME e o caminho do flink-cli pelos seus próprios valores) para baixar o flink-cli:

Windows Subsystem for Linux --distribution Ubuntu export JAVA_HOME=/mnt/c/Work/99_tools/zulu11.56.19-ca-jdk11.0.15-linux_x64 cd <folder> wget https://hdiconfigactions.blob.core.windows.net/hiloflink17blob/flink-cli.tgz tar -xvf flink-cli.tgzDefina o endpoint, o tenant ID e a porta 443 no flink-conf.yaml

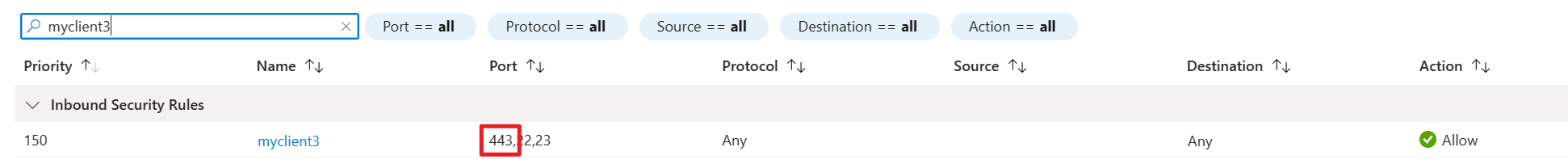

user@MININT-481C9TJ:/mnt/c/Users/user/flink-cli$ cd conf user@MININT-481C9TJ:/mnt/c/Users/user/flink-cli/conf$ ls -l total 8 -rwxrwxrwx 1 user user 2451 Feb 26 20:33 flink-conf.yaml -rwxrwxrwx 1 user user 2946 Feb 23 14:13 log4j-cli.properties user@MININT-481C9TJ:/mnt/c/Users/user/flink-cli/conf$ cat flink-conf.yaml rest.address: <flink cluster endpoint on Azure portal> azure.tenant.id: <tenant ID> rest.port: 443Permitir o IP público local do Windows com a porta 443 e VPN habilitada para o HDInsight na entrada de segurança de rede da sub-rede do cluster AKS.

Execute o sql-client.sh no modo gateway no Flink-cli para utilizar o Flink SQL.

bin/sql-client.sh gateway --endpoint https://fqdn/sql-gatewayExemplo

user@MININT-481C9TJ:/mnt/c/Users/user/flink-cli$ bin/sql-client.sh gateway --endpoint https://fqdn/sql-gateway ▒▓██▓██▒ ▓████▒▒█▓▒▓███▓▒ ▓███▓░░ ▒▒▒▓██▒ ▒ ░██▒ ▒▒▓▓█▓▓▒░ ▒████ ██▒ ░▒▓███▒ ▒█▒█▒ ░▓█ ███ ▓░▒██ ▓█ ▒▒▒▒▒▓██▓░▒░▓▓█ █░ █ ▒▒░ ███▓▓█ ▒█▒▒▒ ████░ ▒▓█▓ ██▒▒▒ ▓███▒ ░▒█▓▓██ ▓█▒ ▓█▒▓██▓ ░█░ ▓░▒▓████▒ ██ ▒█ █▓░▒█▒░▒█▒ ███▓░██▓ ▓█ █ █▓ ▒▓█▓▓█▒ ░██▓ ░█░ █ █▒ ▒█████▓▒ ██▓░▒ ███░ ░ █░ ▓ ░█ █████▒░░ ░█░▓ ▓░ ██▓█ ▒▒▓▒ ▓███████▓░ ▒█▒ ▒▓ ▓██▓ ▒██▓ ▓█ █▓█ ░▒█████▓▓▒░ ██▒▒ █ ▒ ▓█▒ ▓█▓ ▓█ ██▓ ░▓▓▓▓▓▓▓▒ ▒██▓ ░█▒ ▓█ █ ▓███▓▒░ ░▓▓▓███▓ ░▒░ ▓█ ██▓ ██▒ ░▒▓▓███▓▓▓▓▓██████▓▒ ▓███ █ ▓███▒ ███ ░▓▓▒░░ ░▓████▓░ ░▒▓▒ █▓ █▓▒▒▓▓██ ░▒▒░░░▒▒▒▒▓██▓░ █▓ ██ ▓░▒█ ▓▓▓▓▒░░ ▒█▓ ▒▓▓██▓ ▓▒ ▒▒▓ ▓█▓ ▓▒█ █▓░ ░▒▓▓██▒ ░▓█▒ ▒▒▒░▒▒▓█████▒ ██░ ▓█▒█▒ ▒▓▓▒ ▓█ █░ ░░░░ ░█▒ ▓█ ▒█▓ ░ █░ ▒█ █▓ █▓ ██ █░ ▓▓ ▒█▓▓▓▒█░ █▓ ░▓██░ ▓▒ ▓█▓▒░░░▒▓█░ ▒█ ██ ▓█▓░ ▒ ░▒█▒██▒ ▓▓ ▓█▒ ▒█▓▒░ ▒▒ █▒█▓▒▒░░▒██ ░██▒ ▒▓▓▒ ▓██▓▒█▒ ░▓▓▓▓▒█▓ ░▓██▒ ▓░ ▒█▓█ ░░▒▒▒ ▒▓▓▓▓▓▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒▒░░▓▓ ▓░▒█░ ______ _ _ _ _____ ____ _ _____ _ _ _ BETA | ____| (_) | | / ____|/ __ \| | / ____| (_) | | | |__ | |_ _ __ | | __ | (___ | | | | | | | | |_ ___ _ __ | |_ | __| | | | '_ \| |/ / \___ \| | | | | | | | | |/ _ \ '_ \| __| | | | | | | | | < ____) | |__| | |____ | |____| | | __/ | | | |_ |_| |_|_|_| |_|_|\_\ |_____/ \___\_\______| \_____|_|_|\___|_| |_|\__| Welcome! Enter 'HELP;' to list all available commands. 'QUIT;' to exit. Command history file path: /home/user/.flink-sql-historyAntes de consultar qualquer tabela com origem externa, prepare os arquivos JAR relacionados. Nos exemplos a seguir, são consultadas a tabela Kafka e a tabela MySQL no Flink SQL. Faça o download do arquivo jar e coloque-o no armazenamento do Azure Data Lake Storage gen2, anexado ao cluster Flink.

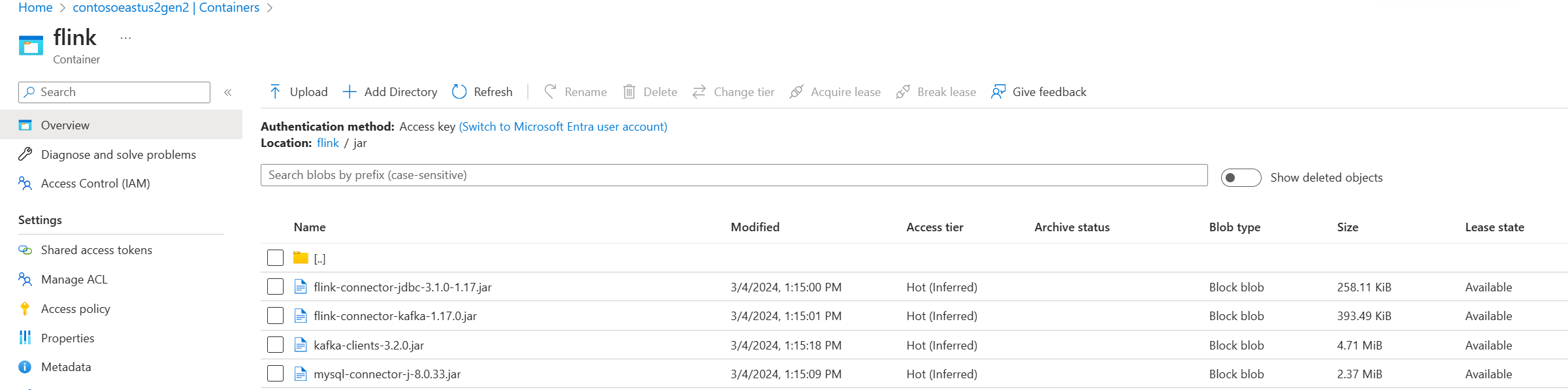

Jars no Azure Data Lake Storage gen2 no portal do Azure:

Use a tabela já criada e coloque-a no metastore do Hive para gerenciamento e execute a consulta.

Nota

Neste exemplo, todos os jars no HDInsight em AKS têm como armazenamento padrão o Azure Data Lake Storage Gen2. O contêiner e a conta de armazenamento não precisam ser iguais aos especificados durante a criação do cluster. Se necessário, você pode especificar outra conta de armazenamento e conceder à identidade gerenciada pelo usuário do cluster a função de proprietário de dados do blob de armazenamento no lado do Azure Data Lake Storage Gen2.

CREATE CATALOG myhive WITH ( 'type' = 'hive' ); USE CATALOG myhive; // ADD jar into environment ADD JAR 'abfs://<container>@<storage name>.dfs.core.windows.net/jar/flink-connector-jdbc-3.1.0-1.17.jar'; ADD JAR 'abfs://<container>@<storage name>.dfs.core.windows.net/jar/mysql-connector-j-8.0.33.jar'; ADD JAR 'abfs://<container>@<storage name>.dfs.core.windows.net/jar/kafka-clients-3.2.0.jar'; ADD JAR 'abfs://<container>@<storage name>.dfs.core.windows.net/jar/flink-connector-kafka-1.17.0.jar'; Flink SQL> show jars; ----------------------------------------------------------------------------------------------+ | jars | +----------------------------------------------------------------------------------------------+ | abfs://<container>@<storage name>.dfs.core.windows.net/jar/flink-connector-kafka-1.17.0.jar | | abfs://<container>@<storage name>.dfs.core.windows.net/jar/flink-connector-jdbc-3.1.0-1.17.jar | | abfs://<container>@<storage name>.dfs.core.windows.net/jar/kafka-clients-3.2.0.jar | | abfs://<container>@<storage name>.dfs.core.windows.net/jar/mysql-connector-j-8.0.33.jar | +----------------------------------------------------------------------------------------------+ 4 rows in set Flink SQL> SET 'sql-client.execution.result-mode' = 'tableau'; [INFO] Execute statement succeed. Flink SQL> show tables; +----------------------+ | table name | +----------------------+ | flightsintervaldata1 | | kafka_user_orders | | kafkatable | | mysql_user_orders | | orders | +----------------------+ 5 rows in set // mysql cdc table Flink SQL> select * from mysql_user_orders; +----+-------------+----------------------------+-------------+--------------------------------+--------------+-------------+--------------+ | op | order_id | order_date | customer_id | customer_name | price | product_id | order_status | +----+-------------+----------------------------+-------------+--------------------------------+--------------+-------------+--------------+ | +I | 10001 | 2023-07-16 10:08:22.000000 | 1 | Jark | 50.00000 | 102 | FALSE | | +I | 10002 | 2023-07-16 10:11:09.000000 | 2 | Sally | 15.00000 | 105 | FALSE | | +I | 10003 | 2023-07-16 10:11:09.000000 | 3 | Sally | 25.00000 |

Referência

CLI (Interface Command-Line do Apache Flink®) no HDInsight em clusters do AKS