Adicionar o Apache Kafka como origem no Hub em Tempo Real (versão prévia)

Este artigo descreve como adicionar o Apache Kafka como fonte de eventos no Hub em Tempo Real do Fabric.

Pré-requisitos

- Acesso a um workspace no modo de licença de capacidade do Fabric (ou) no modo de licença de Avaliação com permissões de Colaborador ou superior.

- Um cluster do Apache Kafka em execução.

- O Apache Kafka deve ser acessível publicamente e não estar atrás de um firewall ou protegido em uma rede virtual.

Página fontes de dados

Entre no Microsoft Fabric.

Selecione Tempo Real na barra de navegação esquerda.

Na página Hub em Tempo Real, selecione + Fontes de dados em Conectar-se a no menu de navegação à esquerda. Você também pode acessar a página Fontes de dados nas páginas Todos os fluxos de dados ou Meus fluxos de dados, selecionando o botão + Conectar fonte de dados no canto superior direito.

Adicionar o Apache Kafka como origem

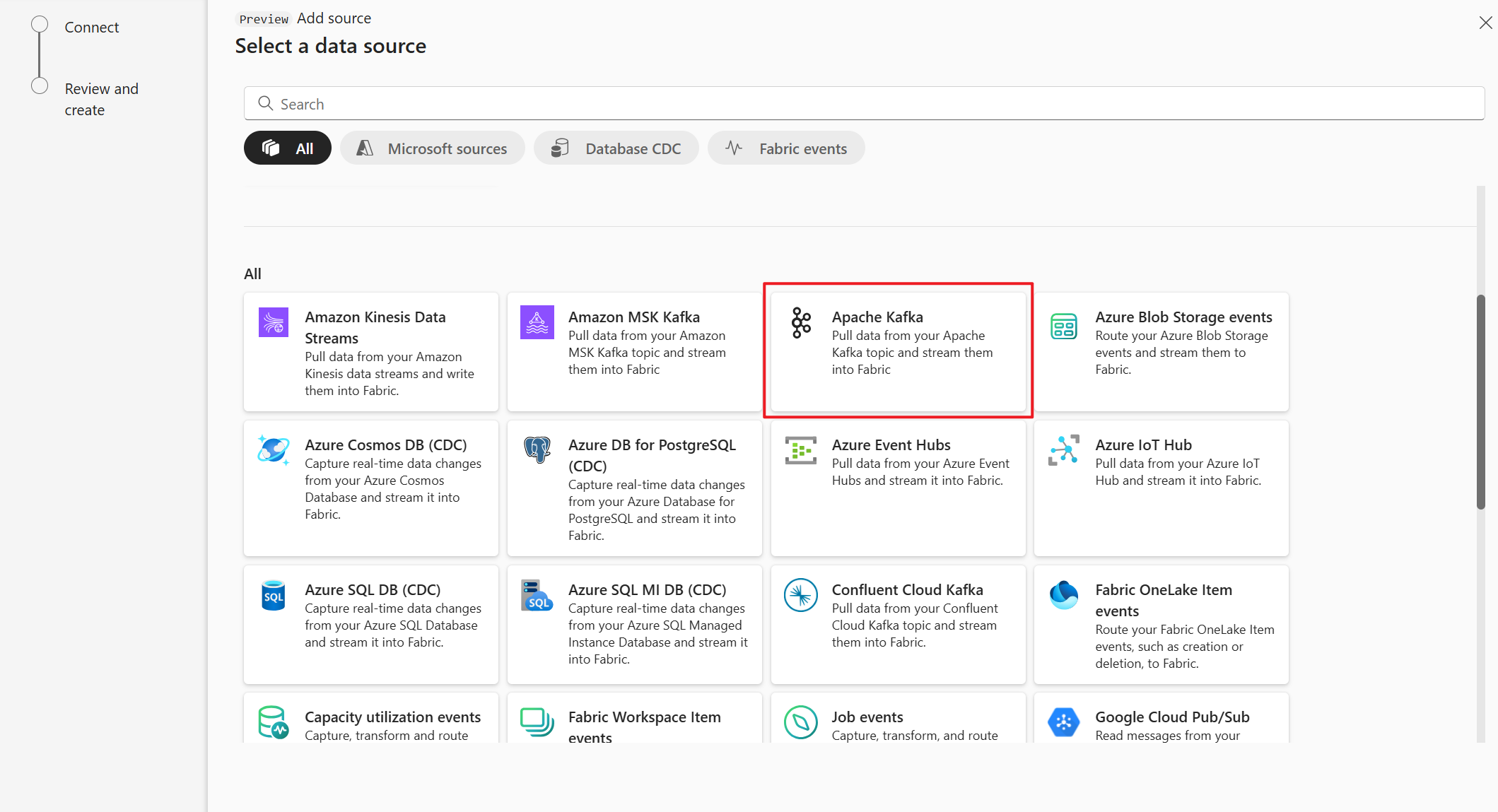

Na página Selecionar uma fonte de dados, selecione apache Kafka.

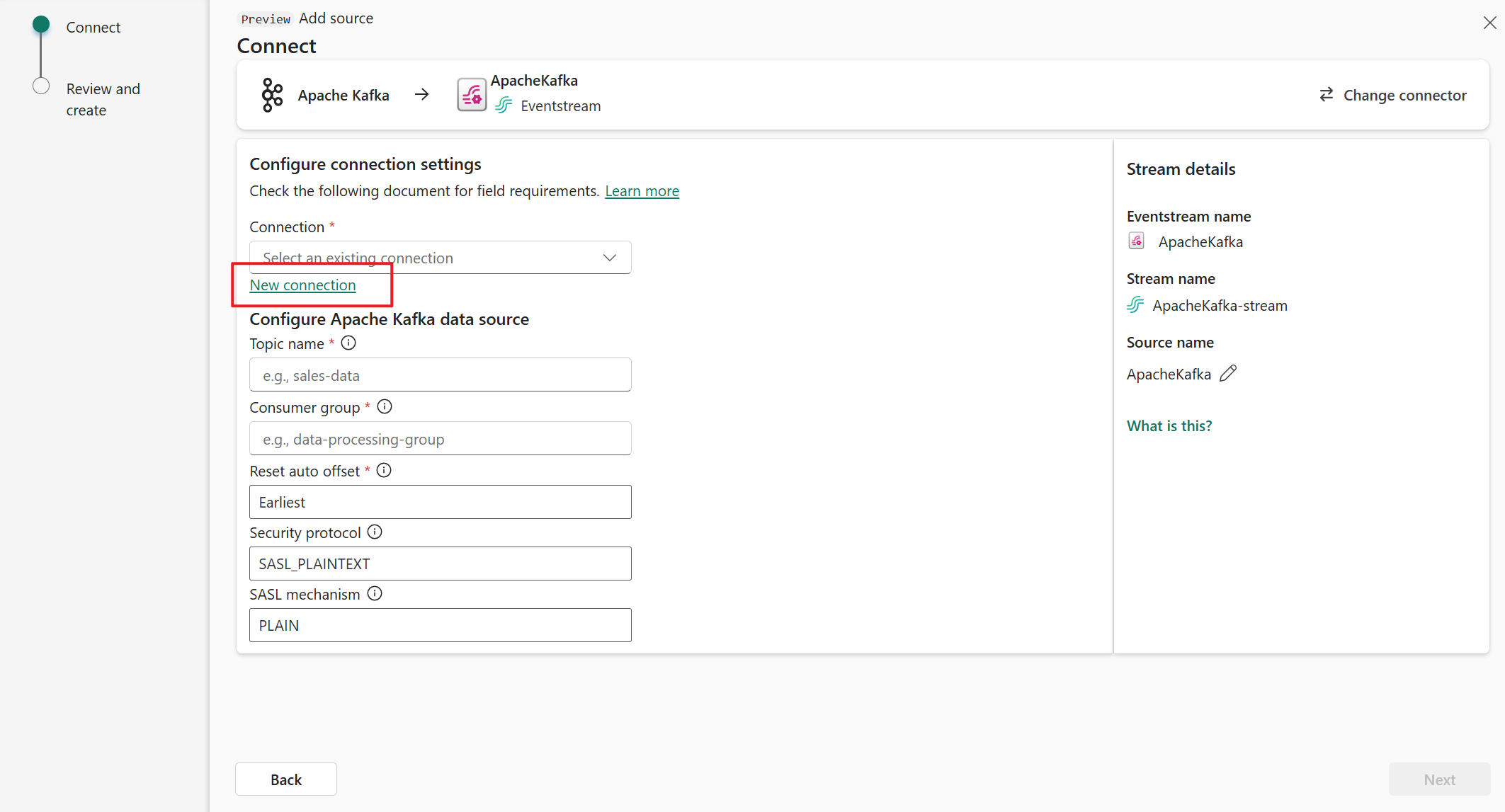

Na página Conectar, selecione Nova conexão.

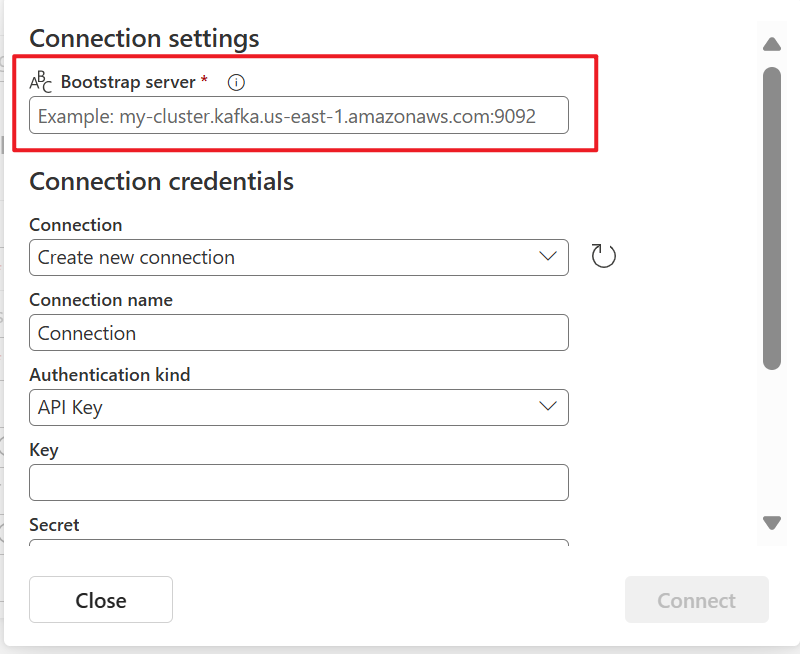

Na seção Configurações de conexão, em Servidor Bootstrap, insira o endereço do servidor Apache Kafka.

Na seção Credenciais de conexão, se você tiver uma conexão existente com o cluster do Apache Kafka, selecione-a na lista suspensa para Conexão. Caso contrário, siga estas etapas:

- Em Nome da conexão, insira um nome para a conexão.

- Em Tipo de autenticação, confirme se a Chave de API está selecionada.

- Em Chave e Segredo, insira a chave de API e o segredo da chave.

Selecione Conectar.

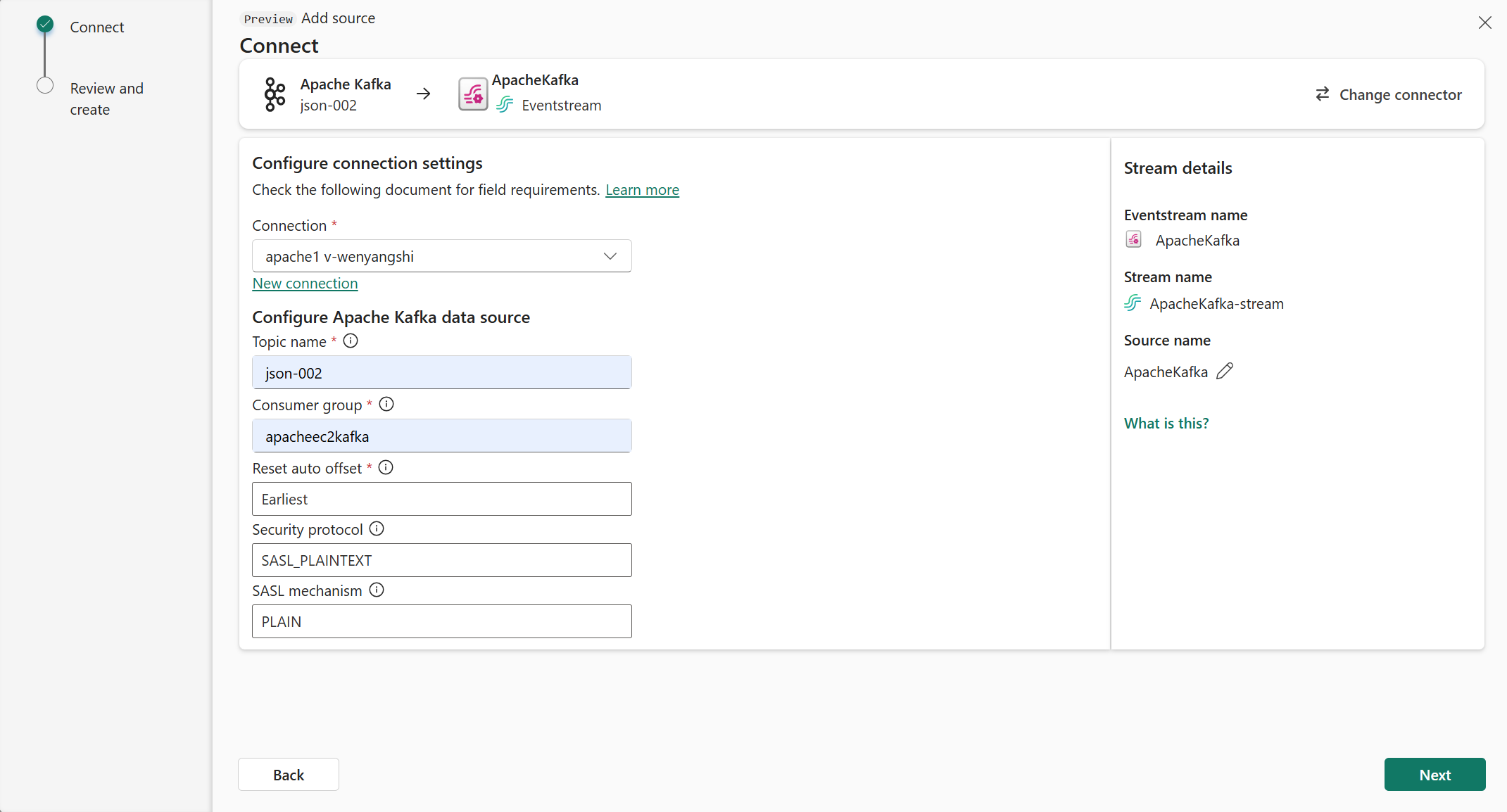

Agora, na página Conectar, siga estas etapas.

Em Tópico, insira o tópico Kafka.

Em Grupo de consumidores, insira o grupo de consumidores do cluster do Apache Kafka. Esse campo fornece um grupo de consumidores dedicado para obter eventos.

Selecione Redefinir deslocamento automático para especificar onde começar a ler os deslocamentos, se não houver confirmação.

Em Protocolo de segurança, o valor padrão é SASL_PLAINTEXT.

Observação

No momento, a origem do Apache Kafka dá suporte apenas à transmissão de dados não criptografada (SASL_PLAINTEXT e PLAINTEXT) entre o cluster do Apache Kafka e o Eventstream. O suporte para transmissão de dados criptografados via SSL estará disponível em breve.

O mecanismo SASL padrão normalmente é PLAIN, a menos que configurado de outra forma. Você pode selecionar o mecanismo SCRAM-SHA-256 ou SCRAM-SHA-512 que atende aos seus requisitos de segurança.

Selecione Avançar. Na tela Revisar e criar, revise o resumo e selecione Adicionar.

Exibir detalhes do fluxo de dados

Na página Examinar e conectar, se você selecionar Abrir Eventstream, o assistente abrirá o Eventstream criado para você com a origem do Apache Kafka selecionada. Para fechar o assistente, selecione Fechar na parte inferior da página.

No hub em tempo real, mude para a guia Fluxos de dados do hub em tempo real. Atualize a página. O fluxo de dados criado para você é exibido.

Para obter etapas detalhadas, confira View details of data streams in Fabric Real-Time hub.

Conteúdo relacionado

Para saber mais sobre consumo de fluxos de dados, confira os seguintes artigos: