Copiar de Armazenamento de Blobs do Azure para Lakehouse

Neste tutorial, você criará um pipeline de dados para mover um arquivo CSV de uma pasta de entrada de uma fonte de Armazenamento de Blobs do Azure para um destino do lakehouse.

Pré-requisitos

Para começar, você deve concluir os seguintes pré-requisitos:

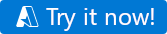

Verifique se você tem um espaço de trabalho habilitado para o Project Microsoft Fabric: Criar um espaço de trabalho.

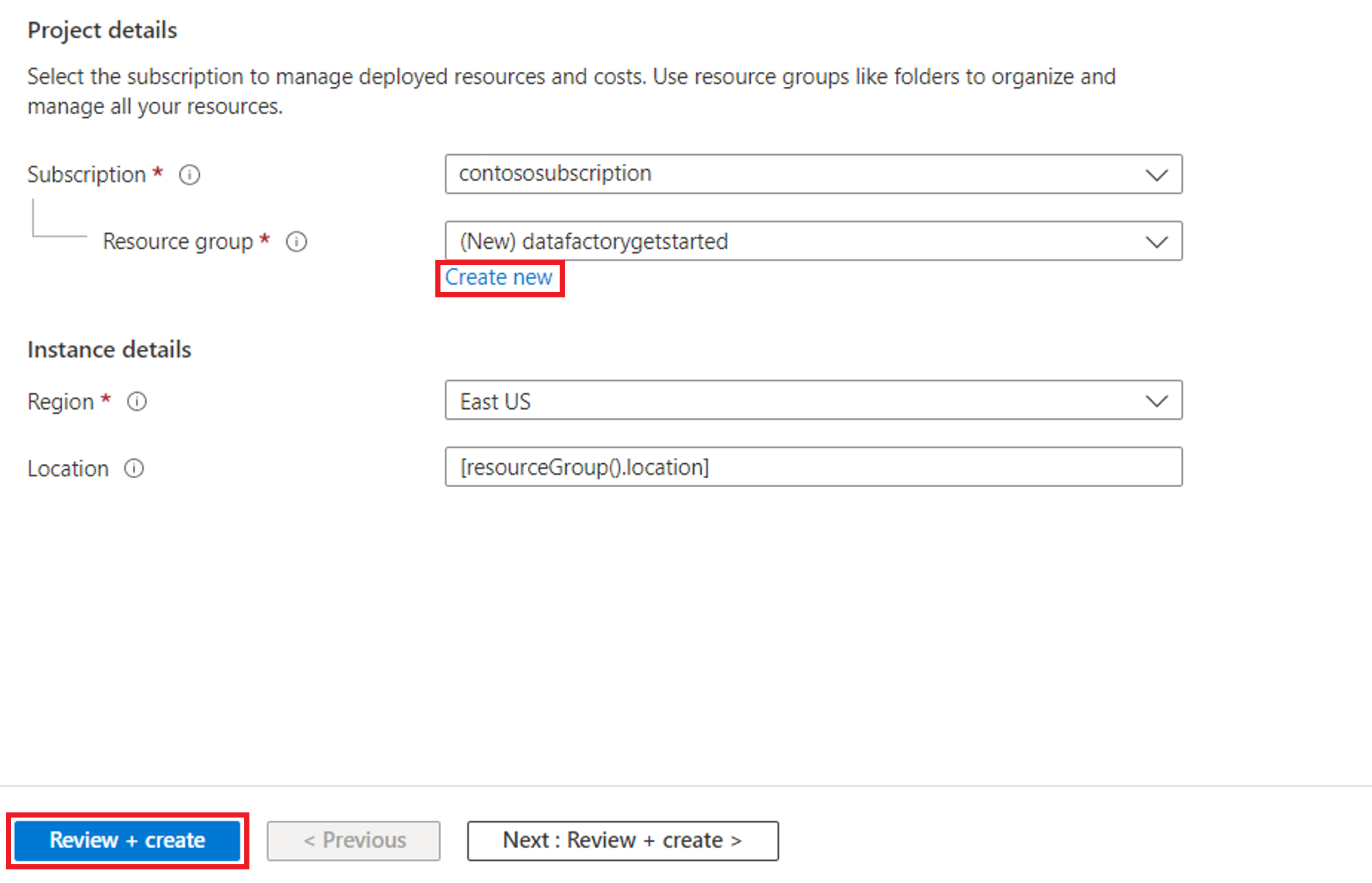

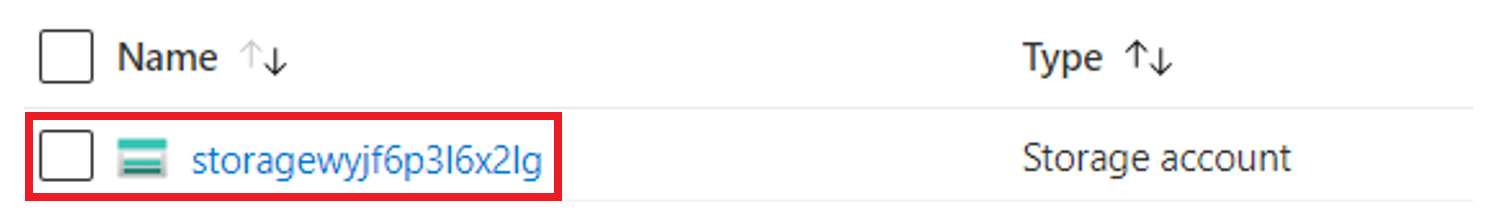

Selecione o botão Experimentar agora! para preparar a fonte de dados do Armazenamento de Blobs do Azure da cópia. Crie um novo grupo de recursos para este Armazenamento de Blobs do Azure e selecione Examinar + Criar>Criar.

Em seguida, um Armazenamento de Blobs do Azure é criado e moviesDB2.csv é carregado na pasta de entrada do Armazenamento de Blobs do Azure criado.

Criar um pipeline de dados

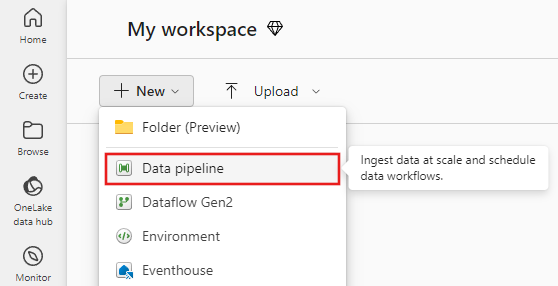

Alterne para Data factory na página app.powerbi.com.

Crie um novo espaço de trabalho para essa demonstração.

Selecione Novo e, em seguida, selecione Pipeline de dados.

Copiar dados usando o Assistente de Cópia

Nesta sessão, você começará a criar um pipeline de dados usando as etapas a seguir. Essas etapas copiam um arquivo CSV de uma pasta de entrada de um Armazenamento de Blobs do Azure para um destino lakehouse usando a cópia assistente.

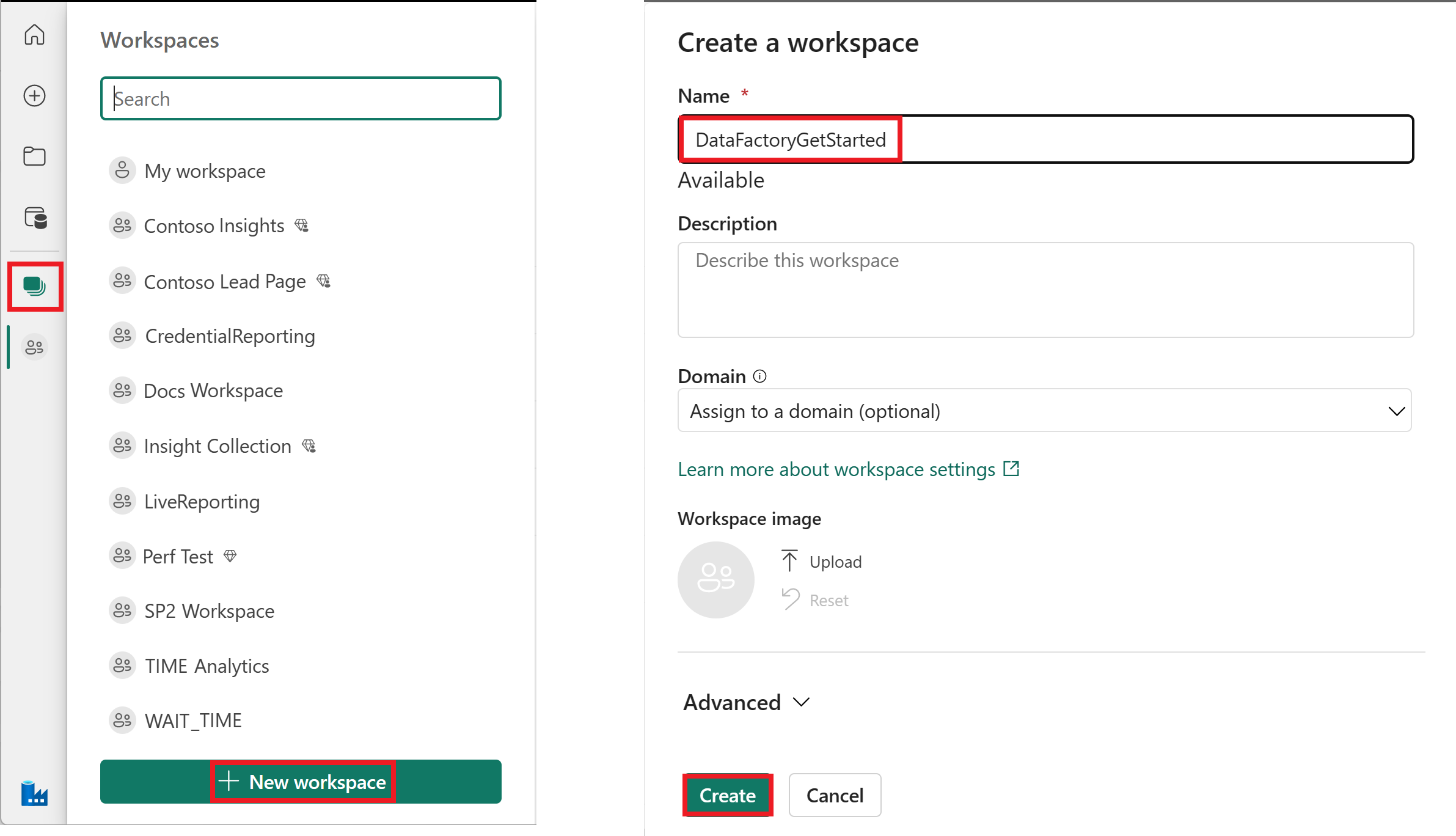

Etapa 1: Começar com a cópia assistente

Selecione Assistente de cópia de dados na tela para abrir a ferramenta de assistente de cópia para começar. Ou selecione Usar o assistente de cópia na lista suspensa Copiar dados na guia Atividades da faixa de opções.

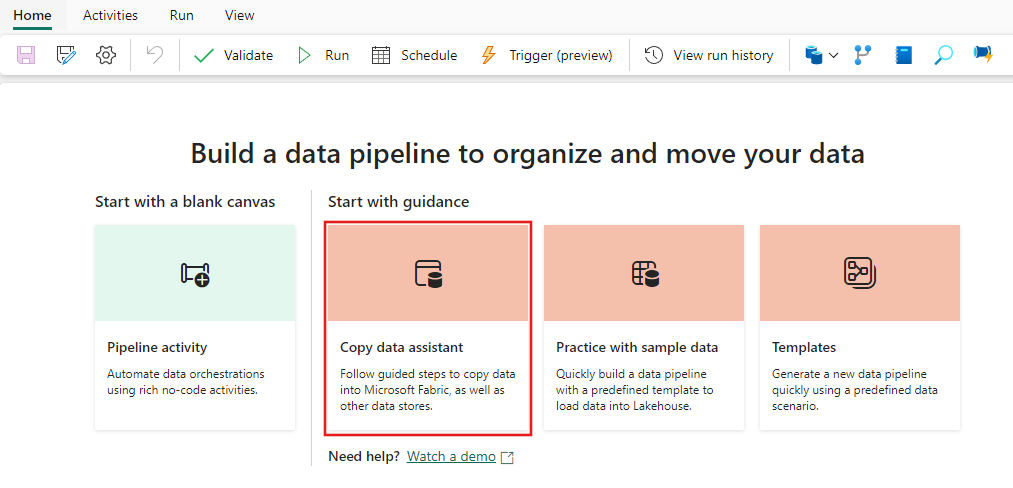

Etapa 2: Configure sua fonte

Digite blob no filtro de seleção, selecione Blobs do Azure e selecione Avançar.

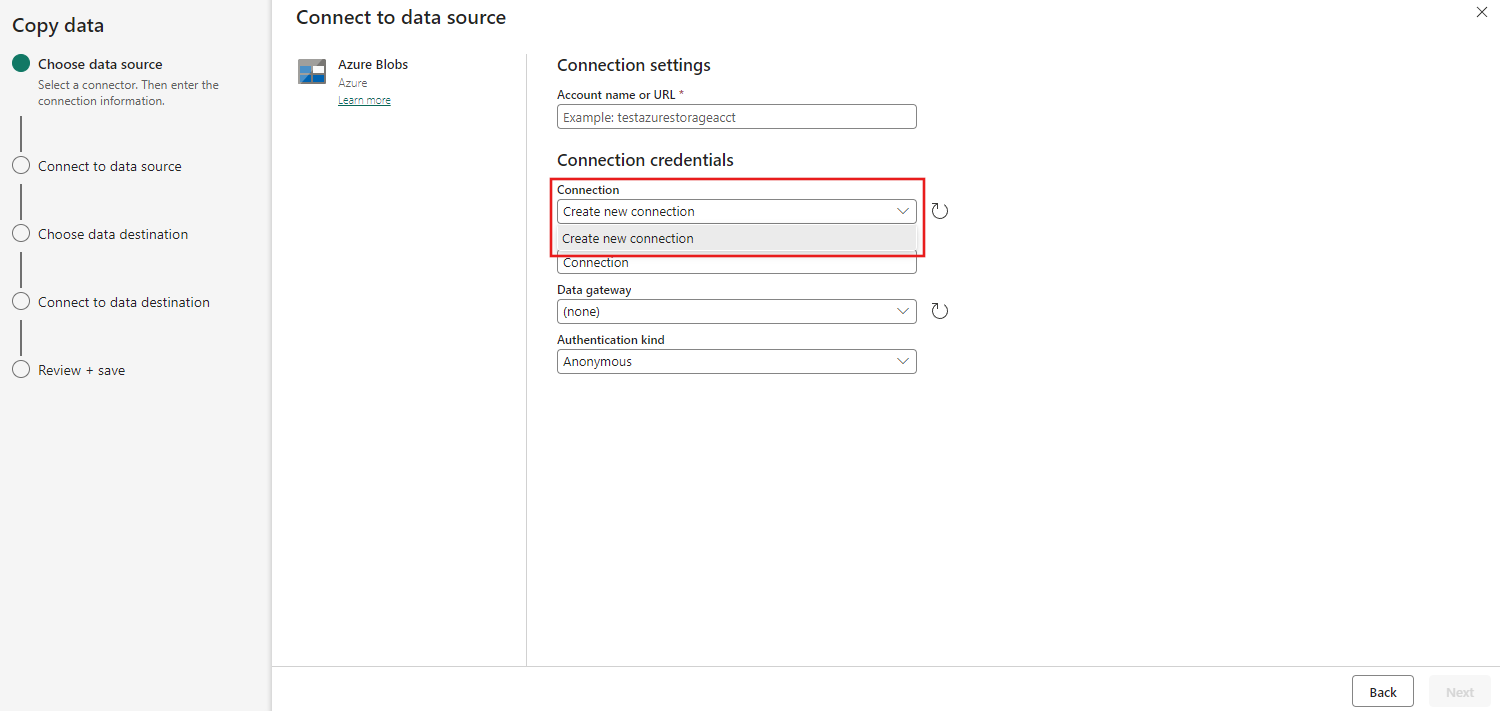

Forneça o nome da conta ou URL e crie uma conexão com sua fonte de dados selecionando Criar nova conexão na lista suspensa Conexão.

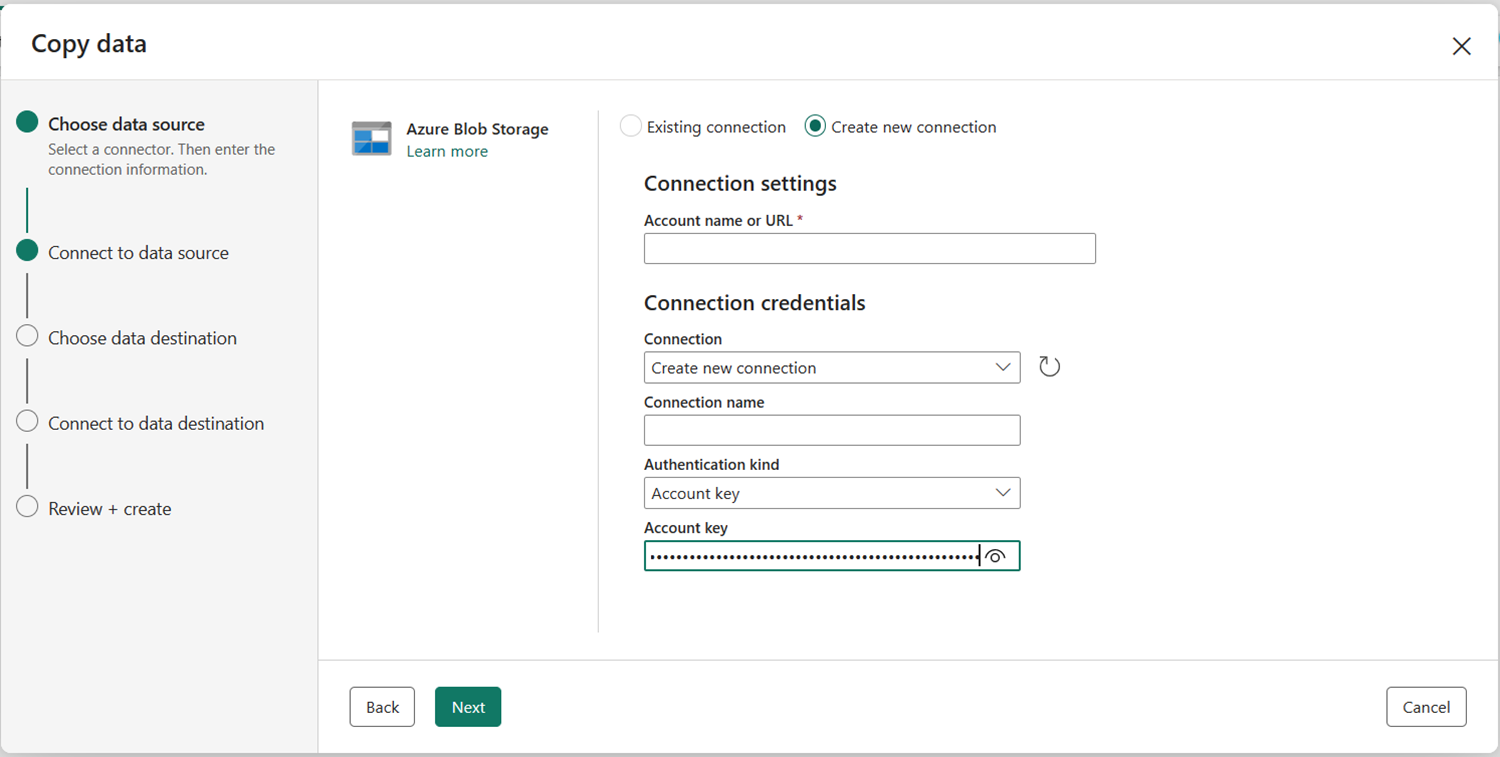

Depois de selecionar Criar nova conexão com a conta de armazenamento especificada, você só precisará preencher o Tipo de autenticação. Nesta demonstração, escolheremos Chave de conta, mas você poderá escolher outro Tipo de autenticação de acordo com suas preferências.

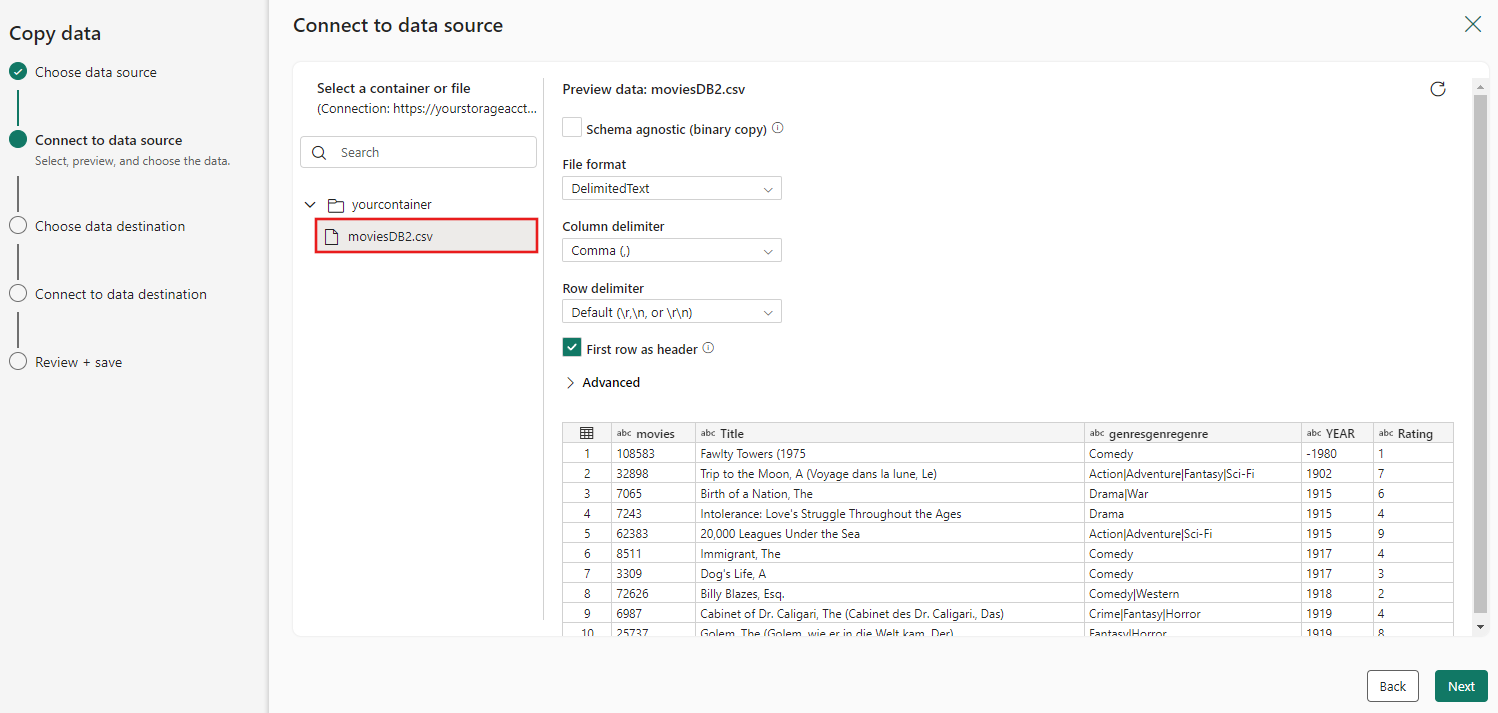

Depois que a conexão for criada com êxito, você só precisará selecionar Avançar para Conectar à fonte de dados.

Escolha o arquivo moviesDB2.csv na configuração de origem a ser visualizada e selecione Avançar.

Etapa 3: Configure seu destino

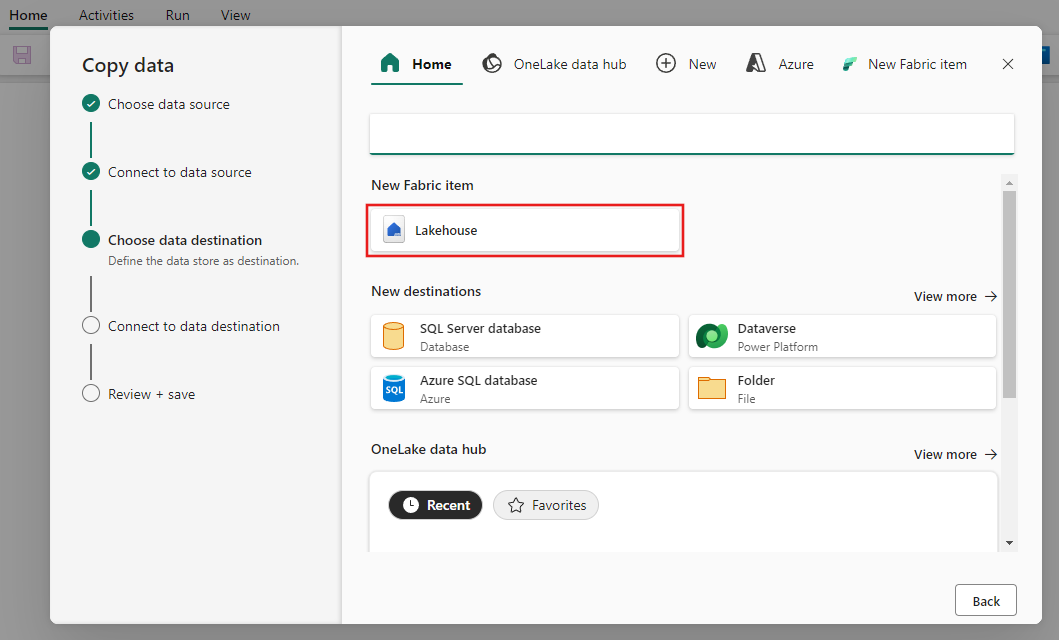

Selecione Lakehouse.

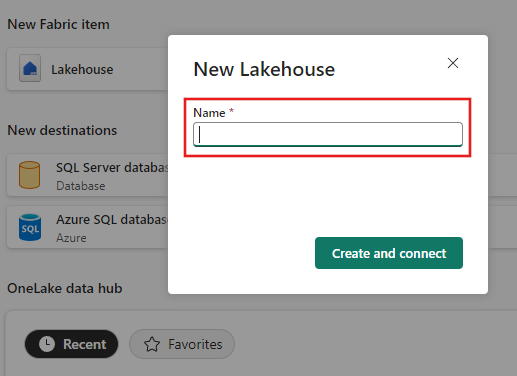

Forneça um nome para o novo Lakehouse. Em seguida, selecione Criar e conectar.

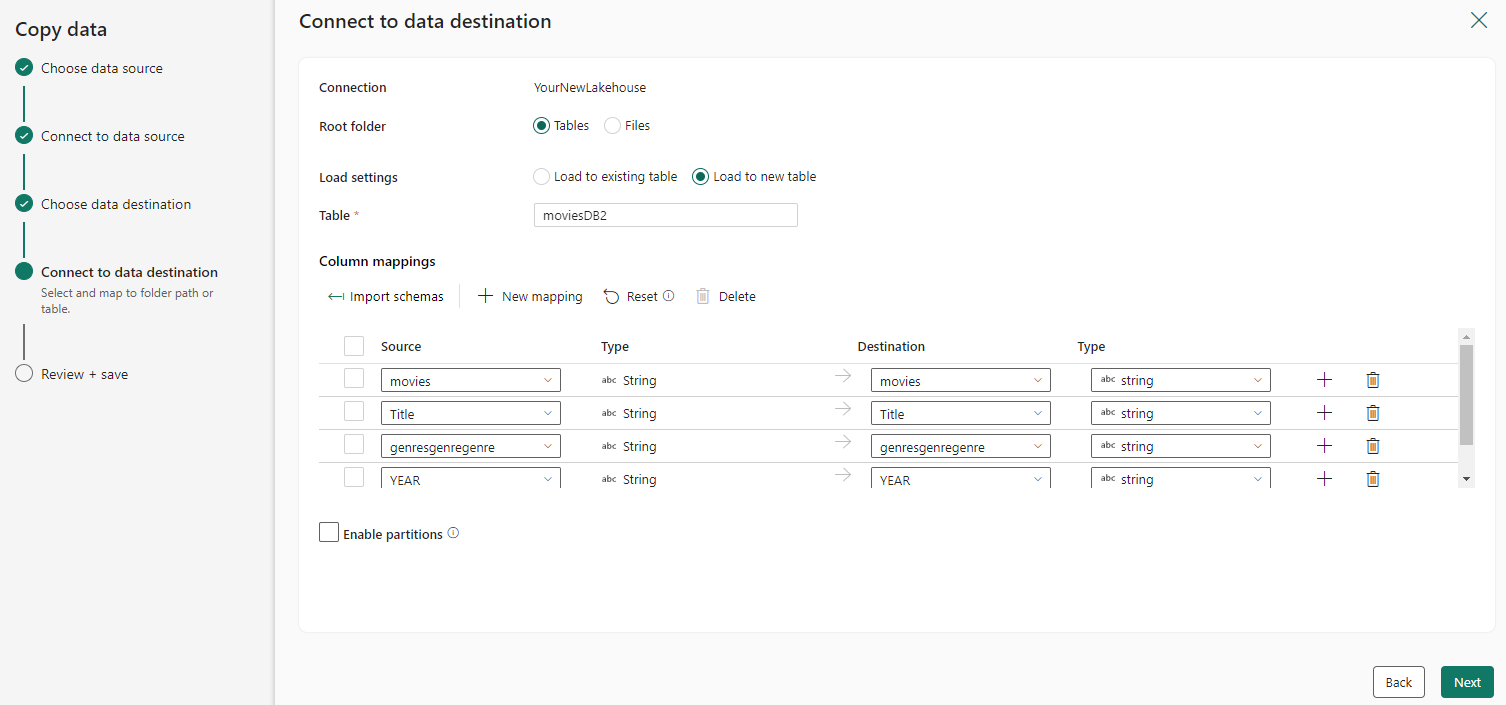

Configure e mapeie seus dados de origem para seu destino; em seguida, selecione Avançar para concluir as configurações de destino.

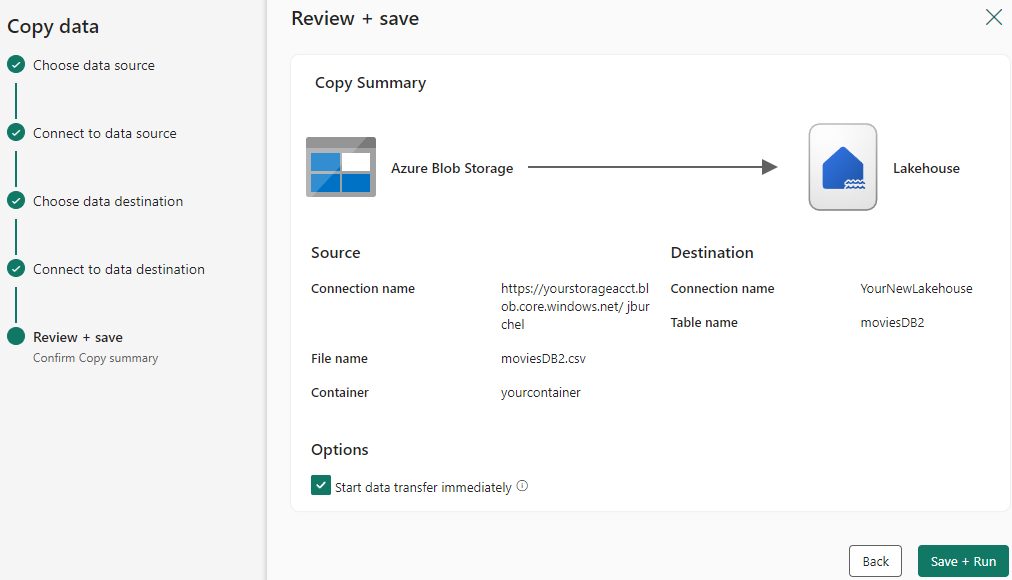

Etapa 4: Examinar e criar sua atividade Copy

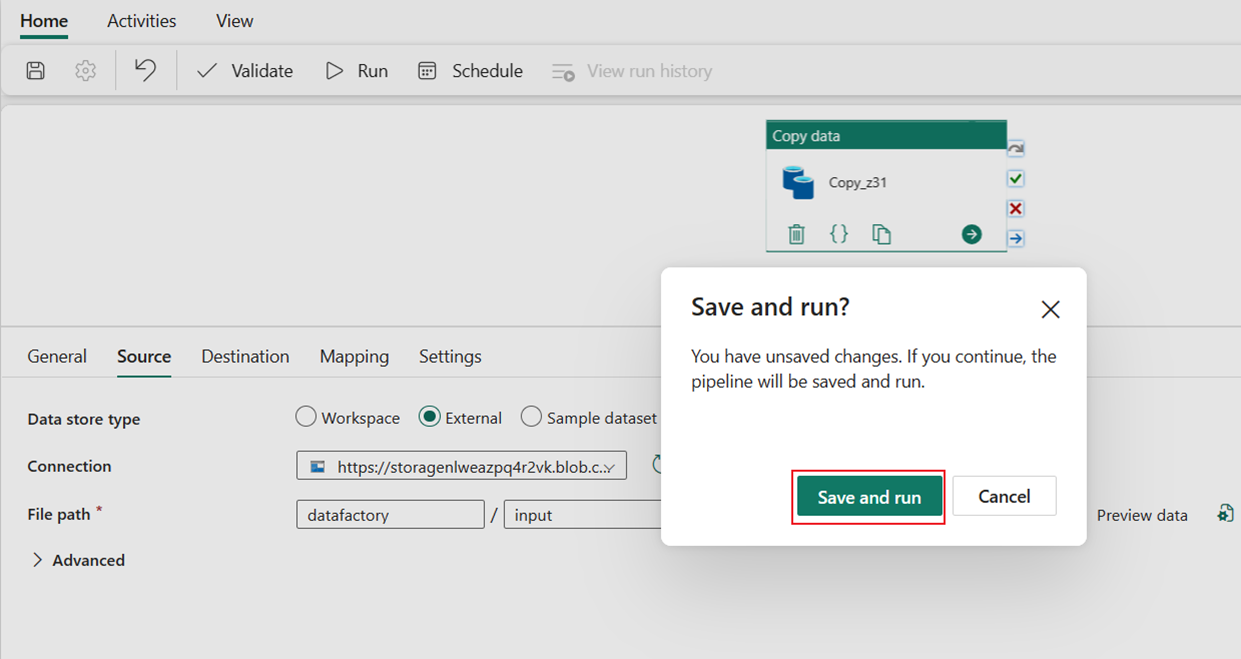

Examine as configurações da atividade Copy nas etapas anteriores e selecione Salvar + executar para concluir. Ou você pode voltar às etapas anteriores para editar suas configurações, se necessário, na ferramenta.

Depois de concluída, a atividade Copy é adicionada à tela do pipeline de dados e executada diretamente se você deixou a caixa de seleção Iniciar transferência de dados imediatamente marcada.

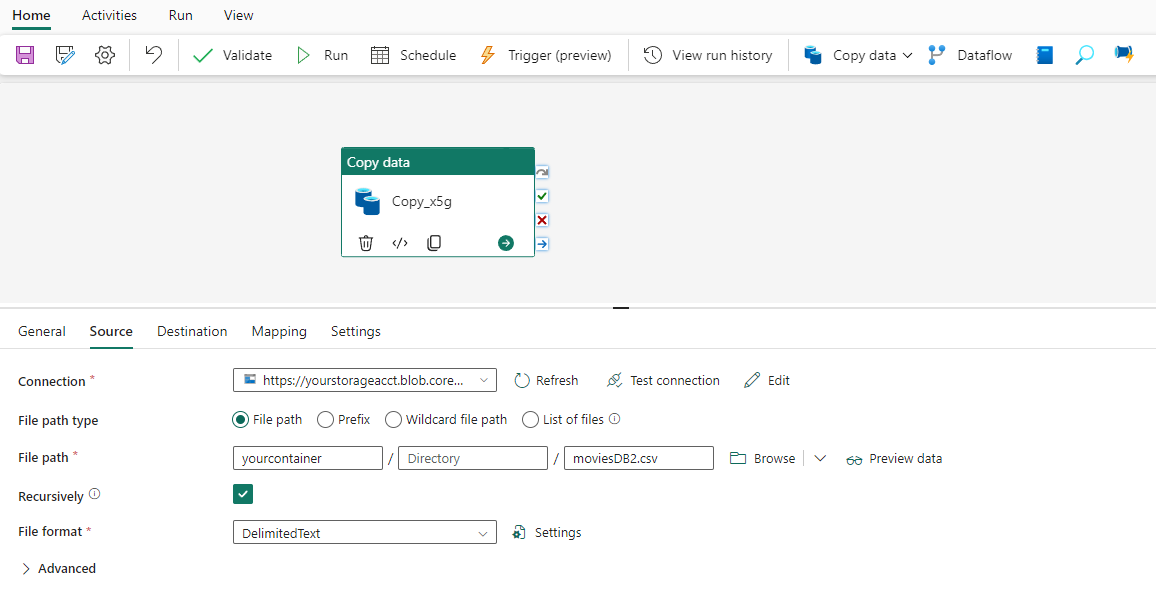

Executar e agendar seu pipeline de dados

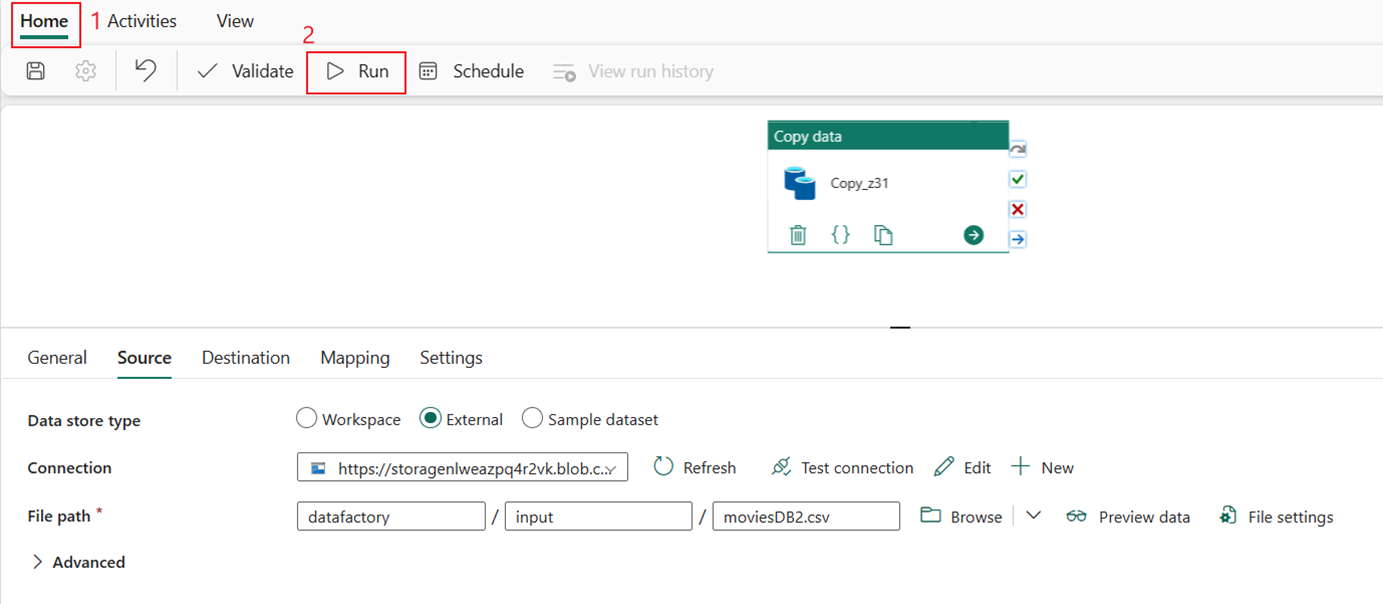

Se você não deixou a caixa de seleção Iniciar transferência de dados imediatamente selecionada na página Revisar + criar, alterne para a guia Início e selecione Executar. Em seguida, selecione Salvar e executar.

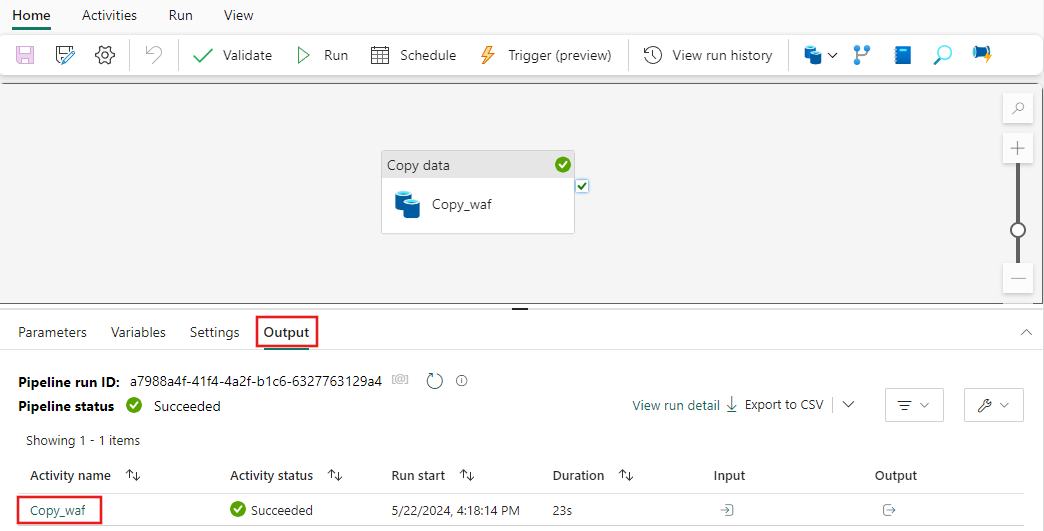

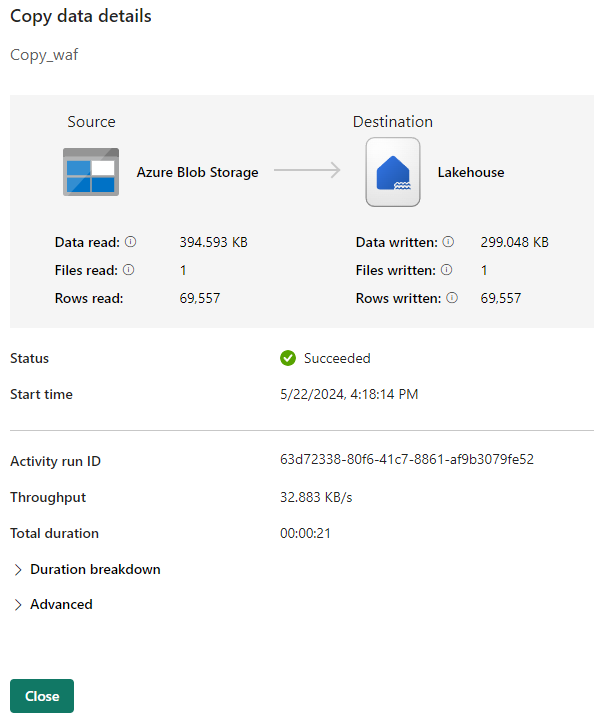

Na guia Saída, selecione o link com o nome da atividade Copy para monitorar o progresso e verificar os resultados da execução.

A caixa de diálogo Detalhes da cópia dos dados exibe os resultados da execução, incluindo status, volume de dados lidos e gravados, horários de início e parada e duração.

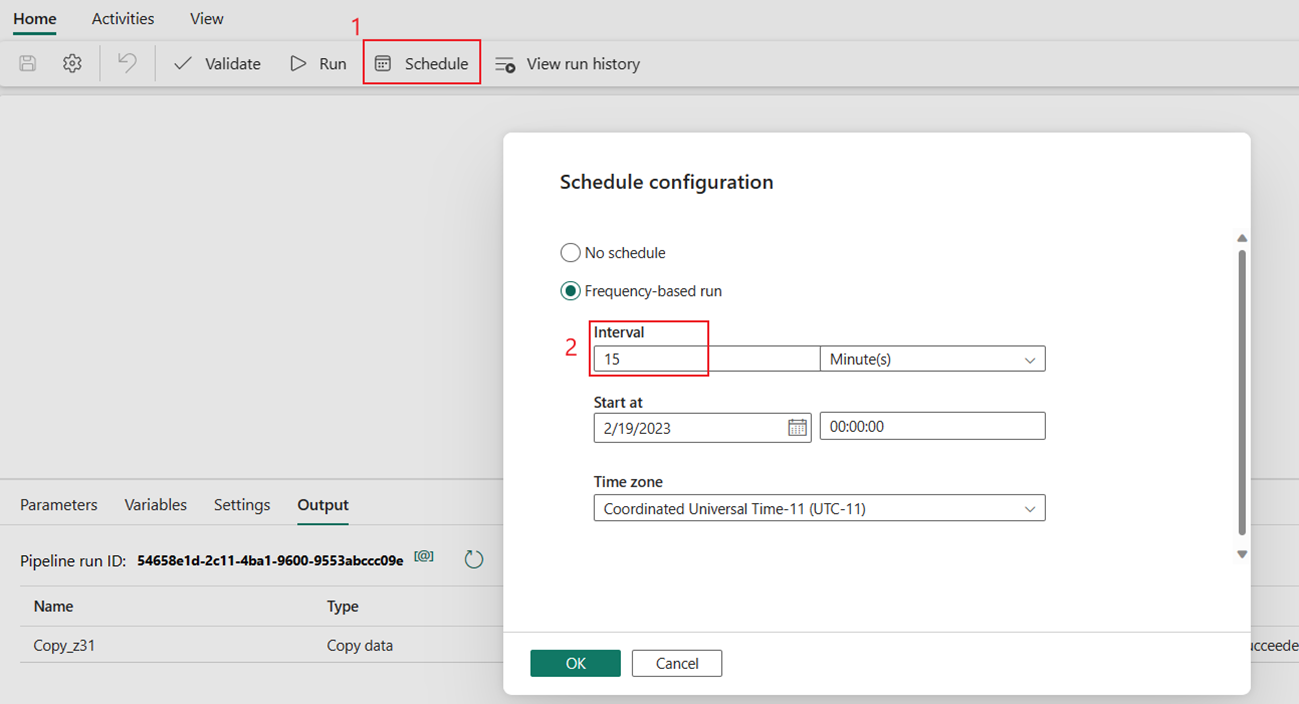

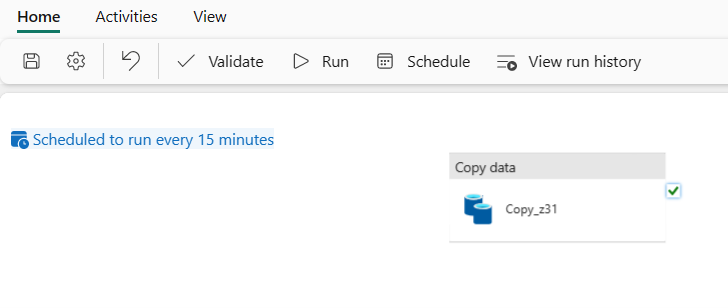

Você também pode agendar o pipeline para ser executado com uma frequência específica, conforme necessário. O exemplo a seguir mostra como agendar a execução do pipeline a cada 15 minutos.

Conteúdo relacionado

O pipeline neste exemplo mostra como copiar dados de Armazenamento de Blobs do Azure para o Lakehouse. Você aprendeu a:

- Crie um pipeline de dados.

- Copiar dados com o Assistente de Cópia.

- Execute e agende seu pipeline de dados.

Em seguida, avance para saber mais sobre como monitorar suas execuções de pipeline.