Cenário de preço usando um pipeline de dados para carregar 1 TB de dados Parquet para uma tabela do Lakehouse

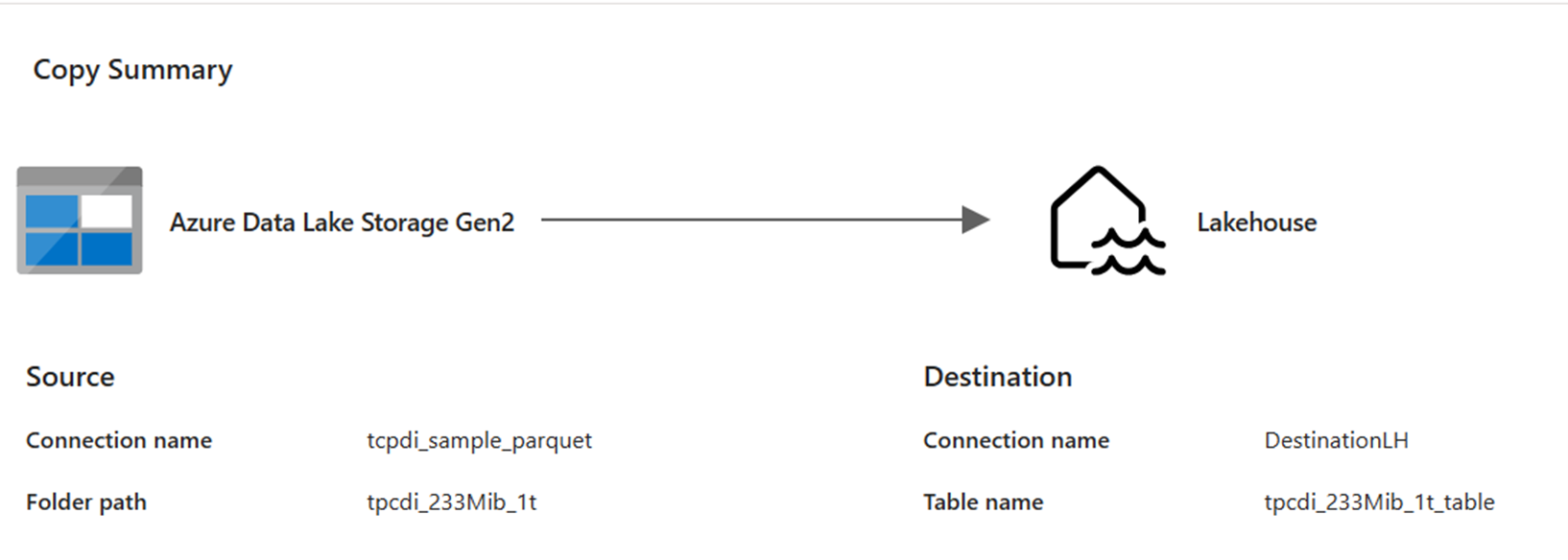

Nesse cenário, uma atividade Copy foi usada em um pipeline de dados para carregar 1 TB de dados Parquet armazenados no Azure Data Lake Storage (ADLS) Gen2 para uma tabela do Lakehouse no Microsoft Fabric.

Os preços usados no exemplo a seguir são hipotéticos e não pretendem sugerir o preço real exato. Eles apenas demonstram como você pode estimar, planejar e gerenciar custos para projetos do Data Factory no Microsoft Fabric. Além disso, como as capacidades do Fabric são precificadas exclusivamente entre regiões, usamos o preço pago conforme o uso para uma capacidade do Fabric no Oeste dos EUA 2 (uma região típica do Azure), a US$ 0,18 por CU por hora. Consulte aqui os Preços do Microsoft Fabric para explorar outras opções de preços de capacidades do Fabric.

Configuração

Para executar esse cenário, você precisará criar um pipeline com o seguinte configuração:

Estimativa de custo usando o Aplicativo de Métricas do Fabric

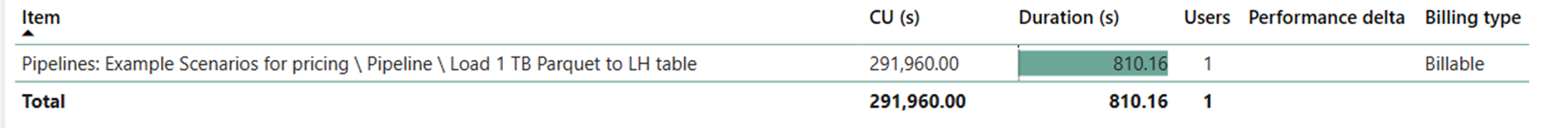

A operação de movimentação de dados utilizou 291.960 segundos de CU com uma duração de 810,16 segundos (13,5 minutos), enquanto a operação de execução da atividade era nula, pois não havia atividade non-Copy na execução do pipeline.

Observação

Embora relatado como uma métrica, a duração real da execução não é relevante ao calcular as horas efetivas de CU com o Aplicativo de Métricas do Fabric, uma vez que a métrica de segundos de CU que ele também relata já conta para sua duração.

| Metric | Operações de Movimentação de Dados |

|---|---|

| Segundos de CU | 291,960 segundos de CU |

| Horas efetivas de CU | (291.960) / (60*60) horas de CU = 81,1 horas de CU |

Custo total da execução a US$ 0,18/hora de CU = (81,1 horas de CU) * (US$ 0,18/hora de CU) ~= US$ 14,60