Como ingerir dados no Fabric usando a atividade de cópia do Azure Data Factory

O conector do Microsoft Fabric Lakehouse no Azure Data Factory (ADF) e no Azure Synapse Analytics permite operações de leitura e gravação no Microsoft Fabric Lakehouse (tanto para tabelas quanto para arquivos). Esse conector oferece a capacidade de usar seus pipelines existentes do ADF e do Synapse, bem como fluxos de dados de mapeamento, para interagir com os Lakehouses do Fabric. Este artigo ajuda você a configurar o Microsoft Fabric para permitir a autenticação da entidade de serviço e, em seguida, demonstra o Conector Lakehouse para leitura e gravação no Lakehouse do Fabric.

Para obter mais informações sobre o Microsoft Fabric Lakehouse, consulte O que é uma lakehouse?

Conector do Lakehouse do Azure Data Factory

Um novo conector de serviço vinculado do Lakehouse e dois novos conjuntos de dados agora estão disponíveis para clientes que desejam começar a ler e gravar no do Microsoft Fabric Lakehouse. Para obter um guia completo sobre o Lakehouse Connector, consulte Copiar e transformar dados em arquivos do Microsoft Fabric Lakehouse (versão prévia).

Autenticação

Serviço vinculado do Azure Data Factory

O conector de Lakehouse do Microsoft Fabric requer uma SPN (entidade de serviço) ou registro de aplicativo para autenticação. Para começar, você deve criar um novo SPN ou usar um existente. O Microsoft Fabric permite o acesso de SPN a grupos de segurança específicos ou a toda a organização. Se um grupo de segurança específico for a opção que sua organização usa, o SPN usado no conector do Lakehouse deverá pertencer a um grupo de segurança adicionado à lista de permissões.

Nota

Não são necessárias permissões delegadas da API do Power BI.

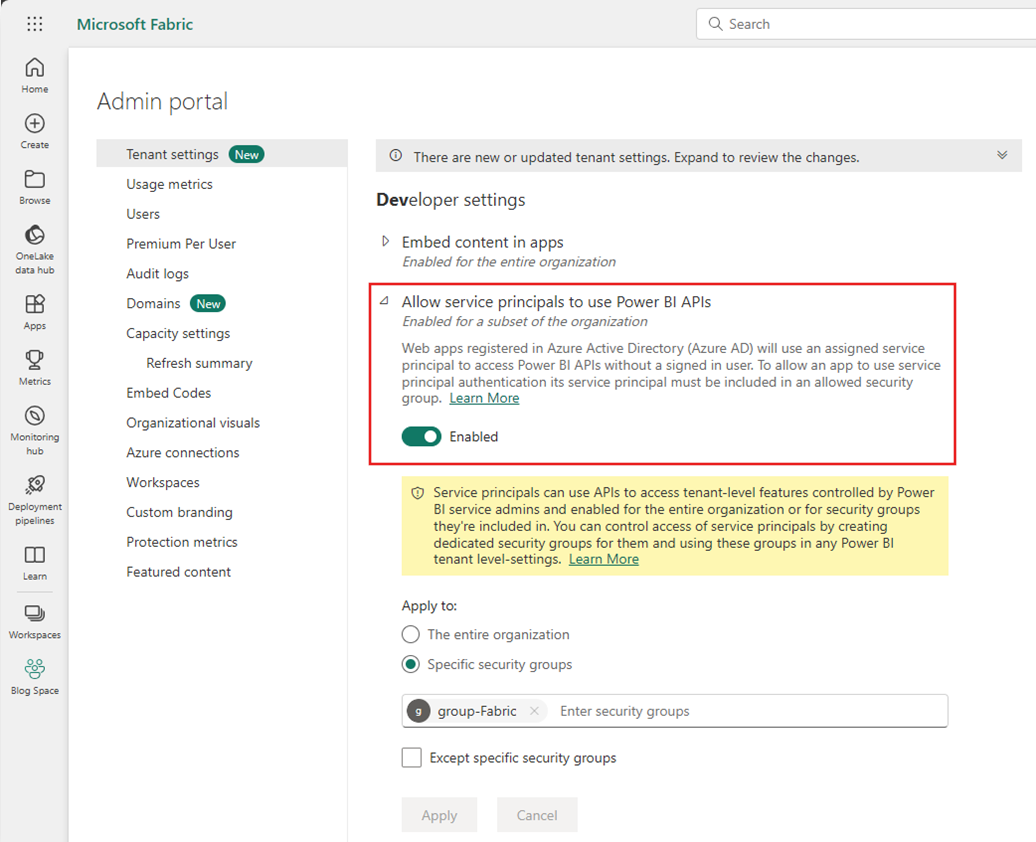

Acesso às APIs do Power BI

No portal de administração do Power BI, o administrador de locatários do Power BI precisa habilitar Permitir que as entidades de serviço usem APIs do Power BI. O grupo de segurança precisa ser especificado na configuração Permitir que as entidades de serviço usem APIs do Power BI, ou você pode habilitar para toda a organização.

Para obter um guia completo, consulte Inserir conteúdo do Power BI em um aplicativo de análise integrada com uma entidade de serviço e um segredo do aplicativo.

Nota

Quando você atribui o Grupo de Segurança ao Workspace, pode haver um atraso para que a entidade de serviço tenha acesso ao workspace devido ao cache de permissões no Azure. Se você precisar de acesso imediato, poderá usar o PowerShell para forçar uma atualização das permissões do usuário. Para fazer isso, abra o PowerShell como Administrador e execute os seguintes comandos:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Acesso ao workspace

Depois que o Grupo de Segurança for adicionado, o Grupo de Segurança ou a entidade de serviço precisam ser adicionados a cada workspace como Membro, Colaborador ou Administrador. Consulte Conceder aos usuários acesso a workspaces para obter mais detalhes.

Demonstração: configurar a autenticação

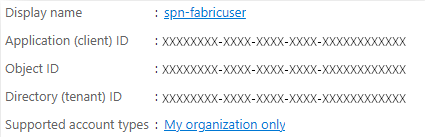

Entidade de serviço de registro de aplicativo

Crie ou use um SPN (nome da entidade de serviço) de registro de aplicativo existente. Siga as etapas em Registrar um aplicativo com o Microsoft Entra ID e criar uma entidade de serviço.

Nota

Você não precisa atribuir um URI de Redirecionamento.

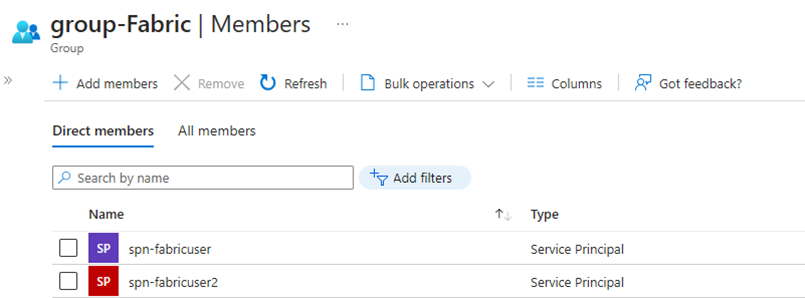

Grupo de segurança

Crie um novo Grupo de Segurança do Microsoft Entra ou use um existente e adicione o SPN a ele. Siga as etapas em Criar um grupo básico e adicionar membros para criar um Grupo de Segurança do Microsoft Entra.

Portal de administração do Power BI

No portal de administração do Power BI, navegue até Configurações do Desenvolvedor, selecione Permitir que as entidades de serviço usem as APIs do Power BI e habilite essa opção. Em seguida, adicione o Grupo de Segurança da etapa anterior. Para obter mais informações sobre as configurações de locatário do portal de administração do Power BI, consulte Configurações de Locatário.

Nota

Certifique-se de que a configuração para que os usuários possam acessar dados armazenados no OneLake com aplicativos externos ao Fabric esteja habilitada. Consulte Permitir que aplicativos em execução fora do Fabric acessem dados por meio do OneLake.

Área de trabalho

Adicione o SPN ou o grupo de serviços ao workspace com acesso de Membro, Colaborador ou Administrador.

Azure Data Factory: serviço vinculado

No Azure Data Factory, crie um serviço vinculado de Lakehouse do Microsoft Fabric.

Nota

Para encontrar as IDs do workspace e do Lakehouse, navegue até o Lakehouse do Fabric e localize-os na URL. Por exemplo: https://.../groups/<Workspace ID>>/lakehouses/<Lakehouse ID>

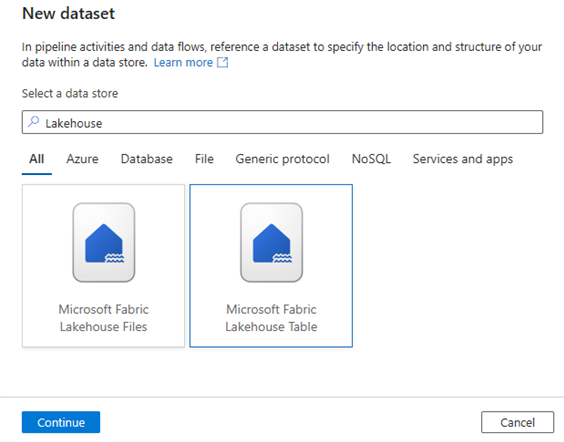

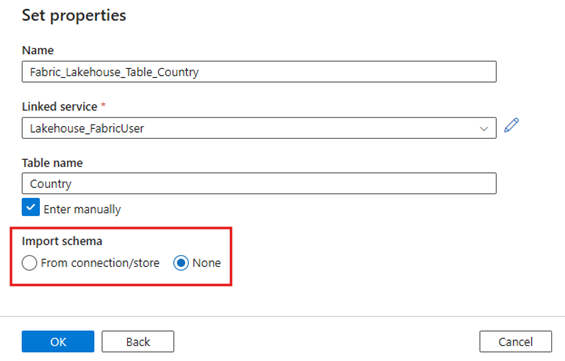

Azure Data Factory: Conjunto de dados

Crie um conjunto de dados que faça referência ao serviço vinculado do Microsoft Fabric Lakehouse.

Nota

Selecione Nenhum para a opção Esquema de importação se a tabela ainda não existir e você estiver especificando manualmente um novo nome de tabela.

Demonstração: Gravar em uma tabela de Lakehouse do Fabric usando um pipeline do ADF

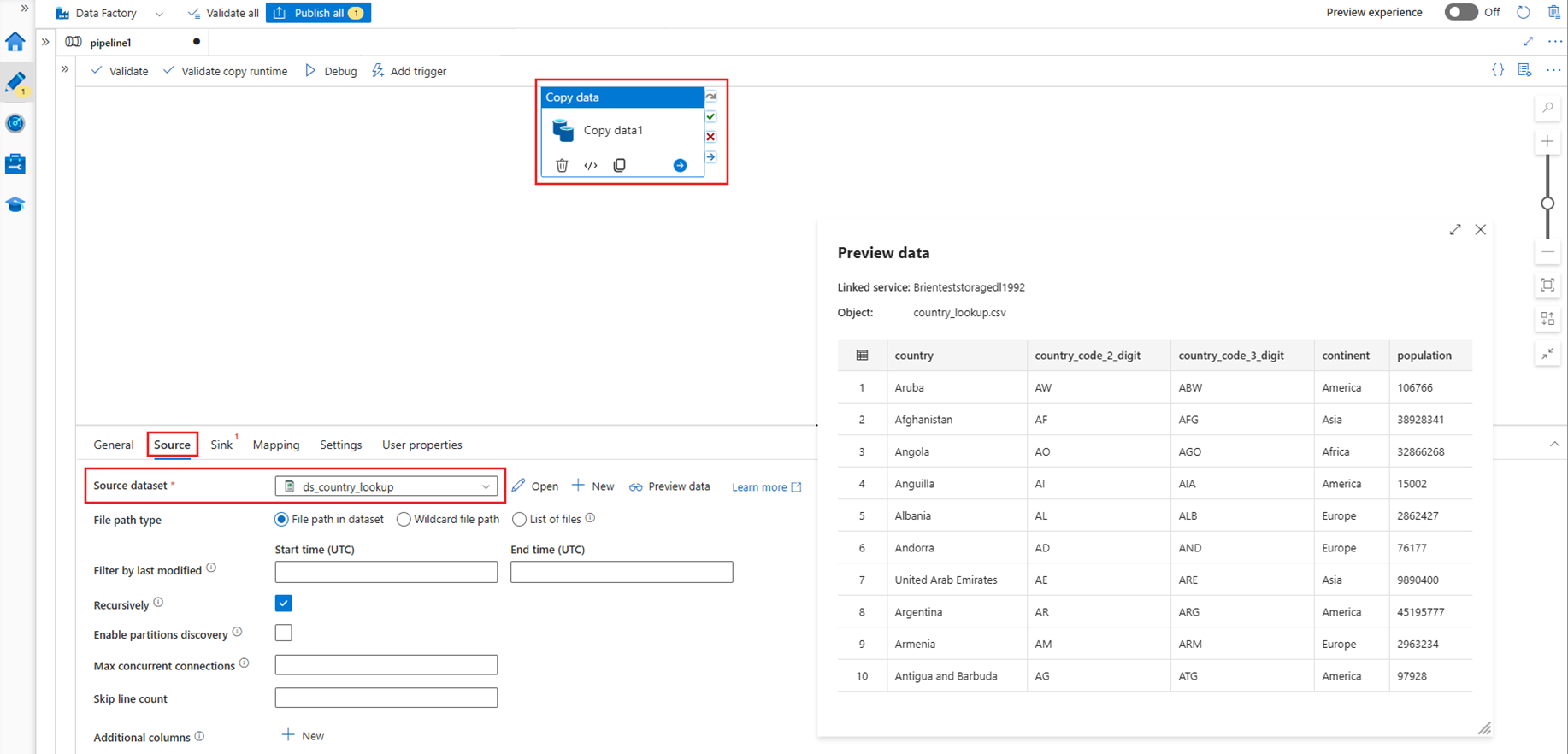

Fonte

Crie um pipeline e adicione uma atividade Copy à tela do pipeline. Na guia Origem da atividade Copy, selecione um conjunto de dados de origem que você deseja mover para uma tabela do Lakehouse. Neste exemplo, estamos fazendo referência a um arquivo de .csv de uma conta do Azure Data Lake Storage (ADLS) Gen2.

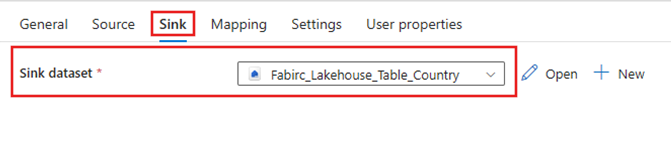

Coletor

Navegue até a guia Coletor da atividade Copy e selecione o conjunto de dados do Lakehouse do Fabric que foi criado anteriormente.

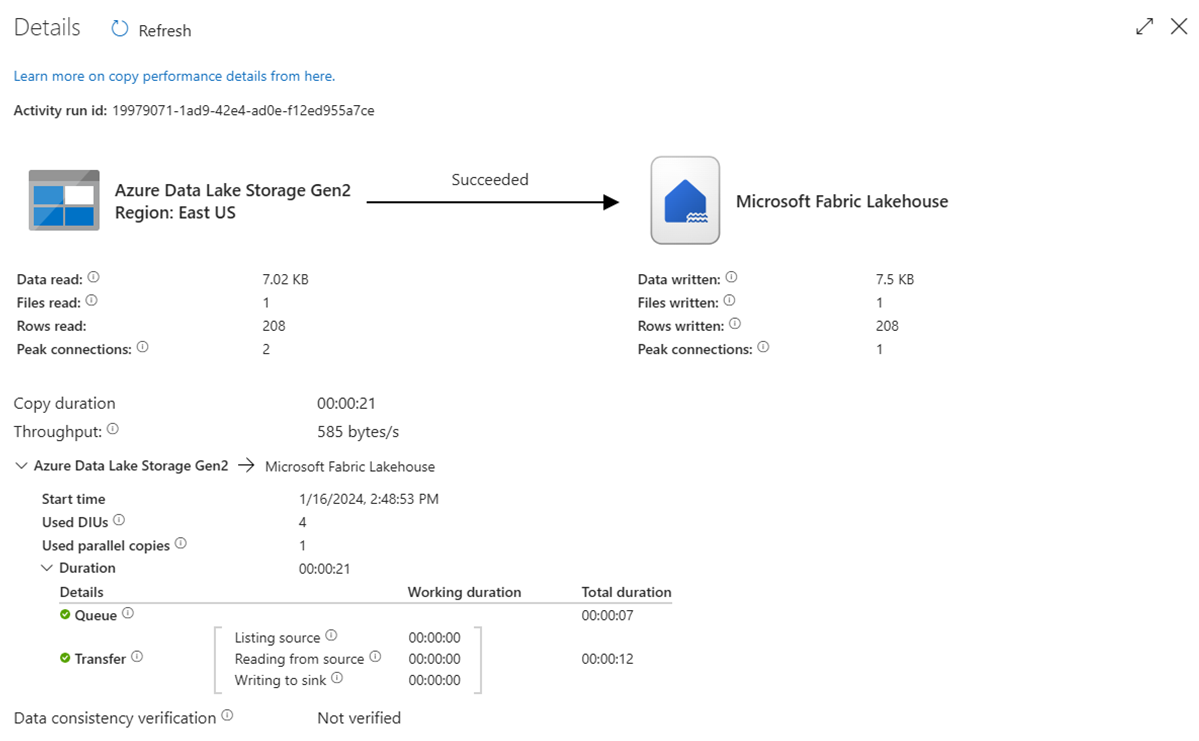

Executar o pipeline

Execute o pipeline para mover os dados do .csv para a tabela do Lakehouse do Fabric.

Demonstração: Ler de uma tabela de Lakehouse do Fabric com um pipeline do ADF

Na seção acima, demonstramos como usar o ADF para gravar em uma Tabela de Lakehouse do Fabric. Agora, vamos ler de uma tabela de Lakehouse do Fabric e gravar em um arquivo Parquet no ADLS (armazenamento do Azure Data Lake) Gen2 usando um pipeline semelhante.

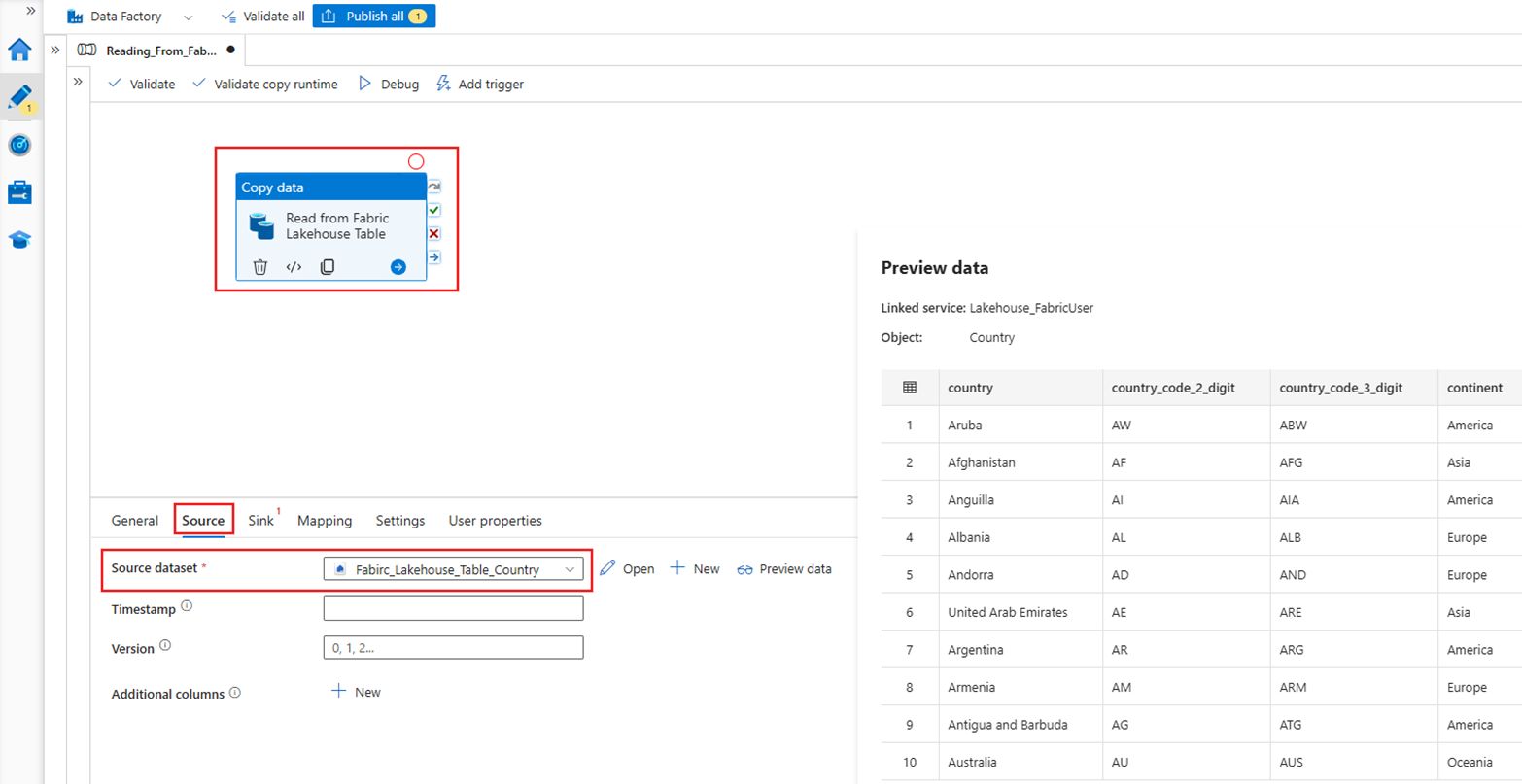

Fonte

Crie um pipeline e adicione uma atividade Copy à tela do pipeline. Na guia Origem da atividade Copy, selecione o conjunto de dados de Lakehouse do Fabric que foi criado anteriormente.

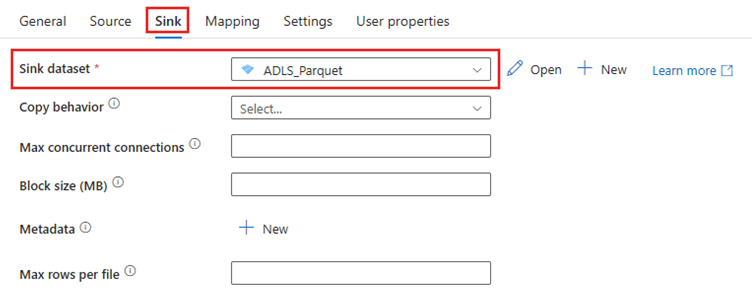

Coletor

Navegue até a guia Coletor da atividade Copy e selecione o conjunto de dados de destino. Neste exemplo, o destino é o Azure Data Lake Storage (Gen2), no formato de um arquivo Parquet.

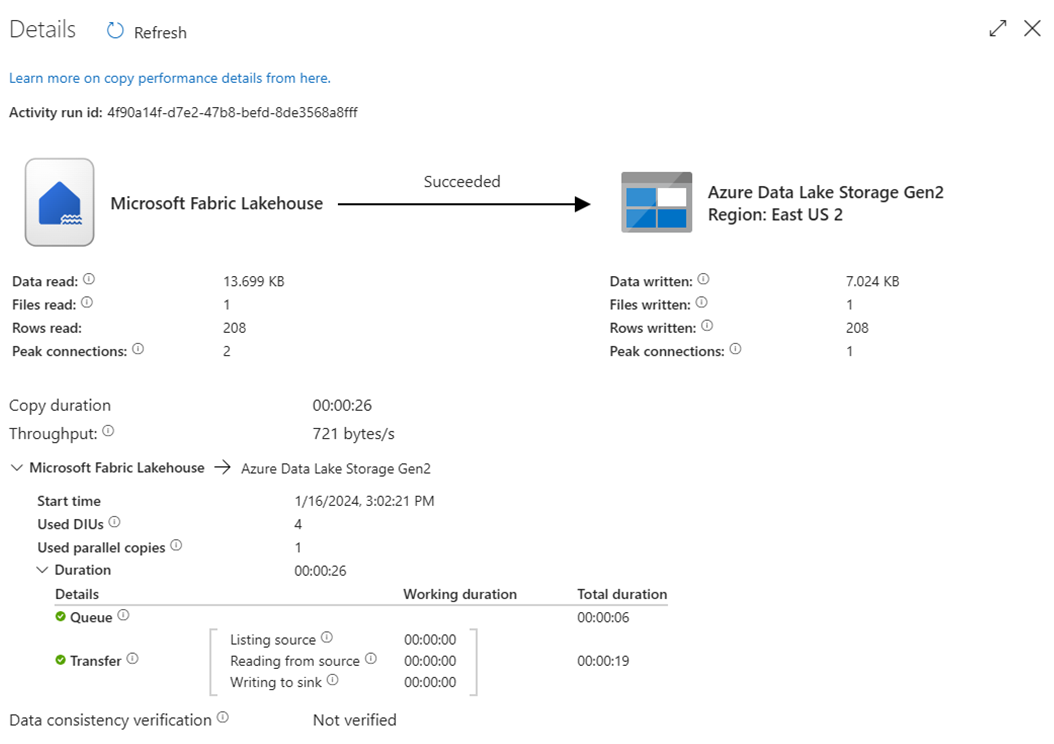

Executar o pipeline

Execute o pipeline para mover os dados da tabela de Lakehouse do Fabric para o arquivo Parquet no ADLS Gen2.

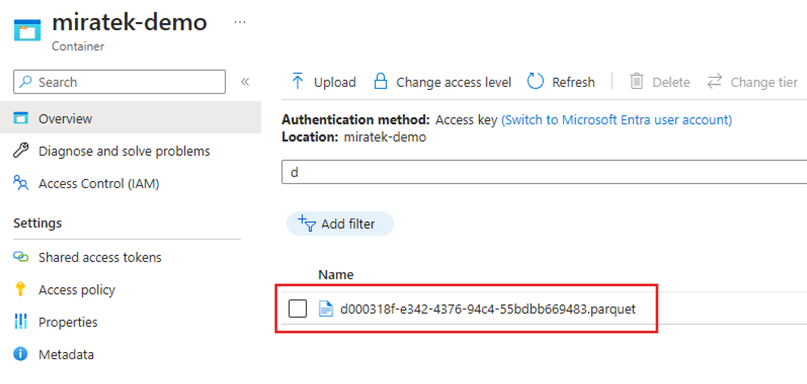

Inspecionar o arquivo Parquet no ADLS Gen2

Os dados da tabela de Lakehouse do Fabric agora estão disponíveis no ADLS Gen2 como um arquivo Parquet.

Resumo

Nesta seção, exploramos os requisitos para o Conector Lakehouse usando a autenticação de "entidade de serviço" em um Lakehouse do Microsoft Fabric e em seguida, apresentamos um exemplo de leitura e gravação no Lakehouse a partir de um pipeline do Azure Data Factory. Esse conector e esses recursos também estão disponíveis nos Fluxos de Dados de Mapeamento do Azure Data Factory, no Azure Synapse Analytics e nos Fluxos de Dados de Mapeamento do Azure Synapse Analytics.