Configurações de administração do espaço de trabalho de Engenharia de Dados no Microsoft Fabric

Aplica-se a:✅ Engenharia e ciência de dados no Microsoft Fabric

Quando você cria um workspace no Microsoft Fabric, um pool inicial associado a esse workspace é criado automaticamente. Com a configuração simplificada no Microsoft Fabric, não há necessidade de escolher os tamanhos de nó ou máquina, pois essas opções são processadas para você nos bastidores. Essa configuração fornece uma experiência de início de sessão do Apache Spark mais rápida (de 5 a 10 segundos) para que os usuários comecem e executem seus trabalhos do Apache Spark em muitos cenários comuns sem precisar se preocupar em configurar a computação. Em cenários avançados com requisitos de computação específicos, os usuários podem criar um pool personalizado do Apache Spark e dimensionar os nós com base em suas necessidades de desempenho.

Para fazer alterações nas configurações do Apache Spark em um espaço de trabalho, é necessário ter a função de administrador dele. Para saber mais, confira Funções em workspaces.

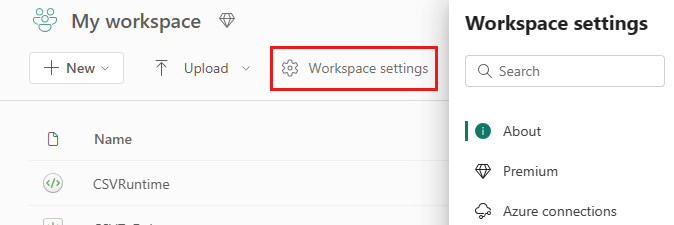

Para gerenciar as configurações do Spark para o pool associado ao seu workspace:

Vá para as Configurações do workspace em seu workspace e escolha a opção Ciência/Engenharia de Dados para expandir o menu:

Você verá a opção Computação do Spark no menu à esquerda:

Observação

Caso altere o pool padrão de Pool Inicial para um Pool do Spark personalizado, poderá visualizar um início de sessão mais longo (cerca de 3 minutos).

pool

Pool padrão do espaço de trabalho

Use o pool inicial criado automaticamente ou criar pools personalizados para o espaço de trabalho.

Pool Inicial: pools ao vivo pré-hidratados criados automaticamente para sua experiência mais rápida. Esses clusters são de tamanho médio. O pool inicial é definido como uma configuração padrão com base no SKU de capacidade do Fabric comprado. Os administradores podem personalizar os nós e executores máximos com base nos requisitos de escala de carga de trabalho do Spark. Para saber mais, confira Configurar Pools Iniciais

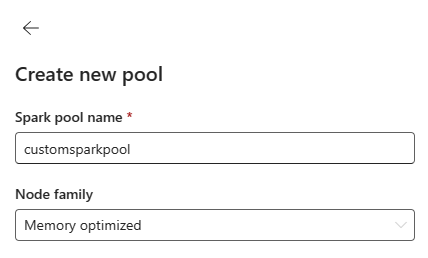

Pool do Spark personalizado: você pode dimensionar os nós, dimensionar automaticamente e alocar dinamicamente os executores com base nos requisitos do trabalho do Spark. Para criar um Pool do Spark personalizado, o administrador de capacidade deve habilitar a opção Pools do workspace personalizados na seção Computação do Spark das configurações do Administrador de Capacidade.

Observação

O controle de nível de capacidade para pools de espaço de trabalho personalizados é habilitado por padrão. Para saber mais, confira Configure and manage data engineering and data science settings for Fabric capacities.

Os administradores podem criar Pools do Spark personalizados com base em seus requisitos de computação selecionando a opção Novo pool.

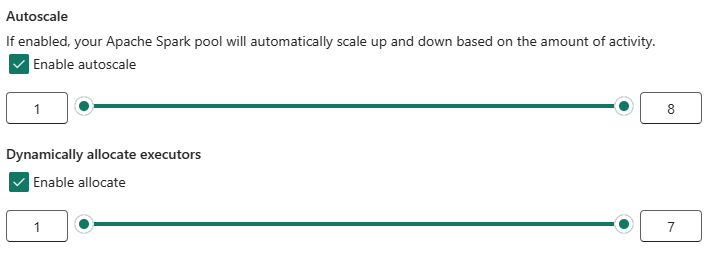

O Apache Spark para Microsoft Fabric oferece suporte a clusters de nó único, o que permite aos usuários selecionar uma configuração mínima de nó de 1, caso em que o driver e o executor são executados em um único nó. Esses clusters de nó único oferecem alta disponibilidade restaurável durante falhas de nó e melhor confiabilidade de trabalho para cargas de trabalho com menores requisitos de computação. Você também pode habilitar ou desabilitar a opção de dimensionamento automático para seus Pools do Spark personalizados. Quando habilitado com dimensionamento automático, o pool adquiriria novos nós dentro do limite máximo de nós especificado pelo usuário e os retiraria após a execução do trabalho para melhor desempenho.

Você também pode selecionar a opção de alocar executores dinamicamente para agrupar automaticamente o número ideal de executores dentro do limite máximo especificado com base no volume de dados para melhor desempenho.

Saiba mais sobre a computação do Apache Spark para o Fabric.

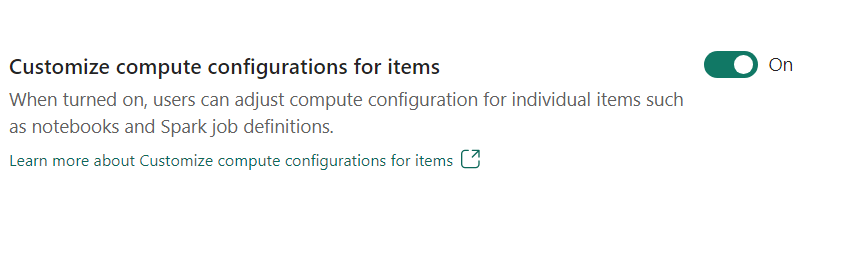

- Personalizar a configuração de computação para itens: como administrador do espaço de trabalho, permita que os usuários ajustem as configurações de computação (propriedades de nível de sessão que incluem Driver/Core do Executor, Driver/Memória do Executor) para itens individuais, como Notebooks e definições de trabalho do Spark usando o ambiente.

Se a configuração for desativada pelo administrador do espaço de trabalho, o pool Padrão e suas configurações de computação são usados para todos os ambientes no espaço de trabalho.

Environment

O ambiente fornece configurações flexíveis para executar seus trabalhos do Spark (Notebooks, definições de trabalhos do Spark). Em um Ambiente, você poderá configurar propriedades de computação, selecionar diferentes runtimes, configurar dependências de pacote de biblioteca com base em seus requisitos de carga de trabalho.

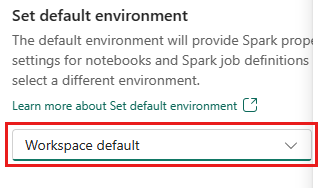

Na guia ambiente, você tem a opção de definir o ambiente padrão. Você pode escolher qual versão do Spark deseja usar para o workspace.

Como administrador do espaço de trabalho do Fabric, selecione um Ambiente como ambiente padrão de espaço de trabalho.

Também poderá criar um por meio da lista suspensa Ambiente.

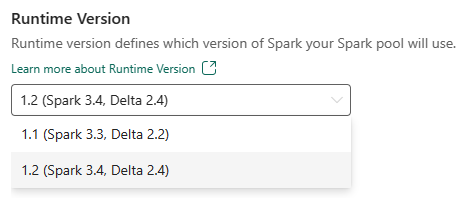

Caso desabilite a opção de ter um ambiente padrão, terá a opção de selecionar a versão de runtime do Fabric nas versões de runtime disponíveis listadas na seleção suspensa.

Saiba mais sobre runtimes do Apache Spark.

Trabalhos

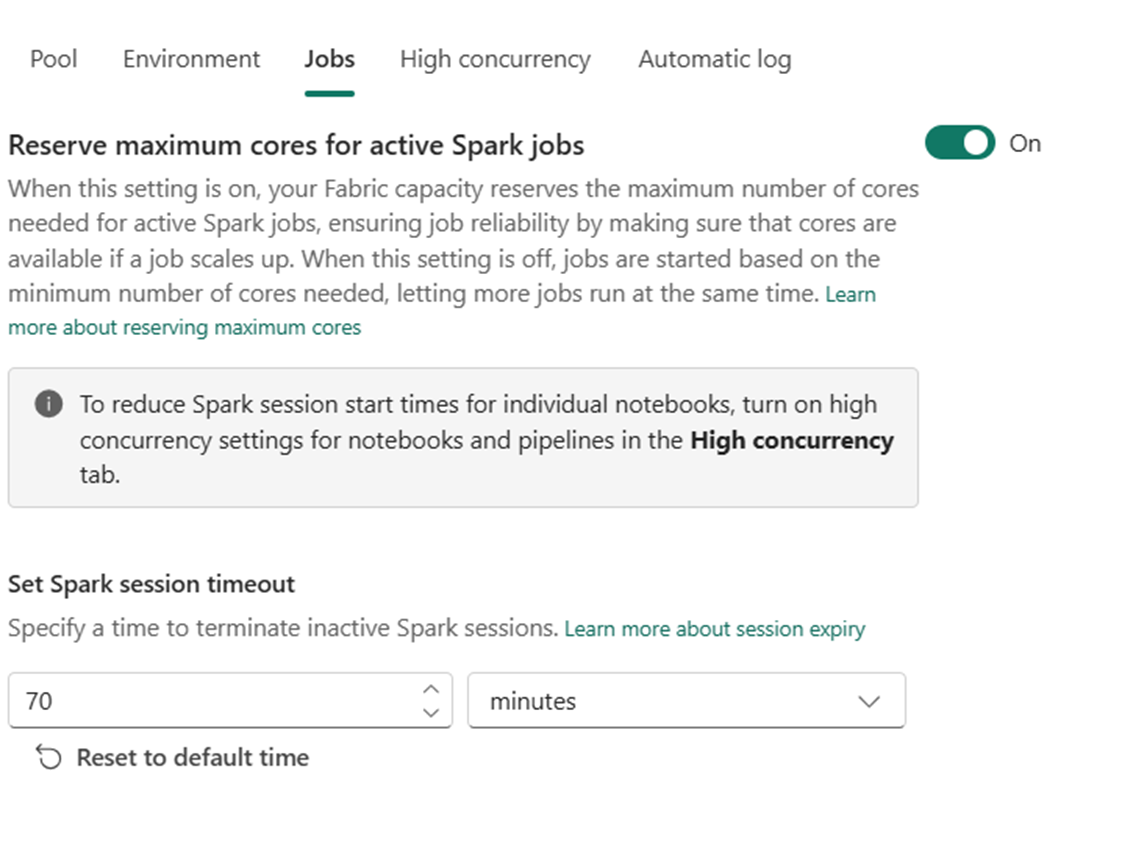

As configurações de trabalhos permitem que os administradores controlem a lógica de admissão de trabalhos para todos os trabalhos Spark no espaço de trabalho.

Por padrão, todos os espaços de trabalho são habilitados com Admissão de Trabalho Otimista. Saiba mais sobre admissão de trabalho para Spark no Microsoft Fabric.

Você pode habilitar a Reserva máxima de núcleos para trabalhos Spark ativos para desativar a abordagem baseada em admissão de trabalho Otimista e reservar núcleos máximos para seus trabalhos Spark.

Você também pode definir o tempo limite da sessão Spark para personalizar a expiração da sessão para todas as sessões interativas do notebook.

Observação

O tempo limite padrão da sessão é definido para 20 minutos para as sessões interativas do Spark.

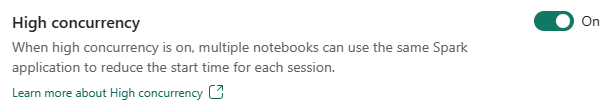

Alta simultaneidade

O modo de alta simultaneidade permite que os usuários compartilhem as mesmas sessões do Spark no Apache Spark do Fabric para cargas de trabalho de engenharia de dados e ciência de dados. Um item como um notebook usa uma sessão do Spark para sua execução e, quando habilitado, permite que os usuários compartilhem uma única sessão do Spark em vários Notebooks.

Saiba mais sobre a Alta simultaneidade no Apache Spark para Fabric.

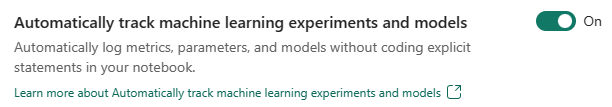

Registrar em logo automático para modelos e experimentos de machine learning

Os administradores agora podem habilitar o registro automático para seus modelos e experimentos de machine learning. Essa opção captura automaticamente os valores dos parâmetros de entrada, métricas de saída e itens de saída de um modelo de machine learning conforme ele está sendo treinado. Saiba mais sobre registro automático.

Conteúdo relacionado

- Leia sobre os Runtimes do Apache Spark no Fabric – visão geral, controle de versão, suporte a vários runtimes e atualização do protocolo Delta Lake.

- Saiba mais na documentação pública do Spark do Apache.

- Encontre respostas para perguntas frequentes: Perguntas frequentes sobre as configurações de administração do workspace do Apache Spark.