Utilizar experiência em Python no Notebook

Observação

Atualmente, o recurso está em versão prévia.

O notebook Python é uma nova experiência criada com base no notebook Fabric. É uma ferramenta versátil e interativa projetada para análise de dados, visualização e aprendizado de máquina. Ele fornece uma experiência de desenvolvimento perfeita para escrever e executar código Python. Essa funcionalidade o torna uma ferramenta essencial para cientistas de dados, analistas e desenvolvedores de BI, especialmente para tarefas de exploração que não exigem Big Data e computação distribuída.

Com um notebook Python, você pode obter:

Vários kernels de Python integrados: notebooks Python oferecem um ambiente de codificação Python puro sem Spark, com duas versões do kernel Python – Python 3.10 e 3.11, disponíveis por padrão, e os recursos nativos do iPython com suporte, como iPyWidget e comandos magic.

Econômico: o novo notebook Python oferece benefícios de economia de custos por padrão, executando em um cluster de nó único com 2vCores e 16 GB de memória. Essa configuração garante uma utilização eficiente de recursos para projetos de exploração de dados com tamanho de dados menor.

Lakehouse e recursos estão nativamente disponíveis: o Fabric Lakehouse, juntamente com a funcionalidade completa dos Recursos integrados ao Notebook, está disponível no notebook Python. Esse recurso permite que os usuários levem facilmente os dados para o Python Notebook. Basta tentar arrastar e soltar para obter o trecho de código.

Combinar programação com T-SQL: o notebook Python oferece um jeito fácil de interagir com os pontos de extremidade do Data Warehouse e do SQL no Explorer. Usando o conector de dados notebookutils, é possível executar facilmente os scripts T-SQL no contexto do Python.

O suporte para bibliotecas populares de análise de dados: Notebooks Python vêm com bibliotecas pré-instaladas, como DuckDB, Polars e Scikit-learn, fornecendo um kit de ferramentas abrangente para manipulação de dados, análise e aprendizado de máquina.

Intellisense Avançado: o notebook Python está adotando o Pylance como mecanismo do IntelliSense, além de outro serviço de linguagem personalizado do Fabric, para proporcionar uma experiência de codificação de ponta para desenvolvedores de notebooks.

NotebookUtils e link semântico: kits de ferramentas de API avançados permitem usar facilmente as funcionalidades do Fabric e do Power BI com experiência orientada a código.

Recursos Avançados de Visualização: Além das funções populares de pré-visualização rica de dataframe 'Table' e 'Chart', também damos suporte a bibliotecas populares de visualização como Matplotlib, Seaborn e Plotly. O PowerBIClient também oferece suporte a essas bibliotecas para ajudar os usuários a entender melhor os padrões e insights de dados.

Capacidades comuns para o notebook do Fabric: todas as capacidades em nível de notebook são naturalmente aplicáveis ao notebook Python, como edição, AutoSave, colaboração, compartilhamento e gerenciamento de permissões, integração com o Git, importação/exportação etc.

Capacidades de ciência de dados full-stack: a caixa de ferramentas avançada low-code Data Wrangler, o framework de aprendizado de máquina MLFlow e o eficiente Copilot estão todos disponíveis no notebook Python.

Como acessar o Python Notebook

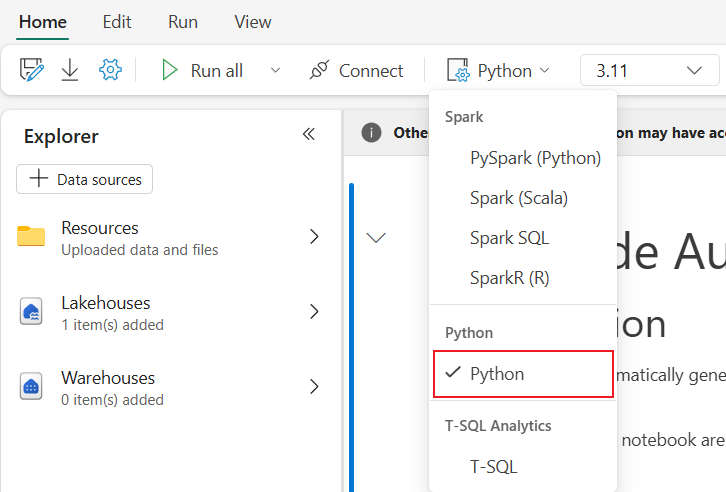

Depois de abrir um Notebook do Fabric, você pode alternar para Python no menu suspenso de linguagem na guia Página Inicial e converter toda a configuração do notebook em Python.

A maioria dos recursos comuns é suportada no nível de notebook. Consulte "Como usar notebooks do Microsoft Fabric" e "Desenvolver, executar e gerenciar notebooks do Microsoft Fabric" para obter informações detalhadas sobre o uso. Aqui listamos alguns recursos importantes específicos para cenários Python.

Executar notebooks Python

O Python Notebook suporta diversas formas de execução de tarefas:

- Execução interativa: você pode executar interativamente um notebook Python como um notebook Jupyter nativo.

- Agendar a execução: você pode usar a experiência do agendador leve na página de configurações do notebook para executar o notebook Python como um trabalho em lotes.

- Execução de pipeline: você pode orquestrar notebooks Python como atividades de notebook em Pipeline de dados. O instantâneo será gerado após a execução do trabalho.

- Execução de referência: você pode usar

notebookutils.notebook.run()ounotebookutils.notebook.runMultiple()para referenciar a execução de notebooks Python em outro notebook Python como trabalho em lotes. O instantâneo será gerado após a conclusão da execução de referência. - Execução da API pública: Você pode agendar a execução do seu notebook Python com a API pública de execução do notebook, certifique-se de que as propriedades de idioma e kernel nos metadados do notebook da carga útil da API pública estejam definidas corretamente.

Você pode monitorar os detalhes de execução do trabalho no notebook Python na guia de faixa de opções Executar –>Exibir todas as execuções.

Interação de dados

Você pode interagir com o Lakehouse, os Warehouses, os endpoints SQL e as pastas de recursos internos com o notebook Python.

Observação

O runtime do Python Notebook vem pré-instalado com as bibliotecas delta-rs e duckdb para dar suporte tanto à leitura quanto à gravação de dados do Delta Lake. No entanto, observe que alguns recursos do Delta Lake podem não ter suporte total no momento. Para mais detalhes e as atualizações mais recentes, consulte os sites oficiais do delta‑rs e do duckdb.

Interação do Lakehouse

Você pode definir um Lakehouse como padrão ou também pode adicionar vários Lakehouses para explorá-los e usá-los em cadernos.

Se você não estiver familiarizado com a leitura de objetos de dados como tabela delta, tente arrastar e soltar o arquivo e a tabela delta na tela do notebook ou use a opção Carregar dados no menu suspenso do objeto. O notebook insere automaticamente o snippet de código na célula de código e gera o código para ler o objeto de dados almejado.

Observação

Se você encontrar o OOM ao carregar um grande volume de dados, tente usar o dataframe DuckDB, Polars ou PyArrow em vez de pandas.

Você pode encontrar a operação de gravação do Lakehouse em Navegar no snippet de código –>Gravar dados na tabela delta.

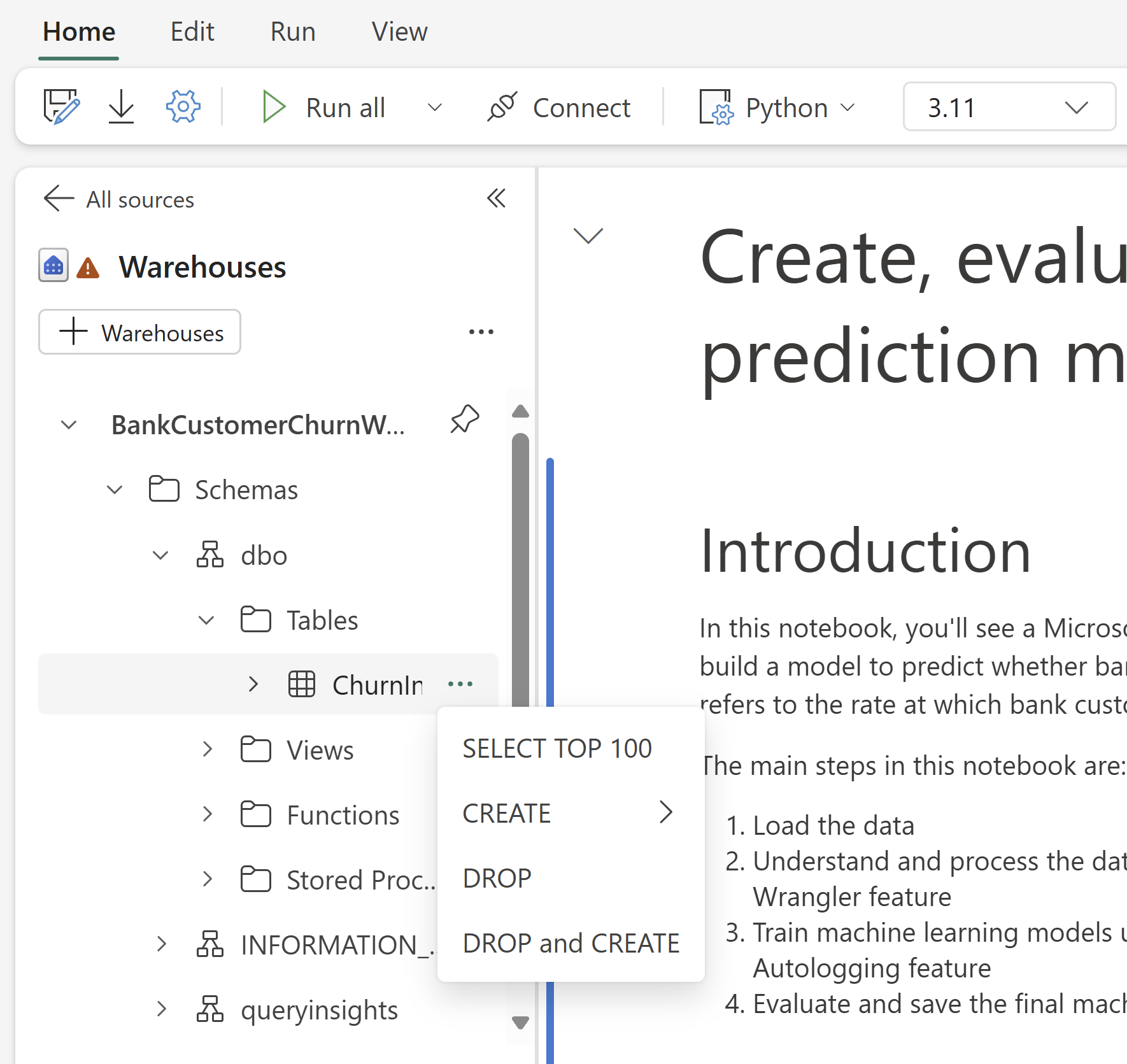

Interação de armazém e programação combinada com T-SQL

Você pode adicionar Data Warehouses ou pontos de extremidade SQL do Explorador de Warehouse do Notebook. Da mesma forma, você pode arrastar e soltar as tabelas na tela do notebook digital ou usar as operações de atalho no menu suspenso da tabela. O Notebook gera automaticamente um snippet de código para você. Você pode usar os notebookutils.data utilitários para estabelecer uma conexão com Warehouses e consultar os dados usando instruções T-SQL no contexto do Python.

Observação

Os pontos de extremidade SQL são somente leitura aqui.

Pasta de recursos do notebook

A pasta de recursos integrados de recursos do Notebook está disponível nativamente no Notebook Python. Você pode interagir facilmente com os arquivos na pasta de recursos integrada usando código Python como se estivesse trabalhando com seu sistema de arquivos local. Atualmente, a pasta de recursos Ambiente não é suportada.

Operações de kernel

O notebook Python dá suporte a dois kernels internos no momento, eles são Python 3.10 e Python 3.11, o kernel padrão selecionado é Python 3.11. você pode alternar facilmente entre eles.

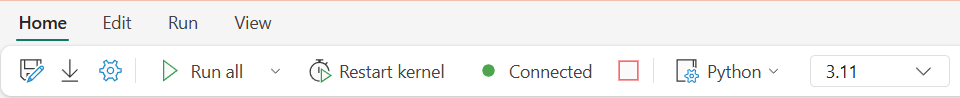

Você pode interromper, reiniciar ou alternar o kernel na guia Página Inicial da faixa de opções. Interromper o kernel nos notebooks do Python é o mesmo que cancelar células nos notebooks do Spark.

Uma saída anormal do kernel faz com que a execução do código seja interrompida e ocorra a perda de variáveis, mas não interrompe a sessão do notebook.

Existem comandos que podem levar à morte do kernel. Por exemplo, quit(), exit().

Gestão de biblioteca

Você pode usar os comandos %pip e %conda para instalações em linha; os comandos suportam bibliotecas públicas e bibliotecas personalizadas.

Para bibliotecas personalizadas, você pode carregar os arquivos lib na pasta Recursos integrados. Oferecemos suporte a vários tipos de bibliotecas, como .whl, .jar, .dll, .py, etc.; basta tentar arrastar e soltar no arquivo e o trecho de código será gerado automaticamente.

Pode ser necessário reiniciar o kernel para usar os pacotes atualizados.

Comando mágico de configuração de sessão

Semelhante à personalização de uma configuração de sessão do Spark no notebook, também é possível usar %%configure no notebook Python. O notebook Python dá suporte à personalização dos nós de computação, dos principais pontos de montagem e do lakehouse padrão da sessão do notebook. Eles podem ser usados em atividades interativas de notebook e notebook de pipeline. É recomendável usar o comando %%configure no início do notebook ou reiniciar a sessão do notebook para que as configurações tenham efeito.

Aqui estão as propriedades suportadas no notebook Python %%configure:

%%configure -f

{

"vCores": 4, // Recommended values: [4, 8, 16, 32, 64], Fabric will allocate matched memory according to the specified vCores.

"defaultLakehouse": {

// Will overwrites the default lakehouse for current session

"name": "<lakehouse-name>",

"id": "<(optional) lakehouse-id>",

"workspaceId": "<(optional) workspace-id-that-contains-the-lakehouse>" // Add workspace ID if it's from another workspace

},

"mountPoints": [

{

"mountPoint": "/myMountPoint",

"source": "abfs[s]://<file_system>@<account_name>.dfs.core.windows.net/<path>"

},

{

"mountPoint": "/myMountPoint1",

"source": "abfs[s]://<file_system>@<account_name>.dfs.core.windows.net/<path1>"

},

],

}

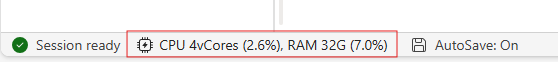

Você pode visualizar a atualização dos recursos de computação na barra de status do notebook e monitorar o uso da CPU e da memória do nó de computação em tempo real.

NotebookUtils

O Notebook Utilities (NotebookUtils) é um pacote integrado para ajudar você a executar facilmente tarefas comuns no Fabric Notebook. Ele vem pré-instalado no tempo de execução do Python. Você pode usar o NotebookUtils para trabalhar com sistemas de arquivos, obter variáveis de ambiente, encadear notebooks, acessar armazenamento externo e trabalhar com segredos.

Você pode usar notebookutils.help() para listar APIs disponíveis e também obter ajuda com métodos ou referenciar o documento NotebookUtils.

Utilitários de dados

Observação

Atualmente, o recurso está em versão prévia.

Você pode usar utilitários notebookutils.data para estabelecer uma conexão com a fonte de dados fornecida e então ler e consultar dados usando a instrução T-SQL.

Execute o seguinte comando para obter uma visão geral dos métodos disponíveis:

notebookutils.data.help()

Saída:

Help on module notebookutils.data in notebookutils:

NAME

notebookutils.data - Utility for read/query data from connected data sources in Fabric

FUNCTIONS

connect_to_artifact(artifact: str, workspace: str = '', artifact_type: str = '', **kwargs)

Establishes and returns an ODBC connection to a specified artifact within a workspace

for subsequent data queries using T-SQL.

:param artifact: The name or ID of the artifact to connect to.

:param workspace: Optional; The workspace in which the provided artifact is located, if not provided,

use the workspace where the current notebook is located.

:param artifactType: Optional; The type of the artifact, Currently supported type are Lakehouse, Warehouse and MirroredDatabase.

If not provided, the method will try to determine the type automatically.

:param **kwargs Optional: Additional optional configuration. Supported keys include:

- tds_endpoint : Allow user to specify a custom TDS endpoint to use for connection.

:return: A connection object to the specified artifact.

:raises UnsupportedArtifactException: If the specified artifact type is not supported to connect.

:raises ArtifactNotFoundException: If the specified artifact is not found within the workspace.

Examples:

sql_query = "SELECT DB_NAME()"

with notebookutils.data.connect_to_artifact("ARTIFACT_NAME_OR_ID", "WORKSPACE_ID", "ARTIFACT_TYPE") as conn:

df = conn.query(sql_query)

display(df)

help(method_name: str = '') -> None

Provides help for the notebookutils.data module or the specified method.

Examples:

notebookutils.data.help()

notebookutils.data.help("connect_to_artifact")

:param method_name: The name of the method to get help with.

DATA

__all__ = ['help', 'connect_to_artifact']

FILE

/home/trusted-service-user/jupyter-env/python3.10/lib/python3.10/site-packages/notebookutils/data.py

Consultar dados do Lakehouse

conn = notebookutils.data.connect_to_artifact("lakehouse_name_or_id", "optional_workspace_id", "optional_lakehouse_type")

df = conn.query("SELECT * FROM sys.schemas;")

Consultar dados do Warehouse

conn = notebookutils.data.connect_to_artifact("warehouse_name_or_id", "optional_workspace_id", "optional_warehouse_type")

df = conn.query("SELECT * FROM sys.schemas;")

Observação

Os utilitários de dados no NotebookUtils só estão disponíveis no notebook Python por enquanto.

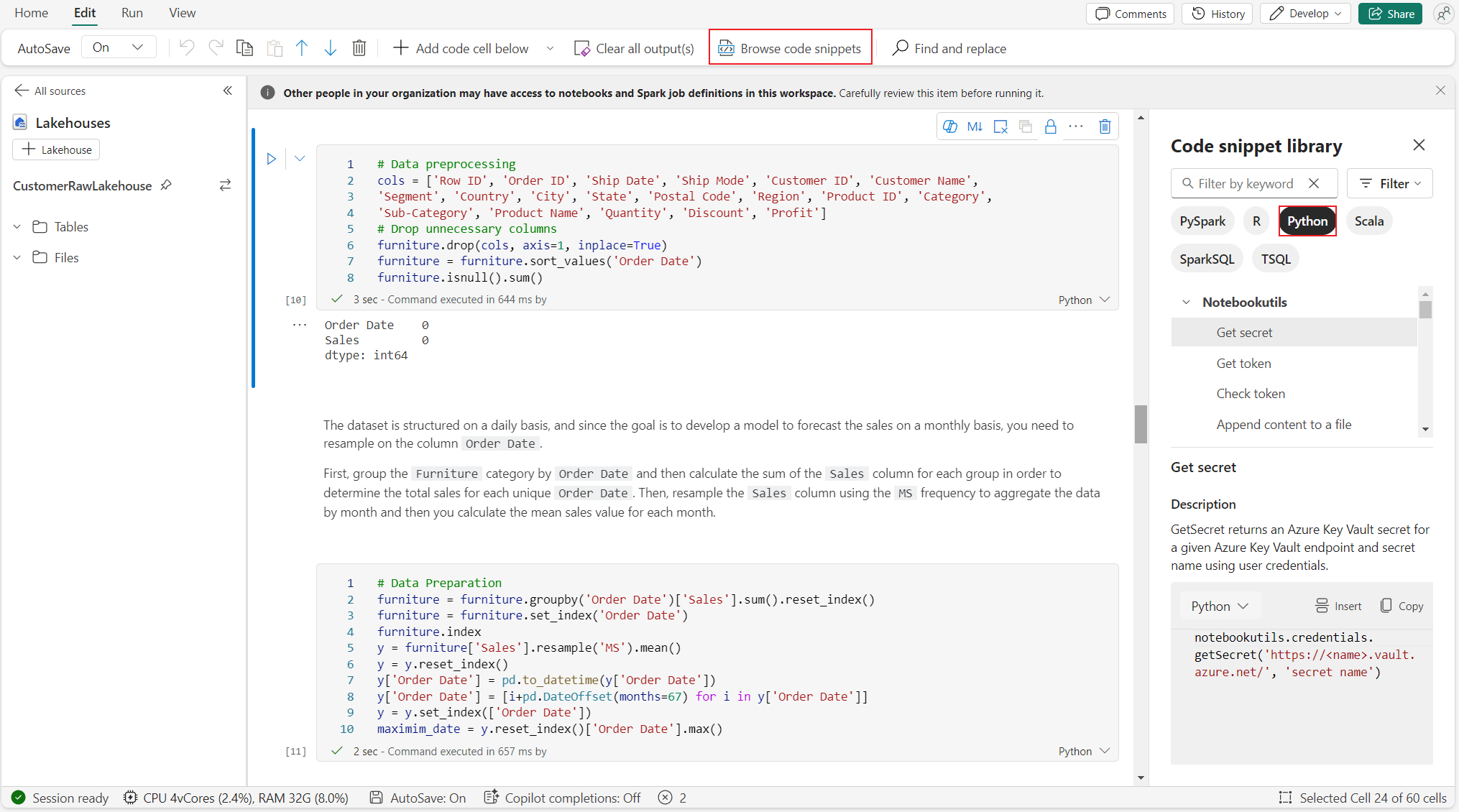

Navegar por trechos de código

Você pode encontrar snippets de código Python úteis na guia Editar –>Procurar snippet de código, novos exemplos de Python agora estão disponíveis. Você pode aprender com o snippet de código Python para começar a explorar o notebook.

Link semântico

O link semântico é um recurso que permite estabelecer uma conexão entre modelos semânticos e o Synapse Ciência de Dados no Microsoft Fabric. Ele tem suporte nativo no notebook Python. Engenheiros de BI e desenvolvedores do Power BI podem usar o Semantic Link Connect e gerenciar o modelo semântico facilmente. Leia o documento público para saber mais sobre o link semântico.

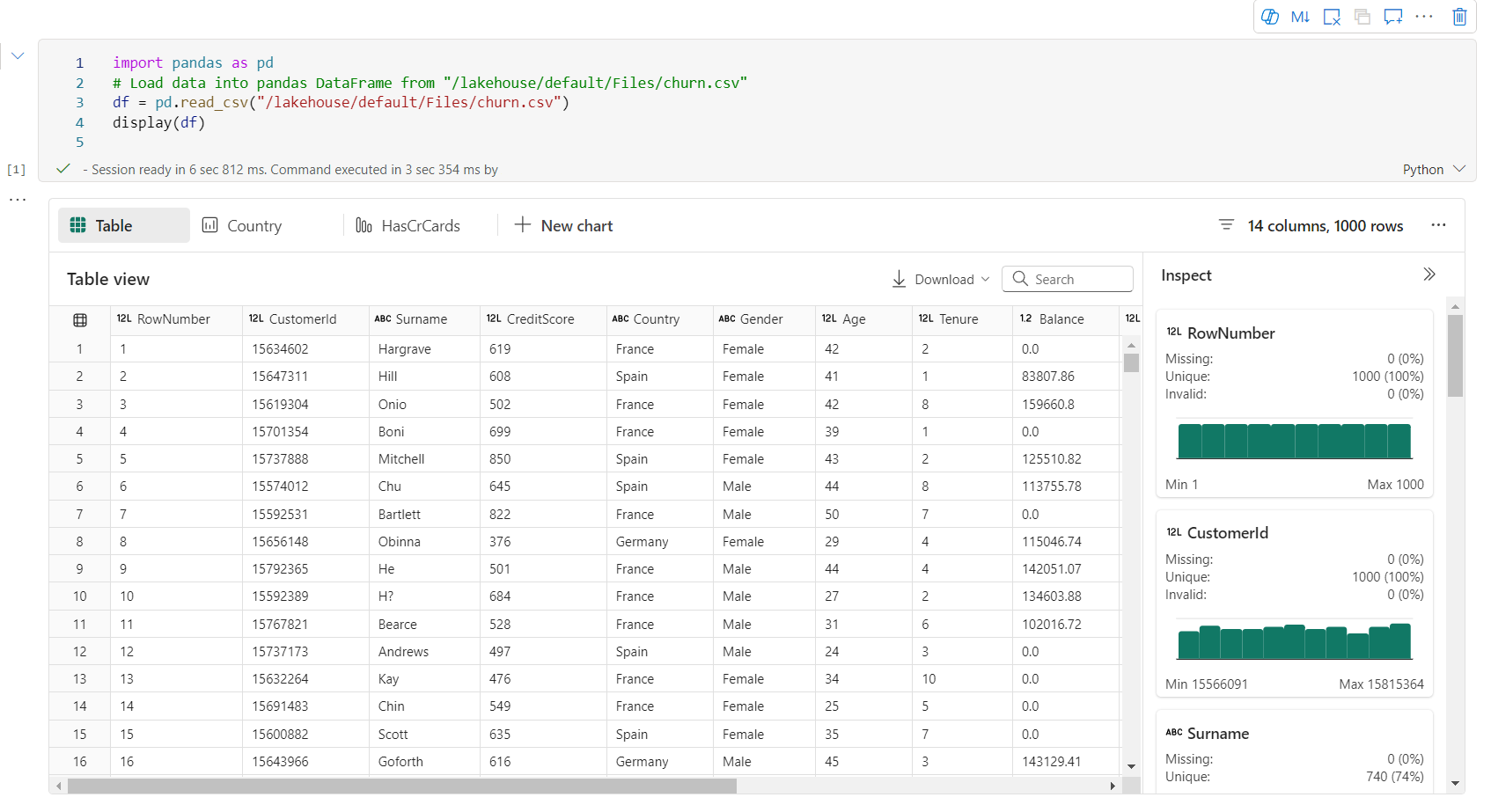

Visualização

Além de desenhar gráficos com bibliotecas, a função integrada de visualização permite que você transforme DataFrames em visualizações de dados em um formato avançado. Você pode usar a função display() em dataframes para produzir a visualização avançada da tabela de dataframe e a visualização de gráfico.

Observação

As configurações do gráfico serão mantidas no notebook Python, o que significa que depois de executar novamente a célula de código, se o esquema de dataframe de destino não tiver sido alterado, os gráficos salvos ainda serão persistidos.

Código IntelliSense

Notebooks Python integraram o Pylance para aprimorar a experiência de codificação em Python. Pylance é o suporte de serviço de linguagem padrão para Python no Visual Studio Code. Ele fornece muitas funções fáceis de usar, como destaque de palavras-chave, informações rápidas, conclusão de código, informações de parâmetros e detecção de erros de sintaxe. Além disso, o Pylance tem melhor desempenho quando o notebook é longo.

Capacidades de ciência de dados

Acesse Documentação de ciência de dados no Microsoft Fabric para saber mais sobre Ciência de Dados e experiência em IA no Fabric. Aqui listamos alguns recursos importantes de ciência de dados que são suportados nativamente no Python Notebook.

Data Wrangler: O Data Wrangler é uma ferramenta baseada em notebook que fornece uma interface imersiva para análise de dados de exploração. Esse recurso combina uma exibição de dados em grade com estatísticas de resumo dinâmicas, visualizações integradas e uma biblioteca de operações comuns de limpeza de dados. Ele fornece limpeza de dados, transformação de dados e integração, o que acelera a preparação de dados com o Data Wrangler.

MLflow: Um experimento de aprendizado de máquina é a principal unidade de organização e controle para todas as execuções de aprendizado de máquina relacionadas. Uma execução corresponde a uma única execução do código do modelo.

Fabric Auto Logging: A Ciência de Dados do Synapse no Microsoft Fabric inclui o registro automático, o que reduz significativamente a quantidade de código necessário para registrar automaticamente os parâmetros, métricas e itens de um modelo de aprendizado de máquina durante o treinamento.

O registro automático amplia os recursos de rastreamento do MLflow. O registro automático pode capturar várias métricas, incluindo precisão, perda, pontuação F1 e métricas personalizadas que você definir. Ao usar o registro automático, desenvolvedores e cientistas de dados podem rastrear e comparar facilmente o desempenho de diferentes modelos e experimentos sem rastreamento manual.

Copilot: O Copilot para notebooks de Ciência de Dados e Engenharia de Dados é um assistente de IA que ajuda você a analisar e visualizar dados. Ele funciona com tabelas lakehouse, conjuntos de dados do Power BI e dataframes pandas/spark, fornecendo respostas e snippets de código diretamente no notebook. Você pode usar o painel do Copilot chat e Char-magics no notebook, e a IA fornece respostas ou código que você pode copiar para o seu notebook.

Limitações conhecidas da prévia pública

A experiência ao vivo do pool não é garantida para cada execução do notebook Python. O início da sessão pode levar até 3 minutos se a execução do notebook não atingir o pool ativo. À medida que o uso do notebook Python cresce, nossos métodos de pool inteligente aumentam gradualmente a alocação do pool ativo para atender à demanda.

A integração de ambiente não está disponível no notebook Python na versão prévia pública.

Definir tempo limite de sessão não está disponível no momento.

O Copilot pode gerar uma instrução Spark, que pode não ser executável no notebook Python.

Atualmente, o Copilot no notebook Python não tem suporte total em várias regiões. O processo de implantação ainda está em andamento, fique atento à medida que continuamos a distribuir suporte em mais regiões.