Visão geral da máquina virtual da série HBv4

Aplica-se a: ✔️ VMs do Linux ✔️ VMs do Windows ✔️ Conjuntos de dimensionamento flexíveis ✔️ Conjuntos de dimensionamento uniformes

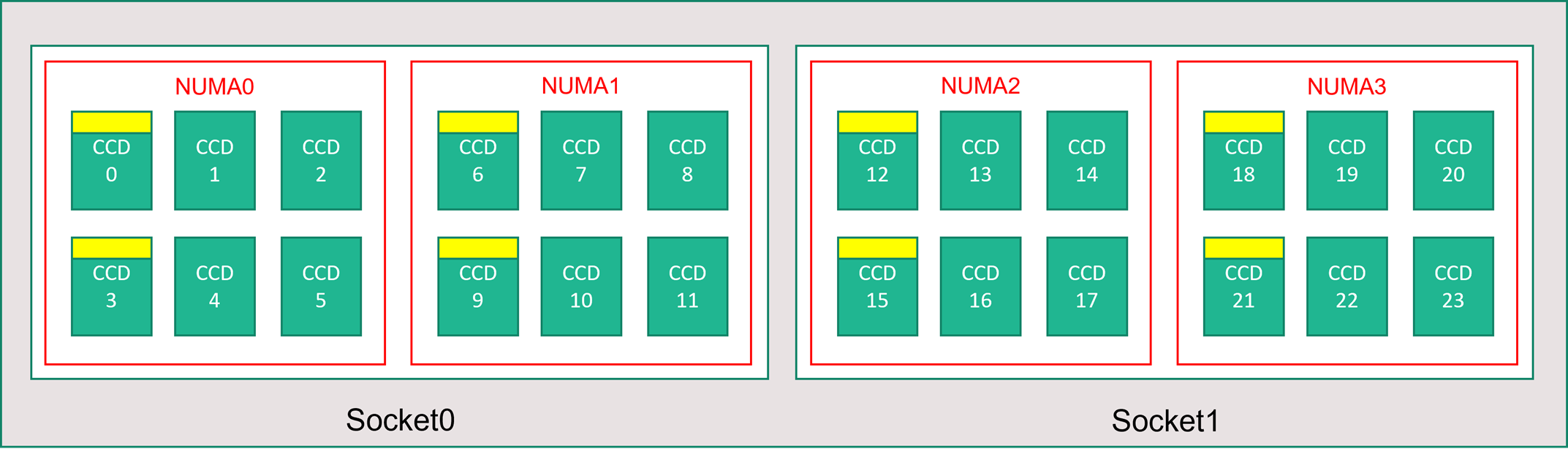

Um servidor da série HBv4 apresenta 2 CPUs * 96 núcleos EPYC 9V33X para um total de 192 núcleos físicos "Zen4" com cache AMD 3D-V. O SMT (multithreading simultâneo) está desabilitado no HBv4. Esses 192 núcleos são divididos em 24 seções (12 por soquete), cada seção contendo 8 núcleos de processador com acesso uniforme a um cache L3 de 96 MB. Os servidores HBv4 do Azure também executam as seguintes configurações de BIOS da AMD:

Nodes per Socket (NPS) = 2

L3 as NUMA = Disabled

NUMA domains within VM OS = 4

C-states = Enabled

Como resultado, o servidor é inicializado com 4 domínios NUMA (2 por soquete) cada um com 48 núcleos em tamanho. Cada NUMA tem acesso direto a 6 canais de DRAM física.

Para fornecer espaço para o hipervisor do Azure operar sem interferir na VM, reservamos 16 núcleos físicos por servidor.

Topologia da VM

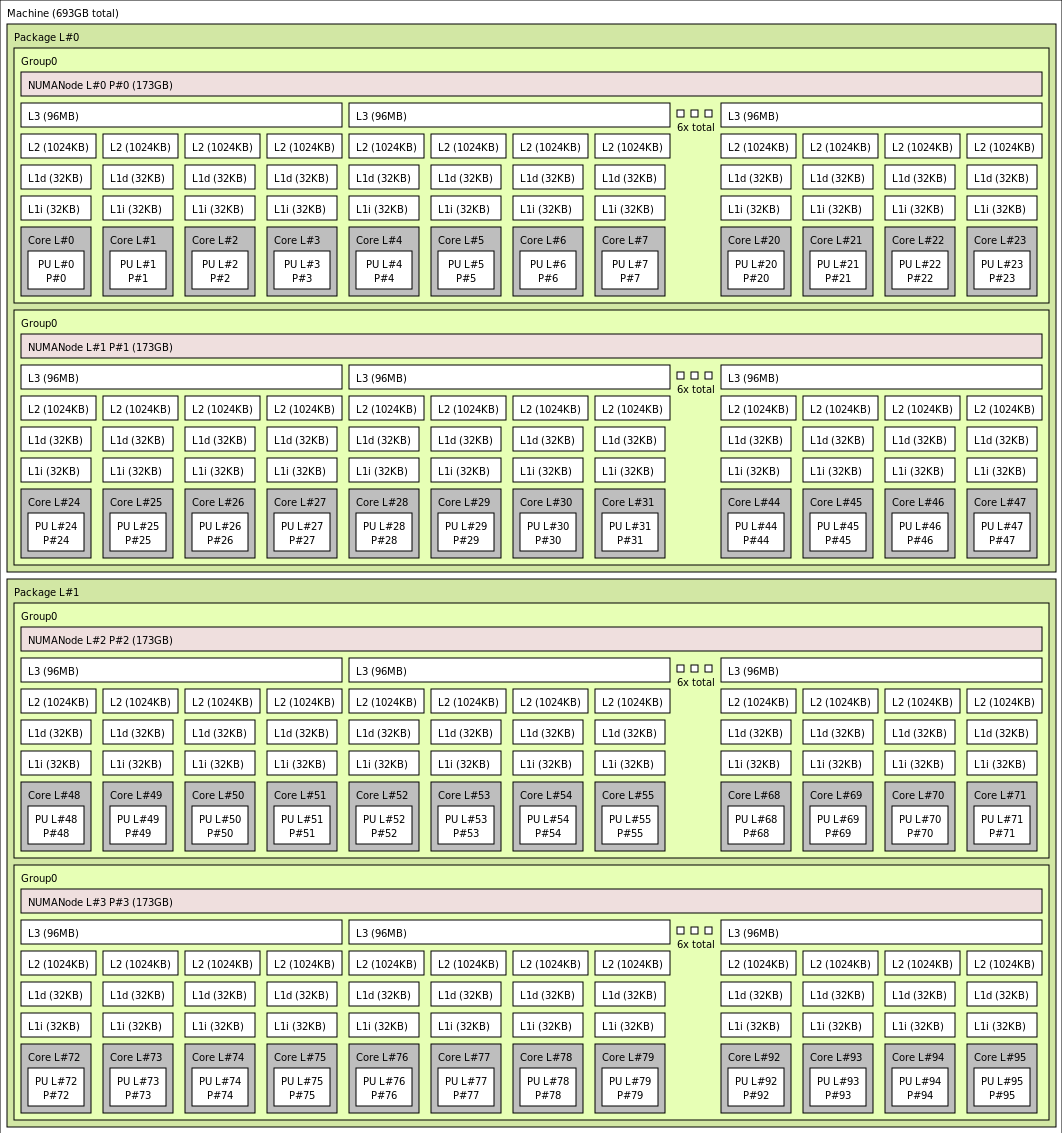

O diagrama a seguir mostra a topologia do servidor. Reservamos esses 16 núcleos de host de hipervisor (amarelo) simetricamente nos dois soquetes da CPU, usando os dois primeiros núcleos de CCDs (Core Complex Dies) em cada domínio NUMA, com os núcleos restantes para a VM da série HBv4 (verde).

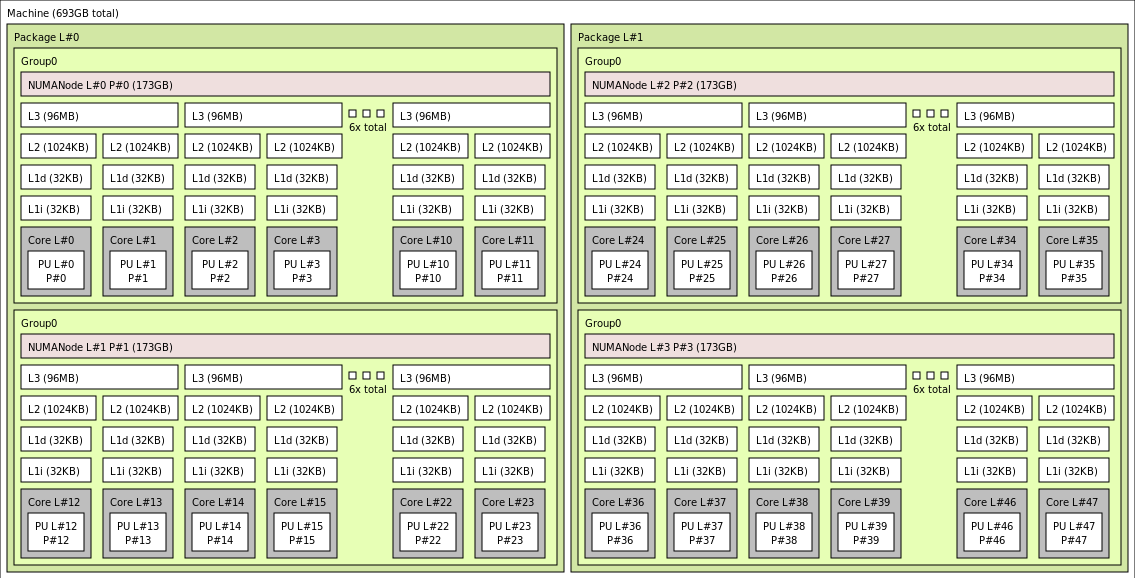

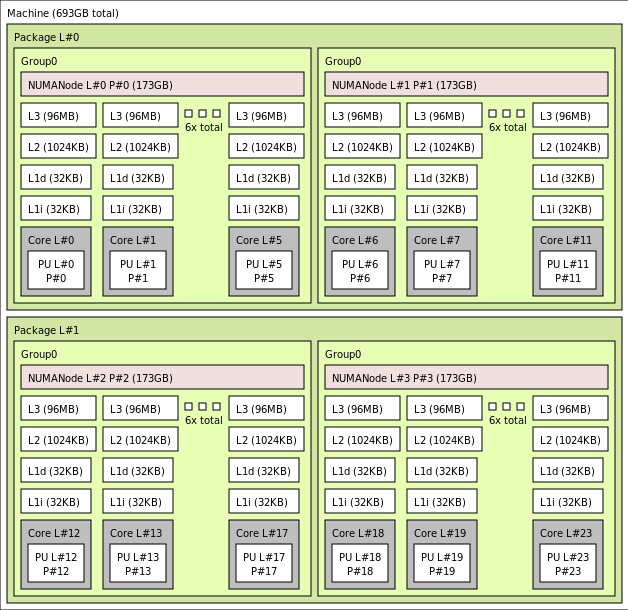

O limite CCD é diferente de um limite NUMA. No HBv4, um grupo de seis (6) CCDs consecutivos é configurado como um domínio NUMA, tanto no nível de servidor de host quanto em uma VM convidada. Assim, todos os tamanhos de VM HBv4 expõem quatro domínios NUMA uniformes que aparecem para um sistema operacional e aplicativo, conforme mostrado abaixo, cada um com um número diferente de núcleos, dependendo do tamanho da VM HBv4 específico.

Cada tamanho de VM HBv4 é semelhante em layout físico, recursos e desempenho de uma CPU diferente da AMD série EPYC 9V33X, da seguinte maneira:

| Tamanho da VM da série HBv4 | Domínios NUMA | Núcleos por domínio NUMA | Similaridade com AMD EPYC |

|---|---|---|---|

| Standard_HB176rs_v4 | 4 | 44 | EPYC 9V33X de soquete duplo |

| Standard_HB176-144rs_v4 | 4 | 36 | EPYC 9V33X de soquete duplo |

| Standard_HB176-96rs_v4 | 4 | 24 | EPYC 9V33X de soquete duplo |

| Standard_HB176-48rs_v4 | 4 | 12 | EPYC 9V33X de soquete duplo |

| Standard_HB176-24rs_v4 | 4 | 6 | EPYC 9V33X de soquete duplo |

Observação

Os tamanhos de VM de núcleos restritos reduzem apenas o número de núcleos físicos expostos à VM. Todos os ativos compartilhados globais (RAM, largura de banda de memória, cache L3, conectividade GMI e xGMI, InfiniBand, rede Ethernet do Azure, SSD local) permanecem constantes. Isso permite que o cliente escolha um tamanho de VM mais adequado para determinado conjunto de cargas de trabalho ou necessidades de licenciamento de software.

O mapeamento NUMA virtual de cada tamanho de VM HBv4 é mapeado para a topologia NUMA física subjacente. Não há uma abstração enganosa potencial da topologia de hardware.

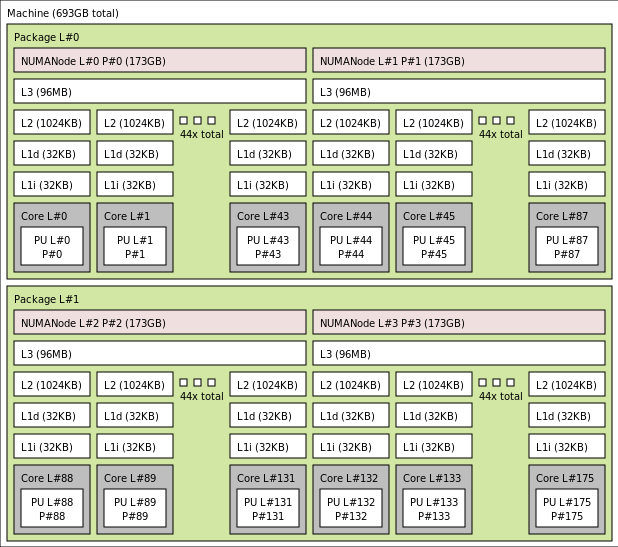

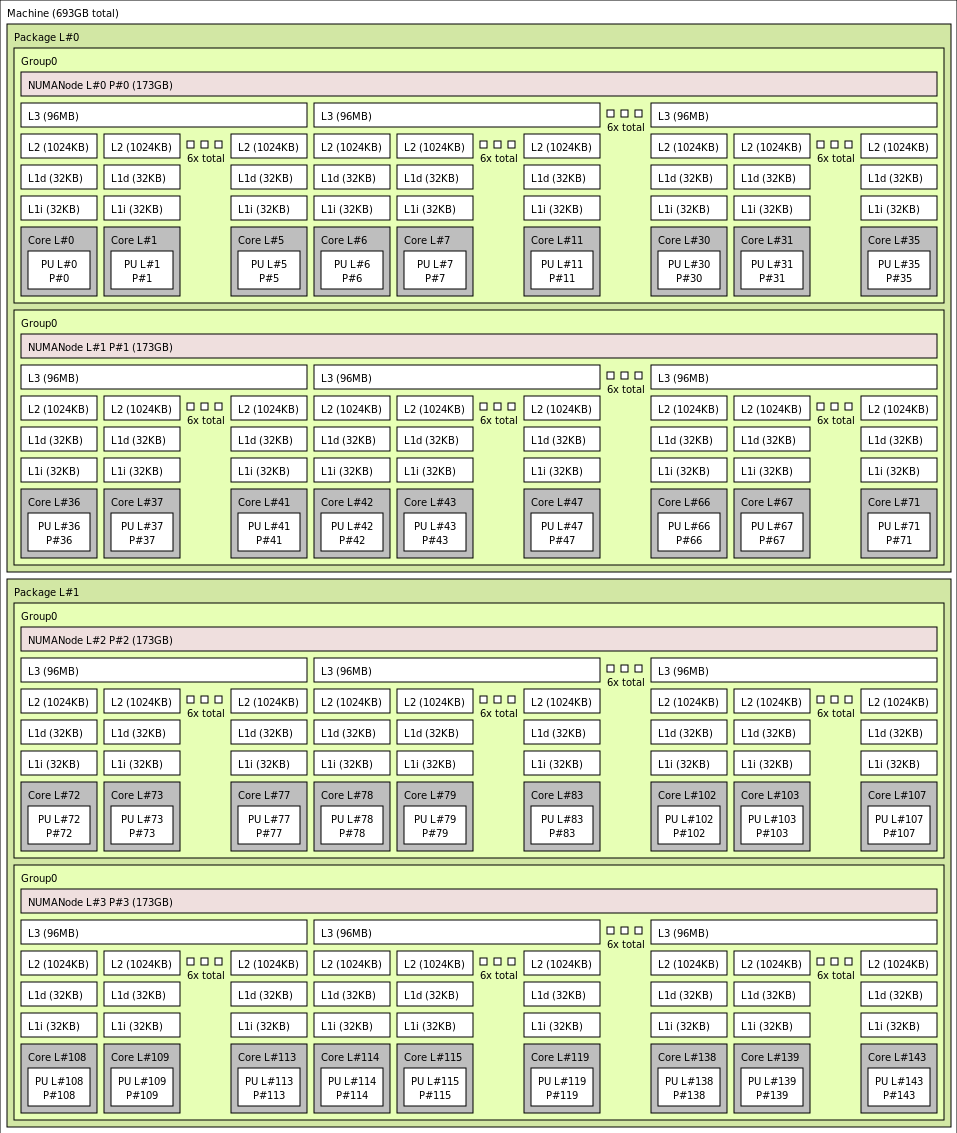

A topologia exata para o tamanho de VM de vários HBv4 é exibida da seguinte maneira usando a saída de lstopo:

lstopo-no-graphics --no-io --no-legend --of txt

Clique para exibir a saída de lstopo para Standard_HB176rs_v4

Clique para exibir a saída de lstopo para Standard_HB176-144rs_v4

Clique para exibir a saída de lstopo para Standard_HB176-96rs_v4

Clique para exibir a saída de lstopo para Standard_HB176-48rs_v4

Clique para exibir a saída de lstopo para Standard_HB176-24rs_v4

Rede InfiniBand

As VMs HBv4 também apresentam adaptadores de rede NVIDIA Mellanox NDR InfiniBand (ConnectX-7) que operam em até 400 gigabits/s. A NIC é passada para a VM via SRIOV, permitindo que o tráfego de rede ignore o hipervisor. Como resultado, os clientes carregam drivers Mellanox OFED padrão em VMs HBv4 como seriam um ambiente de computador bare-metal.

As VMs HBv4 dão suporte ao roteamento adaptável, transporte conectado dinâmico (DCT, além de transportes Standard RC e UD), e descarregamento baseado em hardware de MPI coletiva para o processador integrado do adaptador ConnectX-7. Esses recursos aprimoram o desempenho, a escalabilidade e a consistência do aplicativo, e seu uso é recomendado.

Armazenamento temporário

As VMs HBv4 apresentam 3 dispositivos SSD fisicamente locais. Um dispositivo é pré-formatado para servir como um arquivo de paginação e apareceu na sua VM como um dispositivo "SSD" genérico.

Dois outros, SSDs maiores, são fornecidos como dispositivos de bloco NVMe não formatado via NVMeDirect. Como o dispositivo de bloco NVMe ignora o hipervisor, ele tem maior largura de banda, IOPS maior e menor latência por IOP.

Quando emparelhado em uma matriz distribuída, o SSD de NVMe fornece leituras de até 12 GB/s e gravações de 7 GB/s e até 186.000 IOPS (leituras) e 201.000 IOPS (gravações) para obter profundidades de fila profundas.

Especificações de hardware

| Especificações de hardware | VMs da série HBv4 |

|---|---|

| Núcleos | 176, 144, 96, 48 ou 24 (SMT desabilitado) |

| CPU | AMD EPYC 9V33X |

| Frequência de CPU (não AVX) | Base de 2,4 GHz, aumento de pico de 3,7 GHz |

| Memória | 768 GB (RAM por núcleo depende do tamanho da VM) |

| Disco local | 2 vezes NVMe (bloco) de 1.8 TB, SSD de 480 GB (arquivo de paginação) |

| InfiniBand | Mellanox ConnectX-7 NDR InfiniBand de 400 GB/s |

| Rede | 80 GB/s de Ethernet (40 GB/s utilizáveis) Azure Second Gen SmartNIC |

Especificações de software

| Especificações de software | VMs da série HBv4 |

|---|---|

| Tamanho máximo do trabalho de MPI | 52.800 núcleos (300 VMs em um único conjunto de dimensionamento de máquinas virtuais com singlePlacementGroup=true) |

| Suporte a MPI | HPC-X (2.13 ou superior), Intel MPI (2021.7.0 ou superior), OpenMPI (4.1.3 ou superior), MVAPICH2 (2.3.7 ou superior), MPICH (4.1 ou superior) |

| Estruturas adicionais | UCX, libfabric, PGAS ou outros runtimes baseados em InfiniBand |

| Suporte ao Armazenamento do Azure | Discos Standard e Premium (máximo de 32 discos), Azure NetApp Files, Arquivos do Azure, Azure HPC Cache, Sistema de Arquivos Lustre Gerenciado do Azure |

| Sistema operacional com suporte e validado | AlmaLinux 8.6, 8.7, Ubuntu 20.04+ |

| Sistema operacional recomendado para desempenho | AlmaLinux HPC 8.7, Ubuntu-HPC 20.04+ |

| Suporte do Orchestrator | Azure CycleCloud, Azure Batch, AKS; opções de configuração de cluster |

Observação

- Essas VMs dão suporte apenas à Geração 2.

- O suporte oficinal no nível de kernel de AMD começa com RHEL 8.6 e AlmaLinux 8.6, que é um derivado de RHEL.

- O Windows Server 2012 R2 não é compatível com HBv4 e outras VMs com mais de 64 núcleos (virtuais ou físicos). Para ver mais informações, confira Sistemas operacionais convidados do Windows com suporte para Hyper-V no Windows Server. O Windows Server 2022 é necessário para tamanhos de 144 e 176 núcleos, o Windows Server 2016 também funciona para tamanhos de 24, 48 e 96 núcleos, o Windows Server funciona apenas para tamanhos de 24 e 48 núcleos.

Importante

URN de imagem recomendada: almalinux:almalinux-hpc:8_7-hpc-gen2:8.7.2023060101, Para implantar essa imagem na CLI do Azure, certifique-se de que os seguintes parâmetros estejam incluídos --plan 8_7-hpc-gen2 --product almalinux-hpc --publisher almalinux. Para testes de escala, use a URN recomendada junto com o novo HPC-X tarball.

Observação

- O suporte NDR é adicionado ao UCX 1.13 ou posterior. Versões mais antigas do UCX relatarão o erro de runtime acima. Erro UCX: velocidade ativa inválida

[1677010492.951559] [updsb-vm-0:2754 :0] ib_iface.c:1549 UCX ERROR Invalid active_speed on mlx5_ib0:1: 128. - Ibstat mostra baixa velocidade (SDR): versões mais antigas do Mellanox OFED (MOFED) não dão suporte a NDR e podem relatar velocidades do IB mais lentas. Use as versões MOFED 5.6-1.0.3.3 ou superior.

Próximas etapas

- Leia informações sobre comunicados mais recentes, exemplos de cargas de trabalho de HPC e resultados de desempenho nos Blogs do programa Tech Groups da Computação do Azure.

- Para obter uma visão de nível superior da arquitetura de execução de cargas de trabalho de HPC, confira HPC (computação de alto desempenho) no Azure.