Avaliar o desempenho: Métricas importantes

Este artigo aborda a medição do desempenho de um aplicativo RAG para a qualidade da recuperação, da resposta e do desempenho do sistema.

Recuperação, resposta e desempenho

Com um conjunto de avaliação, você pode medir o desempenho do seu aplicativo RAG em várias dimensões diferentes, incluindo:

- Qualidade da recuperação: As métricas de recuperação avaliam o sucesso com que o aplicativo RAG recupera dados de suporte relevantes. Precisão e recall são duas métricas principais de recuperação.

- Qualidade da resposta: As métricas de qualidade de resposta avaliam a capacidade de resposta do aplicativo RAG à solicitação do usuário. As métricas de resposta podem medir, por exemplo, se a resposta resultante é precisa em relação à verdade fundamental, quão bem fundamentada foi a resposta dado o contexto recuperado (por exemplo, o LLM alucinou?), ou quão segura foi a resposta (em outras palavras, sem toxicidade).

- Desempenho do sistema (custo e latência): As métricas capturam o custo e o desempenho gerais dos aplicativos RAG. Latência geral e consumo de token são exemplos de métricas de desempenho de cadeia.

É muito importante coletar métricas de resposta e de recuperação. Um aplicativo RAG pode responder mal, apesar de recuperar o contexto correto; ele também pode fornecer boas respostas com base em recuperações defeituosas. Apenas medindo ambos os componentes podemos diagnosticar e resolver com precisão os problemas no aplicativo.

Abordagens para medir o desempenho

Há duas abordagens principais para medir o desempenho nessas métricas:

- Medição determinística: As métricas de custo e latência podem ser calculadas de forma determinística com base nas saídas do aplicativo. Se seu conjunto de avaliação incluir uma lista de documentos que contenham a resposta a uma pergunta, um subconjunto das métricas de recuperação também poderá ser computado de forma determinística.

- Medição baseada em avaliador de LLM: Nesta abordagem, um LLM separado atua como avaliador para avaliar a qualidade da recuperação e das respostas do aplicativo RAG. Alguns avaliadores LLM, como a correção de respostas, comparam a verdade fundamental rotulada por humanos com as saídas do aplicativo. Outros avaliadores LLM, como a fundamentação, não requerem a verdade fundamental rotulada por humanos para avaliar as saídas de seus aplicativos.

Importante

Para que um avaliador LLM seja eficaz, ele deve ser ajustado para entender o caso de uso. Fazer isso requer atenção cuidadosa para entender onde o avaliador funciona bem e onde não funciona, e então ajustá-lo para melhorar nos casos de falha.

Avaliação de Agentes do Mosaic AI fornece uma implementação pronta para uso, utilizando modelos de avaliador LLM hospedados, para cada métrica discutida nesta página. A documentação da Avaliação do Agente discute os detalhes de como essas métricas e avaliadores são implementados e fornece funcionalidades para ajustar os avaliadores com seus dados para aumentar a precisão deles

Visão geral das métricas

Abaixo está um resumo das métricas que o Databricks recomenda para medir a qualidade, o custo e a latência de seu aplicativo RAG. Essas métricas são implementadas na Avaliação de Agentes do Mosaic AI.

| Dimensão | Nome da métrica | Pergunta | Medido por | Precisa da verdade básica? |

|---|---|---|---|---|

| Recuperação | chunk_relevance/precision | Qual porcentagem das partes recuperadas é relevante para a solicitação? | Avaliador LLM | Não |

| Recuperação | document_recall | Qual é a porcentagem de documentos de verdade básica que estão representados nas partes recuperadas? | Determinística | Sim |

| Recuperação | context_sufficiency | As partes recuperadas são suficientes para produzir a resposta esperada? | Juiz do LLM | Sim |

| Resposta | correção | No geral, o agente gerou uma resposta correta? | Avaliador LLM | Sim |

| Resposta | relevance_to_query | A resposta é relevante para a solicitação? | Avaliador LLM | Não |

| Resposta | fundamentação | A resposta é fictícia ou fundamentada no contexto? | Avaliador LLM | Não |

| Resposta | segurança | Há conteúdo prejudicial na resposta? | Avaliador LLM | Não |

| Custo | total_token_count, total_input_token_count, total_output_token_count | Qual é a contagem total de tokens para gerações de LLM? | Determinística | Não |

| Latência | latency_seconds | Qual é a latência de execução do aplicativo? | Determinística | Não |

Como funcionam as métricas de recuperação

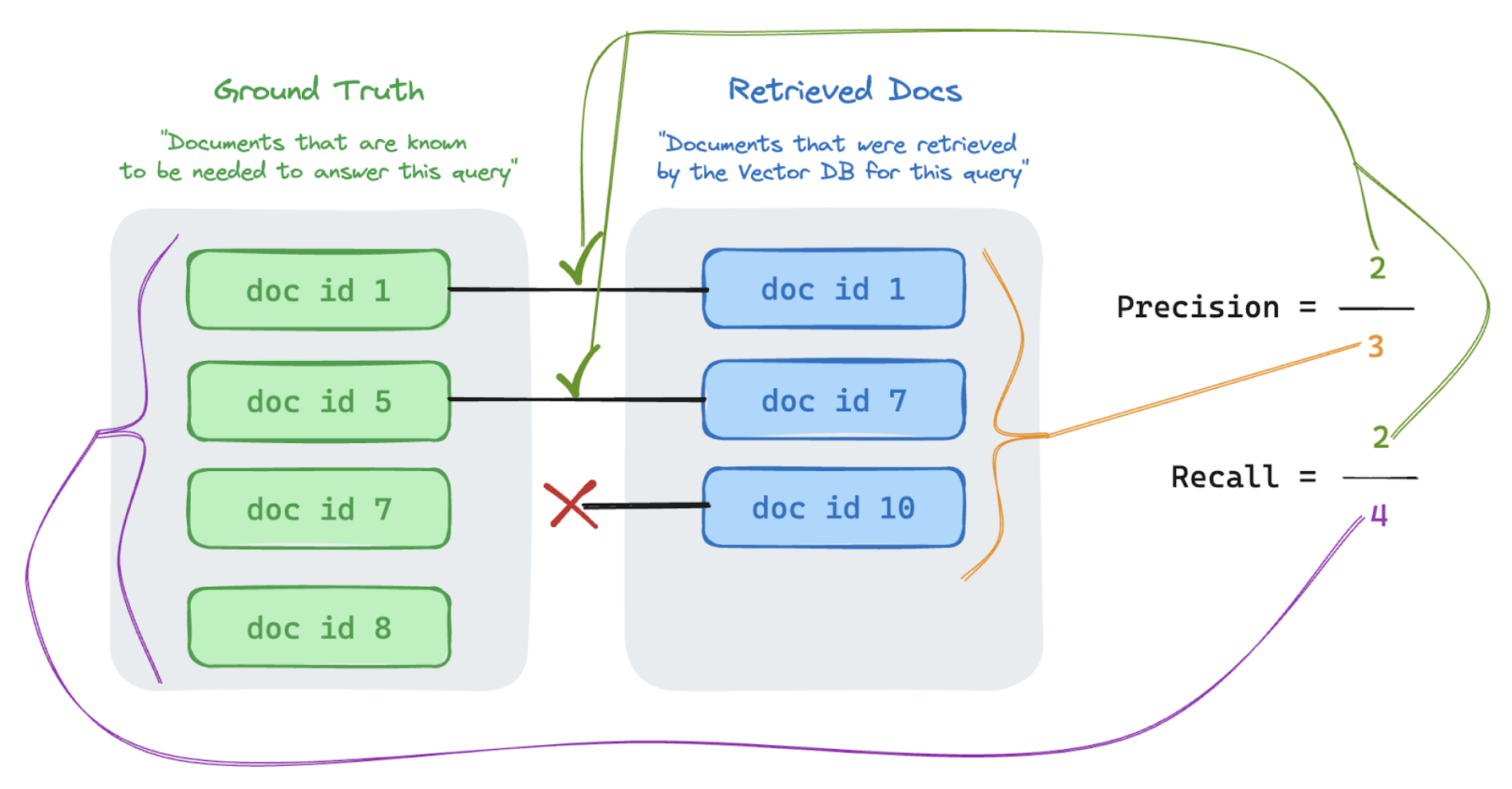

As métricas de recuperação ajudam você a entender se o seu recuperador está fornecendo resultados relevantes. As métricas de recuperação são baseadas em precisão e recuperação.

| Nome da métrica | Pergunta respondida | Detalhes |

|---|---|---|

| Precision | Qual porcentagem das partes recuperadas é relevante para a solicitação? | A precisão é a proporção de documentos recuperados que são realmente relevantes para a solicitação do usuário. Um avaliador LLM pode ser usado para avaliar a relevância de cada parte recuperada para a solicitação do usuário. |

| Chamar de volta | Qual é a porcentagem de documentos de verdade básica que estão representados nas partes recuperadas? | Recall é a proporção dos documentos de verdade fundamental que estão representados nas partes recuperadas. Essa é uma medida da integridade dos resultados. |

Precisão e recall

Abaixo está uma breve introdução sobre a Precisão e Recall adaptada do excelente artigo da Wikipedia.

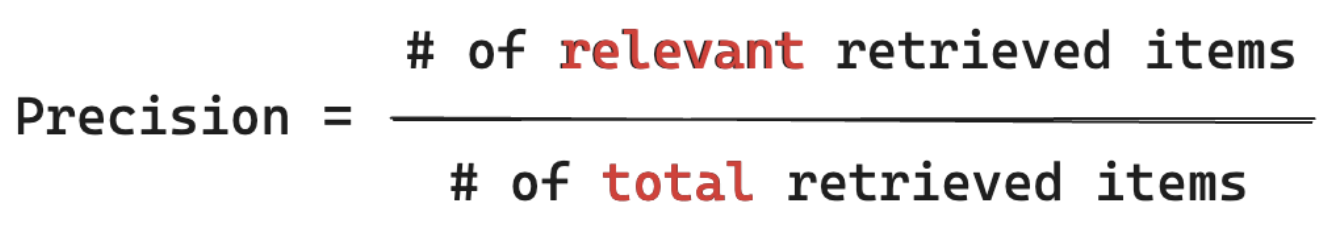

Fórmula da precisão

Precisão mede "Das partes que recuperei, qual % desses itens é realmente relevante para a consulta do meu usuário?" O cálculo da precisão não requer não o conhecimento de todos os itens relevantes.

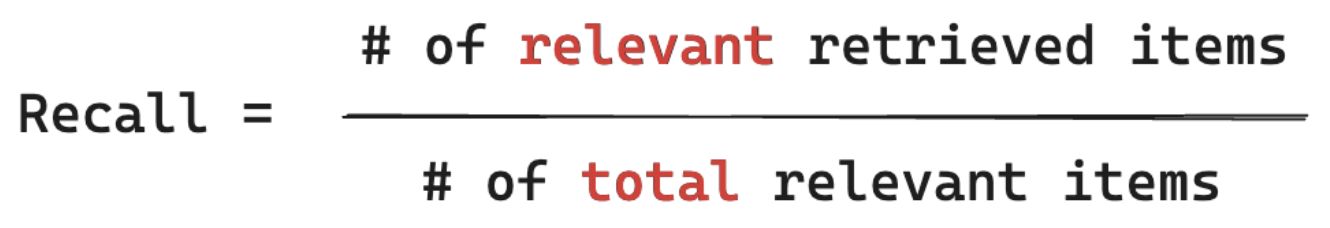

Fórmula de recall

Precisão mede "Das partes que recuperei, qual % desses itens é realmente relevante para a consulta do meu usuário?" O cálculo da recuperação exige que sua verdade básica contenha todos itens relevantes. Os itens podem ser um documento ou uma parte de um documento.

No exemplo abaixo, dois dos três resultados recuperados eram relevantes para a consulta do usuário, portanto a precisão foi de 0,66 (2/3). Os documentos recuperados incluíam dois de um total de quatro documentos relevantes, portanto, a recuperação foi de 0,5 (2/4).