Executar um arquivo em um cluster ou um arquivo ou notebook como um trabalho no Azure Databricks usando a extensão do Databricks para Visual Studio Code

A extensão do Databricks para Visual Studio Code permite que você execute o código Python em um cluster ou o código em Python, R, Scala ou SQL, ou o notebook, como um trabalho no Azure Databricks.

Essas informações pressupõem que você já tenha instalado e configurado a extensão do Databricks para Visual Studio Code. Confira Instalar a extensão do Databricks para Visual Studio Code.

Observação

Para depurar código ou notebooks no Visual Studio Code, use o Databricks Connect. Confira Depurar código usando o Databricks Connect para a extensão do Databricks para Visual Studio Code e Executar e depurar células de notebook com o Databricks Connect usando a extensão do Databricks para Visual Studio Code.

Executar um arquivo Python em um cluster

Para executar um arquivo Python em um cluster do Azure Databricks usando a extensão do Databricks para Visual Studio Code, com a extensão e o projeto abertos, faça o seguinte:

- Abra o arquivo Python que você deseja executar no cluster.

- Realize um dos seguintes procedimentos:

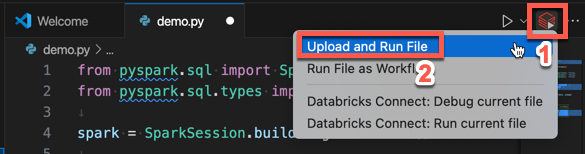

Na barra de título do editor de arquivos, clique no ícone Executar no Databricks e, em seguida, clique em Fazer Upload e Executar Arquivo.

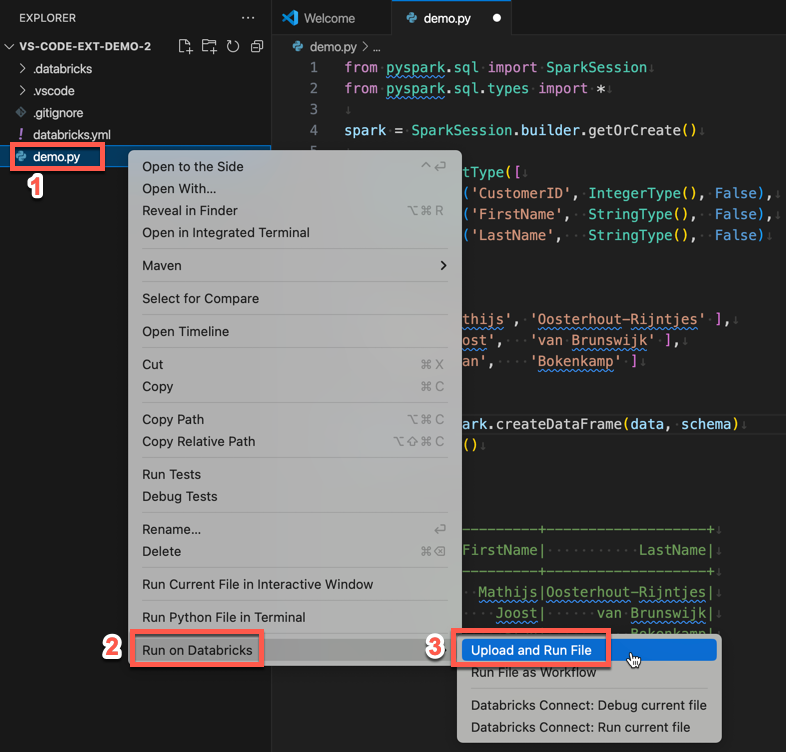

No modo de exibição do Explorer (Exibir > Explorer), clique com o botão direito do mouse no arquivo e selecione Executar no Databricks>Fazer Upload e Executar Arquivo no menu de contexto.

O arquivo é executado no cluster e qualquer saída está disponível no Console de Depuração (Exibir > Console de Depuração).

Executar um arquivo Python como um trabalho

Para executar um arquivo Python como um trabalho do Azure Databricks usando a extensão do Databricks para Visual Studio Code, com a extensão e o projeto abertos, faça o seguinte:

- Abra o arquivo Python que você deseja executar como um trabalho.

- Realize um dos seguintes procedimentos:

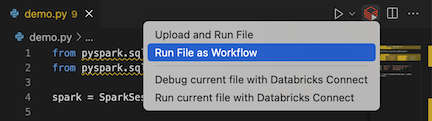

Na barra de título do editor de arquivos, clique no ícone Executar no Databricks e, em seguida, clique em Executar arquivo como fluxo de trabalho.

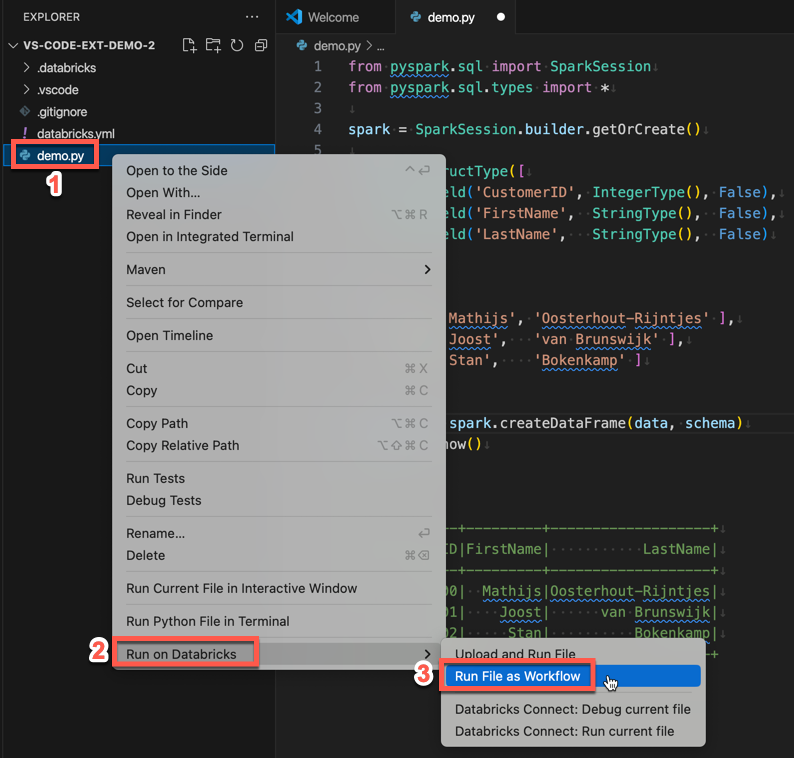

No modo de exibição do Gerenciador (Exibir Gerenciador do >), clique com o botão direito do mouse no arquivo e selecione Executar no Databricks>Executar arquivo como fluxo de trabalho no menu de contexto.

Uma nova guia do editor é exibida, intitulada Execução de Trabalho do Databricks. O arquivo é executado como um trabalho no workspace e as saídas são impressas na área Saída da nova guia do editor.

Para ver informações sobre a execução do trabalho, clique no link ID da execução da tarefa na nova guia editor Execução de Trabalho do Databricks. Seu workspace será aberto e os detalhes da execução do trabalho serão exibidos no workspace.

Executar um notebook Python, R, Scala ou SQL como um trabalho

Para executar um notebook como um trabalho do Azure Databricks usando a extensão do Databricks para Visual Studio Code, com a extensão e o projeto abertos, faça o seguinte:

Abra o notebook que você deseja executar como um trabalho.

Dica

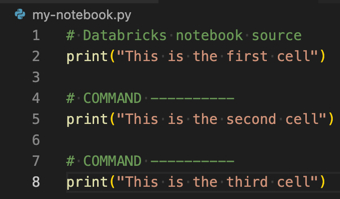

Para transformar um arquivo Python, R, Scala ou SQL em um notebook do Azure Databricks, adicione o comentário

# Databricks notebook sourceao início do arquivo e o comentário# COMMAND ----------antes de cada célula. Para obter mais informações, confira Importar um arquivo e convertê-lo em um notebook.

Realize um dos seguintes procedimentos:

- Na barra de título do editor de arquivos do notebook, clique no ícone Executar no Databricks e, em seguida, clique em Executar arquivo como fluxo de trabalho.

Observação

Se Executar no Databricks como Workflow não estiver disponível, consulte Criar uma configuração de execução personalizada.

- No modo de exibição do Explorer (Exibir > Explorer), clique com o botão direito do mouse no arquivo notebook e selecione Executar no Databricks>Executar arquivo como fluxo de trabalho no menu de contexto.

Uma nova guia do editor é exibida, intitulada Execução de Trabalho do Databricks. O notebook é executado como um trabalho no workspace. O notebook e sua saída são exibidos na área Saída da nova guia do editor.

Para ver informações sobre a execução do trabalho, clique no link ID da execução da tarefa na guia editor Execução de Trabalho do Databricks. Seu workspace será aberto e os detalhes da execução do trabalho serão exibidos no workspace.

Criar uma configuração de execução personalizada

Configurações de execução personalizadas na extensão do Databricks para Visual Studio Code permitem passar argumentos personalizados para um trabalho ou um notebook, ou criar configurações de execução diferentes para arquivos diferentes.

Para criar uma configuração de execução personalizada, clique em Executar > Adicionar Configuração no menu principal do Visual Studio Code. Em seguida, selecione Databricks para uma configuração de execução baseada em cluster ou Databricks: Fluxo de Trabalho para uma configuração de execução baseada em trabalho.

Por exemplo, a seguinte configuração de execução personalizada modifica o comando de inicialização Executar arquivo como fluxo de trabalho para passar o argumento --prod ao trabalho:

{

"version": "0.2.0",

"configurations": [

{

"type": "databricks-workflow",

"request": "launch",

"name": "Run on Databricks as Workflow",

"program": "${file}",

"parameters": {},

"args": ["--prod"]

}

]

}

Dica

Adicione "databricks": true à configuração "type": "python" se quiser usar a configuração do Python, mas usufruir da autenticação do Databricks Connect que faz parte da definição da extensão.

Usando as configurações de execução personalizadas, você também pode passar argumentos da linha de comando e executar o código pressionando F5. Para obter mais informações, veja Iniciar configurações na documentação do Visual Studio Code.