Confiança e segurança do DatabricksIQ

O Databricks entende a importância de seus dados e a confiança que você deposita em nós ao usar a nossa plataforma e os recursos alimentados por DatabricksIQ. O Databricks está comprometido com os mais altos padrões de proteção de dados e implementou medidas rigorosas para garantir que as informações enviadas aos recursos do DatabricksIQ sejam protegidas.

- Seus dados permanecem confidenciais.

- O Databricks não treina modelos de base generativos com dados que você envia a esses recursos e o Databricks não usa esses dados para gerar sugestões exibidas para outros clientes.

- Nossos parceiros de modelo não retêm os dados que você envia por meio desses recursos, mesmo para monitoramento de abuso. Nossos recursos assistenciais de IA com tecnologia de parceiros usam zero pontos de extremidade de retenção de dados dos nossos parceiros de modelo.

- Proteção contra saída prejudicial. O Databricks também usa filtragem de conteúdo do OpenAI do Azure para proteger usuários contra conteúdo prejudicial. Além disso, o Databricks executou uma ampla avaliação com milhares de interações simuladas do usuário para garantir que as proteções implementadas para proteger contra conteúdo nocivo, jailbreaks, geração de código inseguro e uso de conteúdo de direitos autorais de terceiros sejam eficazes.

- O Databricks usa apenas os dados necessários para fornecer o serviço. Os dados só são enviados quando você interage com recursos do DatabricksIQ. O Databricks envia seu prompt, metadados e valores de tabela relevantes, erros, bem como o código de entrada ou consultas para ajudar a retornar resultados mais relevantes. O Databricks não envia outros dados de nível de linha para modelos de terceiros.

- Os dados estão protegidos em trânsito. Todo o tráfego entre o Databricks e os parceiros de modelo é criptografado em trânsito com a criptografia TLS padrão do setor.

- O Databricks oferece controles de residência de dados. Os recursos do DatabricksIQ são Serviços designados e estão em conformidade com os limites de residência de dados. Para obter mais detalhes, consulte Databricks Geos: Residência de dados e Serviços designados do Databricks.

Para obter mais informações sobre a privacidade do Assistente do Databricks, consulte Privacidade e segurança.

Recursos regidos pela configuração de recursos assistivos de IA com tecnologia de parceiro

A IA baseada em parceiros refere-se ao serviço OpenAI do Azure. Veja a seguir um detalhamento dos recursos regidos pela configuração de recursos assistivos de IA com tecnologia de parceiro:

| Recurso | Onde o modelo está hospedado? | Controlado pela configuração de IA com tecnologia de parceiro? |

|---|---|---|

| Chat do Assistente do Databricks | Serviço OpenAI do Azure | Sim |

| Correção rápida | Serviço OpenAI do Azure | Sim |

| Comentários de UC gerados por IA | Workspaces do CSP (perfil de segurança de conformidade): serviço OpenAI do Azure | Sim, para todos os workspaces do CSP. |

| Visualizações assistidas por IA/BI no painel de controle de IA e espaços complementares do Genie | Serviço OpenAI do Azure | Sim |

| Genie | Serviço OpenAI do Azure | Sim |

| Preenchimento automático do Assistente do Databricks | Modelo hospedado pelo Databricks | Não |

| Pesquisa inteligente | Serviço OpenAI do Azure | Sim |

Usar um modelo hospedado no Databricks para o Assistente do Databricks

Importante

Esse recurso está em uma versão prévia.

Saiba mais sobre como usar um modelo hospedado pelo Databricks para alimentar o Assistente do Databricks. Esta seção explica como ele funciona e como usá-lo.

Como ele funciona

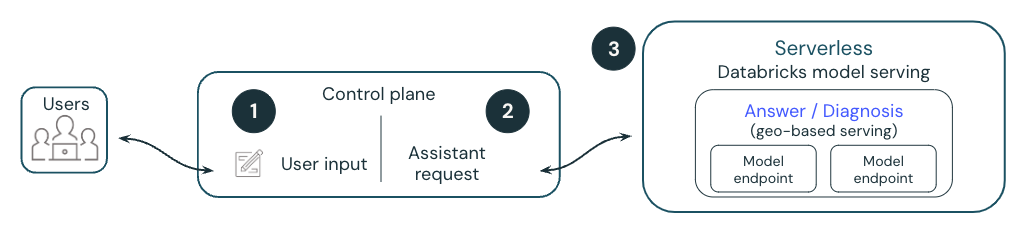

O diagrama a seguir apresenta uma visão geral de como um modelo hospedado pelo Databricks alimenta o Assistente do Databricks.

- Um usuário solicita ao Assistente do Databricks digitando código ou uma pergunta, selecionando Diagnosticar Erro ou destacando uma célula.

- O Databricks anexa metadados a uma solicitação e os envia para um LLM (grande modelo de linguagem) hospedado pelo Databricks. Todos os dados são criptografados quando inativos. Os clientes podem usar uma CMK (chave gerenciada pelo cliente).

- A solicitação do usuário é enviada para o modelo hospedado pelo Databricks.

Os modelos hospedados pelo Databricks usam o Meta Llama 3.x

O Assistente do Databricks com modelos hospedados pelo Databricks atualmente é desenvolvido com o Meta Llama 3. O Meta Llama 3 está licenciado sob a Meta Llama 3 Community License, Copyright © Meta Platforms, Inc. Todos os direitos reservados.

Perguntas frequentes sobre os modelos hospedados pelo Databricks para Assistente

Posso ter minha própria instância de servidor de modelo privado?

Não no momento. Esta versão prévia usa Pontos de extremidade de serviço de modelo que são gerenciados e protegidos pelo Databricks. Os pontos de extremidade de serviço do modelo são sem estado, são protegidos por várias camadas de isolamento e implementam os seguintes controles de segurança para proteger seus dados:

- Cada solicitação do cliente para Serviço de Modelo é logicamente isolada, autenticada e autorizada.

- O Serviço de Modelo de IA Mosaic criptografa todos os dados inativos (AES-256) e em trânsito (TLS 1.2+).

Os metadados enviados aos modelos respeitam as permissões do Catálogo do Unity do usuário?

Sim, todos os dados enviados ao modelo respeitam as permissões do Catálogo do Unity do usuário. Por exemplo, ele não envia metadados relacionados a tabelas as quais o usuário não tem permissão para ver.

Onde os dados são armazenados?

O histórico de chat do Assistente do Databricks é armazenado no banco de dados do painel de controle, junto com o notebook. O banco de dados do painel de controle é criptografado com 256 bits do AES, e os clientes que exigirem controle sobre a chave de criptografia podem utilizar o nosso recurso Chave gerenciada pelo cliente.

Observação

- Assim como outros objetos de workspace, o período de retenção para o histórico de chat do Assistente do Databricks é definido pelo ciclo de vida do objeto. Se um usuário excluir o notebook, isso e qualquer histórico de chat associado serão excluídos em 30 dias.

- Se o notebook for compartilhado com outro usuário, o histórico de chat também ficará visível para esse usuário, a menos que ele seja limpo primeiro.

- Se o notebook for exportado, o histórico de chat não será exportado com ele.

- Se um administrador tiver acesso ao notebook, ele poderá abri-lo e ver o histórico de chat.

Posso trazer minha própria chave de API para o modelo ou hospedar meus próprios modelos?

Não no momento. O Assistente do Databricks é totalmente gerenciado e hospedado pelo Databricks. A funcionalidade do assistente depende fortemente das características de servimento de modelo (por exemplo, chamada de função), assim como do desempenho e qualidade. O Databricks avalia continuamente novos modelos pensando no melhor desempenho e pode atualizar o modelo em versões futuras desse recurso.

Quem é o proprietário dos dados de saída? Se o Assistente gerar códigos, quem será o proprietário desse IP?

O cliente tem uma saída própria.

Recusar o uso de modelos hospedados pelo Databricks

Para recusar o uso de modelos hospedados pelo Databricks:

- Clique no seu nome de usuário na barra superior do workspace do Databricks.

- No menu, selecione Versões Prévias.

- Desative Usar o Assistente com os modelos hospedados pelo Databricks.

Para saber mais sobre como gerenciar versões prévias, consulte Gerenciar versões prévias do Azure Databricks.