Transformar dados executando uma definição de trabalho do Spark do Synapse

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

A atividade de definição de trabalho do Spark do Azure Synapse em um pipeline executa uma definição de trabalho do Spark do Synapse no workspace do Azure Synapse Analytics. Este artigo se baseia no artigo sobre atividades de transformação de dados que apresenta uma visão geral da transformação de dados e as atividades de transformação permitidas.

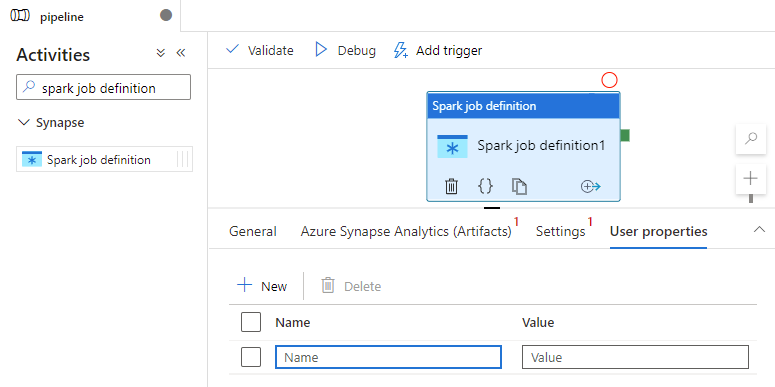

Tela de configuração da definição de trabalho do Apache Spark

Para usar uma atividade de definição de trabalho do Spark para o Synapse em um pipeline, conclua as seguintes etapas:

Configurações gerais

Pesquise por definição de trabalho do Spark no painel de Atividades de pipeline e arraste a atividade de definição de trabalho do Spark embaixo do Synapse até a tela do pipeline.

Selecione a nova atividade de definição de trabalho do Spark na tela se ela ainda não estiver selecionada.

Na guia Geral, insira o exemplo para Nome.

(Opção) Também é possível inserir uma descrição.

Tempo limite: a quantidade máxima de tempo de execução de uma atividade. O padrão é sete dias, que também é a quantidade máxima de tempo permitido. O formato está em D.HH:MM:SS.

Novas tentativas: o número máximo de novas tentativas.

Intervalo de novas tentativas: o número de segundos entre cada nova tentativa.

Saída segura: quando marcada, a saída da atividade não será capturada no log.

Entrada segura: quando marcada, a entrada da atividade não será capturada no log.

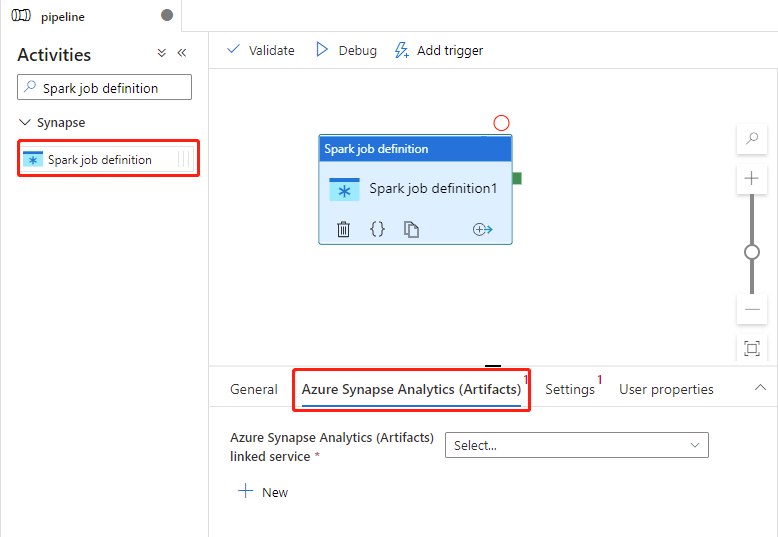

Configurações do Azure Synapse Analytics (Artifacts)

Selecione a nova atividade de definição de trabalho do Spark na tela se ela ainda não estiver selecionada.

Selecione a guia Azure Synapse Analytics (Artifacts) para selecionar ou criar um novo serviço vinculado do Azure Synapse Analytics que executará a atividade de definição de trabalho do Spark.

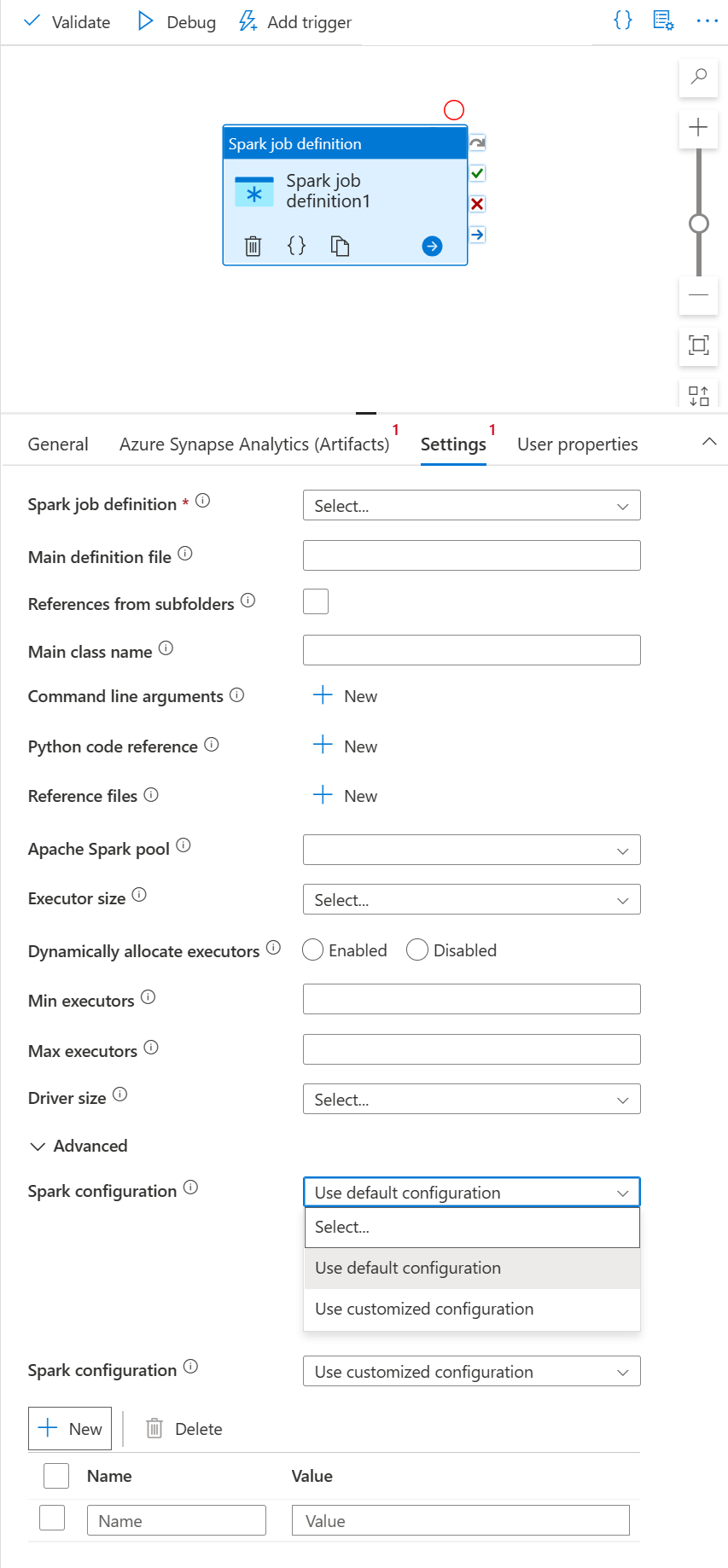

Guia Configurações

Selecione a nova atividade de definição de trabalho do Spark na tela se ela ainda não estiver selecionada.

Selecione a guia Settings (Configurações).

Expanda a lista de definições de trabalho do Spark. Você pode selecionar uma definição de trabalho do Apache Spark existente no workspace do Azure Synapse Analytics vinculado.

(Opcional) Você pode preencher informações para a definição de trabalho do Apache Spark. Quando as configurações a seguir estiverem vazias, as configurações da definição de trabalho do Spark serão usadas para execução. Quando não estiverem vazias, essas configurações substituirão as configurações da definição de trabalho do Spark.

Propriedade Descrição Arquivo de definição principal O arquivo principal usado para o trabalho. Selecione um arquivo ZIP/PY/JAR no armazenamento. Você pode selecionar Carregar arquivo para carregar o arquivo em uma conta de armazenamento.

Exemplo:abfss://…/path/to/wordcount.jarReferências de subpastas Examinando subpastas da pasta raiz do arquivo de definição principal; esses arquivos serão adicionados como arquivos de referência. As pastas chamadas "jars", "pyFiles", "files" ou "archives" serão examinadas e o nome das pastas diferencia maiúsculas de minúsculas. Nome da classe principal O identificador totalmente qualificado ou a classe principal que está no arquivo de definição principal.

Exemplo:WordCountArgumentos de linha de comando É possível adicionar argumentos de linha de comando clicando no botão Novo. Adicionar argumentos de linha de comando substituirá os argumentos da linha de comando estabelecidos pela definição de trabalho do Spark.

Exemplo:abfss://…/path/to/shakespeare.txtabfss://…/path/to/resultPool do Apache Spark Você pode selecionar o pool do Apache Spark na lista. Referência de código Python Arquivos de código python adicionais usados para referência no arquivo de definição principal.

Ele dá suporte à transmissão de arquivos (.py, .py3, .zip) para a propriedade "pyFiles". Ele substituirá a propriedade "pyFiles" configurada na definição de trabalho do Spark.Arquivos de referência Arquivos adicionais usados para referência no arquivo de definição principal. Pool do Apache Spark Você pode selecionar o pool do Apache Spark na lista. Alocar executores dinamicamente Esta configuração é mapeada para a propriedade de alocação dinâmica na configuração do Spark para a alocação de executores do Aplicativo Spark. Mínimo de executores Número mínimo de executores a serem alocados no Pool do Spark especificado para o trabalho. Máximo de executores Número máximo de executores a serem alocados no Pool do Spark especificado para o trabalho. Tamanho do driver Número de núcleos e memória a serem usados para o driver fornecido no pool do Apache Spark especificado para o trabalho. Configuração do Apache Spark Especifique valores para as propriedades de configuração do Spark listadas no tópico: Configuração do Spark – propriedades do aplicativo. Os usuários podem usar a configuração padrão e a configuração personalizada.

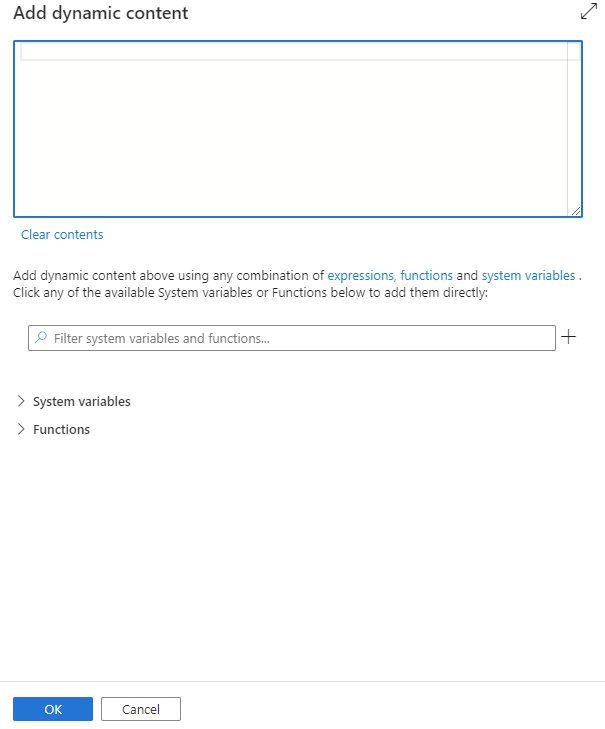

Você pode adicionar conteúdo dinâmico clicando no botão Adicionar conteúdo dinâmico ou pressionando a tecla de atalho Alt+Shift+D. Na página Adicionar conteúdo dinâmico, você pode usar qualquer combinação de expressões, funções e variáveis de sistema para adicionar ao conteúdo dinâmico.

Guia de propriedades do usuário

Você pode adicionar propriedades para a atividade de definição de trabalho do Apache Spark neste painel.

Definição de atividade de definição de trabalho do Spark do Azure Synapse

Aqui está a definição JSON de exemplo de uma atividade de Notebook do Azure Synapse Analytics:

{

"activities": [

{

"name": "Spark job definition1",

"type": "SparkJob",

"dependsOn": [],

"policy": {

"timeout": "7.00:00:00",

"retry": 0,

"retryIntervalInSeconds": 30,

"secureOutput": false,

"secureInput": false

},

"typeProperties": {

"sparkJob": {

"referenceName": {

"value": "Spark job definition 1",

"type": "Expression"

},

"type": "SparkJobDefinitionReference"

}

},

"linkedServiceName": {

"referenceName": "AzureSynapseArtifacts1",

"type": "LinkedServiceReference"

}

}

],

}

Propriedades da definição de trabalho do Spark do Azure Synapse

A tabela a seguir descreve as propriedades JSON usadas na definição de JSON:

| Propriedade | Descrição | Obrigatório |

|---|---|---|

| name | Nome da atividade no pipeline. | Sim |

| descrição | Texto que descreve o que a atividade faz. | Não |

| type | Para a atividade de definição de trabalho do Spark do Azure Synapse, o tipo de atividade é SparkJob. | Sim |

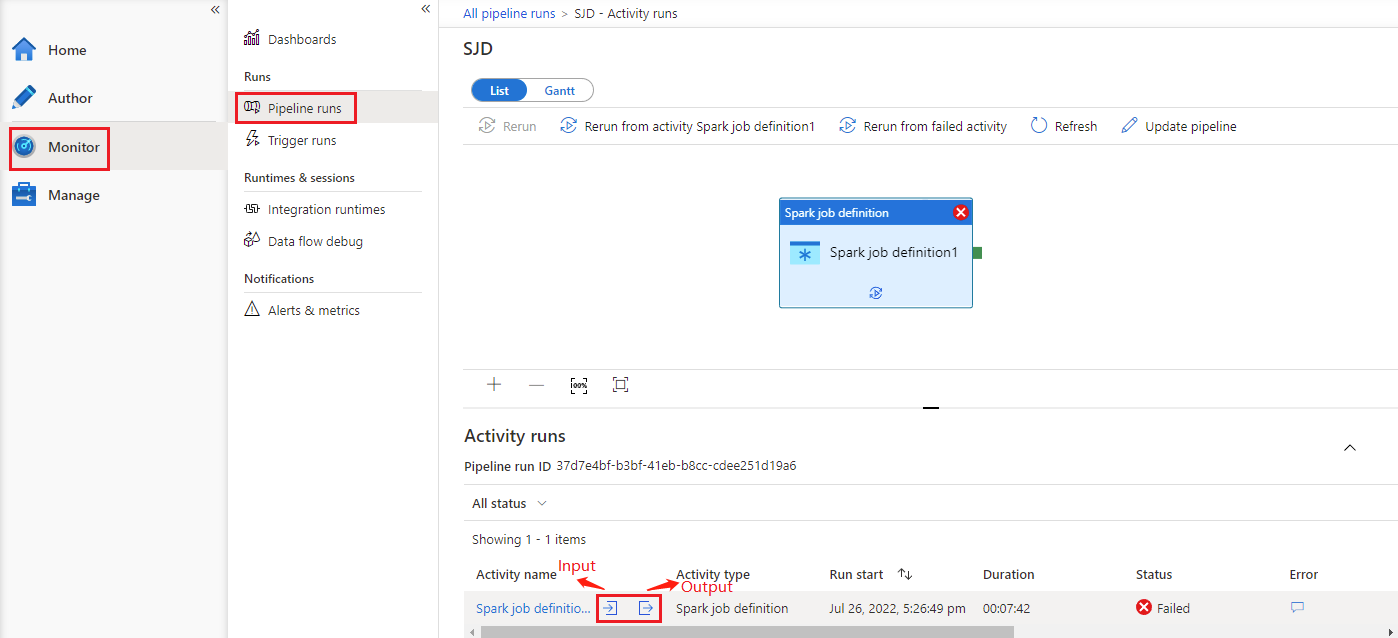

Ver o histórico de execuções de atividades de definição de trabalho do Spark do Azure Synapse

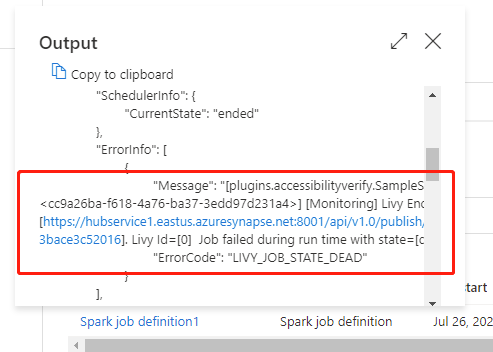

Vá até Execuções de pipeline na guia Monitor e você verá o pipeline acionado. Abra o pipeline que contém a atividade de definição de trabalho do Spark do Azure Synapse para ver o histórico de execuções.

Você pode ver a entrada ou a saída de atividade do notebook selecionando o botão Entrada ou Saída. Se o seu pipeline falhar com um erro de usuário, selecione a saída para verificar o campo resultado e ver o detalhamento do erro de usuário.