Desenvolvimento iterativo e depuração com os pipelines Azure Data Factory e Synapse Analytics

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

O Azure Data Factory e o Synapse Analytics dão suporte ao desenvolvimento iterativo e à depuração de pipelines. Esses recursos permitem que você teste suas alterações antes de criar uma solicitação de pull ou publicá-las no serviço.

Para ver uma introdução de oito minutos e uma demonstração desse recurso, assista ao seguinte vídeo:

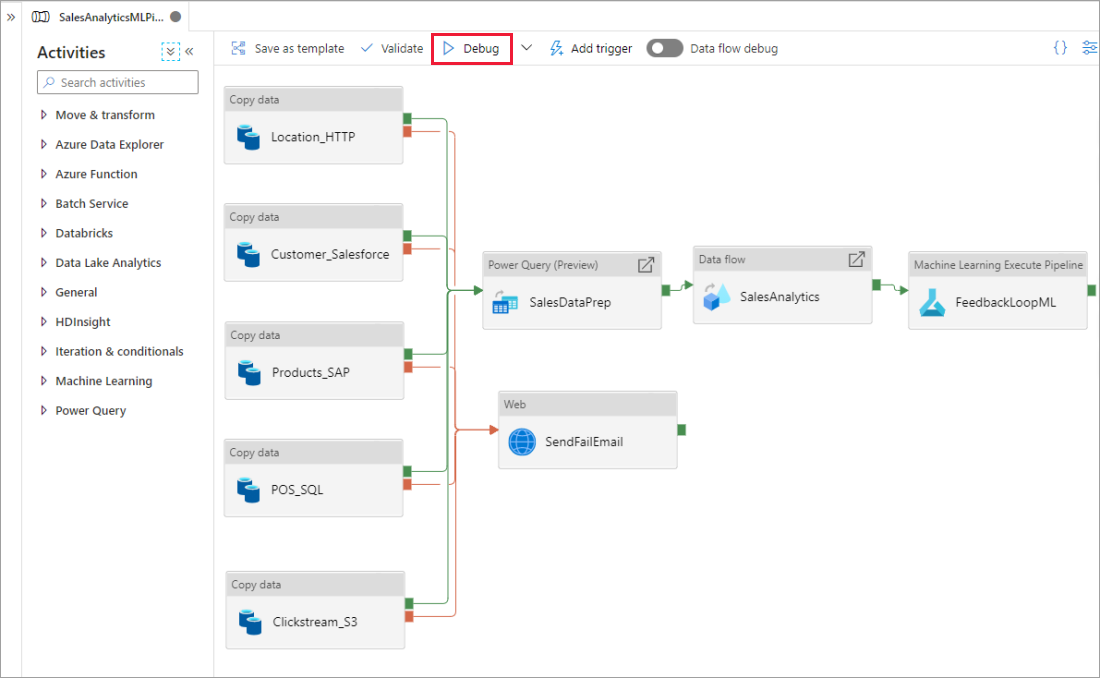

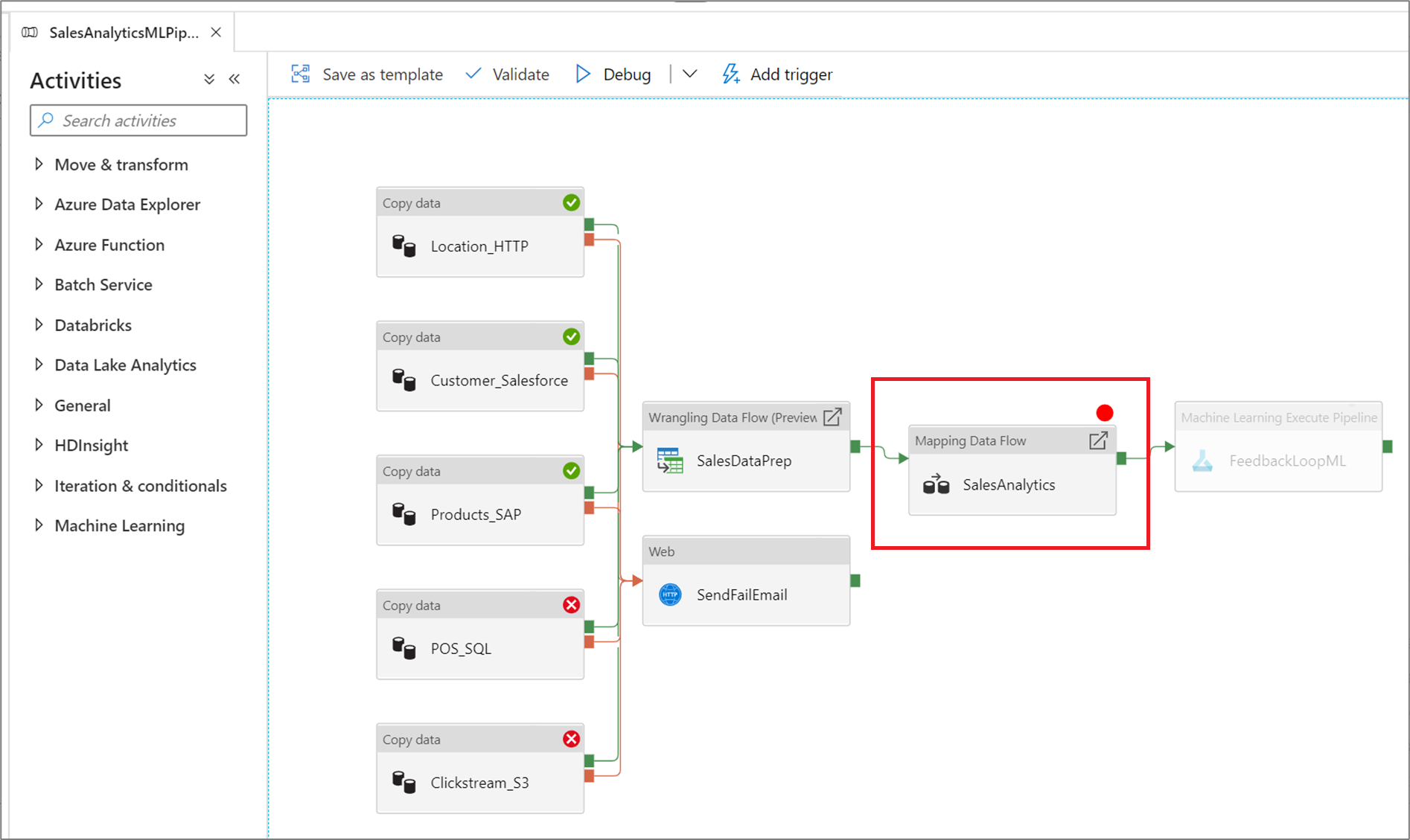

Depuração de um pipeline

Ao criar usando a tela do pipeline, você pode testar suas atividades usando o recurso Depurar Ao fazer execuções de teste, você não precisa publicar suas alterações para o serviço antes de selecionar Depurar. Esse recurso é útil nos cenários em que você deseja garantir que as alterações funcionem conforme o esperado antes de atualizar o fluxo de trabalho do serviço.

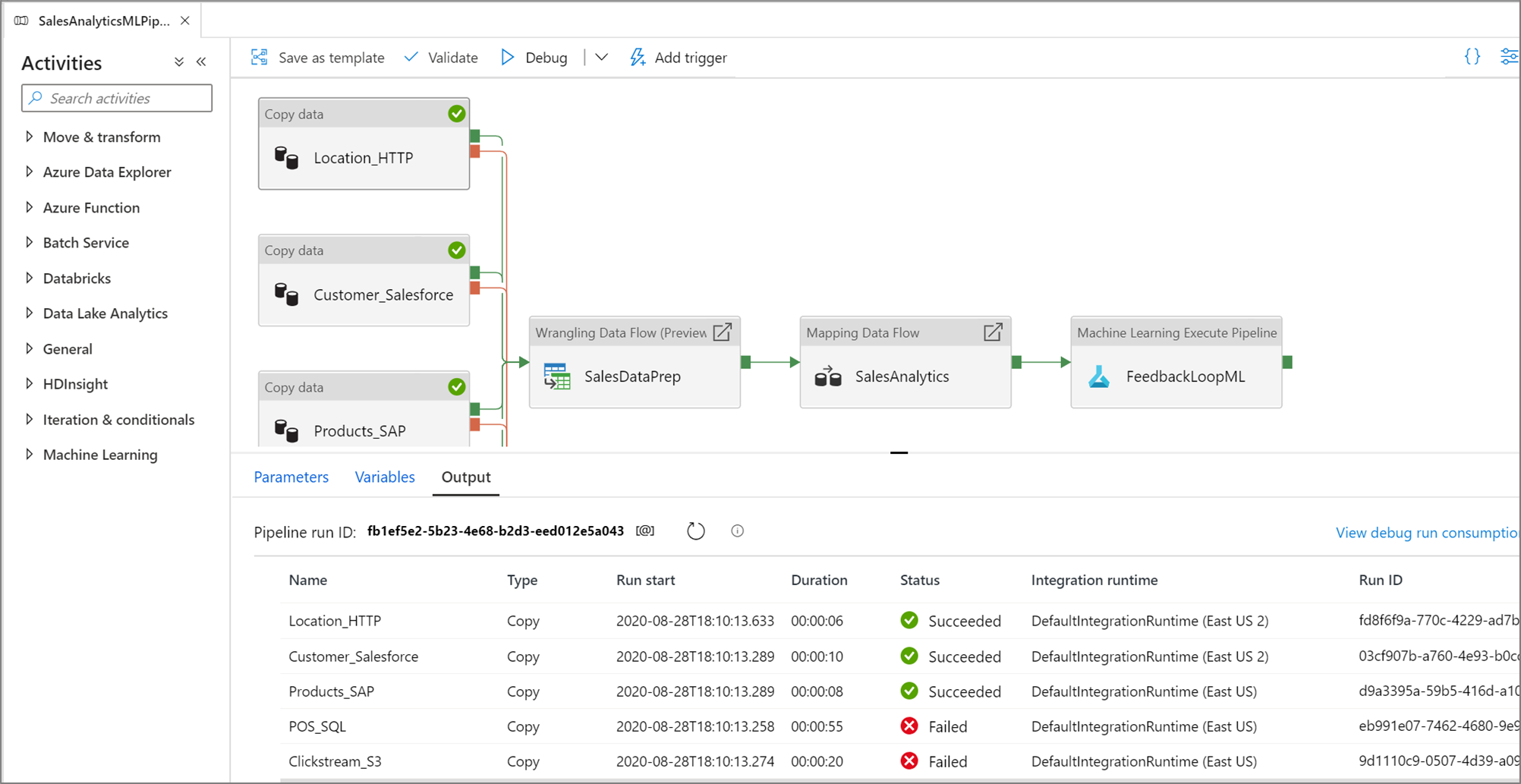

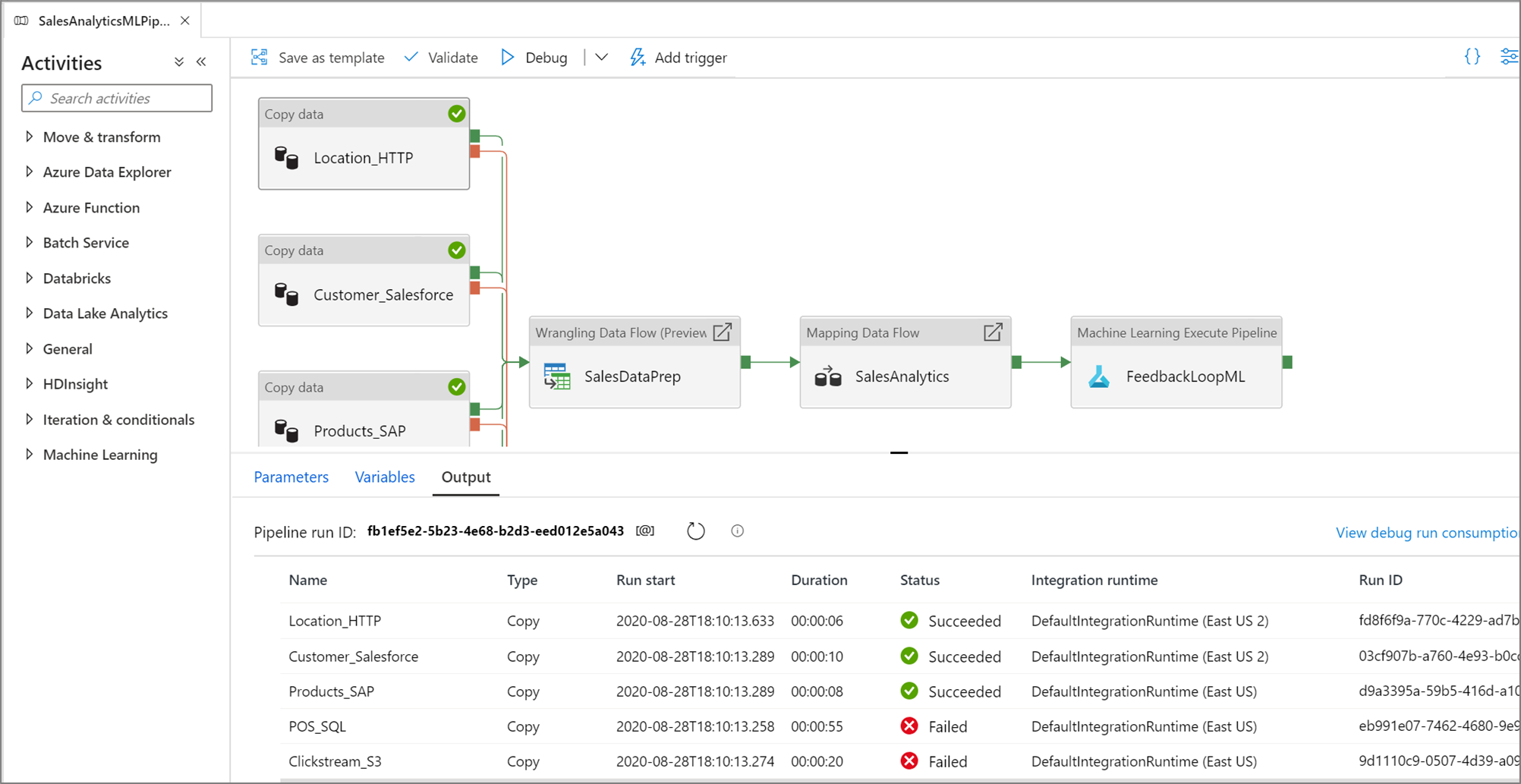

Conforme o pipeline está em execução, você pode ver os resultados de cada atividade na guia Saída da tela do pipeline.

Exiba os resultados das execuções de teste na janela Saída da tela de pipeline.

Depois que uma execução de teste for bem-sucedida, adicione mais atividades ao seu pipeline e continue a depuração de maneira iterativa. Você também pode Cancelar uma execução de teste enquanto ela está em andamento.

Importante

Selecionar Depurar realmente executa o pipeline. Assim, por exemplo, se o pipeline contiver uma atividade de cópia, a execução de teste copiará dados da origem para o destino. Como resultado, é recomendável que você use pastas de teste em suas atividades de cópia e outras atividades durante a depuração. Depois que você tiver depurado pipeline, alterne para as pastas reais que você deseja usar em operações normais.

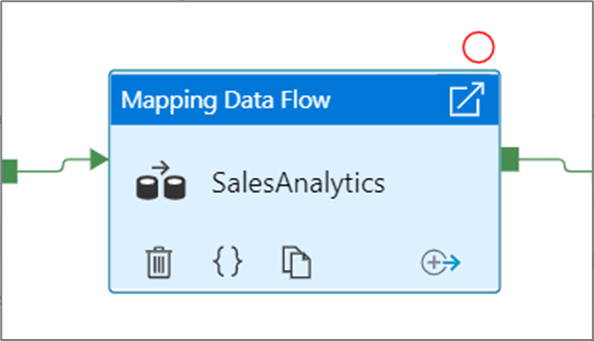

Configuração dos pontos de interrupção

O serviço permite que você depure um pipeline até alcançar uma atividade específica na tela do pipeline. Apenas coloques um ponto de interrupção na atividade até a que você deseja testar e selecione Depurar. O serviço garante que o teste seja executado somente até a atividade de ponto de interrupção na tela de pipeline. Esse recurso Depurar Até é útil quando você não quer testar o pipeline de inteiro, mas apenas um subconjunto das atividades dentro do pipeline.

Para definir um ponto de interrupção, selecione um elemento na tela do pipeline. Uma opção Depurar Até aparece como um círculo vermelho vazio no canto superior direito do elemento.

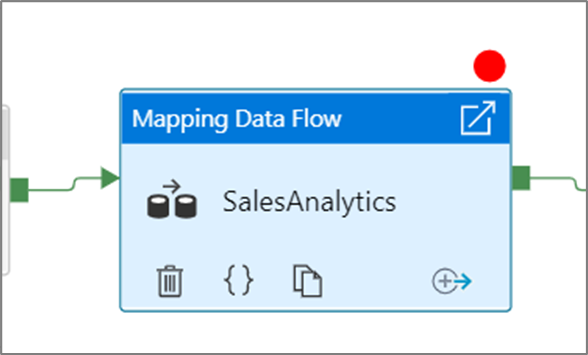

Depois de selecionar a opção Depurar Até, ele é alterado para um círculo vermelho preenchido para indicar que o ponto de interrupção está habilitado.

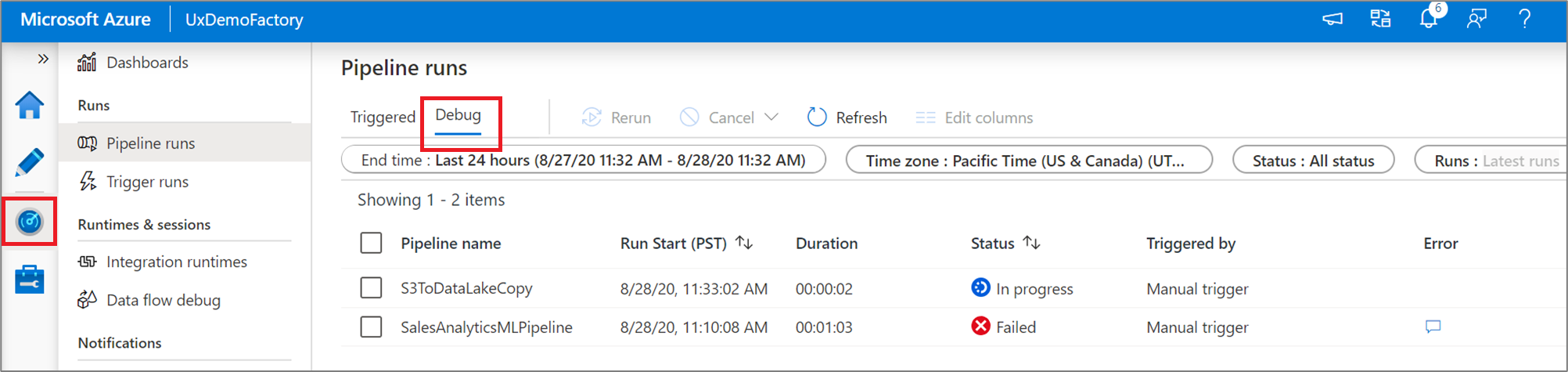

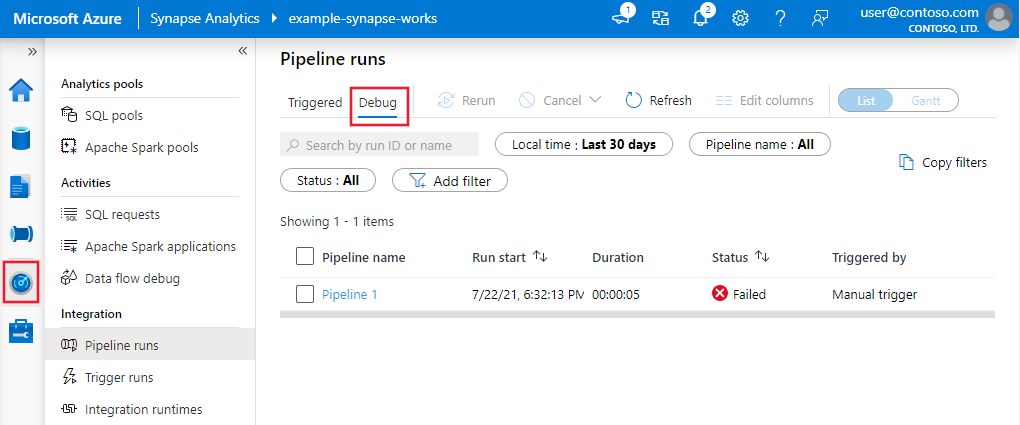

Monitorar execuções de depuração

Quando você executa uma execução de depuração de pipeline, os resultados aparecerão na janela de saída da tela do pipeline. A guia saída conterá apenas a execução mais recente que ocorreu durante a sessão atual do navegador.

Para exibir uma exibição histórica das execuções de depuração ou ver uma lista de todas as execuções de depuração ativas, você pode entrar na experiência do Monitor.

Observação

O serviço só persiste no histórico de execução de depuração por 15 dias.

Depuração de fluxos de dados de mapeamento

O fluxo de dados de mapeamento permite que você crie uma lógica de transformação de dados sem código que é executada em escala. Ao criar sua lógica, você pode ativar uma sessão de depuração para trabalhar interativamente com seus dados usando um cluster do Spark ao vivo. Para saber mais, leia sobre mapear o modo de depuração do fluxo de dados.

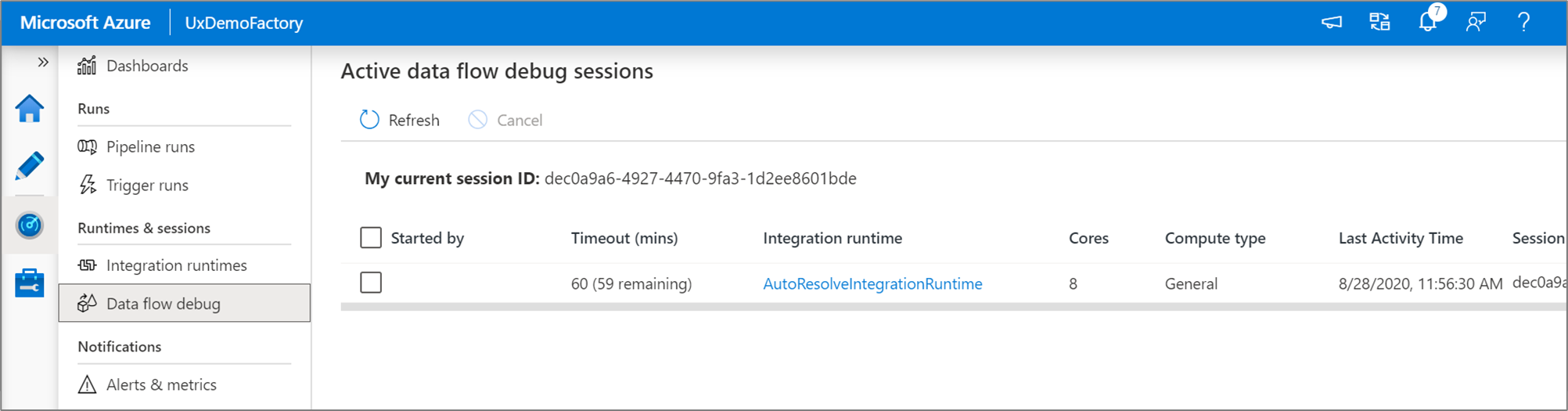

Você pode monitorar sessões de depuração de fluxo de dados ativos na experiência do Monitor.

A visualização de dados no designer de fluxo de dados e a depuração de pipeline de fluxos de dados visam funcionar melhor com pequenos exemplos de dados. No entanto, se você precisar testar sua lógica em um pipeline ou fluxo de dados com base em grandes quantidades de dados, aumente o tamanho do Azure Integration Runtime que está sendo usado na sessão de depuração com mais núcleos e um mínimo de computação de uso geral.

Depurar um pipeline com uma atividade de Fluxo de Dados

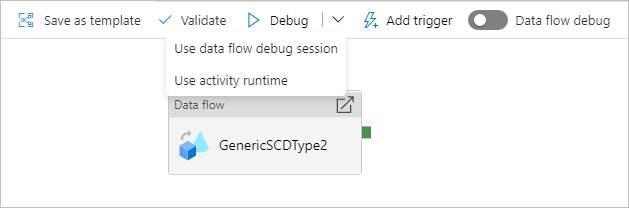

Ao executar um pipeline de depuração executado com um fluxo de dados, você tem duas opções em que computação usar. Você pode usar um cluster de depuração existente ou criar um novo cluster just-in-time para seus fluxos de dados.

O uso de uma sessão de depuração existente reduzirá muito o tempo de inicialização do fluxo de dados, pois o cluster já está em execução, mas não é recomendado para cargas de trabalho complexas ou paralelas, uma vez que pode falhar quando vários trabalhos são executados ao mesmo tempo.

Usar o tempo de execução de atividade criará um novo cluster usando as configurações especificadas em cada tempo de execução de integração da atividade de fluxo de dados. Isso permite que cada trabalho seja isolado e deve ser usado para cargas de trabalhos complexas ou testes de desempenho. Você também pode controlar o TTL no Azure IR para que os recursos de cluster usados para depuração ainda estarão disponíveis para esse período para atender a solicitações de trabalho adicionais.

Observação

Se você tiver um pipeline com fluxos de dados em execução em paralelo ou fluxos de dados que precisam ser testados com grandes conjuntos de dados, escolha "Usar Runtime de Atividade" para que o serviço possa usar o Runtime de integração que você selecionou em sua atividade de fluxo de dados. Isso permitirá que os fluxos de dados executem em vários clusters e possam acomodar suas execuções de fluxo de dados paralelos.

Conteúdo relacionado

Depois de testar suas alterações, promova-as para ambientes mais altos usando a integração e implantação contínua.