Como funciona o gerenciador de orquestração de fluxo de trabalho?

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

Observação

O gerenciador de orquestração de fluxo de trabalho é desenvolvido com Apache Airflow.

Observação

O gerenciador de orquestração de fluxo de trabalho para Azure Data Factory depende do aplicativo Apache Airflow de código aberto. Encontre a documentação e mais tutoriais do Airflow nas páginas Documentação ou Comunidade do Apache Airflow.

O gerenciador de orquestração de fluxo de trabalho no Azure Data Factory usa DAGs (grafos direcionados acíclicos) baseados em Python para executar seus fluxos de trabalho de orquestração. Para usar esse recurso, você precisa fornecer seus DAGs e plug-ins em Armazenamento de Blobs do Azure ou por meio do repositório GitHub. Em seguida, execute e monitore os DAGs iniciando a interface do usuário do Airflow no ADF usando uma CLI (interface de linha de comando) ou um SDK (Software Development Kit).

Criar um ambiente do gerenciador de orquestração de fluxo de trabalho

Confira: Criar um ambiente do gerenciador de orquestração de fluxo de trabalho

Importar DAGs

O gerenciador de orquestração de fluxo de trabalho fornece dois métodos distintos para carregar DAGs de arquivos de origem em Python no ambiente do Airflow. Esses métodos são:

Habilitar o Git Sync: esse serviço permite sincronizar seu repositório GitHub com o gerenciador de orquestração de fluxo de trabalho, permitindo que você importe DAGs diretamente do repositório GitHub. Confira Sincronizar um repositório GitHub no gerenciador de orquestração de fluxo de trabalho

Armazenamento de Blobs do Azure: você pode fazer o upload de seus DAGs, plug-ins, etc. em uma pasta designada dentro de uma conta de armazenamento de blobs vinculada ao Azure Data Factory. Em seguida, importe o caminho do arquivo da pasta no gerenciador de orquestração de fluxo de trabalho. Consulte: Importar DAGs usando o Armazenamento de Blobs do Azure

Remover os DAGs do ambiente do Airflow

Confira Excluir DAGs no gerenciador de orquestração de fluxo de trabalho

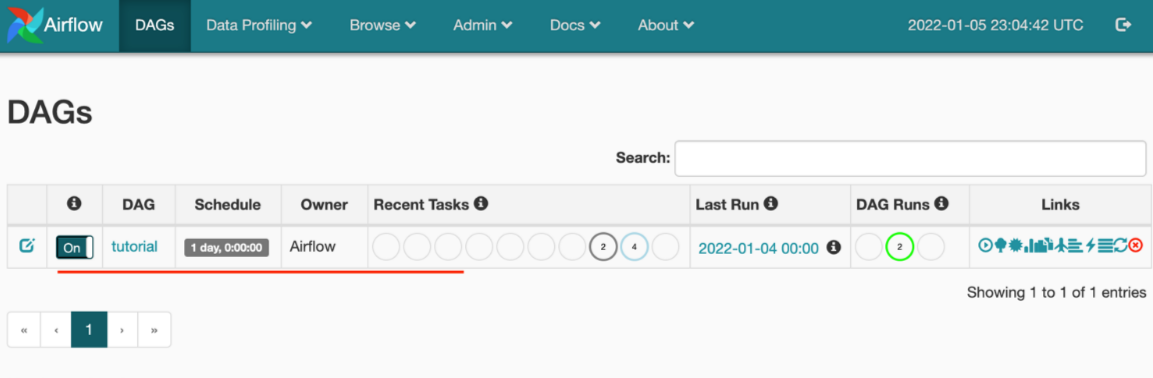

Monitorar as execuções de DAGs

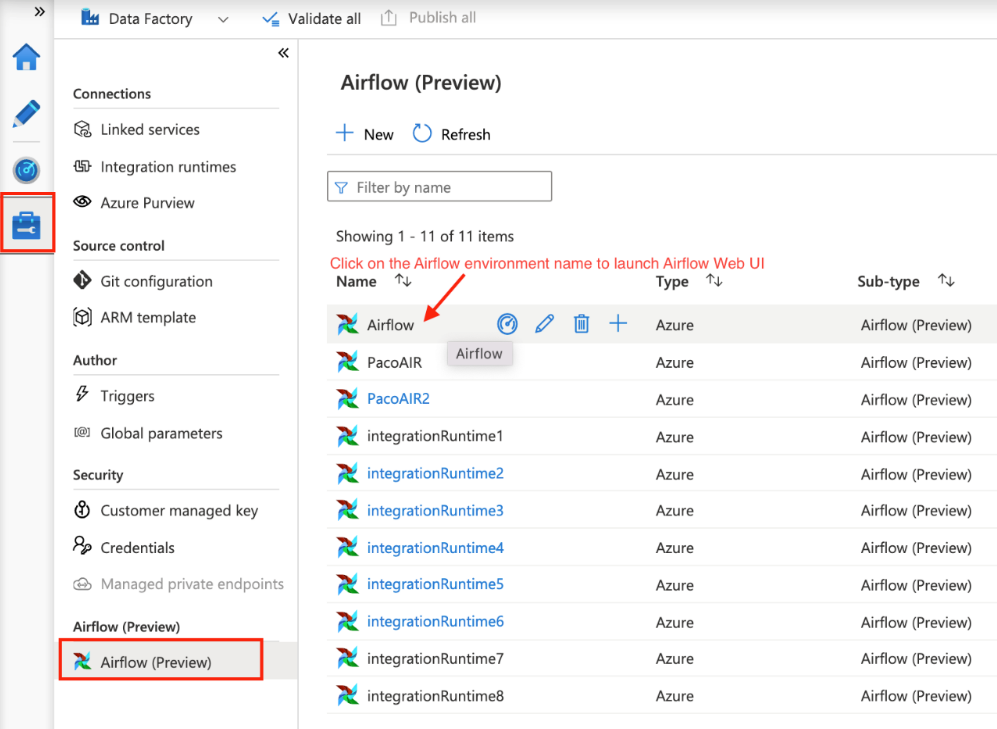

Para monitorar os DAGs do Airflow, entre na interface do usuário do Airflow com o nome de usuário e a senha criados anteriormente.

Selecione o ambiente do Airflow criado.

Conecte-se usando o nome de usuário e a senha fornecidos durante a criação do runtime de integração do Airflow. (Você pode redefinir o nome de usuário ou a senha editando o runtime de integração do Airflow, se necessário)

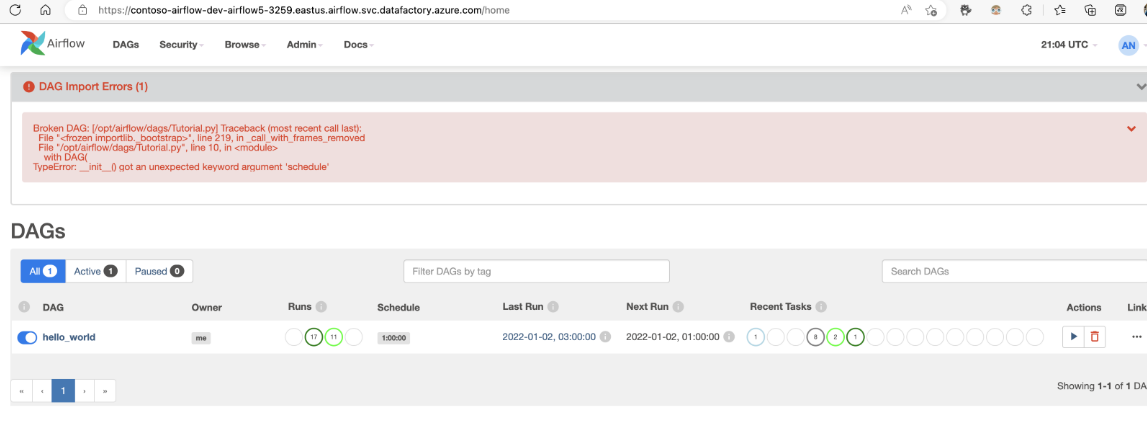

Solução de problemas de importação do DAG

Problema: A importação do DAG leva mais de cinco minutos Mitigação: Reduza o tamanho dos DAGs importados com uma só importação. Uma forma de fazer isso é criando várias pastas de DAGs com os DAGs menores em vários contêineres.

Problema: Os DAGs importados não são exibidos quando você entra na interface do usuário do Airflow. Mitigação: Entre na interface do usuário do Airflow e confira se há erros de análise de DAG. Isso poderá acontecer se os arquivos do DAG contiverem algum código incompatível. Você encontrará os números de linha exatos e os arquivos que têm o problema por meio da interface do usuário do Airflow.