Examinar o padrão de referência de rede de implantação de armazenamento de servidor único para o Azure Local

Aplica-se a: Azure Local 2311.2 e posterior

Este artigo descreve o padrão de referência de rede de armazenamento de servidor único que você pode usar para implantar sua solução local do Azure. As informações neste artigo também ajudam a determinar se essa configuração é viável para suas necessidades de planejamento de implantação. Este artigo é direcionado aos administradores de TI que implantam e gerenciam o Azure Local em seus datacenters.

Para obter informações sobre outros padrões de rede, consulte Padrões de implantação de rede local do Azure.

Introdução

As implantações de servidor único fornecem benefícios de custo e espaço, ajudando a modernizar sua infraestrutura e levar a computação híbrida do Azure para locais que podem tolerar a resiliência de um único computador. O Azure Local em execução em um único computador se comporta de maneira semelhante ao Azure Local em um cluster de vários nós: ele traz integração nativa do Azure Arc, a capacidade de adicionar servidores para escalar horizontalmente o sistema e inclui os mesmos benefícios do Azure.

Ele também dá suporte às mesmas cargas de trabalho, como a AVD (Área de Trabalho Virtual do Azure) e o AKS no Azure Local, e tem suporte e é cobrado da mesma maneira.

Cenários

Use o padrão de armazenamento de servidor único nos seguintes cenários:

Instalações que podem tolerar um nível mais baixo de resiliência. Considere implementar esse padrão sempre que seu local ou serviço fornecido por esse padrão puder tolerar um nível mais baixo de resiliência sem afetar seus negócios.

Alimentos, saúde, finanças, varejo, instalações governamentais. Alguns cenários de alimentos, saúde, finanças e varejo podem aplicar essa opção para minimizar seus custos sem afetar as operações principais e as transações comerciais.

Embora os serviços de Camada 3 (L3) de Rede Definida por Software (SDN) sejam totalmente suportados nesse padrão, os serviços de roteamento, como o BGP (Border Gateway Protocol), podem precisar ser configurados para o dispositivo de firewall no switch TOR (top-of-rack).

Os recursos de segurança de rede, como microssegmentação e QoS (Qualidade de Serviço), não exigem configuração extra para o dispositivo de firewall, pois são implementados na camada do adaptador de rede virtual. Para obter mais informações, consulte Microssegmentação com o Azure Local.

Observação

Os servidores individuais devem usar apenas um único tipo de unidade: unidades NVMe (Non-volatile Memory Express) ou SSD (Solid-State).

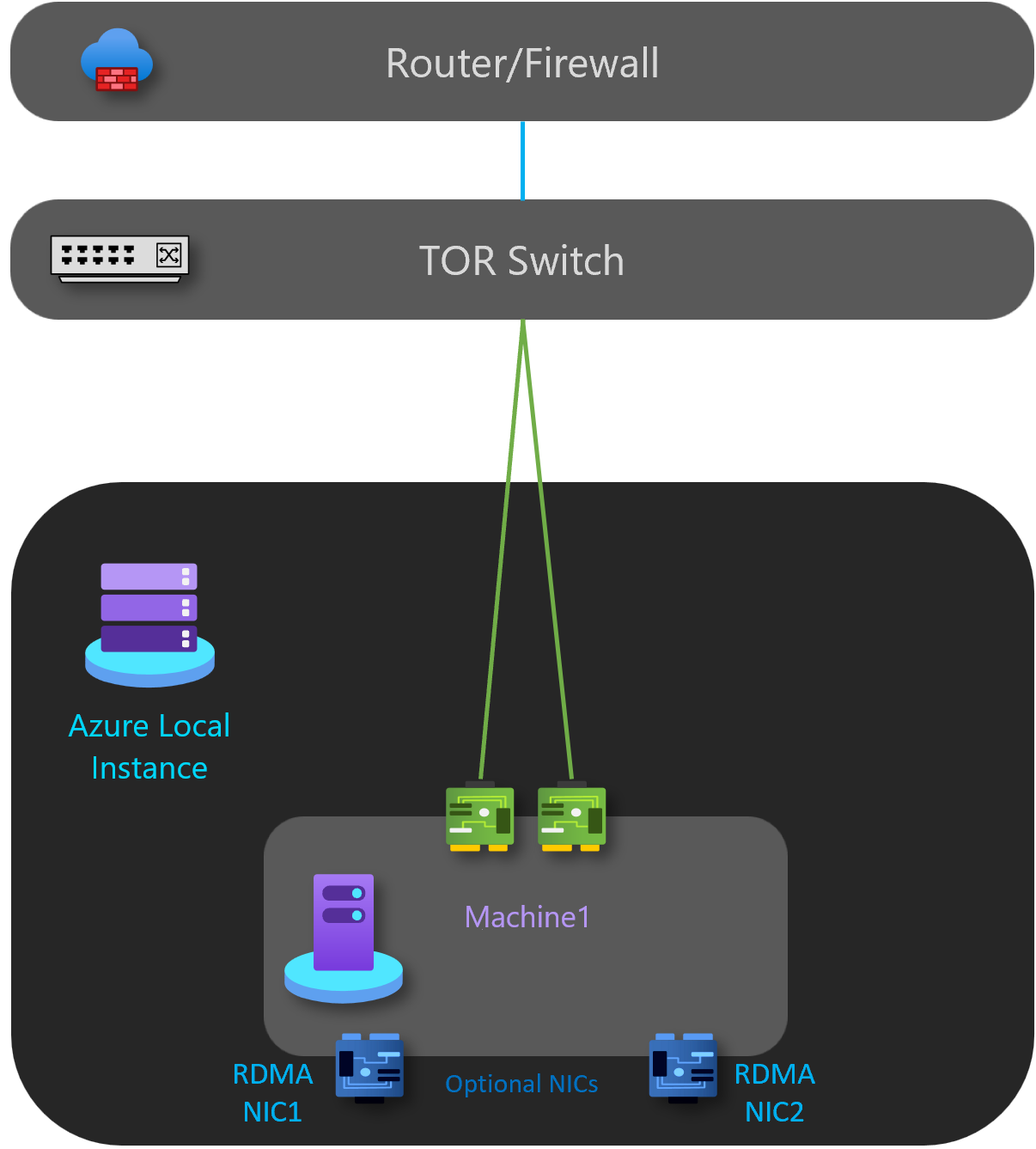

Componentes de conectividade física

Conforme ilustrado no diagrama abaixo, esse padrão tem os seguintes componentes de rede física:

- Para o tráfego para o norte/sul, a instância local do Azure é implementada usando um único comutador L2 ou L3 do TOR.

- Duas portas de rede agrupadas para lidar com o gerenciamento e o tráfego de computação conectado ao switch.

- Duas NICs RDMA desconectadas que só são usadas se adicionarem um segundo servidor ao sistema para expansão. Isso significa que não há aumento de custos para cabeamento ou portas de switch físico.

- (Opcional) Uma placa BMC pode ser usada para permitir o gerenciamento remoto do seu ambiente. Por motivos de segurança, algumas soluções podem usar uma configuração headless sem a placa BMC.

A tabela a seguir lista algumas diretrizes para uma implantação de servidor único:

| Rede | Gerenciamento e computação | Armazenamento | BMC |

|---|---|---|---|

| Velocidade do link | Pelo menos 1 Gbps se o RDMA estiver desabilitado, 10 Gbps recomendado. | Pelo menos 10 Gbps. | Verifique com o fabricante do hardware. |

| Tipo de interface | RJ45, SFP+ ou SFP28 | SFP+ ou SFP28 | RJ45 |

| Portas e agregação | Duas portas agrupadas | Opcional para permitir a adição de um segundo servidor; portas desconectadas. | Uma porta |

| RDMA | Opcional. Depende dos requisitos para suporte a RDMA e NIC de convidado. | N/D | N/D |

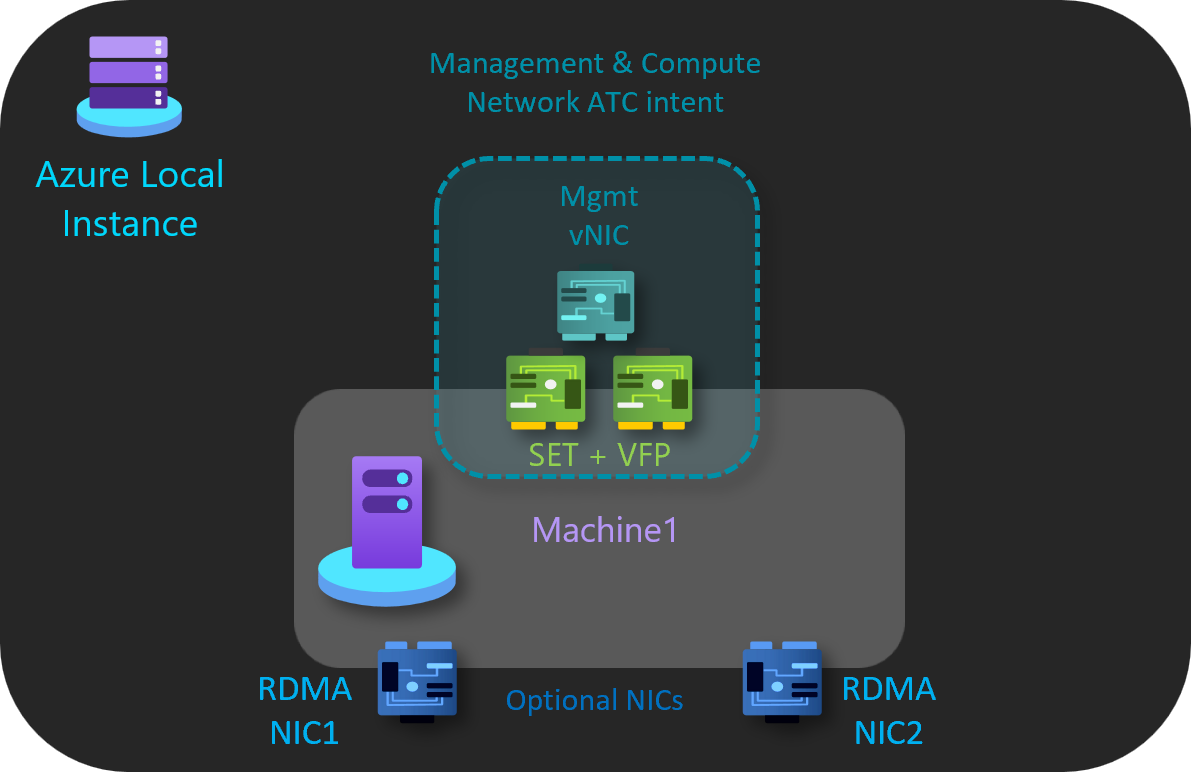

Intenções da ATC de Rede

O padrão de servidor único usa apenas uma intenção da ATC de Rede para gerenciamento e tráfego de computação. As interfaces de rede RDMA são opcionais e desconectadas.

Intenção de gerenciamento e computação

A intenção de gerenciamento e computação tem as seguintes características:

- Tipo de intent: gerenciamento e computação

- Modo de intent: modo de cluster

- Agrupamento: Sim - pNIC01 e pNIC02 são agrupados

- VLAN de gerenciamento padrão: VLAN configurada para adaptadores de gerenciamento é ummodified

- VLAN e vNICs PA: A ATC de rede é transparente para vNICs e VLANs PA

- VLANs e vNICs de computação: a ATC de rede é transparente para computar vNICs e VLANs de VM

Intenção de armazenamento

A intenção de armazenamento tem as seguintes características:

- Tipo de intenção: Nenhum

- Modo de intenção: Nenhum

- Agrupamento: pNIC03 e pNIC04 estão desconectados

- VLANs padrão: nenhuma

- Sub-redes padrão: Nenhuma

Siga estas etapas para criar uma intenção de rede para esse padrão de referência:

Execute o PowerShell como Administrador.

Execute o comando a seguir:

Add-NetIntent -Name <management_compute> -Management -Compute -ClusterName <HCI01> -AdapterName <pNIC01, pNIC02>

Para obter mais informações, consulte Implantar rede de host: intenção de computação e gerenciamento.

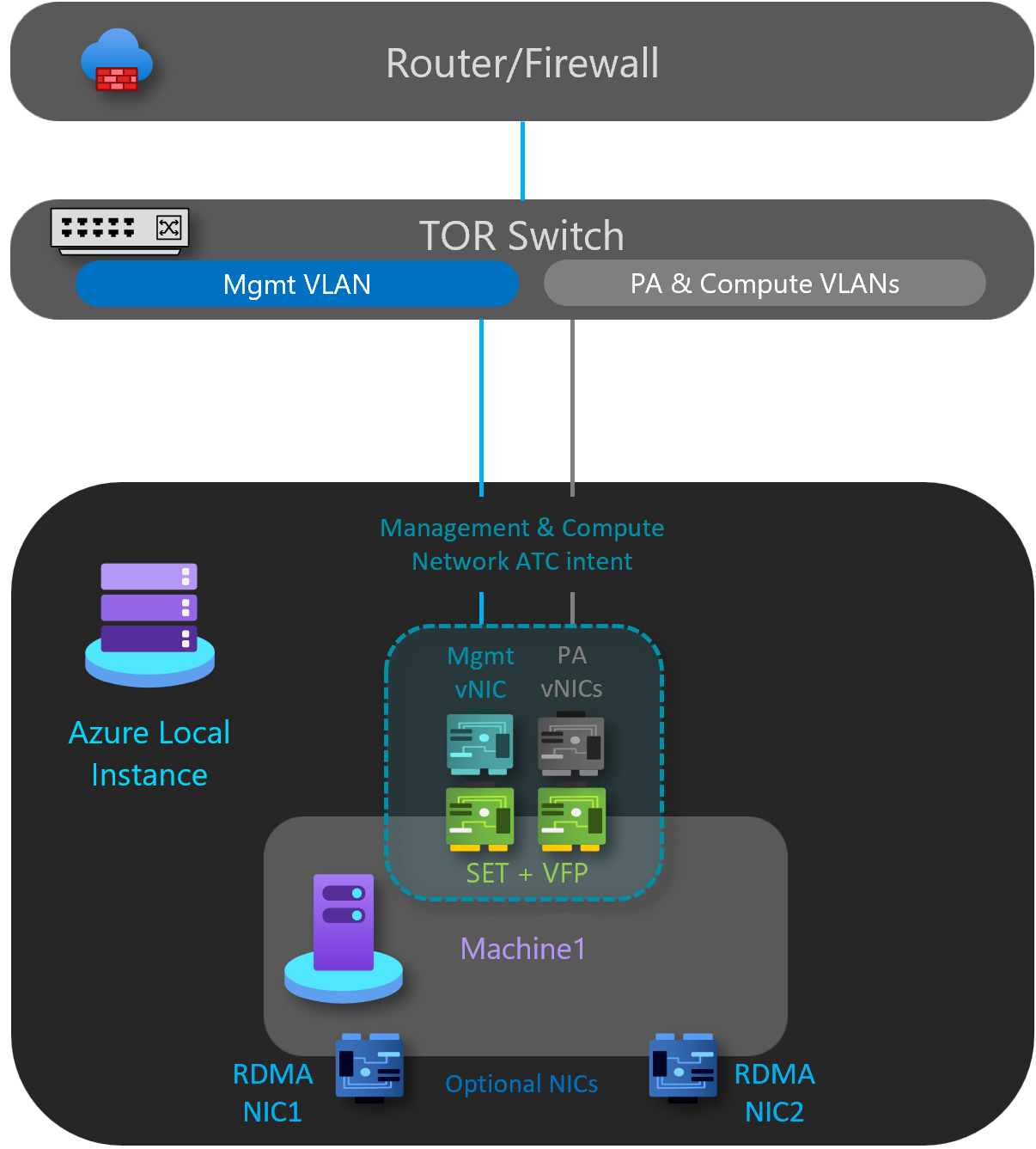

Componentes lógicos de rede

Conforme ilustrado no diagrama abaixo, esse padrão tem os seguintes componentes lógicos de rede:

VLANs de rede de armazenamento

Opcional – esse padrão não requer uma rede de armazenamento.

Rede OOB

A rede Out of Band (OOB) é dedicada a suportar a interface de gerenciamento de servidor "lights-out", também conhecida como controlador de gerenciamento de placa base (BMC). Cada interface BMC se conecta a um switch fornecido pelo cliente. O BMC é usado para automatizar cenários de inicialização PXE.

A rede de gerenciamento requer acesso à interface BMC usando a porta UDP (User Datagram Protocol) 623 da IPMI (Intelligent Platform Management Interface).

A rede OOB é isolada das cargas de trabalho de computação e é opcional para implantações não baseadas em solução.

VLAN de gerenciamento

Todos os hosts de computação física exigem acesso à rede lógica de gerenciamento. Para o planejamento de endereço IP, cada host de computação física deve ter pelo menos um endereço IP atribuído da rede lógica de gerenciamento.

Um servidor DHCP pode atribuir automaticamente endereços IP para a rede de gerenciamento ou você pode atribuir manualmente endereços IP estáticos. Quando o DHCP é o método de atribuição de IP preferencial, recomendamos que você use reservas DHCP sem expiração.

A rede de gerenciamento oferece suporte às seguintes configurações de VLAN:

VLAN nativa – você não precisa fornecer IDs de VLAN. Isso é necessário para instalações baseadas em solução.

VLAN marcada - você fornece IDs de VLAN no momento da implantação. conexões de locatário em cada gateway e alterna os fluxos de tráfego de rede para um gateway em espera se um gateway falhar.

Os gateways usam o Border Gateway Protocol para anunciar endpoints GRE e estabelecer conexões ponto a ponto. A implantação da SDN cria um pool de gateway padrão que dá suporte a todos os tipos de conexão. Nesse pool, você pode especificar quantos gateways são reservados em espera caso um gateway ativo falhe.

Para obter mais informações, consulte O que é o Gateway RAS para SDN?

A rede de gerenciamento dá suporte a todo o tráfego usado para gerenciamento do cluster, incluindo Área de Trabalho Remota, Windows Admin Center e Active Directory.

Para obter mais informações, consulte Planejar uma infraestrutura de SDN: provedor de gerenciamento e HNV.

VLANs de computação

Em alguns cenários, você não precisa usar Redes Virtuais SDN com encapsulamento VXLAN (Virtual Extensible LAN). Em vez disso, você pode usar VLANs tradicionais para isolar suas cargas de trabalho de locatário. Essas VLANs são configuradas na porta do switch TOR no modo tronco. Ao conectar novas VMs a essas VLANs, a marca VLAN correspondente é definida no adaptador de rede virtual.

Rede de PA (Endereço do Provedor) de HNV

A rede de PA (Endereço do Provedor) da HNV (Virtualização de Rede Hyper-V) serve como a rede física subjacente para o tráfego de locatário Leste/Oeste (interno-interno), o tráfego de locatário Norte/Sul (externo-interno) e para trocar informações de emparelhamento BGP com a rede física. Essa rede só é necessária quando há necessidade de implantar redes virtuais usando o encapsulamento VXLAN para outra camada de isolamento e para multilocação de rede.

Para obter mais informações, consulte Planejar uma infraestrutura de SDN: provedor de gerenciamento e HNV.

Opções de isolamento de rede

As seguintes opções de isolamento de rede são suportadas:

VLANs (IEEE 802.1Q)

As VLANs permitem que dispositivos que devem ser mantidos separados compartilhem o cabeamento de uma rede física e ainda sejam impedidos de interagir diretamente uns com os outros. Esse compartilhamento gerenciado gera ganhos em simplicidade, segurança, gerenciamento de tráfego e economia. Por exemplo, uma VLAN pode ser usada para separar o tráfego dentro de uma empresa com base em usuários individuais ou grupos de usuários ou suas funções, ou com base nas características do tráfego. Muitos serviços de hospedagem na Internet usam VLANs para separar zonas privadas umas das outras, permitindo que os servidores de cada cliente sejam agrupados em um único segmento de rede, independentemente de onde os servidores individuais estejam localizados no data center. Algumas precauções são necessárias para evitar que o tráfego "escape" de uma determinada VLAN, uma exploração conhecida como salto de VLAN.

Para obter mais informações, consulte Entender o uso de redes virtuais e VLANs.

Políticas de acesso à rede padrão e microssegmentação

As políticas de acesso à rede padrão garantem que todas as VMs (máquinas virtuais) em seu cluster do Azure Stack HCI estejam protegidas por padrão contra ameaças externas. Com essas políticas, bloquearemos o acesso de entrada a uma VM por padrão, ao mesmo tempo em que damos a opção de habilitar portas de entrada seletivas e, assim, proteger as VMs contra ataques externos. Essa imposição está disponível por meio de ferramentas de gerenciamento como Windows Admin Center.

A microssegmentação envolve a criação de políticas de rede granulares entre aplicativos e serviços. Isso essencialmente reduz o perímetro de segurança a uma cerca em torno de cada aplicativo ou VM. Essa cerca permite apenas a comunicação necessária entre as camadas de aplicativos ou outros limites lógicos, tornando extremamente difícil para as ameaças cibernéticas se espalharem lateralmente de um sistema para outro. A microssegmentação isola com segurança as redes umas das outras e reduz a superfície de ataque total de um incidente de segurança de rede.

As políticas de acesso à rede padrão e a microssegmentação são realizadas como regras de firewall com estado de cinco tuplas (prefixo de endereço de origem, porta de origem, prefixo de endereço de destino, porta de destino e protocolo) em clusters do Azure Stack HCI. As regras de firewall também são conhecidas como NSGs (Grupos de Segurança de Rede). Essas políticas são impostas na porta vSwitch de cada VM. As políticas são enviadas por push pela camada de gerenciamento e o Controlador de Rede SDN as distribui para todos os hosts aplicáveis. Essas políticas estão disponíveis para VMs em redes VLAN tradicionais e em redes de sobreposição SDN.

Para obter mais informações, consulte O que é o Firewall do Datacenter?.

QoS para adaptadores de rede VM

Você pode configurar a QoS (Qualidade de Serviço) para um adaptador de rede VM para limitar a largura de banda em uma interface virtual para impedir que uma VM de alto tráfego concorra com outro tráfego de rede VM. Você também pode configurar a QoS para reservar uma quantidade específica de largura de banda para uma VM para garantir que a VM possa enviar tráfego independentemente de outro tráfego na rede. Isso pode ser aplicado a VMs anexadas a redes VLAN tradicionais, bem como VMs anexadas a redes de sobreposição da SDN.

Para obter mais informações, consulte Configurar QoS para um adaptador de rede VM.

Redes virtuais

A virtualização de rede fornece redes virtuais para VMs de forma semelhante à virtualização de servidor (hipervisor) fornece VMs para o sistema operacional. A virtualização de rede desacopla as redes virtuais da infraestrutura de rede física e remove as restrições de VLAN e atribuição de endereço IP hierárquico do provisionamento de VM. Essa flexibilidade facilita a migração para nuvens IaaS (infraestrutura como serviço) e é eficiente para hosters e administradores de datacenter gerenciarem sua infraestrutura e manterem o isolamento multilocatário necessário, os requisitos de segurança e os endereços IP de VM sobrepostos.

Para obter mais informações, consulte Virtualização de rede Hyper-V.

Opções de serviços de rede L3

As seguintes opções de serviço de rede L3 estão disponíveis:

Emparelhamento de rede virtual

O emparelhamento de rede virtual permite conectar duas redes virtuais perfeitamente. Uma vez emparelhadas, para fins de conectividade, as redes virtuais aparecem como uma delas. Os benefícios do uso do emparelhamento de rede virtual incluem:

- O tráfego entre VMs nas redes virtuais emparelhadas é roteado por meio da infraestrutura de backbone somente por meio de endereços IP privados. A comunicação entre as redes virtuais não requer Internet pública ou gateways.

- Baixa latência, conexão com largura de banda alta entre os recursos em redes virtuais diferentes.

- A capacidade de recursos em uma rede virtual para se comunicar com recursos em uma rede virtual diferente.

- Não há tempo de inatividade para recursos em nenhuma das redes virtuais ao criar o emparelhamento.

Para obter mais informações, consulte Emparelhamento de rede virtual do Azure.

Balanceador de carga de software SDN

Os CSPs (Provedores de Serviços de Nuvem) e as empresas que implantam SDN (Rede Definida pelo Software) podem usar o SLB (Balanceador de Carga de Software) para distribuir uniformemente o tráfego de rede do cliente entre os recursos de rede virtual. O SLB permite que vários servidores hospedem a mesma carga de trabalho, fornecendo alta disponibilidade e escalabilidade. Ele também é usado para fornecer serviços NAT (Conversão de Endereços de Rede) de entrada para acesso de entrada a VMs e serviços NAT de saída para conectividade de saída.

Usando o SLB, você pode escalar horizontalmente seus recursos de balanceamento de carga usando VMs SLB nos mesmos servidores de computação Hyper-V que você usa para suas outras cargas de trabalho de VM. O SLB dá suporte à criação e exclusão rápidas de pontos de extremidade de balanceamento de carga, conforme necessário para operações de CSP. Além disso, o SLB dá suporte a dezenas de gigabytes por cluster, fornece um modelo de provisionamento simples e é fácil de escalar horizontalmente e horizontalmente. O SLB usa o Border Gateway Protocol para anunciar endereços IP virtuais para a rede física.

Para obter mais informações, consulte O que é SLB para SDN?

Gateways de VPN SDN

O Gateway de SDN é um roteador compatível com BGP (Border Gateway Protocol) baseado em software projetado para CSPs e empresas que hospedam redes virtuais multilocatários usando a HNV (Virtualização de Rede Hyper-V). Você pode usar o Gateway de RAS para rotear o tráfego de rede entre uma rede virtual e outra rede, local ou remota.

O Gateway SDN pode ser usado para:

Crie conexões IPsec site a site seguras entre redes virtuais SDN e redes de clientes externos pela Internet.

Crie conexões GRE (Encapsulamento de Roteamento Genérico) entre redes virtuais SDN e redes externas. A diferença entre conexões site a site e conexões GRE é que a última não é uma conexão criptografada.

Para obter mais informações sobre cenários de conectividade GRE, consulte Túnel GRE no Windows Server.

Crie conexões de Camada 3 (L3) entre redes virtuais SDN e redes externas. Nesse caso, o gateway SDN simplesmente atua como um roteador entre sua rede virtual e a rede externa.

O Gateway SDN requer o Controlador de Rede SDN. O Controlador de Rede executa a implantação de pools de gateway, configura

Próximas etapas

Saiba mais sobre padrões de dois nós – padrões de implantação de rede local do Azure.