Ferramenta LLM para fluxos no Estúdio de IA do Azure

Importante

Os itens marcados (versão prévia) neste artigo estão atualmente em versão prévia pública. Essa versão prévia é fornecida sem um contrato de nível de serviço e não recomendamos isso para cargas de trabalho de produção. Alguns recursos podem não ter suporte ou podem ter restrição de recursos. Para obter mais informações, consulte Termos de Uso Complementares de Versões Prévias do Microsoft Azure.

Para usar LLMs (modelos grandes de linguagem) para processamento de linguagem natural, utilize a ferramenta LLM de prompt flow.

Observação

Para que as inserções convertam texto em representações vetoriais densas para várias tarefas de NLP, confira Ferramenta de inserção.

Pré-requisitos

Prepare uma solicitação conforme descrito na documentação da Ferramenta de solicitação. A ferramenta LLM e a ferramenta de Prompt dão suporte a modelos Jinja. Para ver mais informações e as melhores práticas, confira Técnicas de engenharia de solicitação.

Compilar com a ferramenta LLM

Crie ou abra um fluxo no Estúdio de IA do Azure. Para obter mais informações, consulteCriar um fluxo.

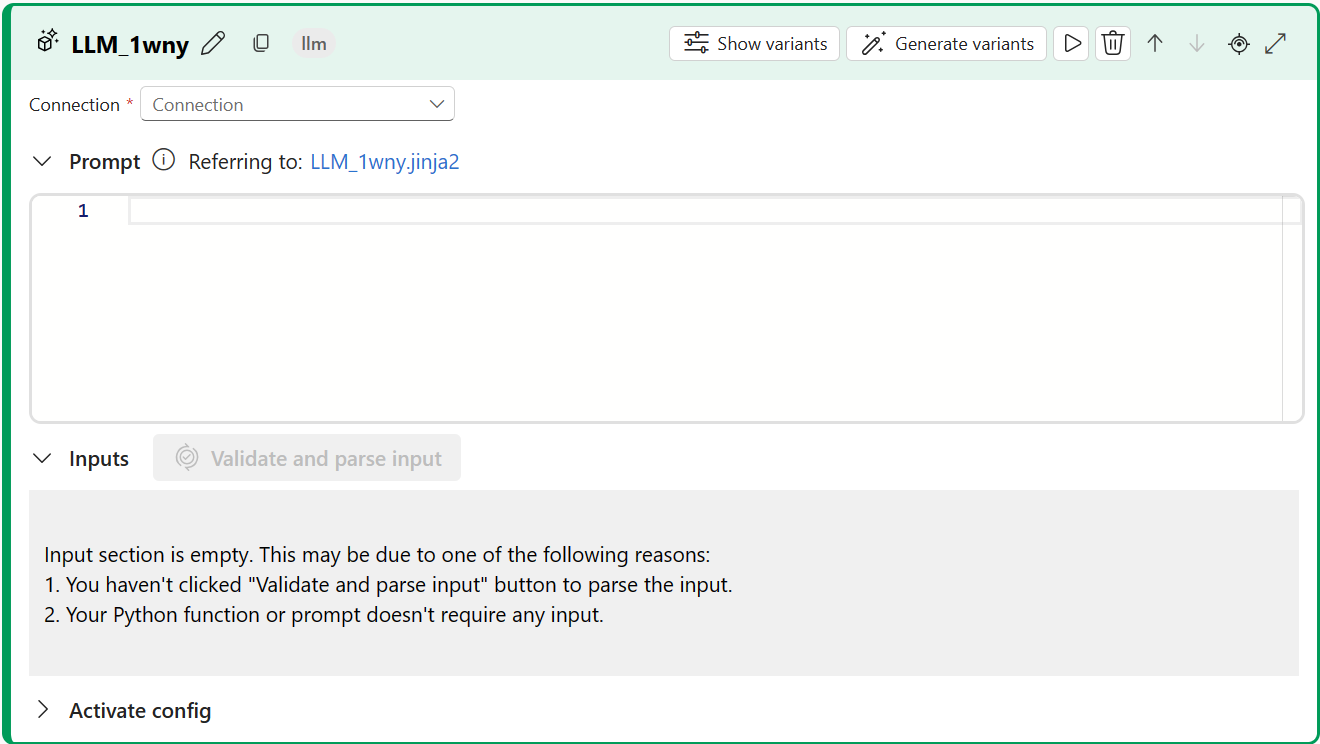

Selecione + LLM para adicionar a ferramenta LLM ao seu fluxo.

Escolha a conexão com um dos recursos provisionados. Por exemplo, selecione Default_AzureOpenAI.

Na lista de seleção API, selecione chat ou preenchimento.

Insira valores para os parâmetros de entrada da ferramenta LLM descritos na Tabela de entradas de preenchimento de texto. Se você selecionou a API de chat, consulte a Tabela de entradas de chat. Se você selecionou a API de preenchimento, consulte a Tabela de entradas de preenchimento de texto. Para obter informações sobre como preparar a entrada da solicitação, confira Pré-requisitos.

Adicione mais ferramentas ao seu fluxo, conforme necessário. Ou selecione Executar para executar o fluxo.

As saídas são descritas na tabela Saídas.

Entradas

Os parâmetros de entrada a seguir estão disponíveis.

Entradas de preenchimento de texto

| Nome | Tipo | Descrição | Obrigatório |

|---|---|---|---|

| prompt | string | Solicitação de texto para o modelo de linguagem. | Sim |

| model, deployment_name | string | O modelo de linguagem a ser usado. | Yes |

| max_tokens | inteiro | O número máximo de tokens a serem gerados na conclusão. O padrão é 16. | No |

| temperatura | FLOAT | A aleatoriedade do texto gerado. O padrão é UTF-1. | No |

| parar | list | A sequência de interrupção do texto gerado. O padrão é nulo. | No |

| sufixo | string | O texto acrescentado ao final do preenchimento. | Não |

| top_p | FLOAT | A probabilidade de usar a melhor opção dos tokens gerados. O padrão é UTF-1. | No |

| logprobs | inteiro | O número de probabilidades de log a serem geradas. O padrão é nulo. | No |

| echo | boolean | O valor que indica se a solicitação deve ser ecoada na resposta. O padrão é false. | No |

| presence_penalty | float | O valor que controla o comportamento do modelo em relação a frases repetidas. O padrão é 0. | No |

| frequency_penalty | float | O valor que controla o comportamento do modelo em relação à geração de frases incomuns. O padrão é 0. | No |

| best_of | inteiro | O número dos melhores preenchimentos a serem gerados. O padrão é UTF-1. | No |

| logit_bias | dicionário | O desvio de logit do modelo de linguagem. O padrão é o dicionário vazio. | Não |

Entradas de chat

| Nome | Tipo | Descrição | Obrigatório |

|---|---|---|---|

| prompt | string | A solicitação de texto à qual o modelo de linguagem deve responder. | Yes |

| model, deployment_name | string | O modelo de linguagem a ser usado. | Yes |

| max_tokens | inteiro | O número máximo de tokens a serem gerados na resposta. O padrão é inf. | No |

| temperatura | FLOAT | A aleatoriedade do texto gerado. O padrão é UTF-1. | No |

| parar | list | A sequência de interrupção do texto gerado. O padrão é nulo. | No |

| top_p | FLOAT | A probabilidade de usar a melhor opção dos tokens gerados. O padrão é UTF-1. | No |

| presence_penalty | float | O valor que controla o comportamento do modelo em relação a frases repetidas. O padrão é 0. | No |

| frequency_penalty | float | O valor que controla o comportamento do modelo em relação à geração de frases incomuns. O padrão é 0. | No |

| logit_bias | dicionário | O desvio de logit do modelo de linguagem. O padrão é o dicionário vazio. | Não |

Saídas

A saída varia dependendo da API selecionada para entradas.

| API | Tipo de retorno | Descrição |

|---|---|---|

| Completion | string | O texto de um preenchimento previsto. |

| Chat | string | O texto de uma resposta da conversa. |