Configure seu projeto de IA para usar a inferência de modelo de IA do Azure

Se você já tiver um projeto de IA na Fábrica de IA do Azure, o catálogo de modelos implantará modelos de provedores de terceiros como pontos de extremidade autônomos por padrão no seu projeto. Cada implantação de modelo tem seu próprio conjunto de URI e credenciais para acessá-lo. Por outro lado, os modelos do OpenAI do Azure são implantados no recurso dos Serviços de IA do Azure ou no recurso do Serviço OpenAI do Azure.

Você pode mudar esse comportamento e implantar ambos os tipos de modelos em recursos dos Serviços de IA do Azure usando a inferência do modelo de IA do Azure. Após a configuração, as implantações de Modelos como Serviço compatíveis com o pagamento conforme o uso ocorrem no recurso dos Serviços de IA do Azure conectado em vez de no projeto propriamente dito, proporcionando um único conjunto de ponto de extremidade e credenciais para você acessar todos os modelos implantados na Fábrica de IA do Azure. Você pode gerenciar o OpenAI do Azure e modelos de provedores de terceiros da mesma maneira.

Além disso, a implantação de modelos na inferência de modelo de IA do Azure traz os benefícios adicionais de:

- Capacidade de roteamento.

- Filtros de conteúdo personalizados.

- Tipo de implantação de capacidade global.

- Autenticação sem chave com controle de acesso baseado em função.

Nesse artigo, você aprenderá a configurar seu projeto para usar modelos implantados na inferência de modelo de IA do Azure nos serviços de IA do Azure.

Pré-requisitos

Para concluir este tutorial, você precisará:

Uma assinatura do Azure. Se você estiver usando Modelos do GitHub, poderá atualizar sua experiência e criar uma assinatura do Azure no processo. Leia Atualizar dos modelos do GitHub para inferência de modelo de IA do Azure se esse for o seu caso.

Um recurso dos serviços de IA do Azure. Para obter mais informações, confira Criar um recurso dos Serviços de IA do Azure.

Um projeto de IA do Azure e um Hub de IA do Azure.

Dica

Quando seu hub de IA é provisionado, um recurso de serviços de IA do Azure é criado com ele e os dois recursos são conectados. Para ver qual recurso de serviços de IA do Azure está conectado ao seu projeto, acesse o portal da Fábrica de IA do Azure>Centro de gerenciamento>Recursos conectados e encontre as conexões do tipo Serviços de IA.

Configure o projeto para usar a inferência de modelo de IA do Azure

Para configurar o projeto para usar a capacidade de inferência de modelo de IA do Azure nos Serviços de IA do Azure, siga estas etapas:

Acesse o portal do IA do Azure Foundry.

Na barra de navegação superior, no canto superior direito, selecione o ícone Recursos de visualização. Uma folha contextual aparece à direita da tela.

Ligue o recurso Implantar modelos no serviço de inferência de modelo de IA do Azure.

Feche o painel.

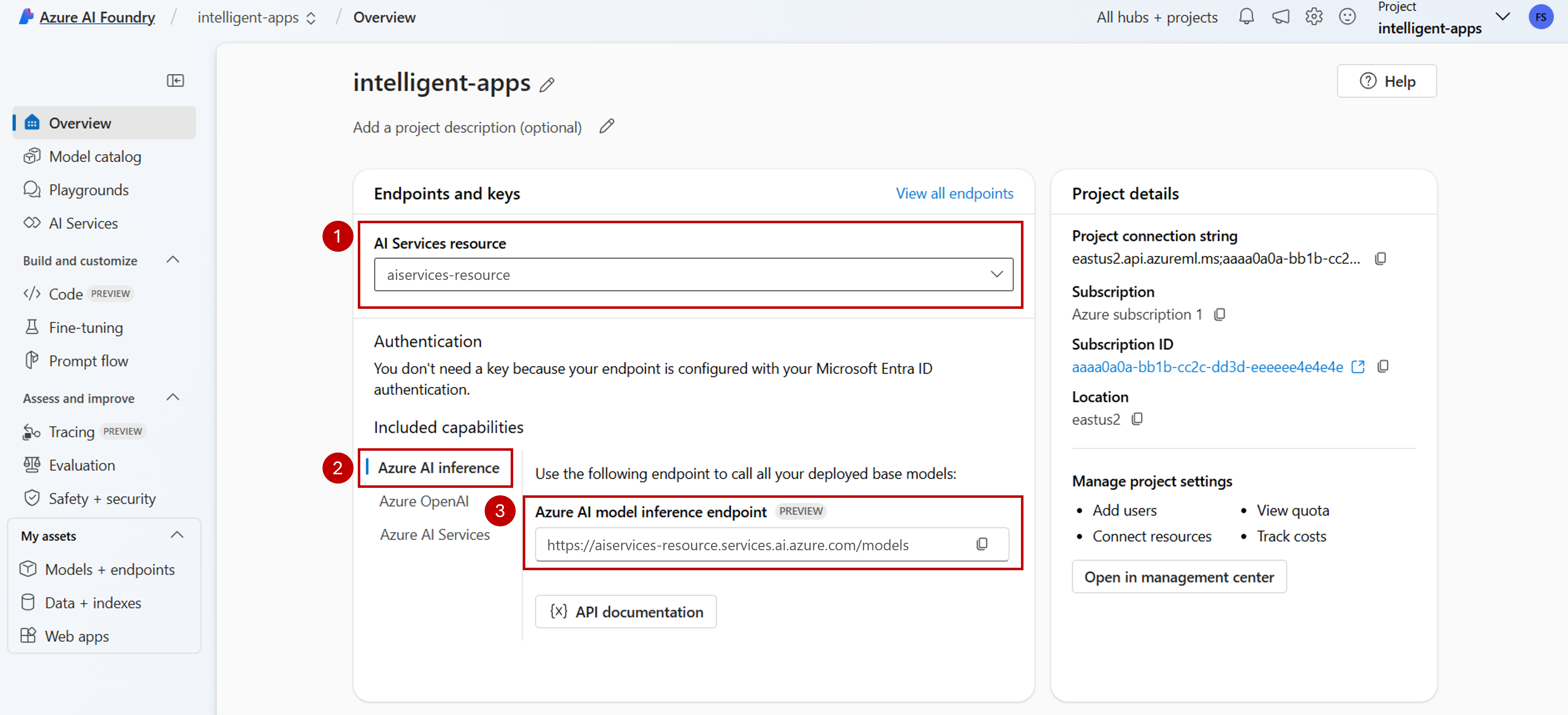

Na página de aterrissagem do seu projeto, identifique o recurso Serviços de IA do Azure conectado ao seu projeto. Use a lista suspensa para alterar o recurso ao qual você está conectado, se necessário.

Se nenhum recurso estiver listado na lista suspensa, seu Hub de IA não tem um recurso Serviços de IA do Azure conectado a ele. Crie uma conexão:

No canto inferior esquerdo da tela, selecione Centro de gerenciamento.

Na seção Conexões, selecione Nova conexão.

Selecione Serviços de IA do Azure.

No navegador, procure um recurso Serviços de IA do Azure existente em sua assinatura.

Selecione Adicionar conexão.

A nova conexão será adicionada ao seu Hub.

Retorne à página de aterrissagem do projeto para continuar e agora selecione a nova conexão criada. Atualize a página se ela não aparecer imediatamente.

Em Funcionalidades incluídas, verifique se você selecionou Inferência de IA do Azure. A URI do ponto de extremidade de inferência de modelo de IA do Azure é exibida juntamente com as credenciais para acessá-la.

Dica

Cada recurso de serviços de IA do Azure tem um único ponto de extremidade de inferência de modelo de IA do Azure que pode ser usado para acessar qualquer implantação de modelo nele. O mesmo ponto de extremidade atende a vários modelos, dependendo de quais estão configurados. Saiba mais sobre como o ponto de extremidade funciona.

Anote a URL do ponto de extremidade e as credenciais.

Crie a implantação de modelo na inferência de modelo de IA do Azure

Para cada modelo que você deseja implantar na inferência de modelo de IA do Azure, siga estas etapas:

Acesse a seção Catálogo de modelos no portal da Fábrica de IA do Azure.

Role até o modelo do seu interesse e selecione-o.

Você pode revisar os detalhes do modelo no cartão do modelo.

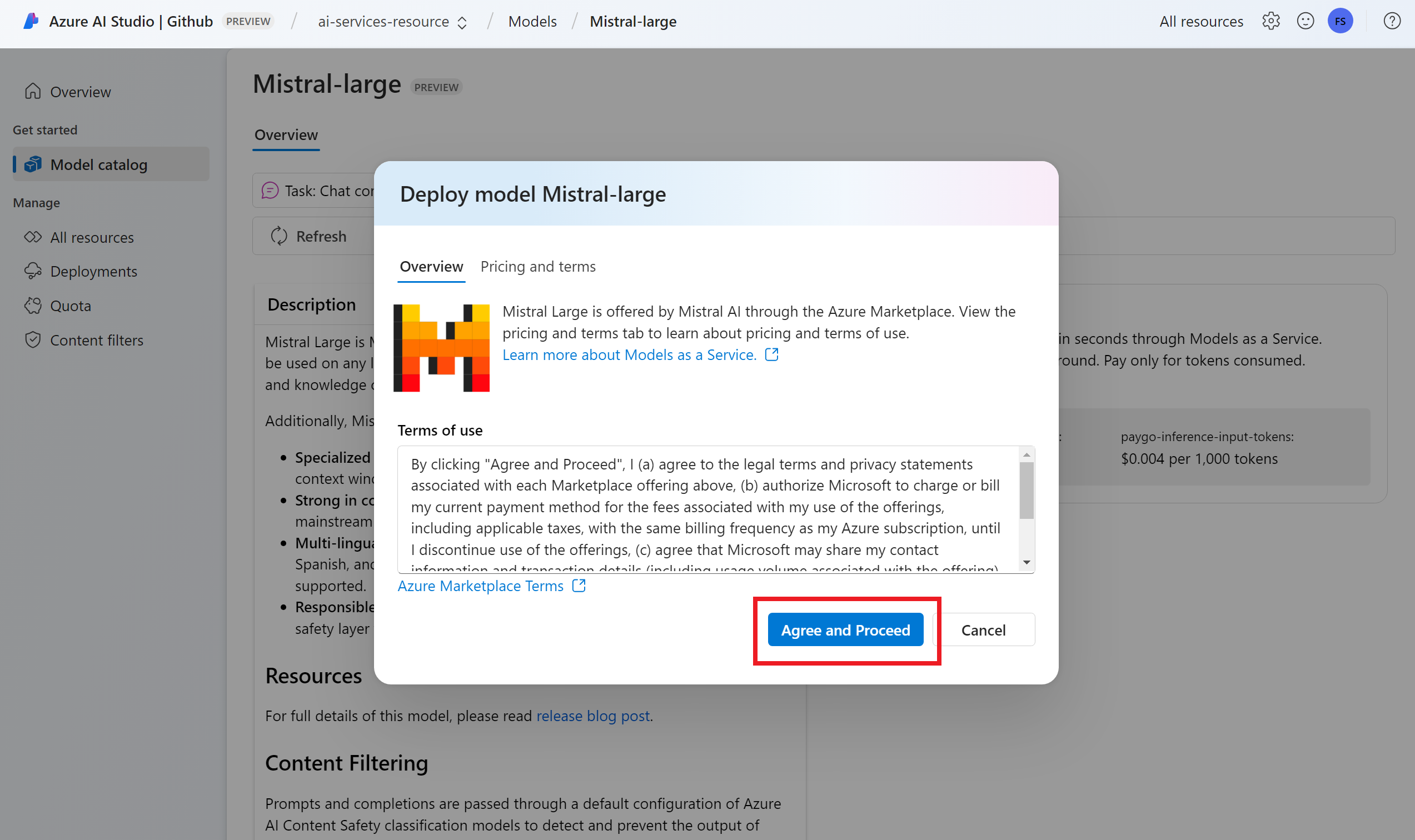

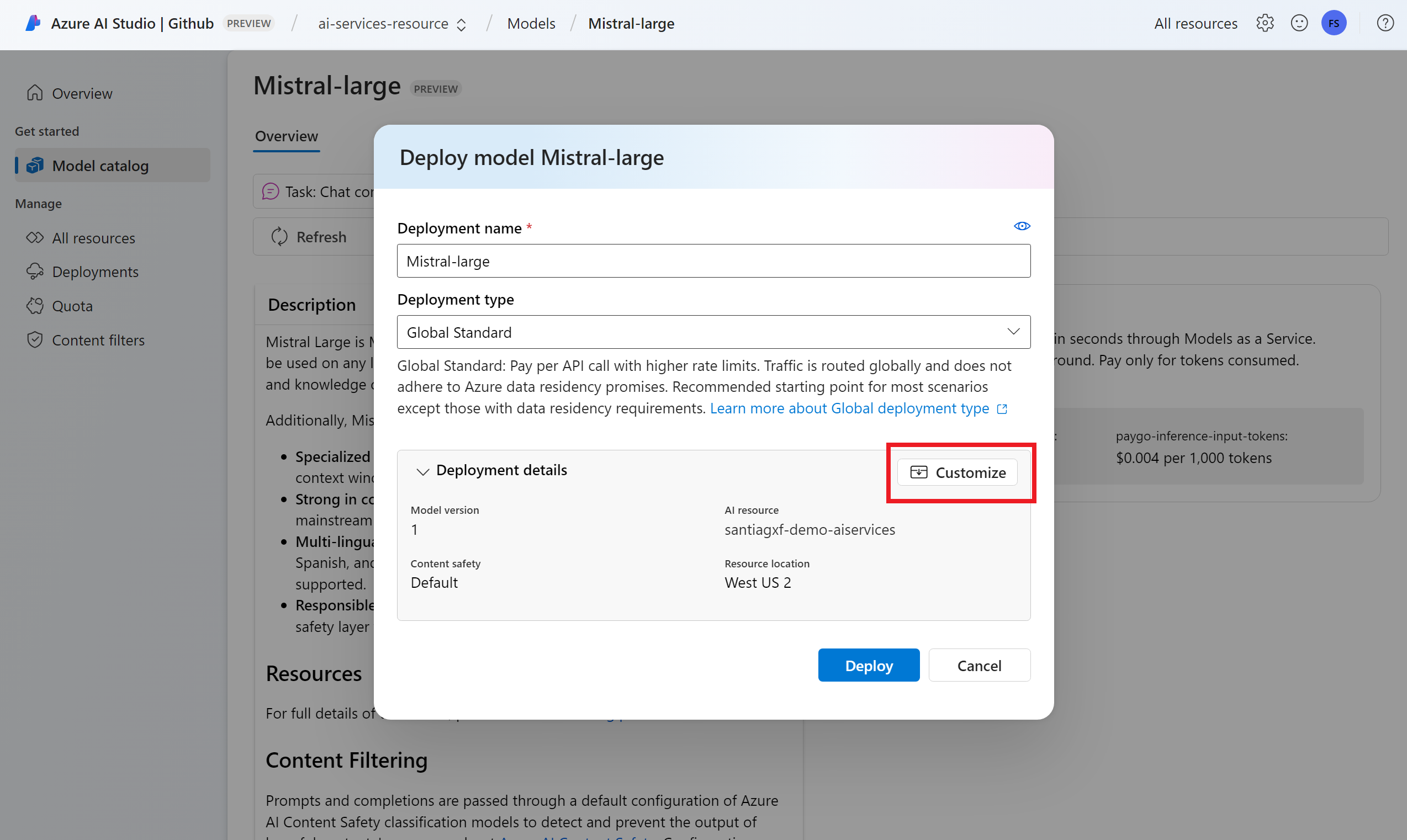

Selecione Implantar.

Para provedores de modelos que exigem mais condições de contrato, você será solicitado a aceitar essas condições. Aceite os termos nesses casos selecionando Assinar e implantar.

Você pode configurar as configurações de implantação nesse momento. Por padrão, a implantação receberá o nome do modelo que você está implantando. O nome da implantação será usado no parâmetro

modelpara solicitação para rotear para essa implantação de modelo específica. Isso permite que você configure nomes específicos para seus modelos ao anexar configurações específicas. Por exemplo,o1-preview-safepara um modelo com um filtro de segurança de conteúdo estrito.Selecionamos automaticamente uma conexão com os Serviços de IA do Azure, dependendo do seu projeto porque você ativou o recurso Implantar modelos no serviço de inferência de modelo de IA do Azure. Use a opção Personalizar para alterar a conexão com base nas suas necessidades. Se você estiver implantando no tipo de implantação Standard, os modelos precisam estar disponíveis na região do recurso Serviços de IA do Azure.

Selecione Implantar.

Quando a implantação for concluída, você verá a URL do ponto de extremidade e as credenciais para obter acesso ao modelo. Observe que agora a URL e as credenciais fornecidas são as mesmas exibidas na página de aterrissagem do projeto para o ponto de extremidade de inferência de modelo da IA do Azure.

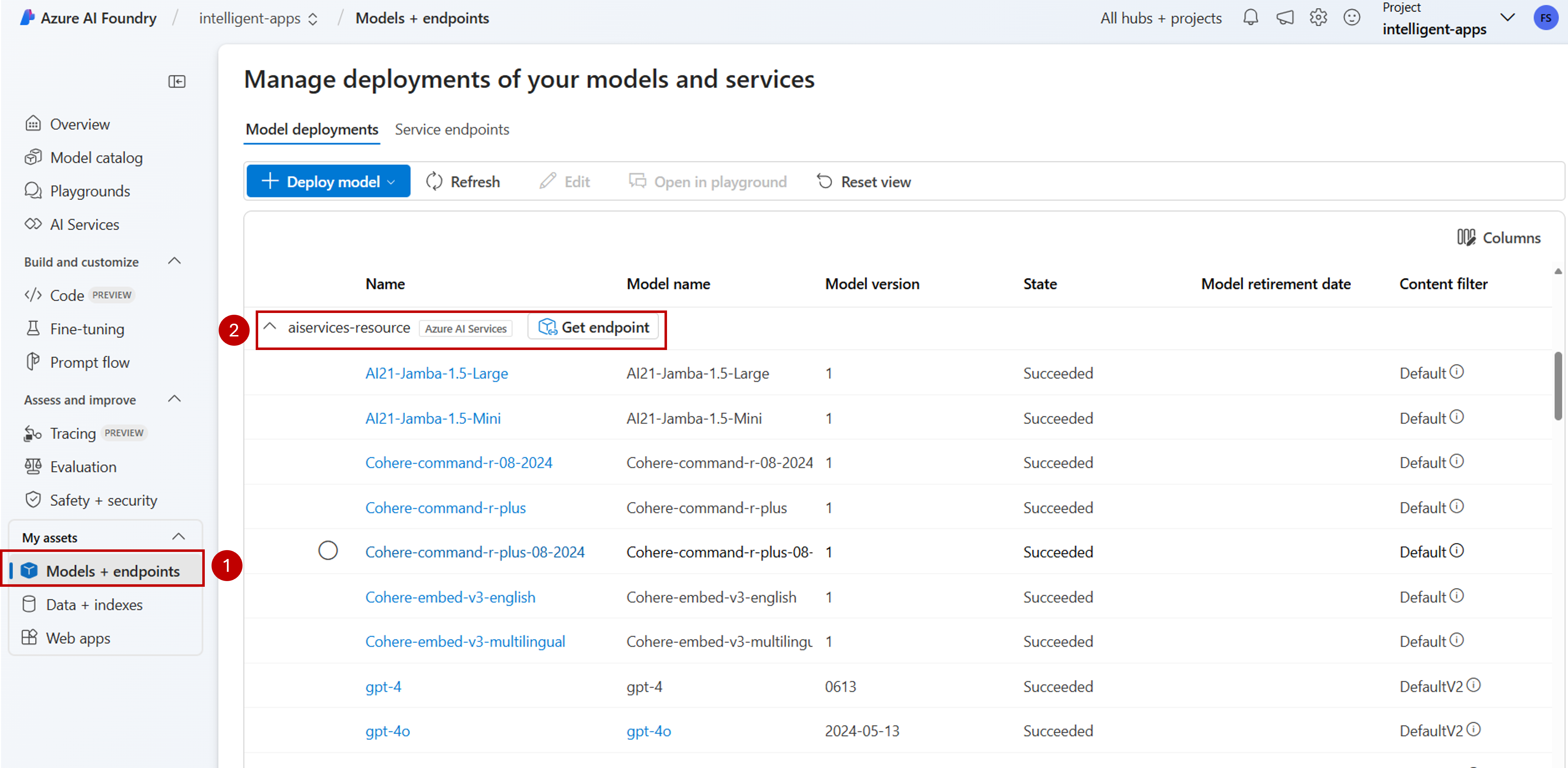

Você pode exibir todos os modelos disponíveis no recurso acessando a seção Modelos + pontos de extremidade e localizando o grupo para a conexão com o recurso de Serviços de IA:

Atualize seu código com o novo ponto de extremidade

Depois que o recurso dos Serviços de IA do Azure estiver configurado, você poderá começar a consumi-lo do código. Você precisa da URL do ponto de extremidade e da chave para ela, que podem ser encontradas na seção Visão geral:

Você pode usar qualquer um dos SDKs com suporte para obter previsões do ponto de extremidade. Os seguintes SDKs têm suporte oficial:

- SDK de OpenAI

- SDK do OpenAI do Azure

- SDK de Inferência de IA do Azure

- SDK do Azure AI Foundry

Consulte a seção de idiomas e SDKs com suporte para obter mais detalhes e exemplos. O exemplo a seguir mostra como usar o SDK de inferência do modelo de IA do Azure com o modelo recém-implantado:

Instale o pacote azure-ai-inference usando seu gerenciador de pacotes, como o pip:

pip install azure-ai-inference>=1.0.0b5

Aviso

O recurso dos Serviços de IA do Azure requer a versão azure-ai-inference>=1.0.0b5 para Python.

Em seguida, você poderá usar o pacote para consumir o modelo. O exemplo a seguir mostra como criar um cliente para consumir conclusões de chat:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Explore nossos exemplos e leia a documentação de referência da API para começar.

Gere sua primeira conclusão de chat:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Use o parâmetro model="<deployment-name> para rotear sua solicitação para essa implantação.

As implantações funcionam como um alias de um determinado modelo em determinadas configurações. Consulte a página de conceito de Roteamento para saber como os Serviços de IA do Azure roteiam implantações.

Mova dos Pontos de Extremidade de API sem Servidor para a inferência de modelo da IA do Azure

Embora você tenha configurado o projeto para usar a inferência de modelo de IA do Azure, as implantações de modelo existentes continuam a existir dentro do projeto como Pontos de Extremidade de API sem Servidor. Essas implantações não são movidas para você. Portanto, você pode atualizar progressivamente qualquer código existente que faça referência a implantações de modelo anteriores. Para começar a mover as implantações de modelo, recomendamos o seguinte fluxo de trabalho:

Recrie a implantação do modelo na inferência de modelo da IA do Azure. Essa implantação de modelo está acessível no ponto de extremidade de inferência de modelo da IA do Azure.

Atualize seu código para usar o novo ponto de extremidade.

Limpe o projeto removendo o Ponto de Extremidade de API sem Servidor.

Atualize seu código com o novo ponto de extremidade

Depois que os modelos forem implantados nos Serviços de IA do Azure, você poderá atualizar seu código para usar o ponto de extremidade de inferência de modelo da IA do Azure. A principal diferença entre o funcionamento dos pontos de extremidade de API sem servidor e a inferência de modelo da IA do Azure reside na URL do ponto de extremidade e no parâmetro do modelo. Enquanto os Pontos de Extremidade de API sem Servidor têm um conjunto de URI e chave para cada implantação de modelo, a inferência de modelo de IA do Azure tem apenas um para todas elas.

A tabela a seguir resume as alterações que você deve introduzir:

| Propriedade | Pontos de Extremidade de API sem Servidor | Inferência de Modelo da IA do Azure |

|---|---|---|

| Ponto de extremidade | https://<endpoint-name>.<region>.inference.ai.azure.com |

https://<ai-resource>.services.ai.azure.com/models |

| Credenciais | Um por modelo/ponto de extremidade. | Um por recurso dos Serviços de IA do Azure. Você também pode usar o Microsoft Entra ID. |

| Parâmetro de modelo | Nenhum. | Obrigatória. Use o nome da implantação do modelo. |

Limpe os pontos de extremidade de API sem servidor existentes do seu projeto

Depois de refatorar seu código, talvez você queira excluir os pontos de extremidade de API sem servidor existentes dentro do projeto (se houver).

Para cada modelo implantado como Pontos de Extremidade de API sem Servidor, siga estas etapas:

Acesse o portal do IA do Azure Foundry.

Selecione Modelos + pontos de extremidade.

Identifique os pontos de extremidade do tipo Sem Servidor e selecione aquele que você deseja excluir.

Selecione a opção Excluir.

Aviso

Essa operação não pode ser revertida. Verifique se o ponto de extremidade não está sendo usado atualmente por outro usuário ou parte do código.

Confirme a operação selecionando Excluir.

Se você criou uma conexão de API sem Servidor com esse ponto de extremidade de outros projetos, essas conexões não serão removidas e continuarão apontando para o ponto de extremidade inexistente. Exclua qualquer uma dessas conexões para evitar erros.

Limitações

Leve em conta as seguintes limitações ao configurar seu projeto para usar a inferência do modelo de IA do Azure:

- Somente modelos compatíveis com pagamento conforme o uso (Modelos como Serviço) estão disponíveis para implantação na inferência de modelo de IA do Azure. Os modelos que exigem cota de computação da sua assinatura (Computação Gerenciada), incluindo modelos personalizados, só podem ser implantados em um determinado projeto como Pontos de Extremidade Online Gerenciados e continuam acessíveis usando seu próprio conjunto de URI e credenciais de ponto de extremidade.

- Os modelos disponíveis tanto com pagamento conforme o uso quanto como ofertas de computação gerenciada são, por padrão, implantados na inferência do modelo de IA do Azure nos recursos dos serviços de IA do Azure. O portal da Fábrica de IA do Azure não oferece uma maneira de implantá-los em Pontos de Extremidade Online Gerenciados. Você precisa desativar o recurso mencionado em Configurar o projeto para usar a inferência do modelo de IA do Azure ou usar os modelos de SDK/ARM de CLI do Azure/ML do Azure para executar a implantação.

Próximas etapas

- Adicionar mais modelos ao ponto de extremidade.