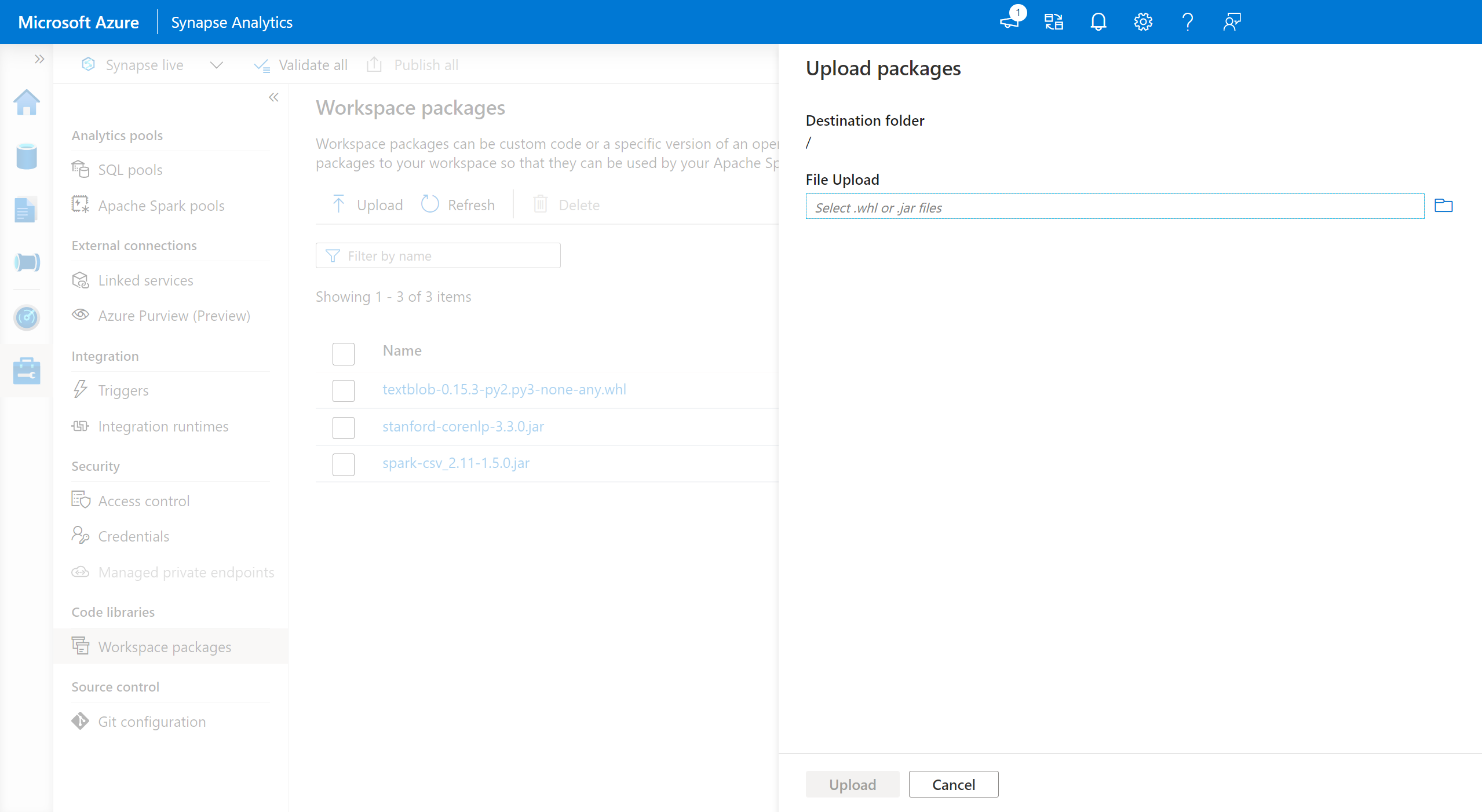

Pacotes do espaço de trabalho

Os pacotes de workspace podem ser arquivos personalizados ou privados (Python), jar (Scala/Java) ou tar.gz (R). Você pode carregar esses pacotes em seu espaço de trabalho e, posteriormente, atribui-los a um pool do Spark específico.

Para adicionar pacotes de espaço de trabalho:

- Navegue até a guia Gerenciar>pacotes de espaço de trabalho.

- Carregue seus arquivos usando o seletor de arquivo.

- Depois que os arquivos tiverem sido carregados no espaço de trabalho do Azure Synapse, você poderá adicionar esses pacotes a um pool do Apache Spark.

Aviso

No Azure Synapse, um pool do Apache Spark pode aproveitar as bibliotecas personalizadas que são carregadas como pacotes de workspace ou carregadas em um caminho conhecido do Azure Data Lake Storage. No entanto, essas duas opções não podem ser usadas simultaneamente no mesmo pool do Apache Spark. Se os pacotes forem fornecidos usando os dois métodos, somente os arquivos wheel especificados na lista Pacotes de espaço de trabalho serão instalados.

Depois que os pacotes de espaço de trabalho são usados para instalar pacotes em um determinado pool do Apache Spark, há uma limitação de que você não pode mais especificar pacotes usando o caminho da conta de armazenamento no mesmo pool.

Observação

É recomendável que você não tenha vários pacotes com o mesmo nome em um espaço de trabalho. Se você quiser usar uma versão diferente do mesmo pacote, precisará excluir a versão existente e carregar a nova.

Conta de armazenamento

Os pacotes personalizados podem ser instalados no pool do Apache Spark carregando todos os arquivos na conta Azure Data Lake Storage (Gen2) que está vinculada ao espaço de trabalho do Synapse.

Os arquivos devem ser carregados no seguinte caminho no contêiner padrão da conta de armazenamento:

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

Aviso

- Em alguns casos, talvez seja necessário criar o caminho do arquivo com base na estrutura acima, caso ele ainda não exista. Por exemplo, talvez seja necessário adicionar a

pythonpasta dentro dalibrariespasta, caso ela ainda não exista. - Esse método de gerenciamento de arquivos personalizados não terá suporte no Runtime do Azure Synapse para o Apache Spark 3.0. Consulte o recurso Pacotes de espaço de trabalho para gerenciar arquivos personalizados.

Importante

Para instalar bibliotecas personalizadas usando o método de armazenamento do Azure DataLake, você deve ter as permissões de colaborador de dados de armazenamento de blob ou de proprietário da conta de armazenamento de blob do Gen2 primário que está vinculada ao espaço de trabalho do Azure Synapse Analytics.

Próximas etapas

- Exibir as bibliotecas padrão: suporte à versão Apache Spark

- Solucionar erros de instalação da biblioteca: solucionar erros de biblioteca

- Criar um canal Conda privado usando sua conta do Azure Data Lake Storage: canais privados Conda