Uruchamianie eksperymentów za pomocą biblioteki MLflow

Eksperymenty MLflow umożliwiają analitykom danych śledzenie przebiegów trenowania w kolekcji nazywanej eksperymentem. Przebiegi eksperymentów są przydatne do porównywania zmian w czasie lub porównywania względnej wydajności modeli z różnymi wartościami hiperparametrów.

Uruchamianie eksperymentu

Tworzenie eksperymentu w usłudze Azure Databricks odbywa się automatycznie po uruchomieniu przebiegu. Oto przykład uruchamiania przebiegu w usłudze MLflow, rejestrowania dwóch parametrów i rejestrowania jednej metryki:

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

W takim przypadku nazwa eksperymentu to nazwa notesu. Można wyeksportować zmienną o nazwie MLFLOW_EXPERIMENT_NAME , aby zmienić nazwę eksperymentu.

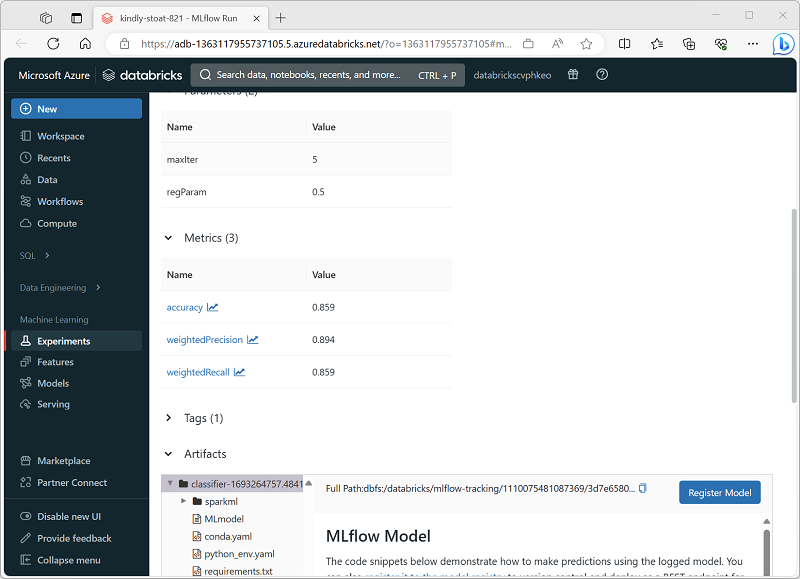

Przeglądanie przebiegu eksperymentu

W portalu usługi Azure Databricks strona Eksperymenty umożliwia wyświetlenie szczegółów każdego przebiegu eksperymentu, w tym zarejestrowanych wartości parametrów, metryk i innych artefaktów.