Praca z usługą Microsoft Fabric lakehouses

Teraz, gdy już znasz podstawowe możliwości usługi Microsoft Fabric Lakehouse, przyjrzyjmy się, jak z nimi pracować.

Tworzenie i eksplorowanie jeziora

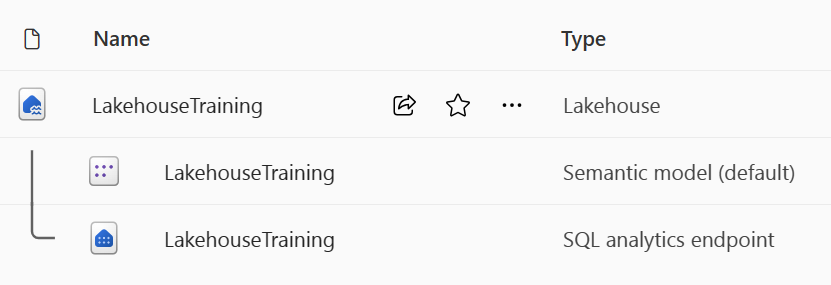

Podczas tworzenia nowego magazynu lakehouse masz trzy różne elementy danych utworzone automatycznie w obszarze roboczym.

- Lakehouse zawiera skróty, foldery, pliki i tabele.

- Model semantyczny (domyślny) udostępnia łatwe źródło danych dla deweloperów raportów usługi Power BI.

- Punkt końcowy analizy SQL umożliwia dostęp tylko do odczytu do wykonywania zapytań dotyczących danych za pomocą języka SQL.

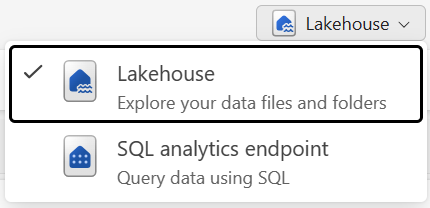

Możesz pracować z danymi w lakehouse w dwóch trybach:

- usługa lakehouse umożliwia dodawanie tabel, plików i folderów oraz interakcję z nimi w lakehouse.

- Punkt końcowy analizy SQL umożliwia używanie języka SQL do wykonywania zapytań dotyczących tabel w usłudze Lakehouse i zarządzania jej semantycznym modelem relacyjnym.

Pozyskiwanie danych do magazynu lakehouse

Pozyskiwanie danych do usługi Lakehouse jest pierwszym krokiem procesu ETL. Użyj dowolnej z poniższych metod, aby przenieść dane do usługi Lakehouse.

- Przekaż: przekaż pliki lokalne.

- Przepływy danych Gen2: importowanie i przekształcanie danych przy użyciu dodatku Power Query.

- Notesy: użyj platformy Apache Spark do pozyskiwania, przekształcania i ładowania danych.

- Potoki usługi Data Factory: użyj działania Kopiowania danych.

Te dane można następnie załadować bezpośrednio do plików lub tabel. Podczas pozyskiwania danych należy wziąć pod uwagę wzorzec ładowania danych, aby określić, czy przed przetworzeniem lub użyciem tabel przejściowych należy załadować wszystkie nieprzetworzone dane jako pliki.

Definicje zadań platformy Spark mogą również służyć do przesyłania zadań wsadowych/przesyłanych strumieniowo do klastrów Spark. Przekazując pliki binarne z danych wyjściowych kompilacji różnych języków (na przykład .jar z języka Java), można zastosować inną logikę przekształcania do danych hostowanych w usłudze Lakehouse. Oprócz pliku binarnego można dodatkowo dostosować zachowanie zadania, przekazując więcej bibliotek i argumentów wiersza polecenia.

Uwaga

Aby uzyskać więcej informacji, zobacz dokumentację tworzenia definicji zadania platformy Apache Spark.

Uzyskiwanie dostępu do danych przy użyciu skrótów

Innym sposobem uzyskiwania dostępu do danych i używania ich w usłudze Fabric jest użycie skrótów. Skróty umożliwiają integrowanie danych z usługą Lakehouse przy zachowaniu ich w magazynie zewnętrznym.

Skróty są przydatne, gdy konieczne jest źródło danych, które znajdują się na innym koncie magazynu, a nawet innym dostawcy usług w chmurze. W usłudze Lakehouse można tworzyć skróty wskazujące różne konta magazynu i inne elementy sieci szkieletowej, takie jak magazyny danych, bazy danych KQL i inne magazyny typu lakehouse.

Wszystkie uprawnienia i poświadczenia danych źródłowych są zarządzane przez usługę OneLake. Podczas uzyskiwania dostępu do danych za pomocą skrótu do innej lokalizacji OneLake tożsamość użytkownika wywołującego zostanie użyta do autoryzowania dostępu do danych w ścieżce docelowej skrótu. Aby odczytać dane, użytkownik musi mieć uprawnienia w lokalizacji docelowej.

Skróty można tworzyć zarówno w bazach danych lakehouses, jak i KQL, i wyświetlać je jako folder w jeziorze. Dzięki temu platforma Spark, sql, analiza w czasie rzeczywistym i usługi Analysis Services mogą korzystać ze skrótów podczas wykonywania zapytań dotyczących danych.

Uwaga

Aby uzyskać więcej informacji na temat używania skrótów, zobacz dokumentację skrótów OneLake w dokumentacji usługi Microsoft Fabric.