Eksplorowanie modeli językowych w katalogu modeli

Wybór modelu językowego dla generowanej aplikacji sztucznej inteligencji jest ważny, ponieważ ma wpływ na to, jak dobrze działa aplikacja. Podczas tworzenia aplikacji generowania sztucznej inteligencji za pomocą usługi Azure AI Foundry utworzysz aplikację do czatu, która może używać modeli językowych w kilku celach:

- Aby zrozumieć pytanie użytkownika.

- Aby wyszukać odpowiedni kontekst.

- Aby wygenerować odpowiedź na pytanie użytkownika.

W portalu Azure AI Foundry możesz przeglądać dostępne modele językowe w katalogu modeli. Przyjrzyjmy się katalogowi modeli i typom modeli językowych dostępnych za pośrednictwem usługi Azure AI.

Eksplorowanie wykazu modeli

W portalu azure AI Foundry możesz przejść do katalogu modeli, aby zapoznać się ze wszystkimi dostępnymi modelami językowymi. Ponadto można zaimportować dowolny model z biblioteki open source Hugging Face do katalogu modeli.

Napiwek

Przytulanie twarzy to społeczność typu open source udostępniająca modele publicznie. Wszystkie modele można znaleźć w katalogu. Ponadto możesz zapoznać się z dokumentacją, aby dowiedzieć się więcej o sposobie działania poszczególnych modeli, takich jak .

Wykaz modeli usługi Azure AI Foundry integruje się z modelami z funkcji Hugging Face i innymi źródłami. Za pomocą wykazu modeli można eksplorować, dostosowywać i wdrażać modele.

Ważne

Dostępność modelu różni się w zależności od lokalizacji, nazywanej również regionem. Lokalizacja jest określona na poziomie centrum sztucznej inteligencji. Podczas tworzenia nowego centrum sztucznej inteligencji możesz użyć pomocnika Lokalizacja, aby określić model, który chcesz wdrożyć, aby uzyskać listę lokalizacji, w których można ją wdrożyć. Możesz również zapoznać się z tabelą podsumowania modelu i dostępnością regionów, aby dowiedzieć się więcej.

Eksplorowanie modeli językowych

Modele podstawowe lub językowe dostępne w wykazie modeli są już wstępnie wytrenowane. Model językowy można wdrożyć w punkcie końcowym lub dostosować model, aby lepiej działał w wyspecjalizowanym zadaniu lub na wiedzy specyficznej dla domeny.

Wybrany model zależy od preferencji użycia i wdrożenia. Przede wszystkim należy zastanowić się nad zadaniem, które ma wykonać model. Na przykład:

- Klasyfikacja tekstu

- klasyfikacja tokenów

- Odpowiadanie na pytania

- Podsumowanie

- Tłumaczenie

Niektóre modele językowe, które są często używane w różnych zadaniach, to:

| Model | opis |

|---|---|

| (Reprezentacje kodera dwukierunkowego z funkcji Transformers) | Skoncentrowano się na kodowaniu informacji przy użyciu kontekstu z wcześniejszego i po tokenie (dwukierunkowym). Często używane, gdy chcesz dostosować model do wykonania określonego zadania, takiego jak klasyfikacja tekstu i odpowiadanie na pytania. |

| GPT (generator wstępnie wytrenowany) | Trenowane w celu tworzenia spójnego i kontekstowego tekstu i jest najczęściej używane w przypadku zadań takich jak generowanie tekstu i uzupełnianie czatów. |

| LLaMA (duży model językowy Meta AI) | Rodzina modeli utworzonych przez aplikację Meta. Podczas trenowania modeli LLaMA skupiono się na dostarczaniu większej ilości danych szkoleniowych niż zwiększaniu złożoności modeli. Modele LLaMA można używać do generowania tekstu i uzupełniania czatów. |

| Phi-3-mini (odmiana parametrów 3.8B modeli phi) | Lekki, najnowocześniejszy model zoptymalizowany pod kątem środowisk ograniczonych do zasobów i lokalnego wnioskowania (na przykład na telefonie), obsługujący monity o długi kontekst do 128 K tokenów. Został opracowany z myślą o bezpieczeństwie, wyrównaniu i wzmocnieniu uczenia się od opinii człowieka. |

Po wybraniu zadania i przefiltrowaniu dostępnych modeli, które są odpowiednie dla danego celu, możesz przejrzeć podsumowanie modelu w narzędziu Azure AI Foundry, aby wziąć pod uwagę inne kwestie:

- Możliwości modelu: oceń możliwości modelu językowego i ich dopasowanie do zadania. Na przykład model, taki jak, jest lepszy w zrozumieniu krótkich tekstów.

- Wstępne trenowanie danych: rozważ zestaw danych używany do wstępnego trenowania modelu językowego. Na przykład GPT-2 jest trenowany na niefiltrowanej zawartości z Internetu, co może spowodować uprzedzenia.

- Ograniczenia i uprzedzenia: należy pamiętać o wszelkich ograniczeniach lub uprzedzeniach, które mogą występować w modelu językowym.

- Obsługa języka: Eksploruj, które modele oferują obsługę określonego języka lub wielojęzyczne możliwości, których potrzebujesz w przypadku użycia.

Napiwek

Chociaż narzędzie Azure AI Foundry zawiera opisy dla każdego modelu językowego w katalogu modeli, możesz również znaleźć więcej informacji na temat każdego modelu za pomocą odpowiedniej karty modelu. Karty modelu są przywoływana w przeglądzie każdego modelu i hostowane na stronie internetowej aplikacji Hugging Face

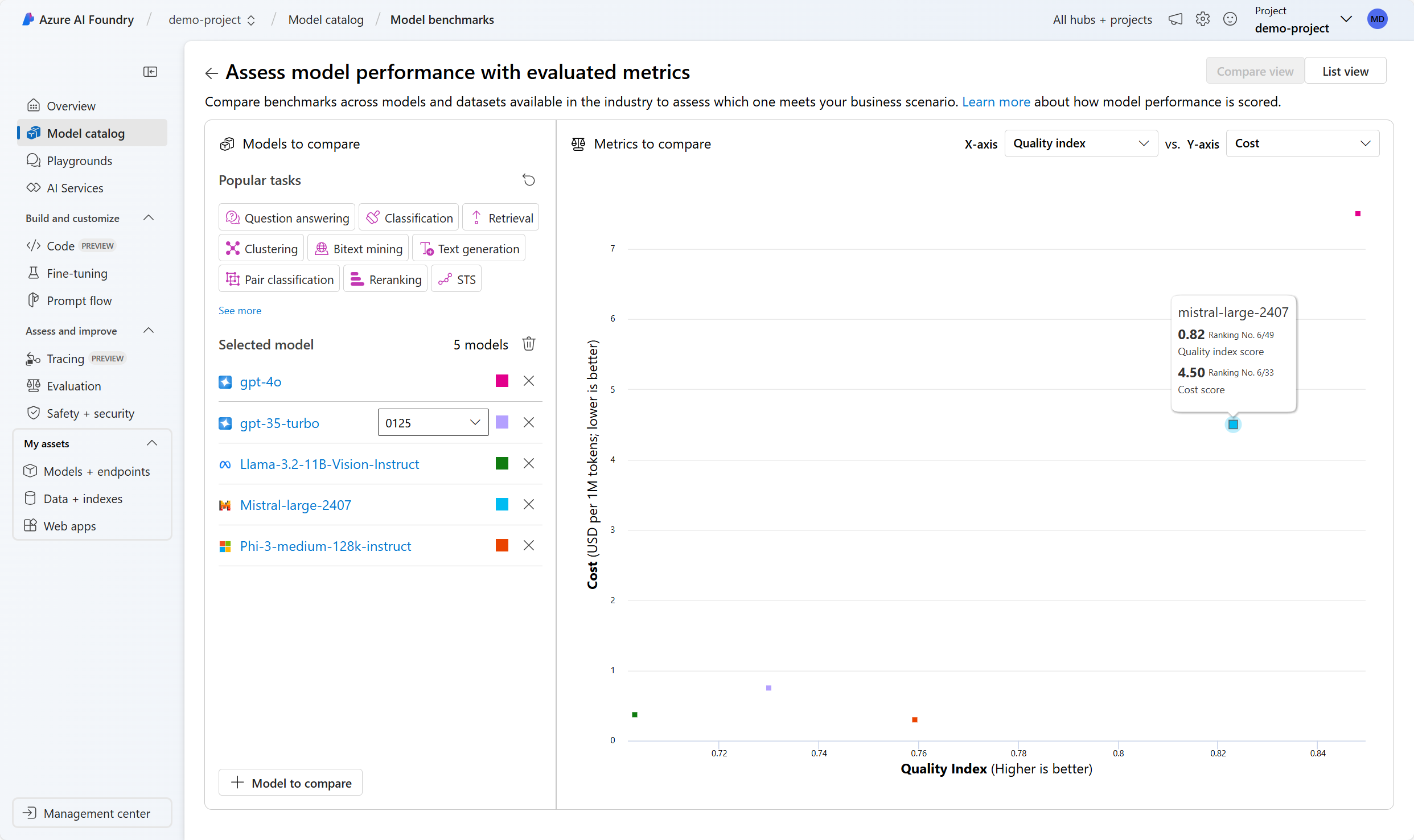

Porównanie testów porównawczych między modelami

Podczas eksplorowania modeli językowych można również porównać dostępne testy porównawcze modelu, aby ocenić jakość modeli przed wdrożeniem i zintegrowaniem modelu. Testy porównawcze są podobne do kart raportów dla modeli językowych. Testy porównawcze pomagają zrozumieć, jak dobrze działa model, porównując go z innymi modelami przy użyciu określonych testów lub zadań. Testy porównawcze modelu w portalu usługi Azure AI Foundry udostępniają wyselekcjonaną listę najlepszych modeli dla danego zadania na podstawie metryk testów porównawczych.

Niektóre często używane metryki do oceny wydajności modeli językowych to:

| Metryka | Opis |

|---|---|

| Dokładność | Wyniki dokładności są dostępne na poziomie zestawu danych i modelu. Na poziomie zestawu danych wynik jest średnią wartością metryki dokładności obliczonej na wszystkich przykładach w zestawie danych. Użyta metryka dokładności jest dokładnie zgodna we wszystkich przypadkach, z wyjątkiem zestawu danych HumanEval, który używa metryki pass@1. Dokładne dopasowanie po prostu porównuje model wygenerowany tekst z prawidłową odpowiedzią zgodnie z zestawem danych, zgłaszając go, jeśli wygenerowany tekst odpowiada dokładnie i zero w przeciwnym razie. Pass@1 mierzy proporcję rozwiązań modelu, które przechodzą zestaw testów jednostkowych w zadaniu generowania kodu. Na poziomie modelu współczynnik dokładności jest średnią dokładności na poziomie zestawu danych dla każdego modelu. |

| Spójności | Spójność ocenia, jak dobrze model językowy może wygenerować dane wyjściowe, które przepływa płynnie, odczytuje naturalnie i przypomina język przypominający człowieka. |

| Płynność | Płynność ocenia biegłość językową przewidywanej odpowiedzi na generowanie sztucznej inteligencji. Ocenia, jak dobrze wygenerowany tekst jest zgodny z regułami gramatycznymi, strukturami składniowymi i odpowiednim użyciem słownictwa, co skutkuje poprawną językowo i naturalnie brzmiącymi odpowiedziami. |

| GPTSimilarity | GPTSimilarity to miara, która kwantyfikuje podobieństwo między zdaniem podstawy prawdy (lub dokumentem) a wyrokiem przewidywania wygenerowanym przez model sztucznej inteligencji. Jest obliczana przez pierwsze osadzanie na poziomie zdania przy użyciu interfejsu API osadzania zarówno dla podstawowej prawdy, jak i przewidywania modelu. Te osadzania reprezentują wielowymiarowe reprezentacje wektorów zdań, przechwytując ich semantyczne znaczenie i kontekst. |

| Uziemienie | Groundedness mierzy, jak dobrze generowane odpowiedzi modelu językowego są zgodne z informacjami ze źródła danych wejściowych. |

| Mający znaczenie dla | Istotność mierzy zakres, w jakim wygenerowane odpowiedzi modelu językowego są odpowiednie i bezpośrednio związane z podanymi pytaniami. |

Uwaga

Podczas tworzenia i oceniania aplikacji korzystających z modeli językowych ważne jest użycie metryk do mierzenia wydajności modelu i aplikacji. Te same metryki używane na potrzeby testów porównawczych, które porównują różne modele, mogą również służyć do oceny wydajności poszczególnych modeli podczas opracowywania. Te metryki pomagają zrozumieć, jak dobrze działa model i zidentyfikować obszary pod kątem poprawy.

Wybranie modelu, który odpowiada Twoim potrzebom, może być procesem iteracyjnym. Następnie dowiesz się, jak wdrożyć model, aby przetestować go i eksperymentować z optymalizacją modelu pod kątem przypadku użycia.