Ćwiczenie — integrowanie i używanie funkcji rozpoznawania mowy i transkrypcji

W tym module utworzysz aplikację rzeczywistości mieszanej, która eksploruje korzystanie z usług Azure Speech Services za pomocą urządzenia HoloLens 2. Po ukończeniu tej serii będziesz w stanie użyć mikrofonu urządzenia do transkrypcji mowy na tekst w czasie rzeczywistym, przetłumaczyć mowę na inne języki i użyć funkcji rozpoznawania intencji, aby zrozumieć polecenia głosowe przy użyciu sztucznej inteligencji.

Utwórz i przygotuj projekt Unity

W tej sekcji utworzysz nowy projekt Unity i przygotujesz go do opracowywania z użyciem MRTK.

W ramach wymagań wstępnych upewnij się, że wykonano poniższe kroki, aby zainicjować projekt i aplikację:

- Tworzenie projektu Unity i nadanie mu odpowiedniej nazwy, na przykład samouczki MRTK

- Przełączanie platformy kompilacji

- Importowanie podstawowych zasobów TextMeshPro

- Importowanie zestawu narzędzi Mixed Reality Toolkit

- Konfigurowanie projektu Unity

- Tworzenie i konfigurowanie sceny i nadanie jej odpowiedniej nazwy; na przykład AzureSpeechServices

Notatka

Dowiedz się, jak skonfigurować projekt rzeczywistości mieszanej w module Introduction to Mixed Reality Toolkit (Wprowadzenie do zestawu narzędzi Mixed Reality Toolkit).

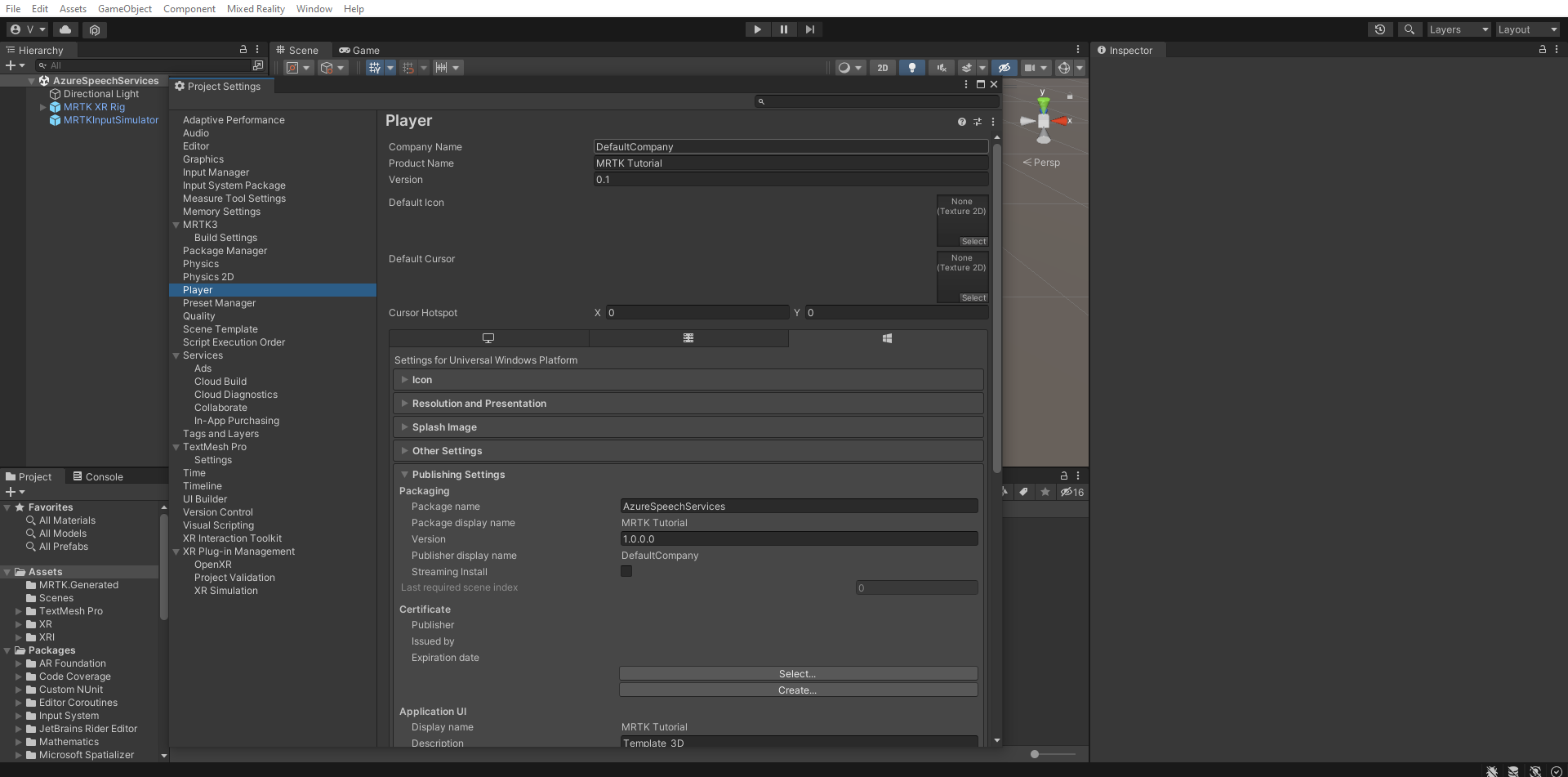

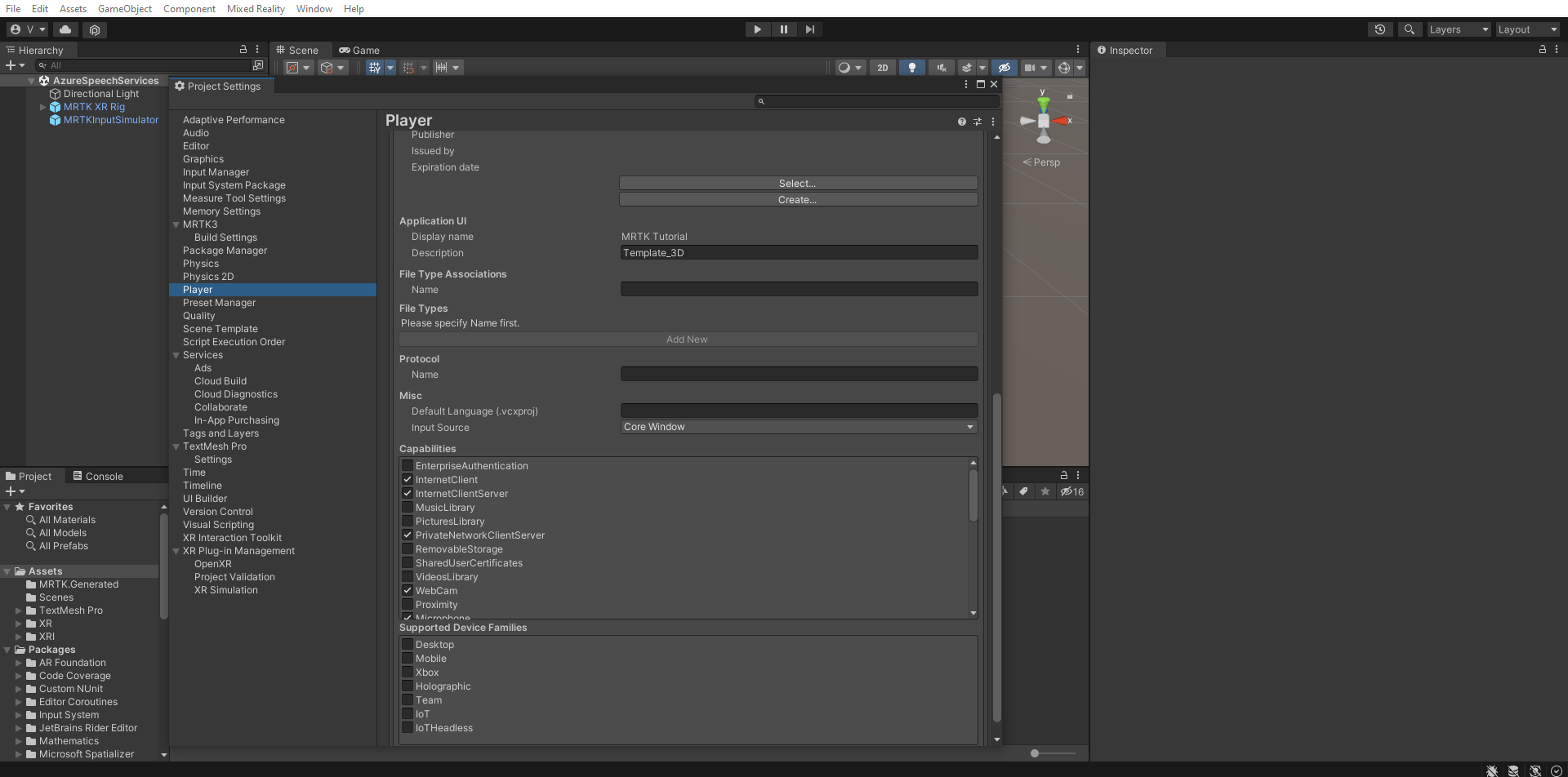

Konfigurowanie możliwości

W menu Unity wybierz Edytuj>Ustawienia Projektu..., aby otworzyć okno Ustawień Gracza, a następnie znajdź sekcję Gracz>Ustawienia Publikowania.

W ustawień publikowania przewiń w dół do sekcji Capabilities i upewnij się, że InternetClient, Mikrofonoraz SpatialPerception (Percepcja przestrzenna) są nadal włączone, tak jak to zrobiłeś podczas tworzenia projektu na początku samouczka. Następnie włącz funkcje InternetClientServer i PrivateNetworkClientServer.

Importowanie zasobów samouczka

Pobierz i zaimportuj następujące pakiety niestandardowe aparatu Unity w kolejności ich wyświetlania:

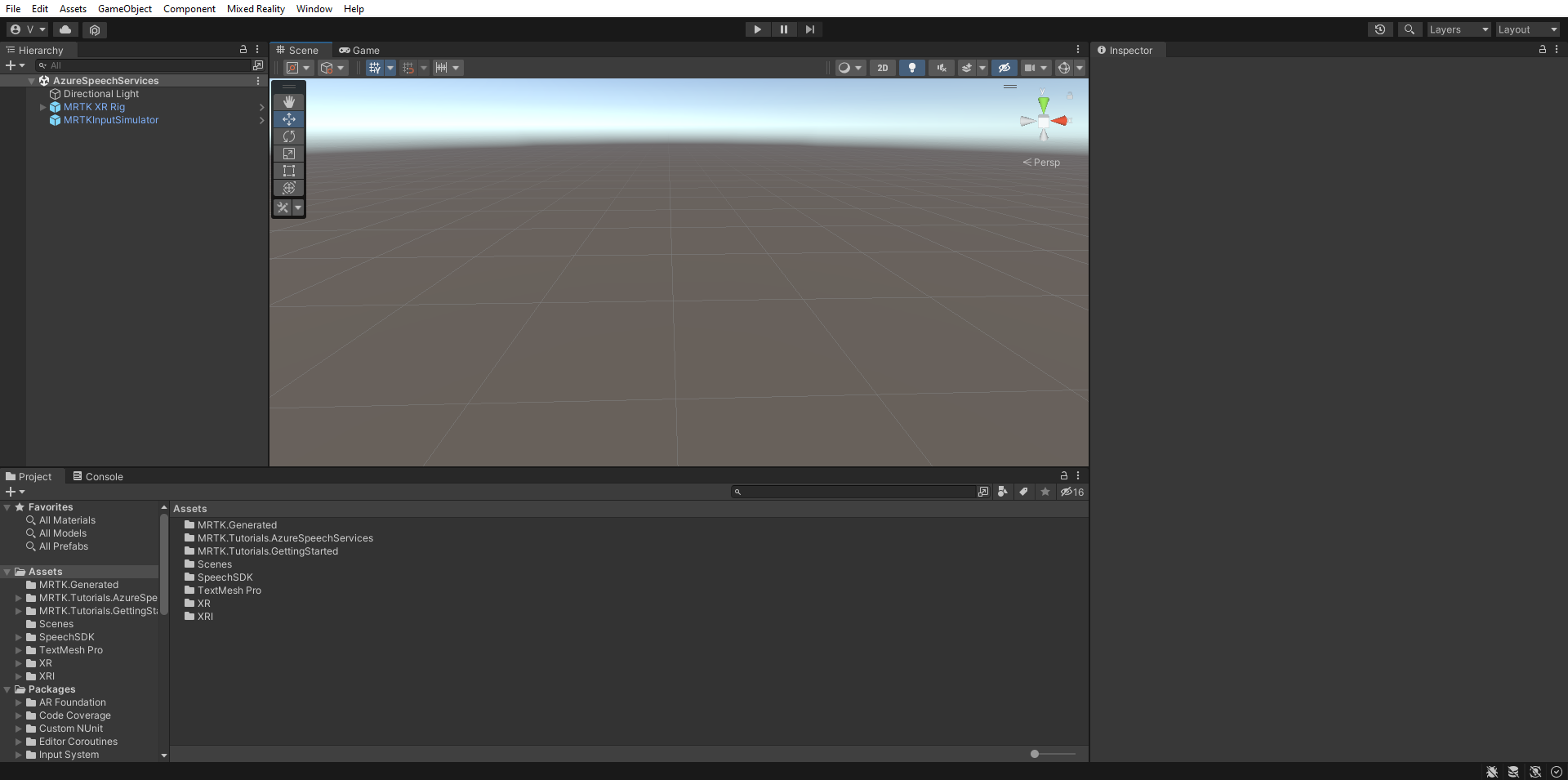

Po zaimportowaniu zasobów samouczka okno Projektu powinno wyglądać następująco:

Przygotowywanie sceny

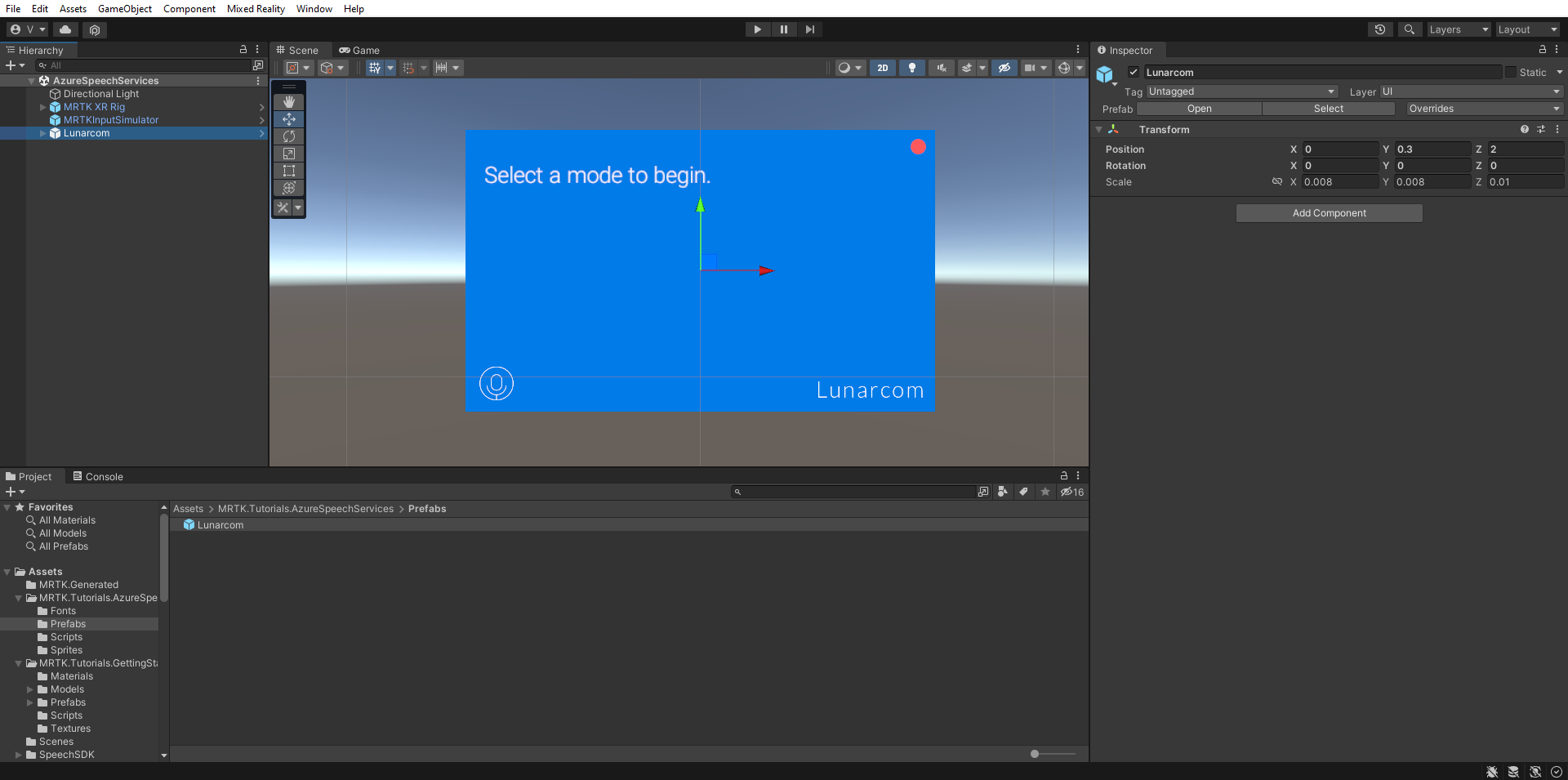

W tej sekcji przygotujesz scenę, dodając prefabrykowany element samouczka i konfigurując komponent Lunarcom Controller (Script) w celu sterowania sceną.

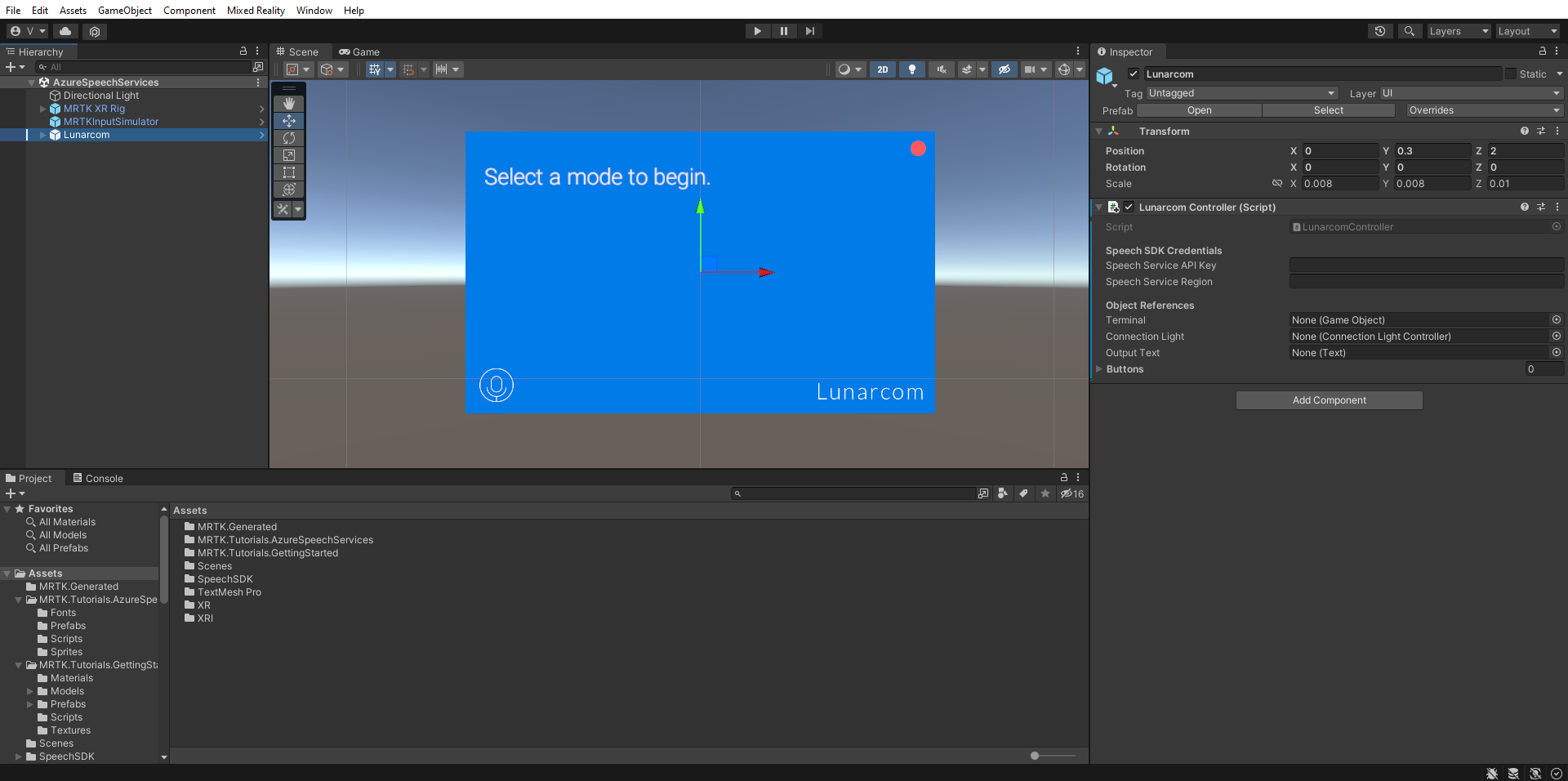

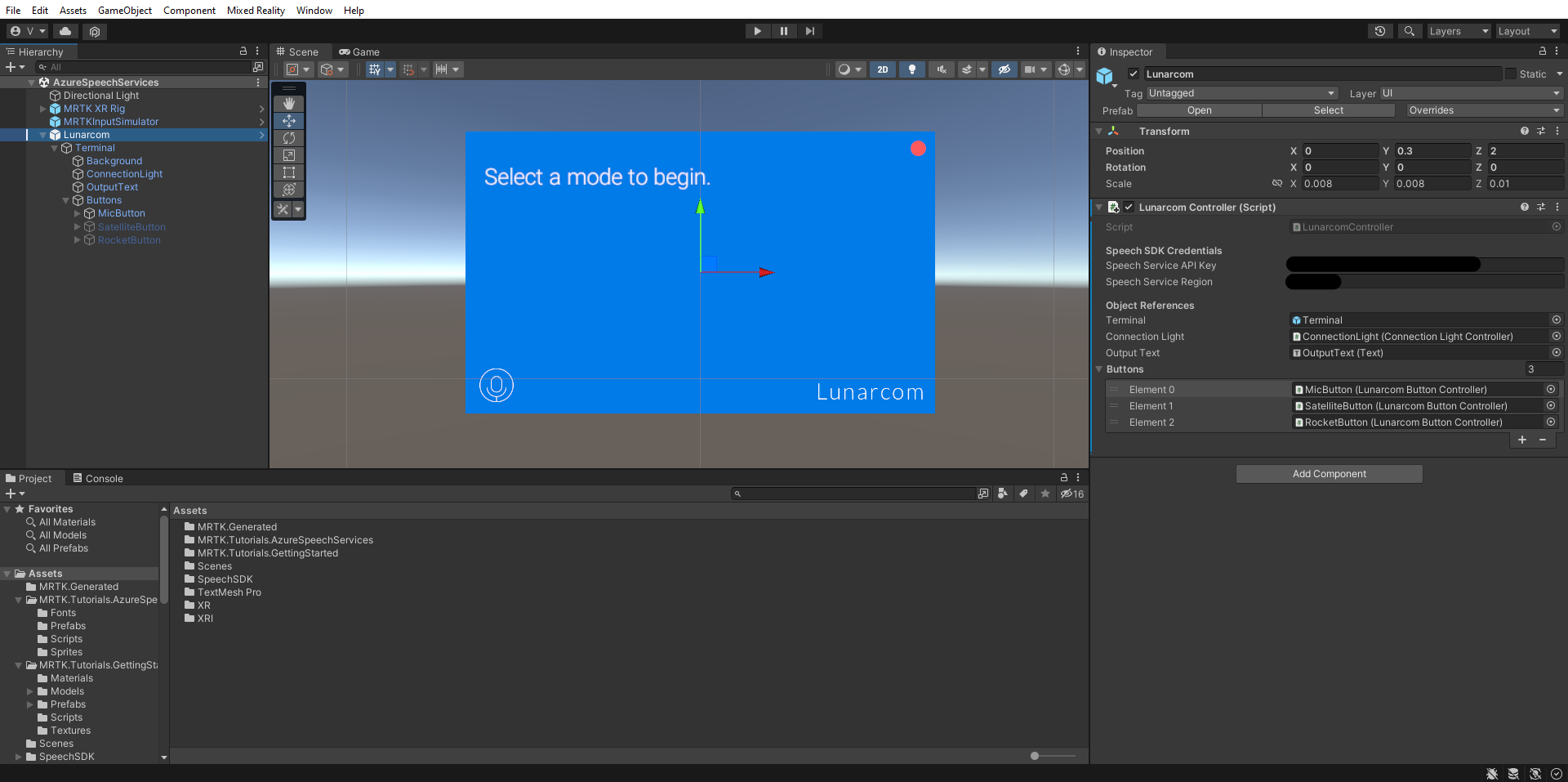

W oknie Project (Projekt) przejdź do folderu Assets>MRTK.Tutorials.AzureSpeechServices>Prefabs i przeciągnij Prefab Lunarcom do okna hierarchia, aby dodać go do sceny.

Jeśli obiekt Lunarcom jest nadal zaznaczony w oknie Hierarchia, w oknie Inspector (Inspektor) użyj przycisku Dodaj składnik, aby dodać składnik Lunarcom Controller (Script) do obiektu Lunarcom.

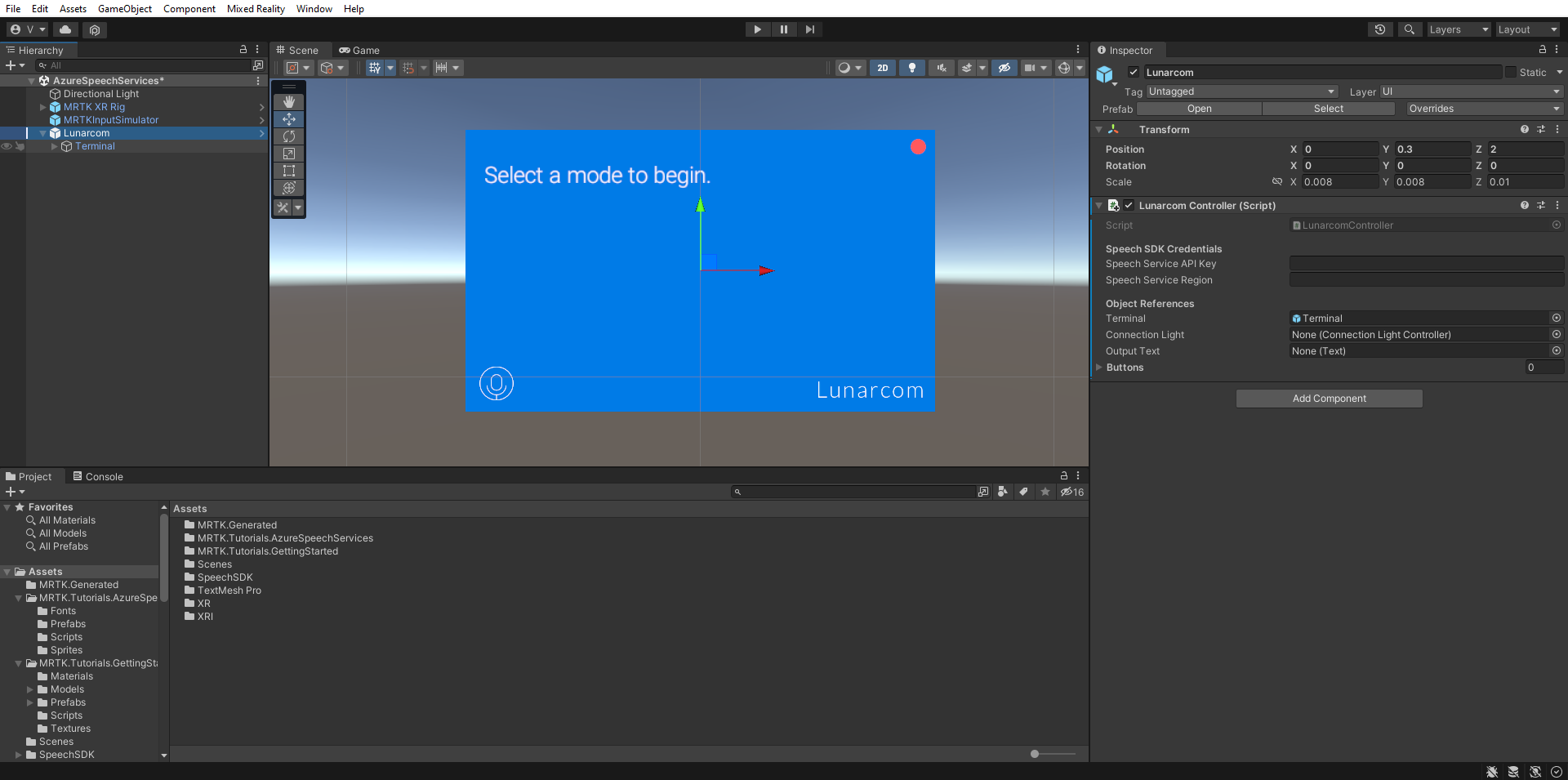

Po wybraniu obiektu Lunarcom, rozwiń go, aby wyświetlić jego obiekty podrzędne, a następnie przeciągnij obiekt Terminal do pola Terminal składnika Lunarcom Controller (Script).

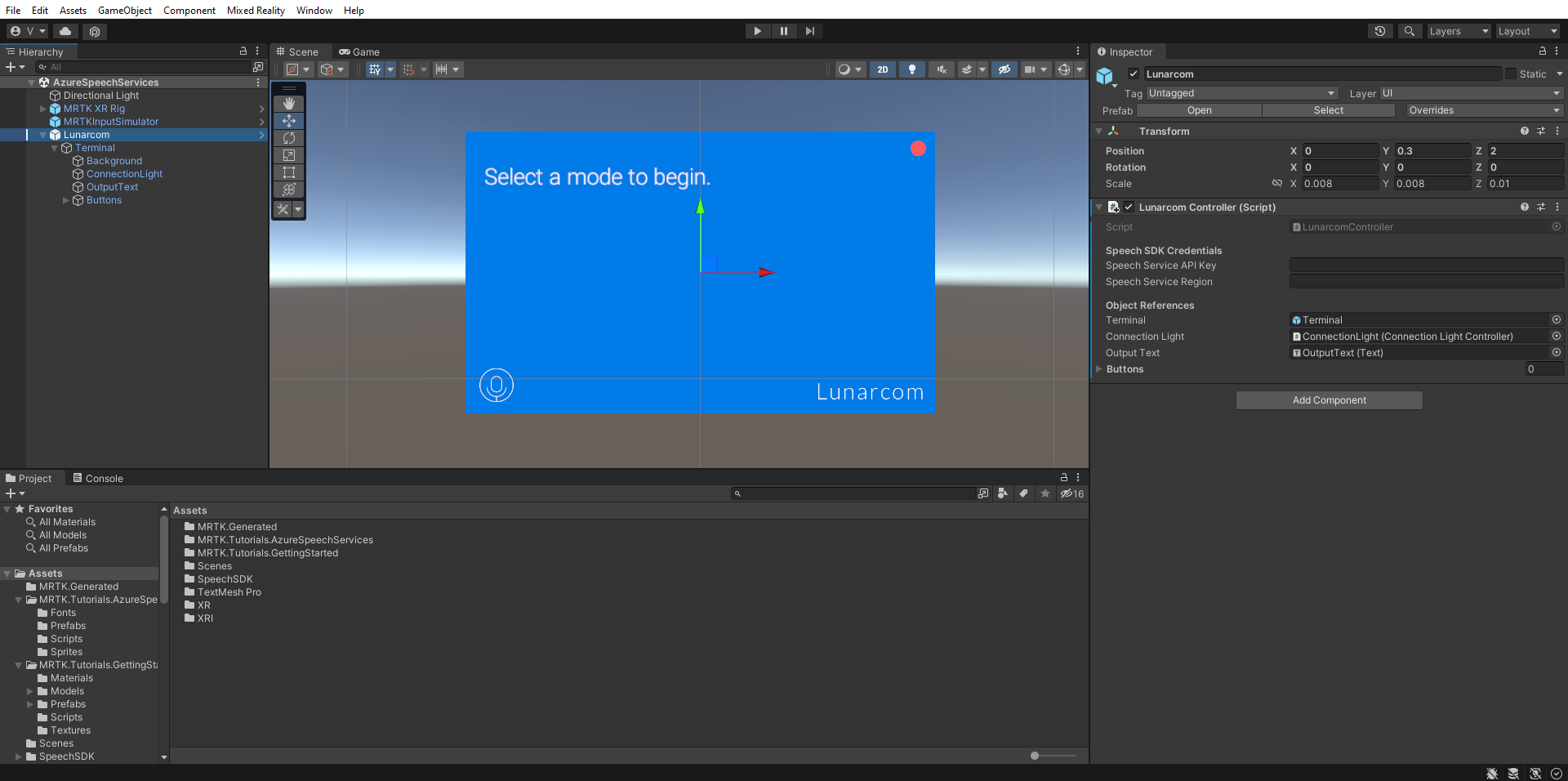

Gdy obiekt Lunarcom jest nadal zaznaczony, rozwiń obiekt Terminal, aby wyświetlić jego obiekty podrzędne, a następnie przeciągnij obiekt ConnectionLight do pola Connection Light w składniku Lunarcom Controller (Skrypt), a obiekt OutputText do pola Output Text.

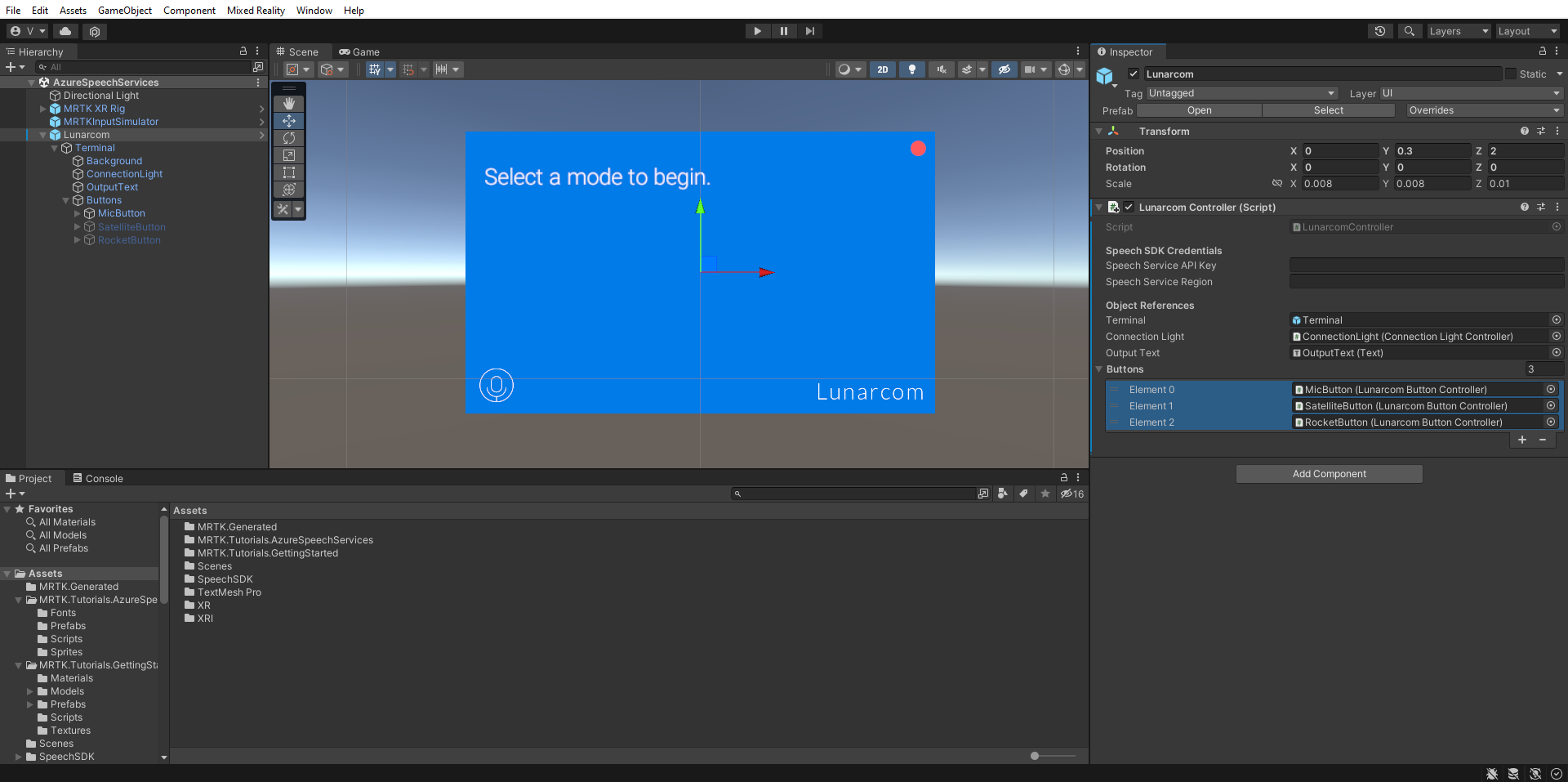

Po wybraniu obiektu Lunarcom, rozwiń obiekt Buttons, aby wyświetlić jego obiekty podrzędne. Następnie w oknie Inspector rozwiń listę Buttons, ustaw pole Buttons na 3i przeciągnij obiekty MicButton, SatelliteButtonoraz RocketButton do pól Element 0, 1 i 2 odpowiednio.

Łączenie projektu Unity z zasobem Azure

Aby korzystać z usług Azure Speech Services, musisz utworzyć zasób platformy Azure i uzyskać klucz interfejsu API dla usługi Mowa. Postępuj zgodnie z instrukcjami przewodnika szybkiego startu i zanotuj region usługi (znany również jako Location ) i klucz interfejsu API (znany również jako Key1 lub Key2 ).

W oknie Hierarchia wybierz obiekt Lunarcom, a następnie w oknie Inspektor (Inspector) znajdź składnik Lunarcom Controller (Script) w sekcji Speech SDK Credentials i skonfiguruj go w następujący sposób:

- W polu klucza interfejsu API usługi rozpoznawania mowy wprowadź klucz interfejsu API (Klucz1 lub Klucz2).

- W polu region usługi rozpoznawania mowy wprowadź swój region usługi (lokalizacja) przy użyciu małych liter, z pominięciem spacji.

Używanie rozpoznawania mowy do transkrypcji mowy

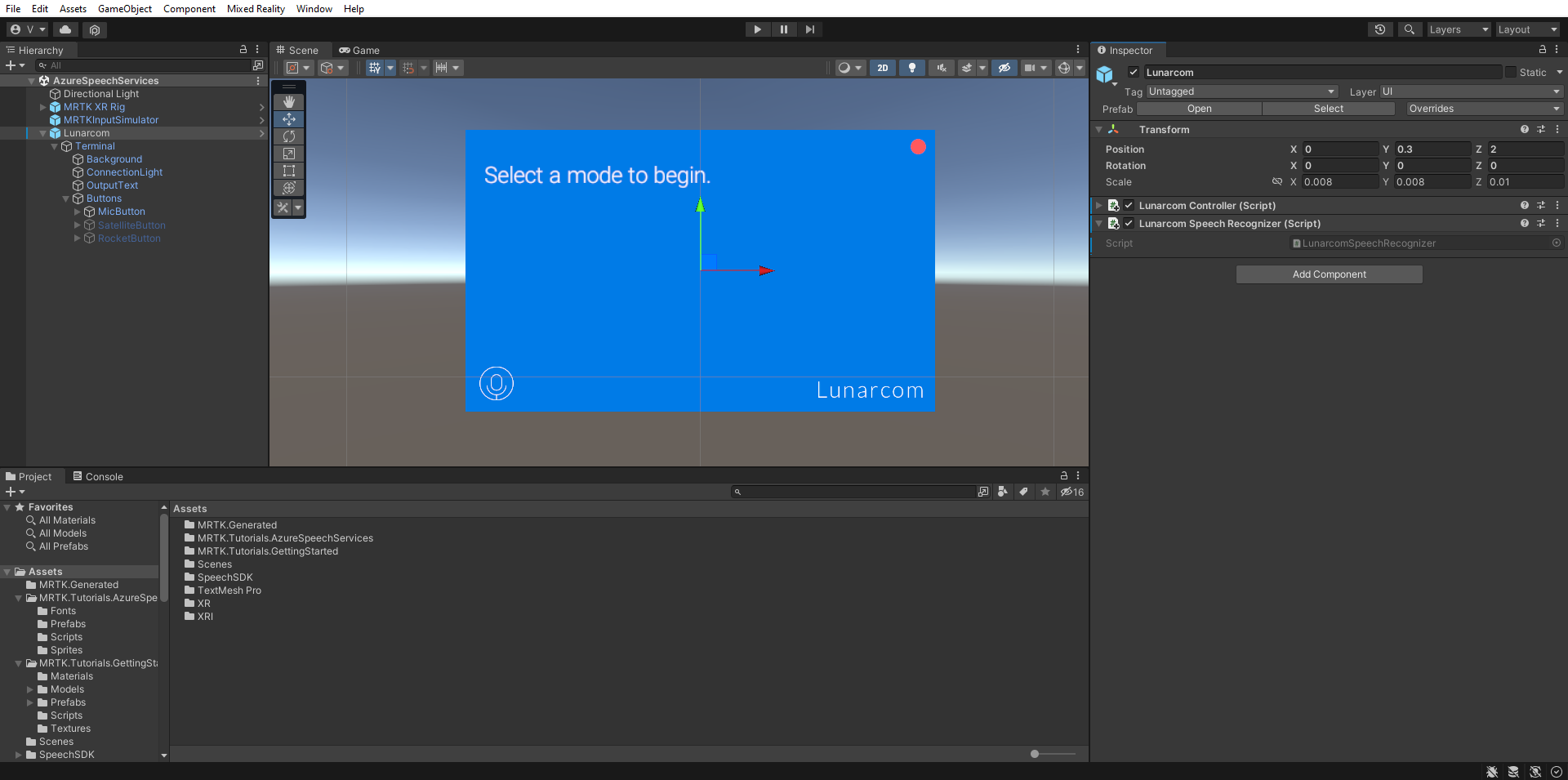

W oknie Hierarchia wybierz obiekt Lunarcom, a następnie w oknie Inspector (Inspektor) użyj przycisku Dodaj składnik, aby dodać składnik Lunarcom Speech Recognizer (Script) do obiektu Lunarcom.

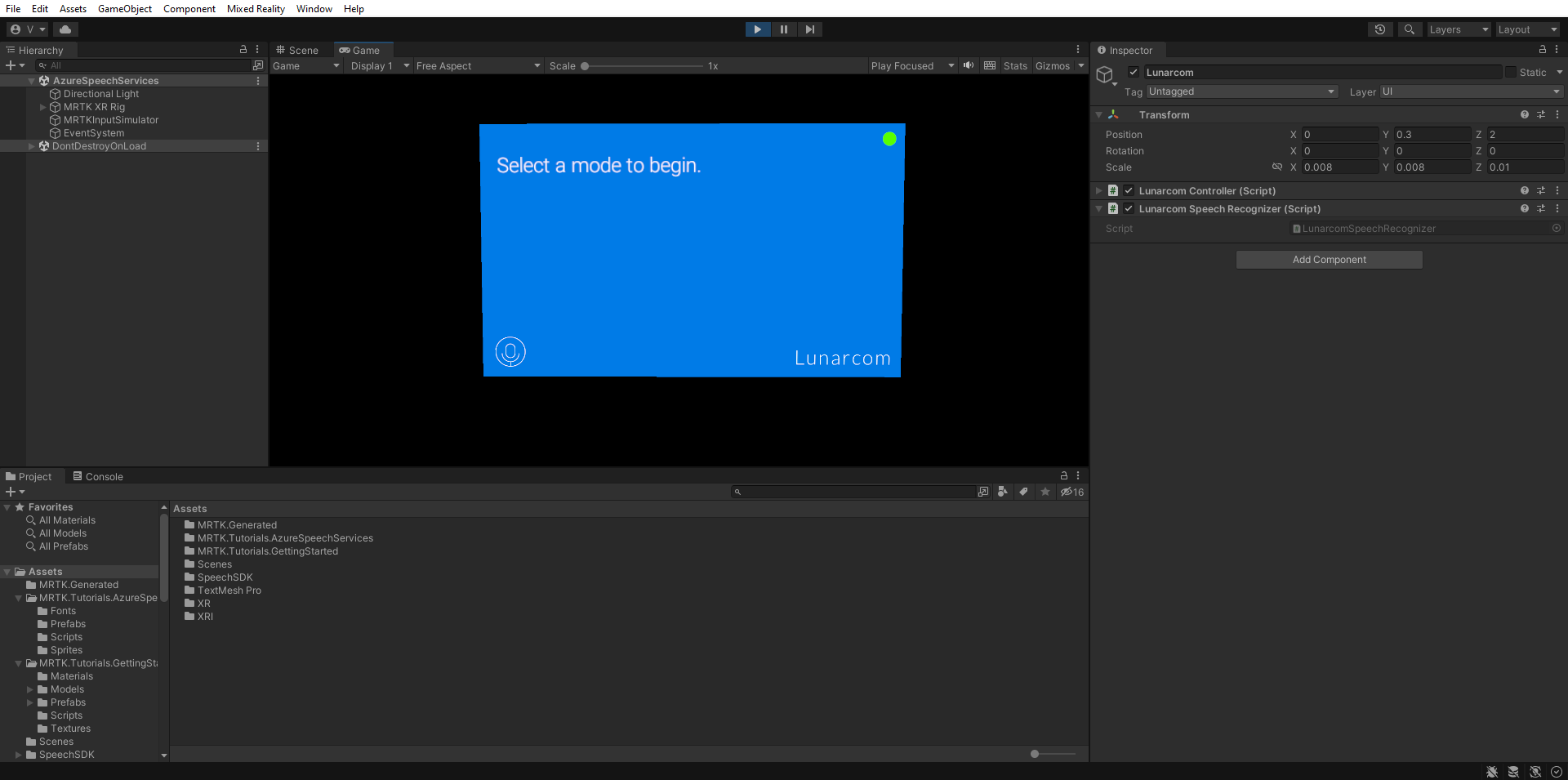

Jeśli teraz wejdziesz w tryb gry i wybierzesz przycisk Odtwórz, możesz przetestować rozpoznawanie mowy, najpierw naciskając przycisk mikrofonu.

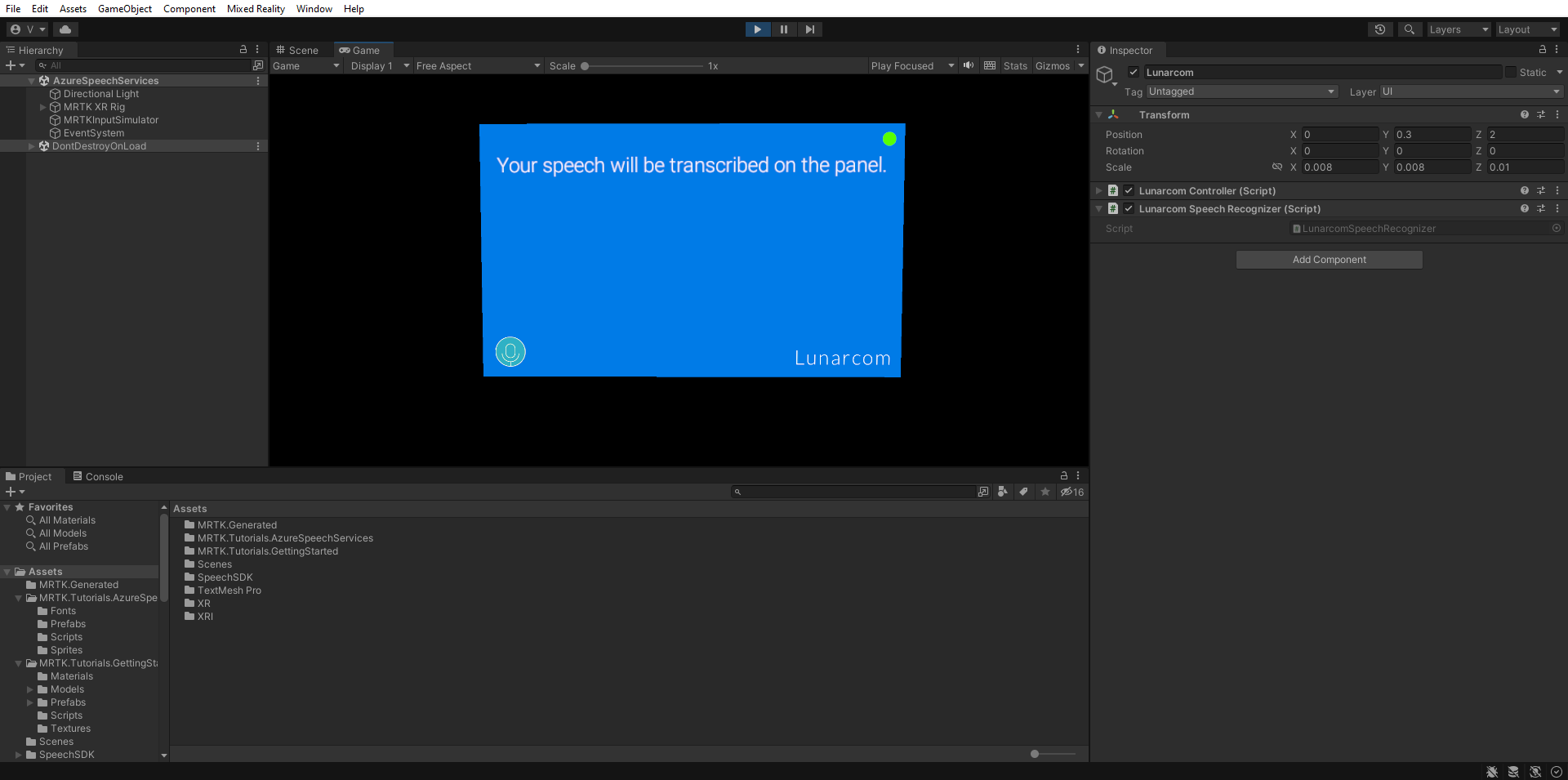

Następnie, zakładając, że komputer ma mikrofon, gdy coś powiesz, twoja mowa zostanie przetranskrybowana na panelu terminalu.

Ostrożność

Aplikacja musi nawiązać połączenie z platformą Azure, więc upewnij się, że komputer/urządzenie jest połączone z Internetem.