Jak używać notesu usługi Azure Machine Learning na platformie Spark

Ważny

Usługa Azure HDInsight w usłudze AKS została wycofana 31 stycznia 2025 r. Dowiedz się więcej z tym ogłoszeniem.

Aby uniknąć nagłego kończenia obciążeń, należy przeprowadzić migrację obciążeń do usługi Microsoft Fabric lub równoważnego produktu platformy Azure.

Ważny

Ta funkcja jest obecnie dostępna w wersji zapoznawczej. Dodatkowe warunki użytkowania dla wersji zapoznawczych Microsoft Azure zawierają więcej warunków prawnych, które dotyczą funkcji Azure w wersji beta, zapoznawczej lub nieudostępnionych jeszcze ogółowi. Aby uzyskać informacje na temat tej konkretnej wersji zapoznawczej, zobacz informacje o wersji zapoznawczej Azure HDInsight na AKS. W przypadku pytań lub sugestii dotyczących funkcji prosimy przesłać zapytanie na AskHDInsight z podaniem szczegółów. Śledź nas, aby uzyskać więcej aktualizacji na temat społeczności Azure HDInsight.

Uczenie maszynowe to rozwijająca się technologia, która umożliwia komputerom automatyczne uczenie się z poprzednich danych. Uczenie maszynowe używa różnych algorytmów do tworzenia modeli matematycznych i przewidywania przy użyciu danych historycznych albo informacji. Mamy model zdefiniowany w odniesieniu do niektórych parametrów, a uczenie się jest wykonywaniem programu komputerowego w celu zoptymalizowania parametrów modelu przy użyciu danych treningowych lub doświadczenia. Model może być predykcyjny, aby przewidywać w przyszłości, lub opisowy, aby uzyskać wiedzę na podstawie danych.

W poniższym notesie samouczka przedstawiono przykład trenowania modeli uczenia maszynowego na danych tabelarycznych. Możesz zaimportować ten notes i uruchomić go samodzielnie.

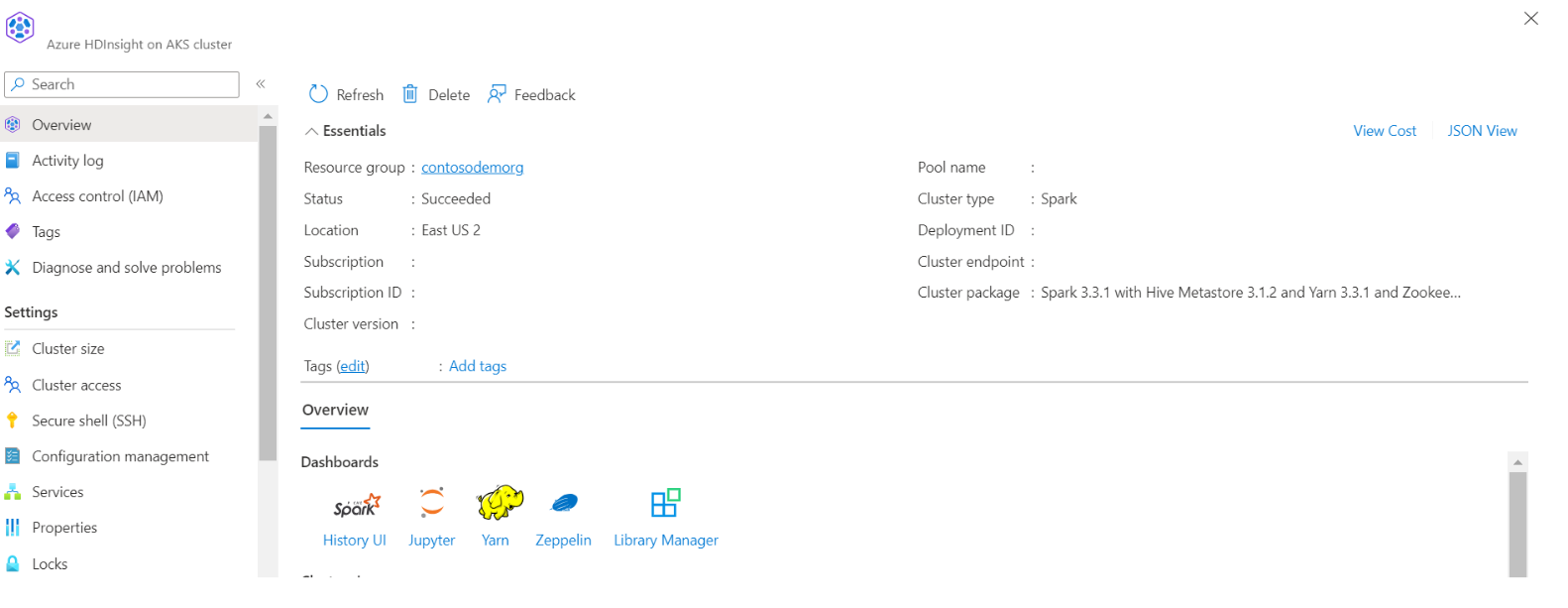

Przekaż plik CSV do przechowywania

Znajdowanie nazwy magazynu i kontenera w widoku JSON portalu

Przejdź do podstawowego magazynu usługi HDI>, kontenera>, a następnie do folderu podstawowego> i załaduj plik CSV

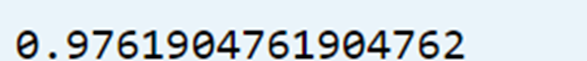

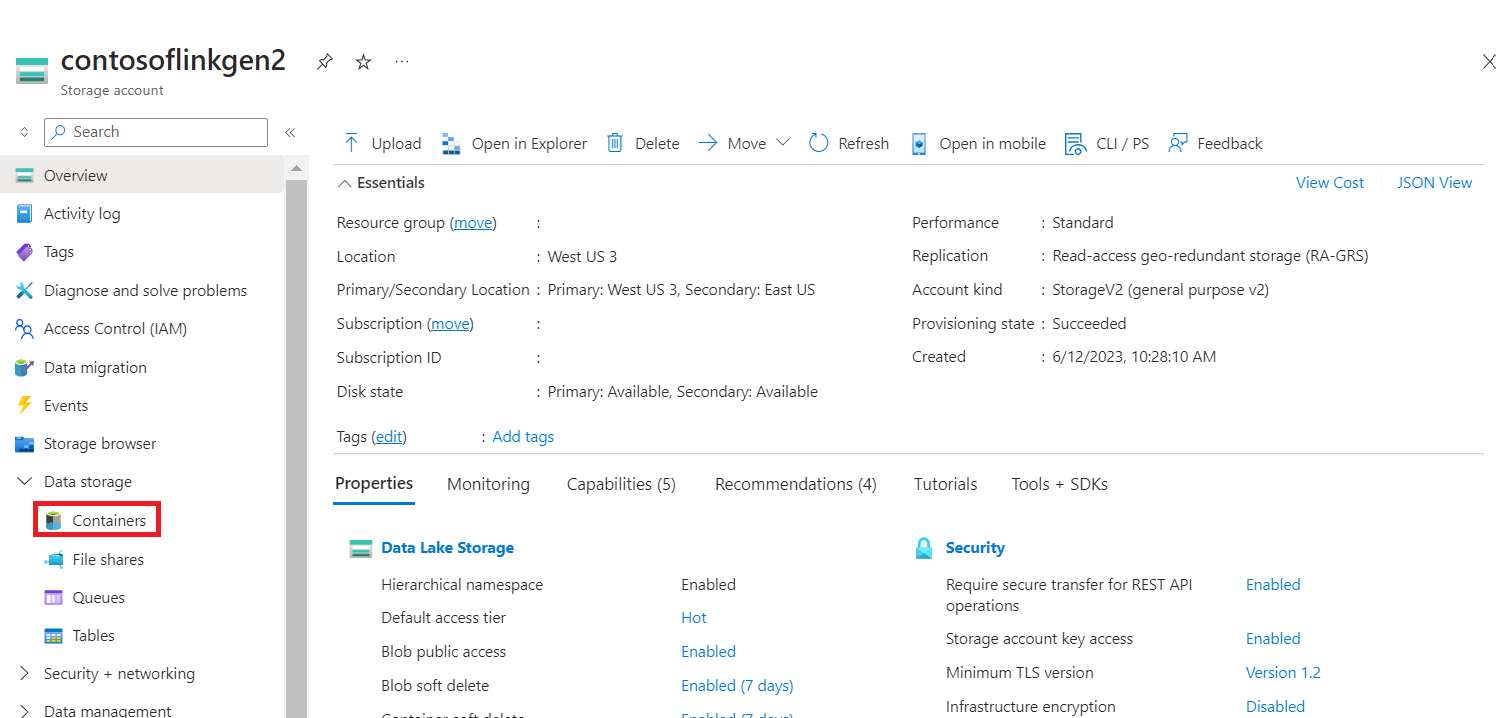

Zaloguj się do klastra i otwórz Jupyter Notebook

Importowanie bibliotek Spark MLlib w celu utworzenia potoku

import pyspark from pyspark.ml import Pipeline, PipelineModel from pyspark.ml.classification import LogisticRegression from pyspark.ml.feature import VectorAssembler, StringIndexer, IndexToString

Odczytywanie pliku CSV w ramce danych platformy Spark

df = spark.read.("abfss:///iris_csv.csv",inferSchema=True,header=True)Dzielenie danych na potrzeby trenowania i testowania

iris_train, iris_test = df.randomSplit([0.7, 0.3], seed=123)Stwórz potok i wytrenuj model.

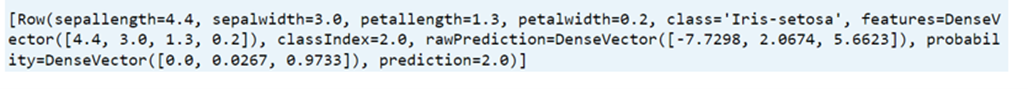

assembler = VectorAssembler(inputCols=['sepallength', 'sepalwidth', 'petallength', 'petalwidth'],outputCol="features",handleInvalid="skip") indexer = StringIndexer(inputCol="class", outputCol="classIndex", handleInvalid="skip") classifier = LogisticRegression(featuresCol="features", labelCol="classIndex", maxIter=10, regParam=0.01) pipeline = Pipeline(stages=[assembler,indexer,classifier]) model = pipeline.fit(iris_train) # Create a test `dataframe` with predictions from the trained model test_model = model.transform(iris_test) # Taking an output from the test dataframe with predictions test_model.take(1)

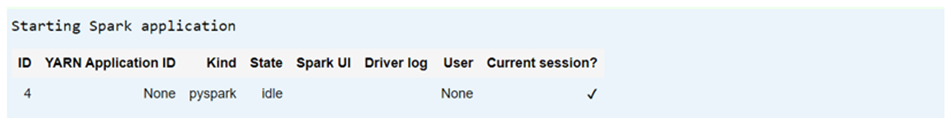

Ocena dokładności modelu

import pyspark.ml.evaluation as ev evaluator = ev.MulticlassClassificationEvaluator(labelCol='classIndex') print(evaluator.evaluate(test_model,{evaluator.metricName: 'accuracy'}))