Stream dane z usługi Azure Storage Blob do usługi Azure Data Lake Storage Gen1 przy użyciu usługi Azure Stream Analytics

Z tego artykułu dowiesz się, jak używać Azure Data Lake Storage Gen1 jako danych wyjściowych zadania usługi Azure Stream Analytics. W tym artykule przedstawiono prosty scenariusz odczytujący dane z obiektu blob usługi Azure Storage (dane wejściowe) i zapisujący dane do Data Lake Storage Gen1 (dane wyjściowe).

Wymagania wstępne

Przed przystąpieniem do wykonania kroków opisanych w tym samouczku należy dysponować następującymi elementami:

Subskrypcja platformy Azure. Zobacz temat Uzyskiwanie bezpłatnej wersji próbnej platformy Azure.

Konto usługi Azure Storage. Kontener obiektów blob z tego konta będzie używany do wprowadzania danych dla zadania usługi Stream Analytics. W tym samouczku założono, że masz konto magazynu o nazwie storageforasa i kontener w ramach konta o nazwie storageforasacontainer. Po utworzeniu kontenera przekaż do niego przykładowy plik danych.

Konto Data Lake Storage Gen1. Postępuj zgodnie z instrukcjami w temacie Rozpoczynanie pracy z usługą Azure Data Lake Storage Gen1 przy użyciu Azure Portal. Załóżmy, że masz konto Data Lake Storage Gen1 o nazwie myadlsg1.

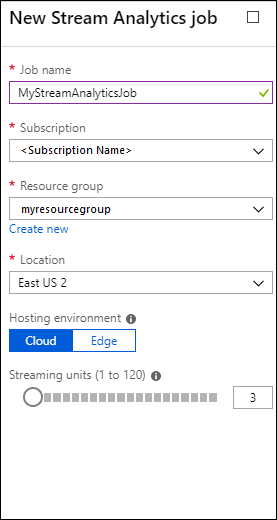

Tworzenie zadania usługi Stream Analytics

Zacznij od utworzenia zadania usługi Stream Analytics zawierającego źródło wejściowe i miejsce docelowe danych wyjściowych. W tym samouczku źródłem jest kontener obiektów blob platformy Azure, a miejsce docelowe jest Data Lake Storage Gen1.

Zaloguj się w witrynie Azure Portal.

W okienku po lewej stronie kliknij pozycję zadania usługi Stream Analytics, a następnie kliknij przycisk Dodaj.

Uwaga

Upewnij się, że utworzono zadanie w tym samym regionie co konto magazynu lub poniesiesz dodatkowe koszty przenoszenia danych między regionami.

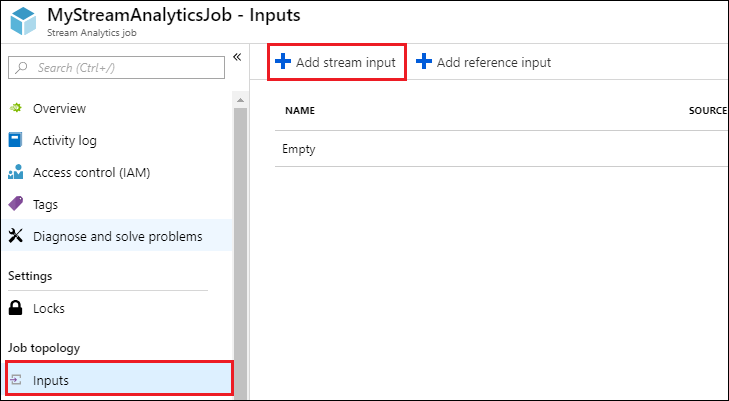

Tworzenie danych wejściowych obiektu blob dla zadania

Otwórz stronę zadania usługi Stream Analytics, w okienku po lewej stronie kliknij kartę Dane wejściowe, a następnie kliknij przycisk Dodaj.

W bloku Nowe dane wejściowe podaj następujące wartości.

W polu Alias danych wejściowych wprowadź unikatową nazwę danych wejściowych zadania.

W polu Typ źródła wybierz pozycję Strumień danych.

W polu Źródło wybierz pozycję Blob Storage.

W obszarze Subskrypcja wybierz pozycję Użyj magazynu obiektów blob z bieżącej subskrypcji.

W polu Konto magazynu wybierz konto magazynu utworzone w ramach wymagań wstępnych.

W polu Kontener wybierz kontener utworzony na wybranym koncie magazynu.

W obszarze Format serializacji zdarzeń wybierz pozycję CSV.

W obszarze Ogranicznik wybierz kartę.

W obszarze Kodowanie wybierz wartość UTF-8.

Kliknij pozycję Utwórz. Portal dodaje teraz dane wejściowe i testuje połączenie z nim.

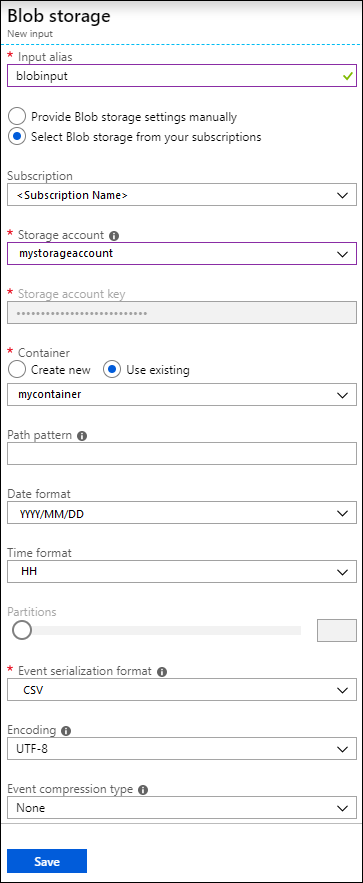

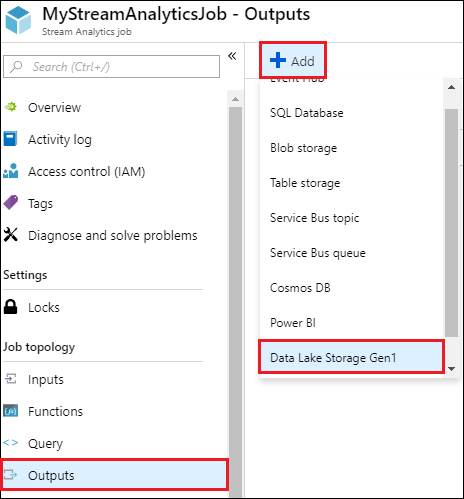

Tworzenie danych wyjściowych Data Lake Storage Gen1 dla zadania

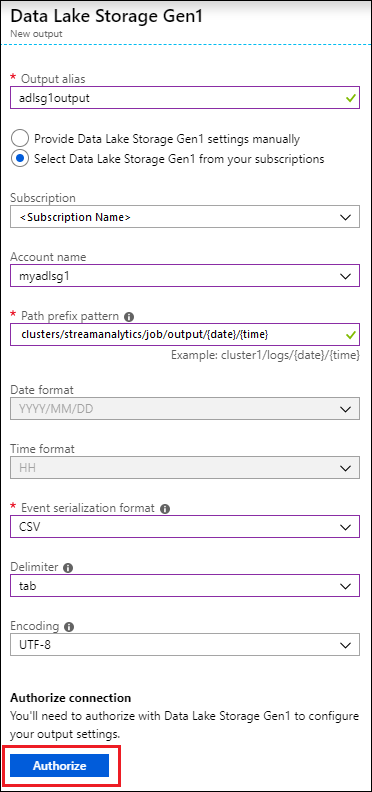

Otwórz stronę zadania usługi Stream Analytics, kliknij kartę Dane wyjściowe, kliknij przycisk Dodaj i wybierz pozycję Data Lake Storage Gen1.

W bloku Nowe dane wyjściowe podaj następujące wartości.

- W polu Alias danych wyjściowych wprowadź unikatową nazwę danych wyjściowych zadania. Jest to przyjazna nazwa używana w zapytaniach, aby skierować dane wyjściowe zapytania do tego konta Data Lake Storage Gen1.

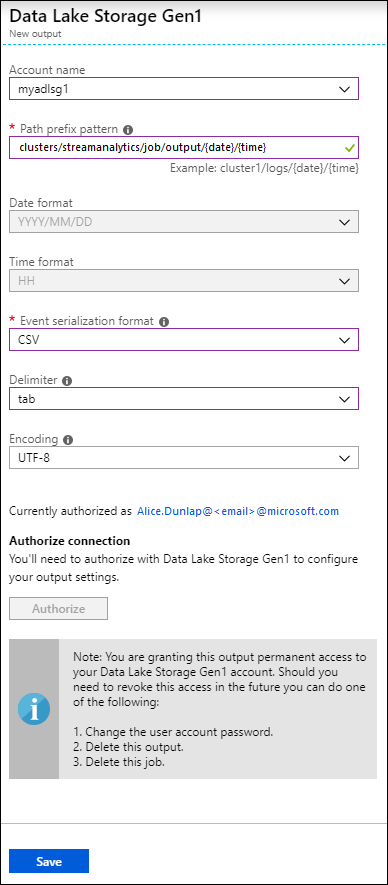

- Zostanie wyświetlony monit o autoryzowanie dostępu do konta Data Lake Storage Gen1. Kliknij pozycję Autoryzuj.

W bloku Nowe dane wyjściowe podaj następujące wartości.

W polu Nazwa konta wybierz konto Data Lake Storage Gen1, do którego ma zostać wysłane dane wyjściowe zadania.

W polu Wzorzec prefiksu ścieżki wprowadź ścieżkę pliku używaną do zapisywania plików na określonym koncie Data Lake Storage Gen1.

W polu Format daty, jeśli użyto tokenu daty w ścieżce prefiksu, możesz wybrać format daty, w którym są zorganizowane pliki.

W polu Format czasu, jeśli użyto tokenu czasu w ścieżce prefiksu, określ format czasu, w którym są zorganizowane pliki.

W obszarze Format serializacji zdarzeń wybierz pozycję CSV.

W obszarze Ogranicznik wybierz kartę.

W obszarze Kodowanie wybierz wartość UTF-8.

Kliknij pozycję Utwórz. Portal dodaje teraz dane wyjściowe i testuje połączenie z nim.

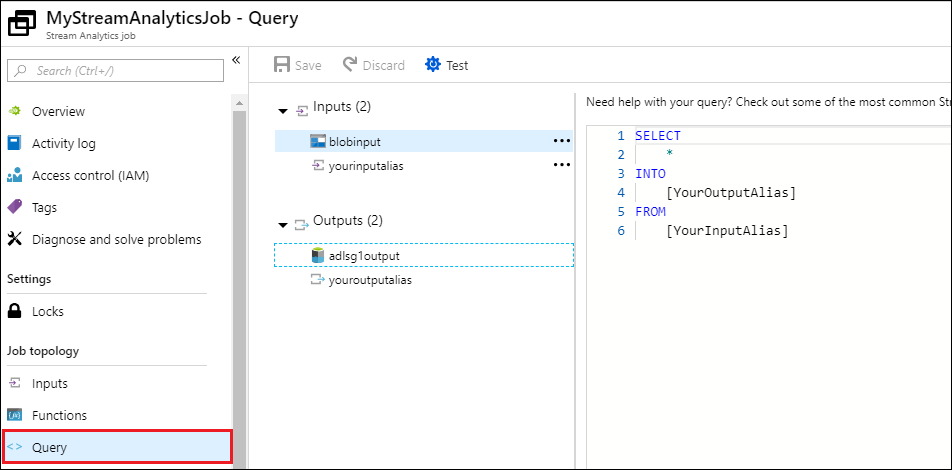

Uruchamianie zadania usługi Stream Analytics

Aby uruchomić zadanie usługi Stream Analytics, należy uruchomić zapytanie na karcie Zapytanie. W tym samouczku możesz uruchomić przykładowe zapytanie, zastępując symbole zastępcze aliasami wejściowymi i wyjściowymi zadania, jak pokazano na poniższym zrzucie ekranu.

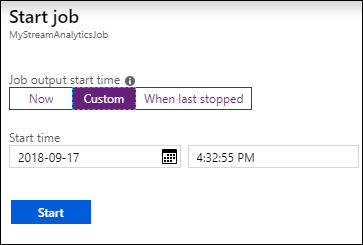

Kliknij przycisk Zapisz w górnej części ekranu, a następnie na karcie Przegląd kliknij przycisk Start. W oknie dialogowym wybierz pozycję Godzina niestandardowa, a następnie ustaw bieżącą datę i godzinę.

Kliknij przycisk Start , aby uruchomić zadanie. Uruchomienie zadania może potrwać do kilku minut.

Aby wyzwolić zadanie wybierania danych z obiektu blob, skopiuj przykładowy plik danych do kontenera obiektów blob. Przykładowy plik danych można pobrać z repozytorium Git usługi Azure Data Lake. W tym samouczku skopiujmy plik vehicle1_09142014.csv. Do przekazywania danych do kontenera obiektów blob można użyć różnych klientów, takich jak Eksplorator usługi Azure Storage.

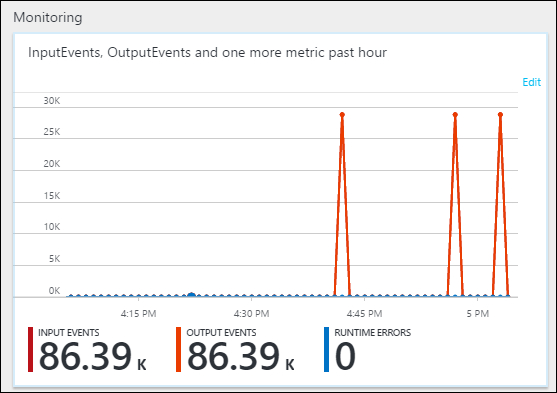

Na karcie Przegląd w obszarze Monitorowanie sprawdź, jak dane zostały przetworzone.

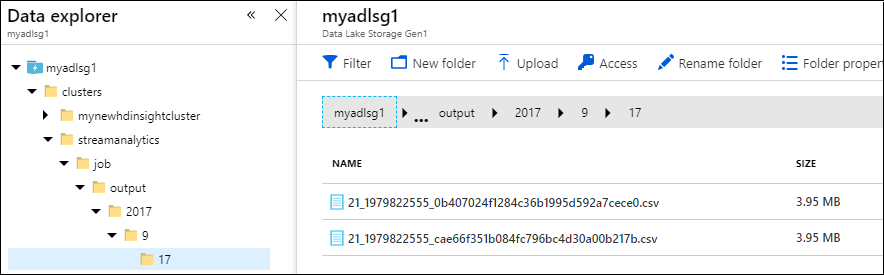

Na koniec możesz sprawdzić, czy dane wyjściowe zadania są dostępne na koncie Data Lake Storage Gen1.

W okienku Data Explorer zwróć uwagę, że dane wyjściowe są zapisywane w ścieżce folderu, jak określono w ustawieniach danych wyjściowych Data Lake Storage Gen1 (

streamanalytics/job/output/{date}/{time}).